基于Spark的用户实时分析

Spark的最简安装

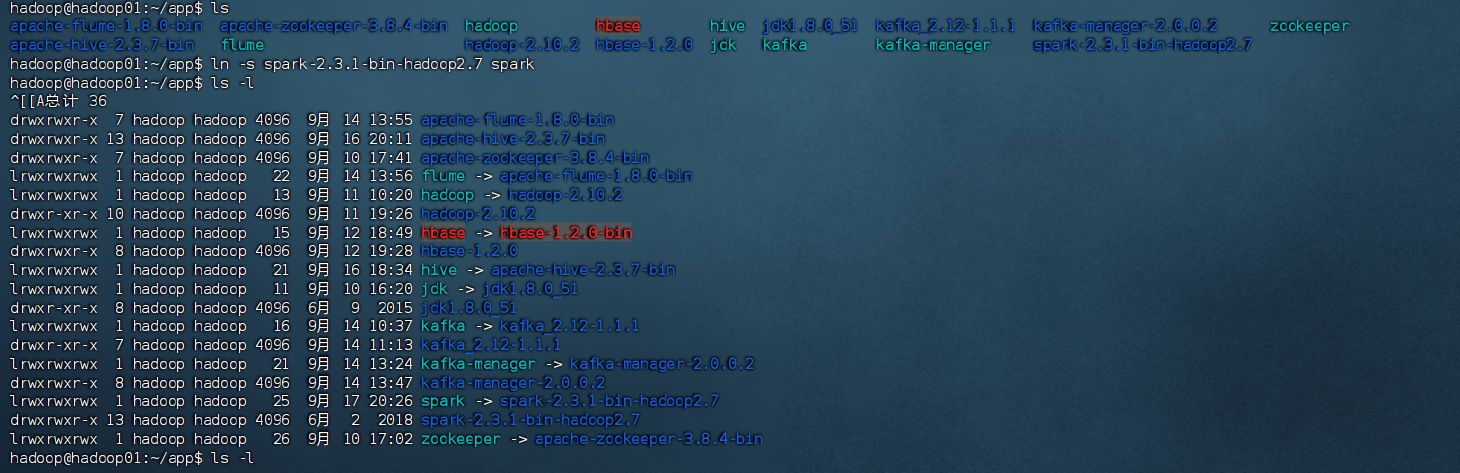

1. 下载并解压 Spark

首先,我们需要下载 Spark 安装包。您可以选择以下方式之一:

方式一:从官网下载(推荐)

# 在 hadoop01 节点上执行

cd /home/hadoop/app

wget https://archive.apache.org/dist/spark/spark-2.3.1/spark-2.3.1-bin-hadoop2.7.tgz

方式二:如果已有安装包,直接解压

cd /home/hadoop/app

# 如果已经有安装包,直接解压

tar -zxvf spark-2.3.1-bin-hadoop2.7.tgz

# 创建软链接

ln -s spark-2.3.1-bin-hadoop2.7 spark

2. 测试运行 Spark

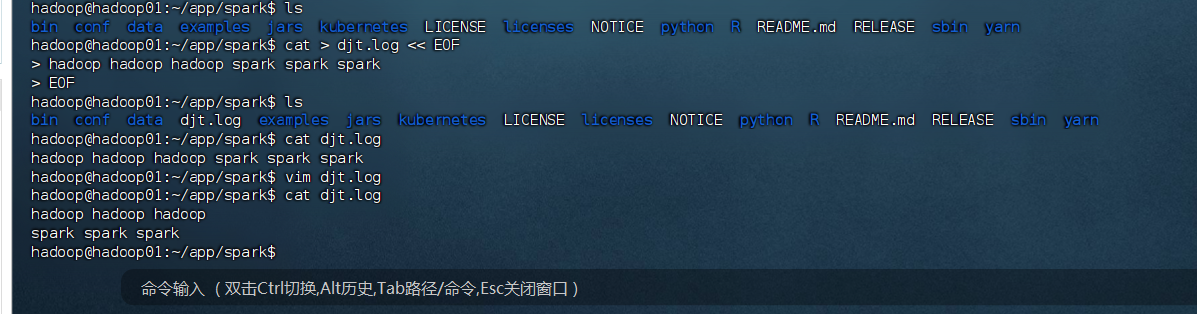

(1) 准备测试数据集

cd /home/hadoop/app/spark

# 创建测试文件

cat > djt.log << EOF

hadoop hadoop hadoop spark spark spark

EOF# 查看文件内容

cat djt.log

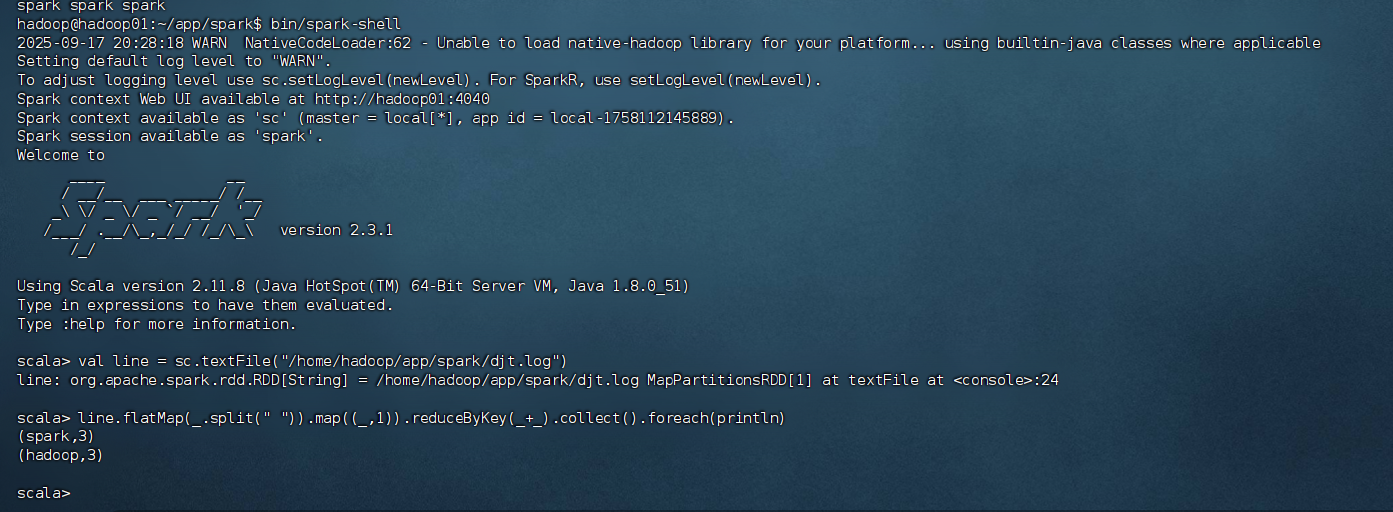

(2) Spark shell 测试运行单词词频统计

# 启动 Spark shell

bin/spark-shell# 等待 Spark shell 启动完成,看到 scala> 提示符后,依次输入以下命令:

在 Spark shell 中输入以下命令:

// 读取本地文件

val line = sc.textFile("/home/hadoop/app/spark/djt.log")// WordCount 统计并打印

line.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect().foreach(println)

预期输出:

(spark,3)

(hadoop,3)

3. Spark 实现 WordCount(Scala 程序)

步骤1:下载 Hadoop 及 winutils.exe

1.1 下载 Hadoop 2.7.1 安装包

链接参考https://blog.csdn.net/qq_39900031/article/details/121080109

好的,我把 Windows 下 Hadoop 环境配置的 完整详细过程整理给你(以 Hadoop 2.7.1 + JDK1.8 为例):

一、准备工作

-

安装 JDK1.8

-

下载 JDK1.8 并安装,推荐路径如:

C:\Java\jdk1.8.0_221。 -

配置环境变量:

JAVA_HOME=C:\Java\jdk1.8.0_221PATH中添加:%JAVA_HOME%\bin- 新建

CLASSPATH=.;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar

-

-

下载 Hadoop 2.7.1

- 地址:http://archive.apache.org/dist/hadoop/core/hadoop-2.7.1/

- 解压到:

C:\hadoop-2.7.1

-

下载 HadoopOnWindows 适配包

- GitHub 或 CSDN 提供的

hadooponwindows-master.zip - 解压后,把里面的 bin 和 etc 文件夹 覆盖到

C:\hadoop-2.7.1目录下。

- GitHub 或 CSDN 提供的

二、配置 Hadoop 环境变量

在 系统环境变量中新建:

HADOOP_HOME=C:\hadoop-2.7.1PATH添加:%HADOOP_HOME%\bin;%HADOOP_HOME%\sbin

三、修改配置文件

进入 C:\hadoop-2.7.1\etc\hadoop 目录:

-

hadoop-env.cmd

set JAVA_HOME=C:\Java\jdk1.8.0_221 -

core-site.xml

<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property><property><name>hadoop.tmp.dir</name><value>C:/hadoop-2.7.1/tmp</value>