SPAR模型优化思路

SPAR 模型中类比推理逻辑存在的缺陷:

(1)图卷积过程训练过于复杂

(2)图卷积中,像素节点和类别节点是以特征相似度强弱构造邻接矩阵的,没有考虑到像素的空间关系。也许可以加入位置嵌入。

(3)邻居特征的传递过程是完全平均的,实际上应该考虑到不同相似度邻居贡献程度不一致的问题。

(4)噪声污染

1. 将图卷积替换为更灵活的 图注意力(GAT)或 Transformer-on-graph

GAT:Graph Attention Network

传统 GCN 用固定的邻接归一化权重(如)来“平均”邻居特征——所有邻居贡献相同(或仅由度数决定)。

GAT 为每条边分配不同的权重(可学习、输入自适应),从而更精准地聚合邻居。

GCN 更新节点的公式为:

优化后 GAT 更新节点特征的公式为:

为权重矩阵(线性变换);

表示节点

对邻居

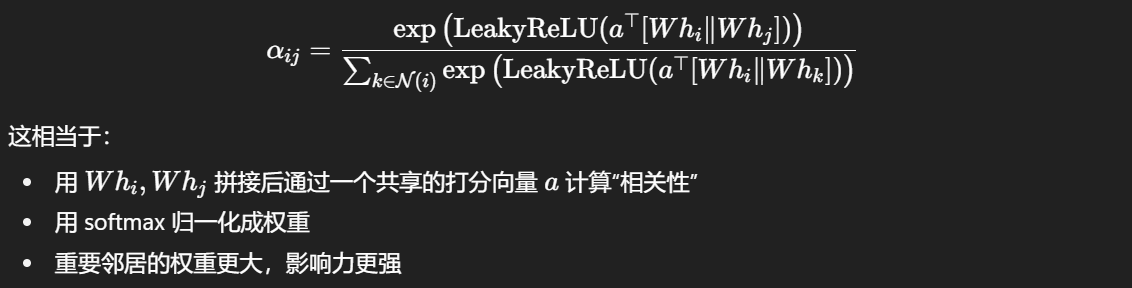

的注意力权重,计算公式为:

GAT 还引入多头注意力:用多个独立的和

并行计算不同的注意力分布。

这样,GAT 让模型能够选择性地聚合有用信息,过滤无关邻居,但是它的计算代价比 GCN 稍重,因为每条边都要计算注意力分数。

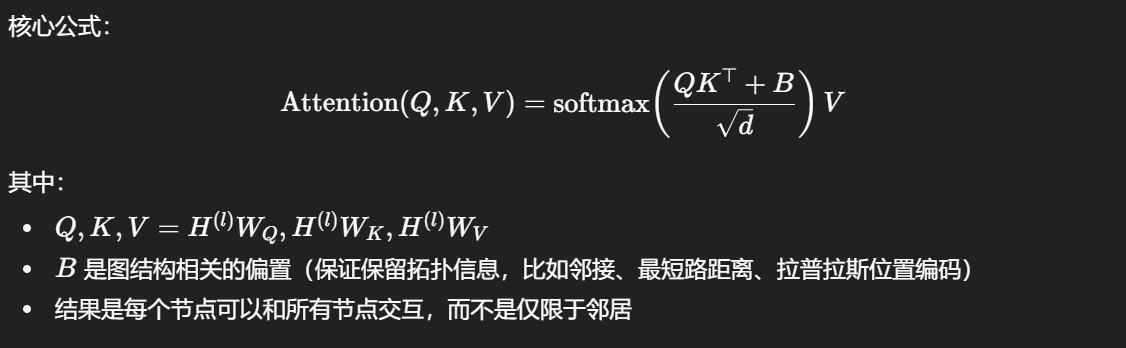

GFormer:Graph Transformer

GFormer(或更广义的 Graph Transformer)把 Transformer 的思想移植到图上,用全局自注意力代替邻居平均聚合,让每个节点都能和所有节点交互,并且交互强度由输入特征动态决定。

这样,GFormer 一个节点可以直接关注远处的节点,不用堆叠多层传播;但是它的计算复杂度更高,为,且需要额外设计位置编码/结构偏置,否则会丢失拓扑信息(不区分谁是邻居)。

(GCN 为普通图卷积,GAT 在此基础上做了邻居注意力,GFormer 则是在全图做注意力)

因此,尽管 GAT 和 GFormer 能够帮助模型捕捉更丰富的节点关系,但它们会显著增加训练的计算复杂度和显存开销。SPAR 本身就因为使用 GCN 而导致训练时间较长,因此直接替换为 GAT 或 GFormer 并不可取。

不过,可以考虑在节点构建方式上进行优化:将“像素级节点”替换为“patch 级节点”,类似 ViT 的做法,把多个相邻像素合并为更大的 patch 再作为单个节点建图,从而减少节点数。

2. 替代 GCN/GAT/GFormer

(1)文本→像素的低秩交叉注意力

让类别/文本 token 当 Query,像素特征当 Key/Value。复杂度从 (全局自注意)降为

(K=类数远小于像素数 N)。

相当于在 Self-prompting 的过程做了一次 像素文本;而在第二个过程做了一次 文本

像素;

(2)原型(Prototype)驱动的语义迁移

原型(prototype):文本原型(由 Self-prompting 得到的类别嵌入;携带高层语义);视觉原型(从当前图像或一个 batch中,按某类的初始评分选 Top-T 个高置信像素/patch,做加权均值;更贴合当前图像偏移);融合原型。

迁移:让每个位置 只与少量原型交互(而非与所有像素两两交互),完成低秩的消息传递。可采用注意力式迁移,残差式增强语义。

该方法如何贯彻了类比推理的思想? 高置信区域提炼出的特征已经捕捉了该类别的稳健模式,文本注入类别信息,小目标与之对齐得到增强。

(3)卷积近似的拉普拉斯平滑(无图的局部扩散)

不显式构图、不算邻接与度矩阵,直接在特征图上用小卷积核做“邻居平均”的扩散/平滑,把强语义区域的信息向周边扩散,提升局部一致性。但是这样无法直接捕捉到“远处但语义一致”的类比关系。可能的解决方法:

A. 在卷积前引入一个空间权重图 W(h,w),由特征相似度或文本指导生成,但是这样又大大增加了训练复杂度;

B. 扩展邻域,不限于小的卷积核;

C. 文本/视觉原型引导门控:用文本原型或视觉原型来生成通道门控或空间 mask:让卷积只在“和类相关”的区域扩散。(方法类似(2))

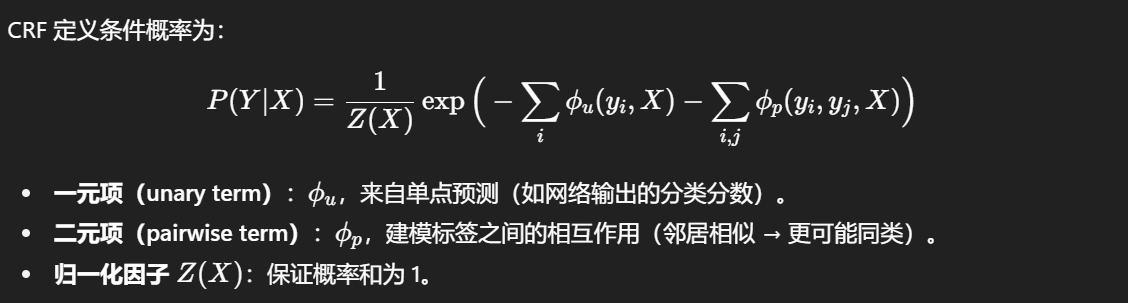

*(4)CRF/引导滤波 作为后验平滑(图像域高效近似)

CRF 在预测时考虑邻居之间的依赖关系,通过定义条件概率分布 P(Y∣X) 来直接建模标签序列 Y 在输入 X 下的联合概率。

具体来说:

CRF可以让相邻像素预测更平滑,同时在边缘处保持清晰分割。(DenseCRF)

(5)稀疏 KNN + 迭代标签传播

对每个类别/像素节点,只保留 Top-K 最相似邻居,构成稀疏图,大大降低了计算复杂度,同时减少噪声扩散。但 KNN 稀疏图可能导致“圈子固化”现象:大车只和大车互相连边,小目标(难目标)就吸收不到这些大车的“语义补强”。

———————————————————————————————————————————

改进方案1:引入位置嵌入+原型

采用融合原型(文本原型 + Top-T视觉原型 + 位置嵌入的方案)让每个位置都能按注意力权重补全语义信息;同时以残差的方式对原始特征进行强化,保留像素自身个性。

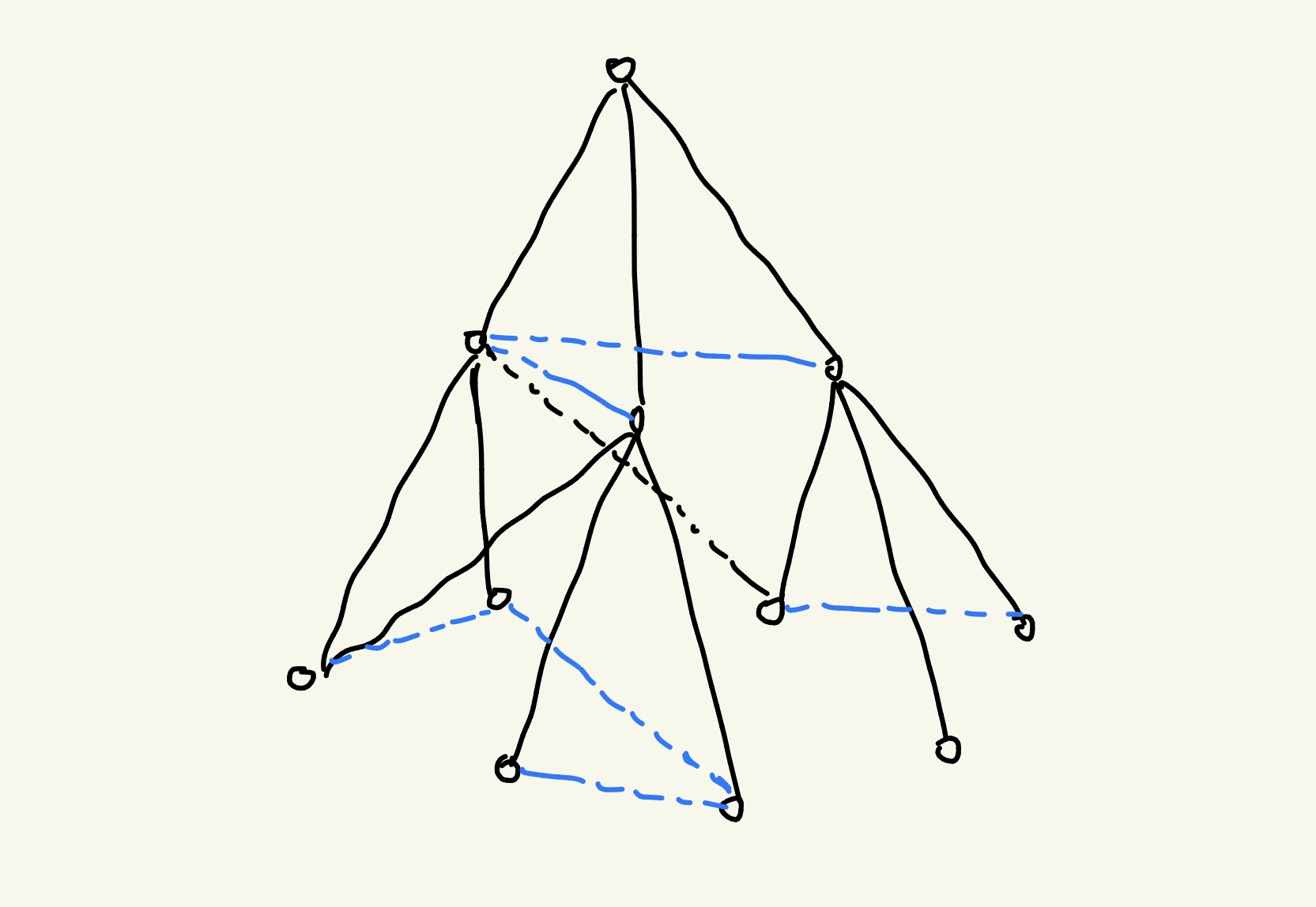

改进方案2:森林结构

文本嵌入作为多根节点;

像素特征按照其与根节点的相似度建树:用“概率分层” → 节点和根的相似度决定它落在某一层的概率,传播时做加权更新;

层内横向连接:允许兄弟节点之间有一定信息交换,可以吸收多源语义;

传播模式:自上而下传播,小目标(深层节点)会汇聚上层“大目标/强特征”的信息,同时避免了困难目标的噪声影响;自下向上传播,更新文本节点。

——————————————————————————————————————————