本地化部署 DeepSeek

本地化部署 DeepSeek 的详细步骤

- 一、安装 Ollama

- 二.安装模型-DeepSeek

- 三、安装配置 Chatbox AI(可选)

- 四.测试

一、安装 Ollama

Ollama 是一个开源的本地化工具,用于简化大型语言模型的本地运行和部署。

• 访问 Ollama 官网:进入Ollama 官网,点击“Download”按钮,选择与本地电脑系统对应的版本进行下载。

• 安装 Ollama:

• 下载完成后,运行安装程序(Windows 系统为.exe文件)。安装过程中,建议不要更改默认安装路径,因为后续模型安装也需要占用较大空间,需确保安装路径有足够的空间,建议至少预留 10GB。

说明:安装完成以后需要添加系统环境变量sysdm.cpl,默认ollama的路径:

“C:\Users\zhang\AppData\Local\Programs\Ollama\ollama.exe”

模型路径:C:\Users\zhang\AppData\Local\Programs\Ollama,

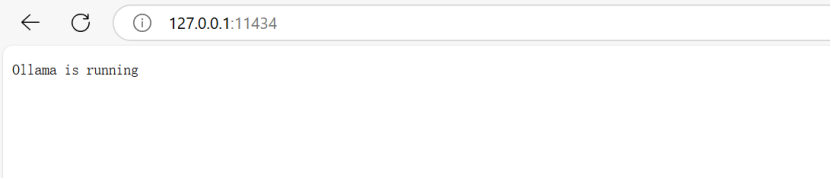

web访问链路:http://127.0.0.1:11434/

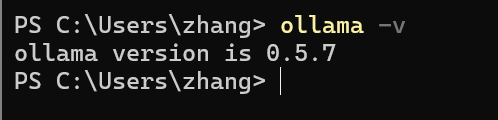

• 安装完成后,Ollama 会自动启动。可以通过任务栏图标或在命令提示符中输入ollama -v命令来确认 Ollama 是否正常安装,若能正常显示版本信息,则说明安装成功。

二.安装模型-DeepSeek

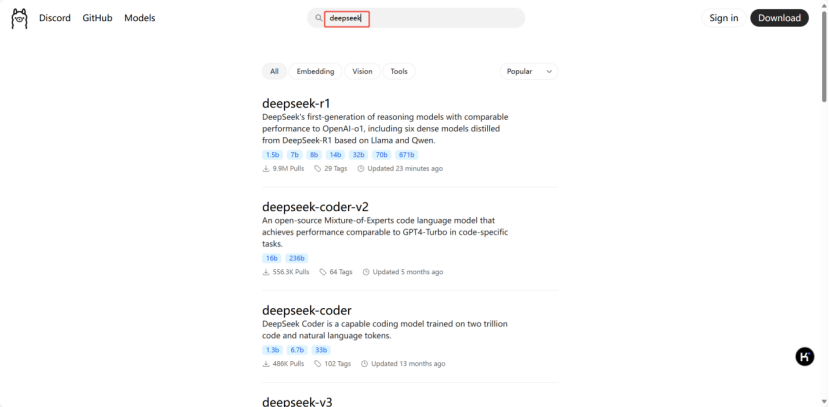

• 选择模型版本:这里很多开源的模型都能下载,包括deepseek和qwen

• 在 Ollama 官网首页的搜索框中输入“DeepSeek”,可以看到不同参数版本的 DeepSeek 模型,如 1.5b、7b、8b、14b、32b、70b、671b 等。不同版本的模型对电脑的内存及显存要求不同,需根据电脑配置选择合适的版本。一般来说,8b 版本对配置要求相对较低,14b 版本需要 12G 以上的显存才能流畅运行,而 32b 及以上版本则需要更高配置的显卡,如 3090 或 4090。

• 安装模型:

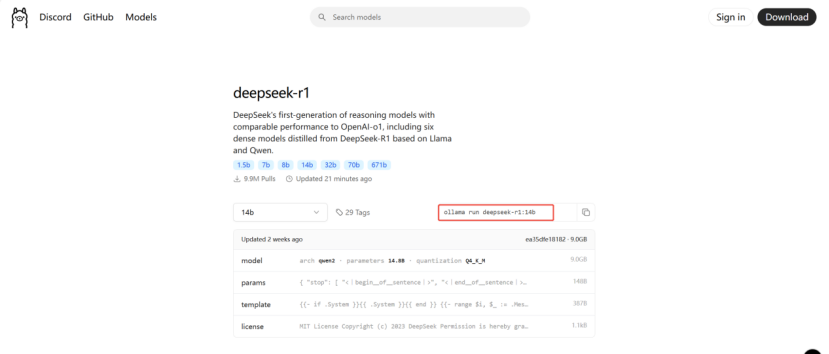

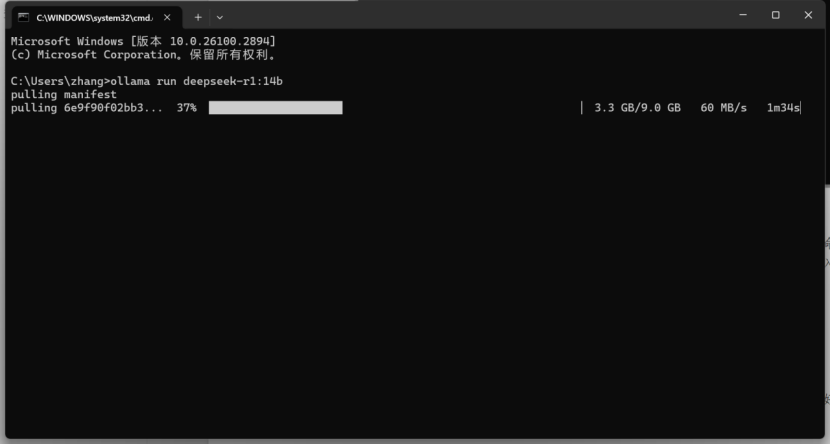

• 找到自己选择的模型版本,复制对应的安装命令。例如,安装 14b 版本的命令为ollama run deepseek-r1:14b。

• 打开命令提示符(Windows 系统可通过按下 Win+R 键,输入“cmd”并回车键打开),输入复制的安装命令并回车。

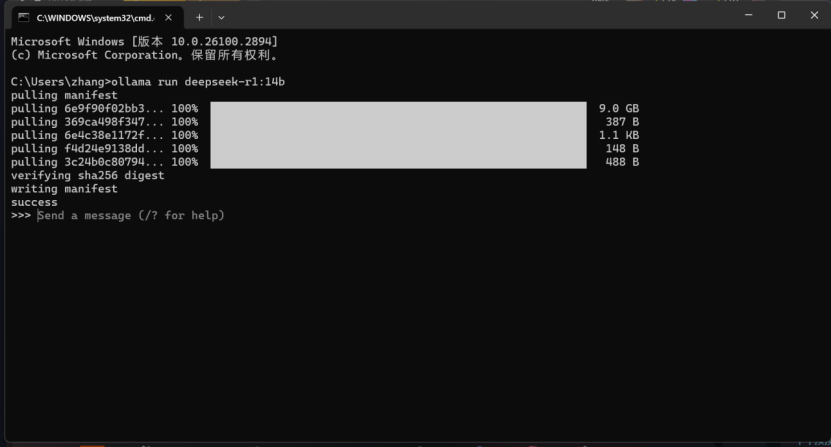

• 根据选择的模型大小和网络速度,等待一段时间(我这里大概1小时30分钟)后,若在命令提示符中看到“success”字样,则说明模型安装成功。此时,可以在命令提示符中输入问题与 DeepSeek 进行交互。

再次打开访问,可直接输入:ollama run deepseek-r1:14b

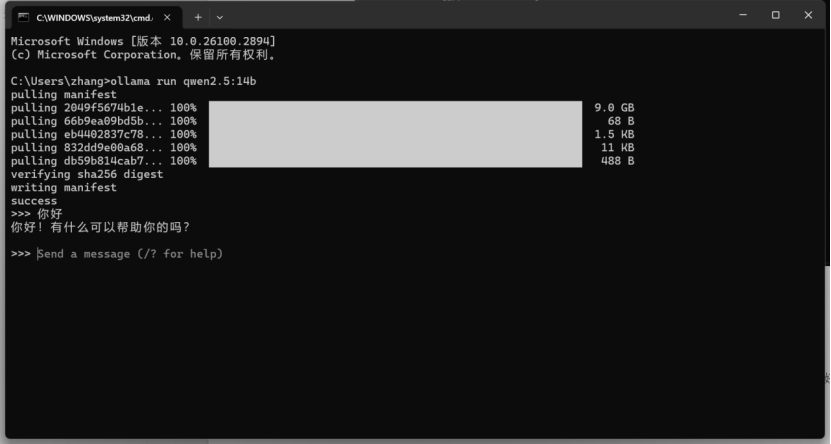

访问千问,可以输入:ollama run qwen2.5:14b

三、安装配置 Chatbox AI(可选)

Chatbox AI 是一款专门用于与各种语言模型对话的图形化工具,能够提供更友好的交互体验。

• 安装 Chatbox AI:

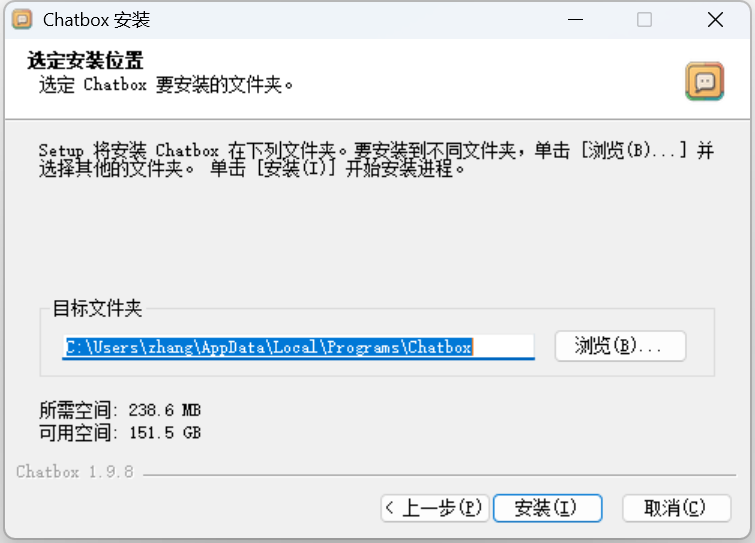

• 访问Chatbox AI 官网,点击“Download”按钮,选择与电脑系统对应的版本进行下载。

• 下载完成后,运行安装程序(Windows 系统为.exe文件)进行安装,安装完成后会自动打开 Chatbox AI 软件。

• 配置 Chatbox AI:

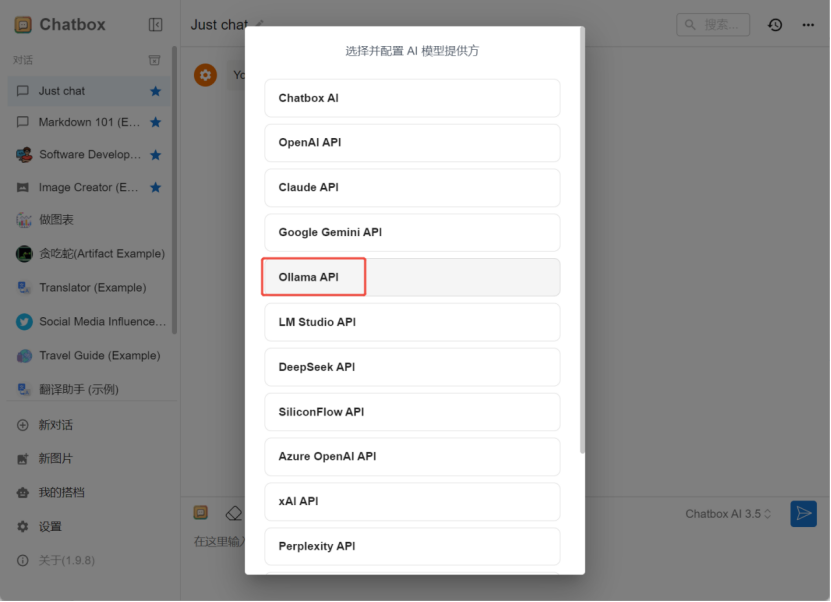

• 点击 Chatbox AI 软件左下角的设置按钮,在“模型”选项卡中进行以下配置:

• 模型提供方:选择“Ollama API”。

• API 域名:填写http://localhost:11434,这是 Ollama 的默认端口。

• 模型名称:填写与部署的 DeepSeek 模型版本严格一致的名称,例如,如果安装的是 7b 版本的 DeepSeek 模型,则填写deepseek-r1:14b。

• 在“对话”选项卡中可以进行用户头像、机器人助手头像、新对话默认提示等设置。

• 设置完成后,点击“保存”按钮。

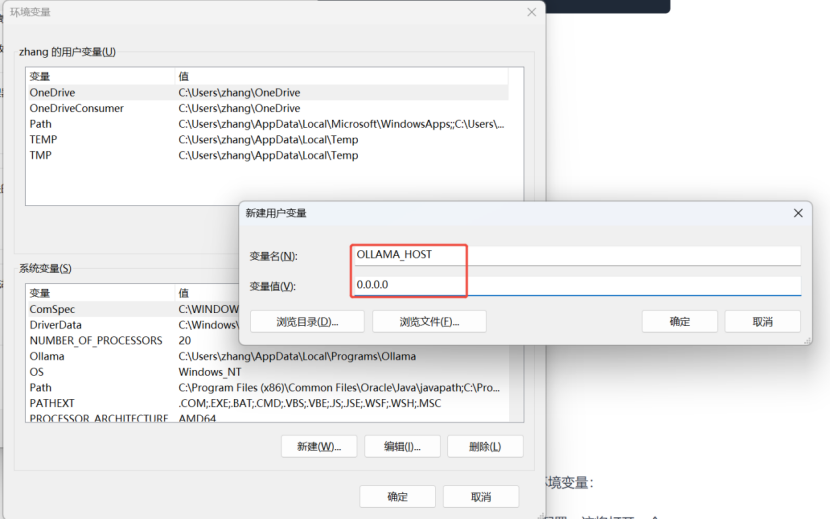

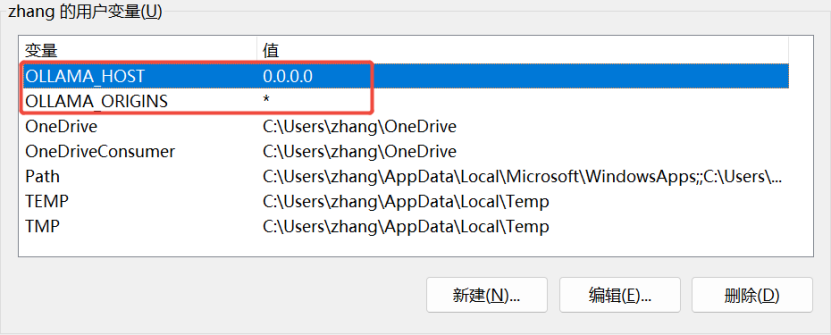

新建用户环境变量:

四.测试

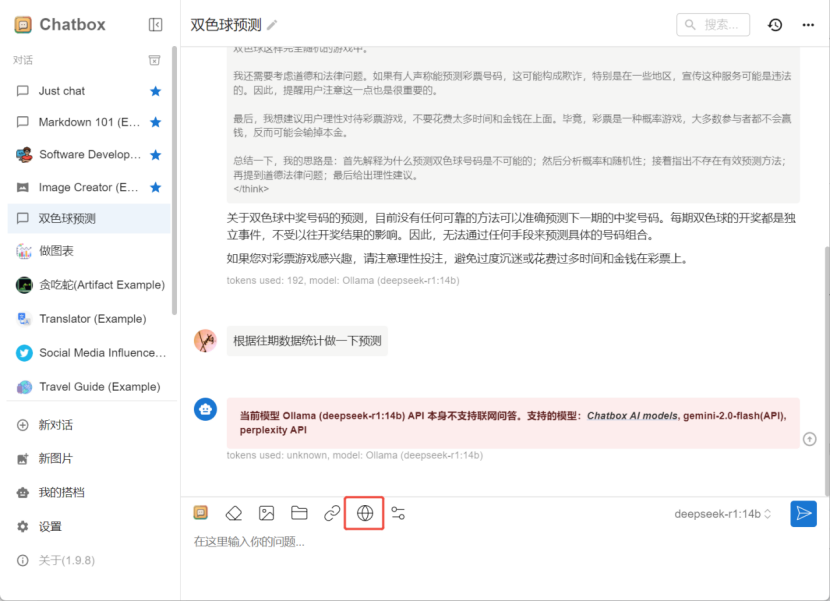

• 在 Chatbox AI 软件左侧点击“新对话”,会自动建立一个新的对话框,即可像微信聊天一样与 DeepSeek 模型进行对话。

测试结果:

不支持联网功能

四、其他注意事项

• 硬件配置要求:虽然 DeepSeek 的部分小版本模型对硬件要求相对较低,但为了获得更好的性能和体验,建议使用较高配置的电脑,特别是显卡和内存方面。例如,对于 14b 及以上版本的模型,显存至少需要 12G 以上,内存建议 16G 及以上。

• 磁盘空间:安装 Ollama 和 DeepSeek 模型需要占用较大的磁盘空间,尤其是大版本的模型。在安装前,需确保安装路径有足够的空间,避免因空间不足导致安装失败或运行异常。

• 网络问题:在安装过程中,可能会因网络问题导致下载超时等情况,可尝试重新运行安装命令或更换网络环境。