【ES9.X】GitHub-events 聚合方案

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 前言

- 一、高层结论(快速看)

- 二、两种方案详细比较

- 三、推荐技术栈(组件 + 建议版本)

- 四、操作步骤总览

- 五、关键配置(可复制执行)

-

- 5.1 索引模板(data stream template)

- 5.2 Ingest Pipeline

- 5.3 Summary(Transform)

- 六、常见问题(FAQ)与调优建议

- 七、总结

前言

目标读者:想把每天大量的 GitHub event 导入 Elasticsearch 9,并做 用户/仓库 × 事件类型 的月/年统计、同时能容忍“迟到”(乱序)数据的工程师或运维。

本文总结 两种方案 的适用场景、优缺点、组件清单与配置示例(索引模板 / ingest pipeline / transform / bulk 导入 / docker-compose)。示例基于 Elasticsearch 9.x。为方便演示我使用官方镜像(你也可替换为 bitnami 镜像),并提供可复制的 curl + heredoc 命令。

一、高层结论(快速看)

-

方案 A — 实时数据流(low-latency,数据时间跨度小、迟到少)

适用于写入延迟很小、乱序几分钟内能到达的场景。实现路径:filebeat/Logstash 或 Bulk API → data stream(或普通索引)→ ingest pipeline(抽字段/生成 payload_text)→ ILM rollover → (可选)Transform/rollup 做历史视图。优点:实时性高、实现简单;缺点:对“长延迟”迟到数据支持弱。 -

方案 B — 延迟-容错数据流(大时序乱序 / 跨天跨月迟到)

适用于事件写入可能跨天/跨月到达(你描述的场景)。关键点:在 pipeline 中同时写入 事件时间 @timestamp(来自事件本身,如 create_time)以及一个 摄取时间 ingest_time(由 ingest pipeline 自动写入);Transform 的 sync.time.field 用 摄取时间 ingest_time,而分桶用 事件时间 @timestamp。并采用两阶段:先做 batch 回填历史索引(一次性),再用 continuous transform 处理增量。优点:不会遗漏迟到数据(无论迟到多久);缺点:实时性稍复杂(回填 + 持续同步),Transform 资源消耗大时需要分段回灌或限制频率。

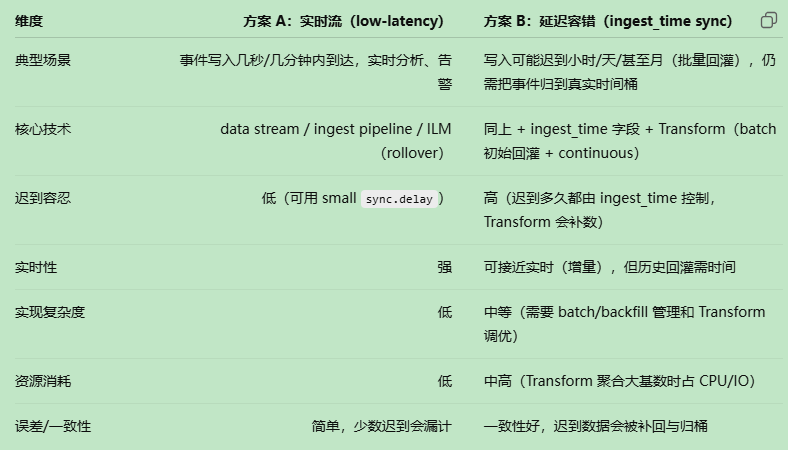

二、两种方案详细比较

三、推荐技术栈(组件 + 建议版本)

下面是本文示例和测试时使用 / 推荐的组件版本。你可以用你已有的镜像(比如你已拿到 bitnami/elasticsearch:9.1.2),模块间兼容性要注意(Elasticsearch 9 → Kibana 9)。Filebeat/Logstash 官方 8.x Beats 可能仍能工作,但请以兼容性文档为准。

- Elasticsearch: 9.1.2(示例;你已有 bitnami/elasticsearch:9.1.2)

- Kibana: 9.1.2(可选,ui 可视化)

- MinIO(可选,作为 snapshot repo):minio/minio:RELEASE.2025-05-24T17-08-30Z(你早前提到的)

- Logstash(可选,ETL 选项):docker.elastic.co/logstash/logstash:8.x(或兼容版本)

- Filebeat(可选,用于采集已解压后的 NDJSON 或搭配预处理):推荐用能配合 ES 版本的 Beats(查官方兼容矩阵)

- 工具:curl, zcat / gunzip(用于 bulk 导入)

四、操作步骤总览

- 准备 Docker 环境并把 docker-compose.yml 放一处。

- 启动 ES / Kibana / MinIO(如果需要 snapshot)。

- 创建 索引模板(data stream template) —— 指定 payload 类型(建议 flattened)并为 actor_login/repo_name 提供 keyword + text(支持精确/模糊)。

- 创建 ingest pipeline:写入 ingest_time、解析 @timestamp(来自 created_at / create_time)、抽取 actor_login/repo_name/event_type/commit_count,并生成 payload_text。

- 创建 data stream(写入时自动创建 backing index),通过 pipeline 写入。

- 方案 A:直接在索引上用 Kibana/ES 查询/可视化;(可选)建立 ILM / rollover。

- 方案 B(若跨天/跨月乱序): 做一次 batch Transform(无 sync)对历史数据回灌 summary 索引,或使用 pivot Transform 的 preview / 分段 backfill。 创建 continuous Transform(sync.time.field = ingest_time)以捕获后续迟到数据并把它们按 @timestamp 归入正确桶(month/year)

- 定期检查 Transform 状态、ILM 状态与磁盘使用情况。

五、关键配置(可复制执行)

5.1 索引模板(data stream template)

重点:payload 使用 flattened,actor_login / repo_name 提供 keyword + text 子字段,便于精确与模糊查询。

curl