通义万相音频驱动视频模型Wan2.2-S2V重磅开源

引言:AI视频生成技术迎来历史性突破

2024年8月26日,阿里云通义万相团队宣布重磅开源全新音频驱动视频生成模型Wan2.2-S2V,这是继文生视频、图生视频、首尾帧生视频、全能编辑模型后的又一里程碑式发布。该模型仅需一张图片和一段音频,即可生成面部表情自然、口型一致、肢体动作丝滑的电影级数字人视频,生成时长可达分钟级。

相关演示视频:

- 【Wan2.2实测】吊打所有开源视频模型?挑战Kling/Veo3王座

- AI视频生成神器!音频对口型、图生视频、文生视频演示

通义万相Wan2.2-S2V:革命性技术突破

复杂场景音频驱动能力

Wan2.2-S2V展现出卓越的多样性支持能力,可驱动真人、卡通、动物、数字人等多种类型图片,并支持肖像、半身以及全身等任意画幅。用户只需上传一段音频,模型就能让图片中的主体形象完成说话、唱歌和表演等动作。

通义团队基于通义万相的通用视频生成能力,创新性地融合了文本引导的全局运动控制和音频驱动的细粒度局部运动,实现了复杂场景的音频驱动视频生成。通过引入AdaIN和CrossAttention两种控制机制,实现了更准确更动态的音频控制效果 。

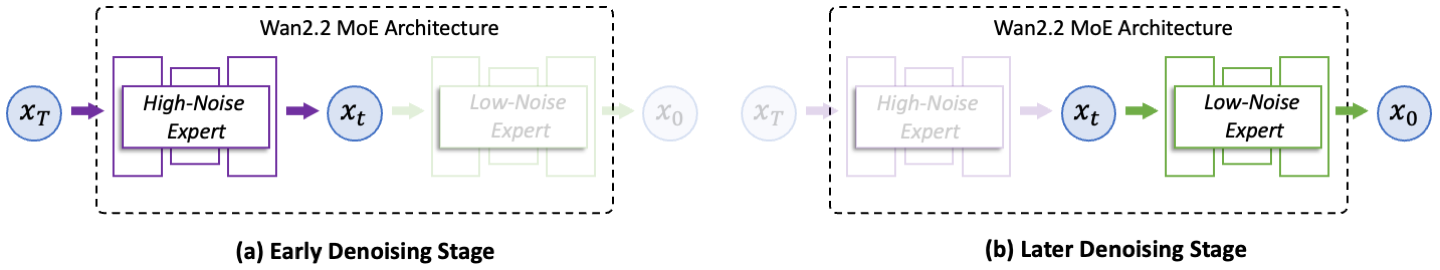

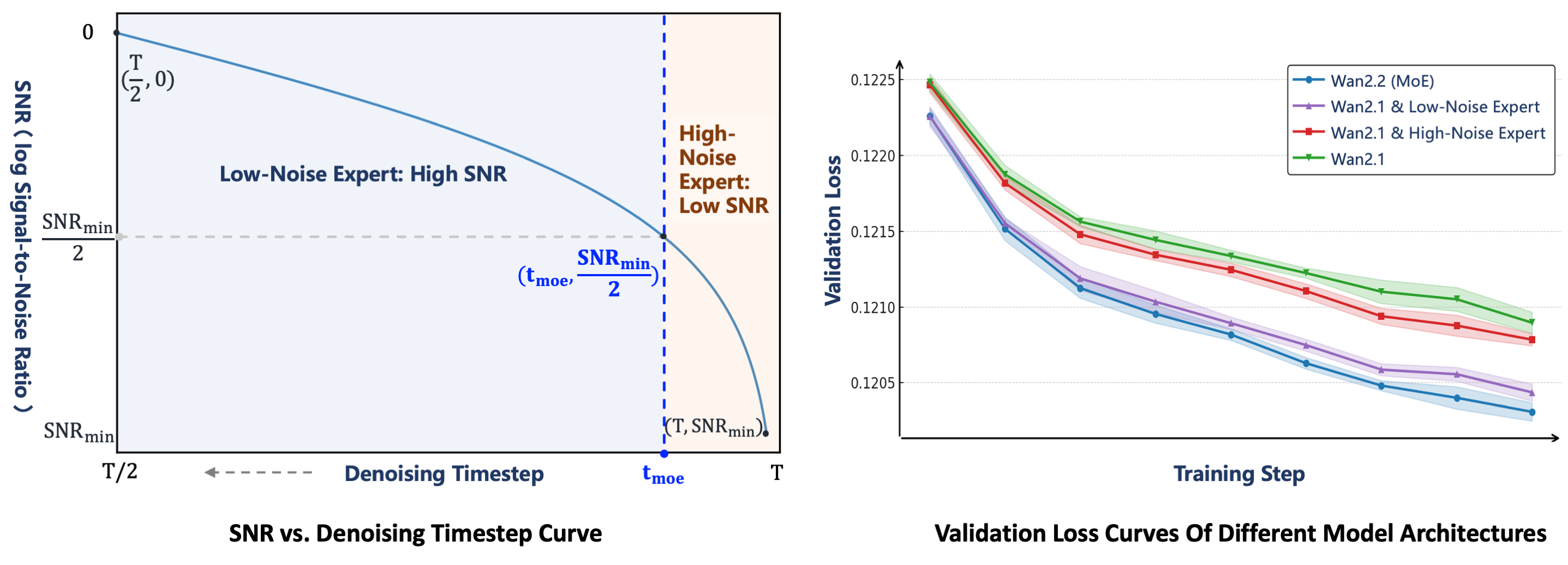

创新MoE架构:业界首创双专家模式

Wan2.2引入了业界首个视频生成领域的MoE(Mixture-of-Experts)架构,这是该模型的核心技术创新。MoE架构采用了两专家设计,专门针对扩散模型的去噪过程进行优化:

- 高噪专家模型:负责早期阶段的整体布局规划

- 低噪专家模型:负责后期阶段的视频细节优化

每个专家模型拥有约140亿参数,总计270亿参数,但每步仅激活140亿参数,保持推理计算和GPU内存使用几乎不变 。

长视频稳定生成技术

在生成时长方面,Wan2.2-S2V单次生成的视频时长可达业界领先的分钟级。该模型通过层次化帧压缩技术,大幅降低了历史帧的Token数量,将motion frames(历史参考帧)的长度从数帧拓展到73帧,从而实现了稳定的长视频生成效果。

精准文本控制与多分辨率支持

Wan2.2-S2V支持文本控制功能,输入Prompt后可对视频画面进行精准控制,实现镜头运动、角色轨迹和实体间互动。通过多分辨率训练,该模型可支持不同分辨率场景的视频生成需求,包括竖屏短视频、横屏影视剧等多种格式。

技术深度解析视频:

- Wan2.2百科全书:文生视频、图生视频全面解析

- Wan2.2高级运用方式!11大进阶用法详解

AI图像生成领域重大进展:Qwen-Image开源引关注

通义千问首个图像生成基础模型

2025年8月5日,阿里通义千问团队宣布开源20B的MMDiT模型Qwen-Image,这是通义千问系列首个图像生成基础模型。该模型在复杂文本渲染和精确图像编辑方面取得显著进展,支持文生图和通用图像编辑功能。

根据测试数据显示,Qwen-Image在GenEval、DPG等通用图像生成和GEdit、ImgEdit等图像编辑的主流评测中表现优异,甚至在某些指标上达到了开源模型的新高度。

全参数化训练与数据集优势

在模型训练方面,通义团队构建了超60万个片段的音视频数据集,通过混合并行训练进行全参数化训练,充分挖掘了模型性能。相比Wan2.1,Wan2.2的训练数据增加了65.6%的图像和83.2%的视频,这种大规模数据扩展显著增强了模型在运动、语义和美学等多个维度的泛化能力。

全球AI视频生成赛道竞争白热化

Sora引领的行业变革浪潮

自2024年2月OpenAI发布Sora以来,AI视频生成技术迎来爆发式发展。Sora的问世不仅推动了视频生成技术出圈,更催化了整个产业的快速发展步伐。据量子位智库研究报告显示,2024年AI视频生成是最受关注的技术领域之一,投资规模和技术突破频次都创下历史新高 。

行业对比分析视频:

- 阿里WAN2.1开源实测:对比Veo2,开源视频模型天花板?

- Sora上线后AI视频生成赛道分析

开源生态加速成熟

开源模型发展迅速,能力已逐渐比肩闭源模型。根据中国工业互联网研究院发布的《人工智能大模型年度发展趋势报告》,2024年开源大模型发展迅速,开源模型与闭源模型的平均能力差距正在急剧缩小,顶尖开源模型能力已经比肩闭源模型。

Wan2.2作为全球首个开源的MoE架构视频生成模型,在这一趋势中扮演了重要的推动作用。其开源发布不仅降低了技术门槛,更为整个行业建立了新的技术标杆。

AI数字人市场蓬勃发展

市场规模快速扩张

根据IDC发布的《中国2024年AI数字人市场份额》报告显示,2024年中国AI数字人市场规模约41.2亿元,同比增长85.3%,实现了高速增长态势。

这一快速增长得益于技术成熟度的提升和应用场景的不断拓展。特别是音频驱动视频生成技术的突破,让数字人在表情同步、口型匹配等关键指标上达到了接近真人的水平。

数字人技术应用视频:

- 最强开源数字人LatentSync1.5演示

- AI数字人新玩法!EchoMimic V2音频驱动详解

广泛的应用场景

AI数字人技术作为连接虚拟与现实世界的重要媒介,正在构建新型内容输出范式,显著提升内容产业价值。在AIGC技术的推动下,AI数字人已在以下领域展现出巨大应用潜力:

- 数字人直播:24小时不间断直播,降低人工成本

- 影视制作:快速生成演员替身,提升制作效率

- AI教育:个性化教学助手,提供沉浸式学习体验

- 在线客服:智能客服代表,提升服务质量

- 新闻播报:自动化新闻播报,提高时效性

- 直播带货:虚拟主播带货,拓展营销渠道

开源生态建设全面加速

完善的开源支持体系

通义万相Wan2.2-S2V的开源发布为开发者提供了完整的技术支持生态:

开源代码与模型:

- GitHub开源地址:https://github.com/Wan-Video/Wan2.2

- 魔搭社区:通义万相2.2-S2V-14B

- HuggingFace平台:https://huggingface.co/Wan-AI/Wan2.2-S2V-14B

社区生态蓬勃发展

开源发布后,Wan2.2迅速获得了社区的积极响应。多个第三方项目和工具开始集成Wan2.2能力:

- DiffSynth-Studio:提供了低GPU内存、FP8量化、序列并行等优化支持

- ComfyUI集成:官方和第三方都提供了ComfyUI节点支持

- Diffusers集成:支持T2V、I2V和TI2V多个版本

技术部署教程视频:

- Wan2.2本地部署教程,ComfyUI集成指南

- 8G显卡运行Wan2.2完整教程

技术创新亮点深度解析

高压缩比VAE架构突破

Wan2.2引入了高压缩Wan2.2-VAE,实现了T×H×W压缩比达到4×16×16的技术突破,总体压缩率提升至64倍,同时保持高质量视频重建能力。TI2V-5B模型通过额外的分块化层,将总压缩比进一步提升至4×32×32。

这一技术创新使得TI2V-5B能够在消费级GPU上生成5秒720P视频,用时不到9分钟,成为当前最快的720P@24fps视频生成模型之一。

信噪比驱动的专家切换机制

Wan2.2的MoE架构采用了基于信噪比(SNR)的智能专家切换机制。通过定义阈值步骤t_moe对应SNR_min的一半,实现了高噪专家和低噪专家之间的平滑切换,确保了视频生成过程的连续性和质量一致性。

电影级美学控制能力

Wan2.2整合了精心策划的美学数据,包含详细的灯光、构图、对比度、色调等标签信息。这使得模型能够进行更精确和可控的电影风格生成,满足专业创作者对视觉质量的严格要求。

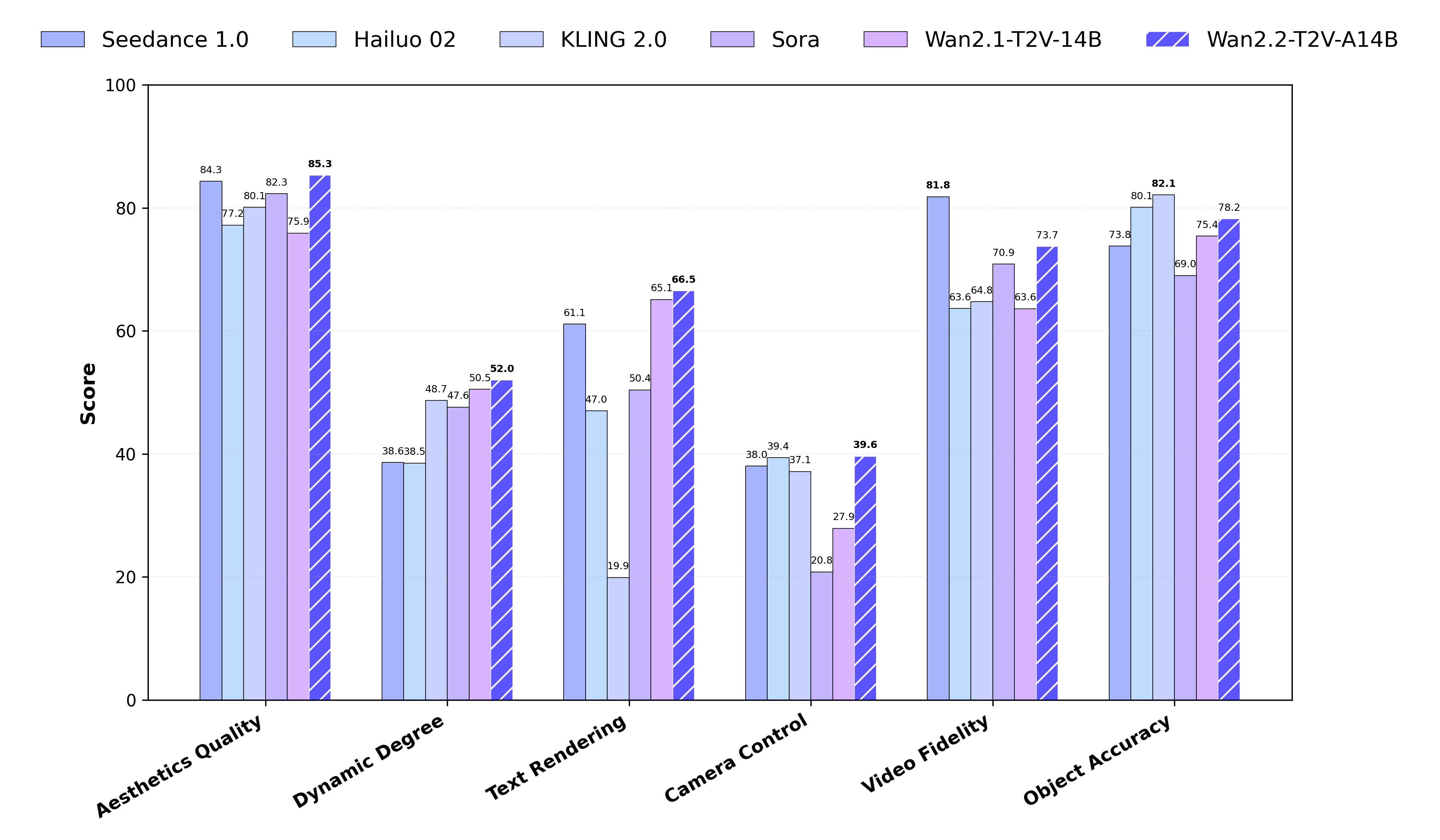

性能基准测试与行业对比

权威评测结果

根据新发布的Wan-Bench 2.0评测结果,Wan2.2在与领先闭源商业模型的对比中展现出优异性能,在多个关键维度上实现了领先:

- 视频质量:在画面清晰度、细节保真度方面表现突出

- 运动一致性:在复杂动作序列生成中保持高度一致性

- 文本理解:在prompt理解和执行方面准确度更高

- 美学质量:在色彩、构图、光影效果方面达到电影级标准

计算效率优势

Wan2.2在不同GPU配置下的计算效率表现:

| 模型版本 | GPU配置 | 内存使用 | 生成时间 | 视频质量 |

|---|---|---|---|---|

| TI2V-5B | RTX 4090 | 24GB | <9分钟 | 720P@24fps |

| T2V-A14B | 8×A100 | 80GB | 分钟级 | 720P@24fps |

| S2V-14B | 8×H100 | 80GB | 分钟级 | 720P@24fps |

行业发展趋势与未来展望

多模态融合成为主流

随着技术不断成熟,AI模型正从单一模式转向多模态融合。通义万相Wan2.2-S2V通过融合音频、图像、文本等多种模态信息,实现了更加智能和自然的视频生成效果,代表了行业发展的重要方向。

开源推动产业生态繁荣

开源模型的快速发展正在推动整个AI产业生态的繁荣。通过开源,技术门槛大幅降低,更多开发者和企业能够参与到AI技术的研发和应用中,加速了技术创新和产业化进程。

应用场景持续拓展

随着技术能力的不断提升和成本的持续下降,AI视频生成和数字人技术的应用场景将持续拓展:

- 专业影视制作:从概念设计到后期制作的全流程支持

- 个人内容创作:让普通用户也能创作专业级视频内容

- 企业营销推广:定制化品牌形象和营销视频

- 教育培训:沉浸式学习体验和个性化教学内容 创新应用案例视频:

- 一站式视频创作工作流,Wan2.2+音频+换脸同步

- WAN2.2炸裂发布!AI视频生成新王来了

技术部署与使用指南

硬件配置要求

Wan2.2-S2V支持多种硬件配置,从消费级到专业级GPU都有相应的部署方案:

最低配置:

- GPU:RTX 4090 (24GB VRAM)

- 模型:TI2V-5B

- 功能:文生视频、图生视频

- 生成速度:720P视频<9分钟

推荐配置:

- GPU:8×A100 (80GB VRAM)

- 模型:S2V-14B

- 功能:音频驱动、姿态控制

- 生成速度:分钟级

安装与使用

基础安装:

Copygit clone https://github.com/Wan-Video/Wan2.2.git

cd Wan2.2

pip install -r requirements.txt

📋模型下载:

Copyhuggingface-cli download Wan-AI/Wan2.2-S2V-14B --local-dir ./Wan2.2-S2V-14B

📋音频驱动视频生成:

Copypython generate.py --task s2v-14B --size 1024*704 --ckpt_dir ./Wan2.2-S2V-14B/ --prompt "Summer beach style" --image "input.jpg" --audio "talk.wav"

📋结语:开源AI的无限可能

通义万相Wan2.2-S2V的开源发布不仅是技术上的重大突破,更代表了AI发展理念的深刻变革。从闭源竞争到开源协作,从技术壁垒到知识共享,这种转变正在重塑整个AI产业的发展格局。

随着Qwen-Image等图像生成模型的持续突破,以及MoE架构在视频生成领域的成功应用,我们有理由相信,AI视频生成和数字人技术将在未来几年迎来更加蓬勃的发展。这不仅将为内容创作、数字娱乐、教育培训等传统领域带来革命性变化,更将催生出我们目前尚未想象到的全新应用场景。

在这个技术快速迭代的时代,保持对前沿技术的敏感度和学习能力,积极拥抱开源生态,将是每个从业者和企业适应未来发展的关键。通义万相的开源举措不仅体现了技术共享的精神,更为整个行业的健康发展奠定了坚实基础。

正如GitHub项目页面所展示的丰富功能和社区生态,Wan2.2已经不仅仅是一个技术产品,更是一个充满活力的技术社区和创新平台。随着更多开发者的参与和贡献,我们期待看到这一开源项目在未来创造出更多令人惊艳的应用和突破。

文章来源:AITOP100,原文地址:通义万相音频驱动视频模型Wan2.2-S2V重磅开源-AITOP100,AI资讯