Prompt工程完全指南:从基础结构到AI时代的上下文革命

Prompt工程完全指南:从基础结构到AI时代的上下文革命

💡 特殊说明

本文基于数百篇公开发布的 Prompt 工程技术文章,经过整理、归纳与拓展后撰写。

旨在为读者提供系统且实用的参考资料。

摘要

在AI驱动的时代,Prompt已从简单的提示词升级为人机协作的操作系统——它决定了大语言模型的思考路径与输出质量。本文深度解析Prompt的本质、黄金结构的10大模块(从任务上下文到输出格式)、概率与上下文优化原理,以及实用的调试与自动化技巧。通过真实案例展示如何用结构化Prompt驱动高质量代码生成、协调多智能体协作,并展望Prompt工程向上下文工程演进的未来趋势。如果你想让AI更聪明、更可靠地工作,这篇指南是不可错过的全景地图。

一、Prompt的本质与核心价值

在AI驱动的开发范式中,Prompt(提示词)已从简单的指令升级为人机协作的核心接口。它不仅是大语言模型(LLM)的“操作手册”,更是人类意图与机器能力之间的“翻译器”。LLM本质是概率驱动的“续写引擎+模式压缩器”,其输出质量高度依赖输入的结构化程度——清晰的Prompt能显著降低模型熵值,减少幻觉并提升任务成功率。

随着深度智能体(Deep Agents)的兴起,Prompt的角色进一步扩展:从单一任务指令演变为包含角色定义、能力边界、协作规则的“智能体操作系统”。例如,Claude Code的系统提示包含数百行工具使用规范和行为准则,而Manus等智能体通过Prompt实现子智能体的上下文隔离与专业分工。

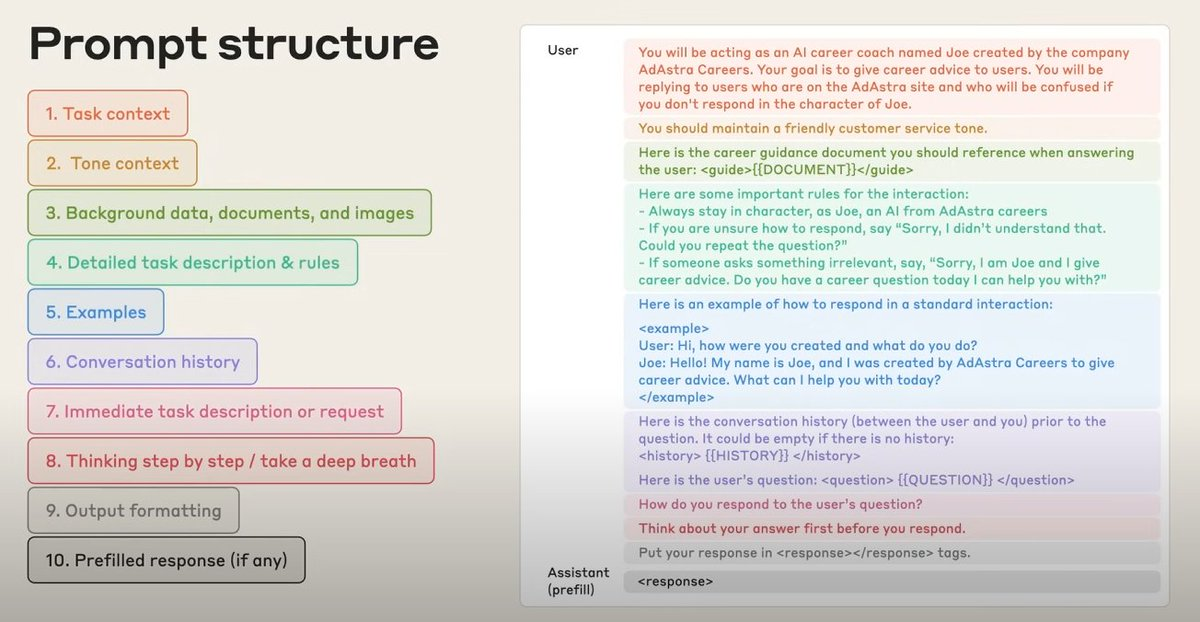

二、Prompt的黄金结构:十大核心组成部分

高效Prompt需像精密仪器一样结构化。根据实战总结,完整的Prompt应包含以下模块,各部分协同作用以引导模型输出:

1. 任务上下文(Task Context)

定义AI的角色、目标场景及核心任务。例如:“你是AdAstra Careers的AI职业教练Joe,为网站用户提供职业建议”。清晰的上下文能避免模型角色漂移,确保输出符合场景预期。

2. 语气与风格(Tone Context)

指定输出的语言风格(如“友好的客户服务语气”“技术文档的严谨风格”),甚至可包含角色性格特征(如“幽默但专业”)。这一步直接影响用户体验,尤其在对话式AI中至关重要。

3. 背景数据与素材(Background Data)

提供模型决策所需的事实依据,包括文档、图片、代码片段等。例如,让AI分析用户反馈时,需附上原始评论数据;生成代码时,需提供现有项目结构。关键原则:素材需结构化(如分点列出),避免冗长文本淹没核心信息。

4. 详细任务描述与规则(Detailed Task Rules)

明确任务边界、禁忌行为及输出标准。例如:“回答时必须引用提供的文档内容,无法回答时回复‘Sorry, I didn’t understand that’”。复杂任务需列出步骤化要求,如“先分析用户意图,再调用工具查询,最后生成自然语言回答”。

5. 示例(Examples)

通过“输入-输出”对展示期望格式。例如,定义AI回复用户问题的模板:“用户问‘你是谁?’时,回答:‘Hello! I’m Joe, created by AdAstra Careers to give career advice…’”。示例越具体,模型对齐效果越好,尤其适用于格式生成(如JSON、Markdown)。

6. 对话历史(Conversation History)

在多轮交互中,需包含前序对话内容以维持上下文连贯。但需注意记忆管理:过长历史会导致模型注意力分散,建议仅保留最近3-5轮关键信息,或通过摘要压缩核心内容。

7. 即时任务指令(Immediate Task Request)

用户当前的具体问题或需求,需简洁明确。例如:“用Markdown格式总结《人类简史》的核心观点”比“谈谈《人类简史》”更易获得精准结果。

8. 思考步骤引导(Thinking Step-by-Step)

通过“Let’s think step by step”等引导语,强制模型展开推理过程,减少跳跃性错误。例如,解决数学问题时,让AI先列出公式再计算,可显著提升准确率。

9. 输出格式(Output Formatting)

指定输出的结构(如表格、JSON、代码块),甚至可提供模板。例如:“用以下JSON格式返回结果:{“title”: “…”, “key_points”: […]}"。工具如jsonprompt.ai可自动生成格式约束Prompt,确保输出兼容性。

10. 预填充响应(Prefilled Response)

在复杂工具调用场景中,预填充回复开头以引导模型行为。例如:“接下来我将调用工具:browser_search(关键词=‘2025 AI趋势’)”,避免模型遗漏关键步骤。

三、Prompt工程的核心原理:驾驭LLM的概率本质

要设计出高效Prompt,需先理解LLM的底层逻辑:模型通过学习人类语言的概率分布预测下一个token,而Prompt的作用是通过结构化信息“调整概率分布”,引导模型生成期望结果。

1. 熵值管理:平衡确定性与创造力

- 低温(Temperature≈0):概率集中于高可能性token,输出确定但刻板,适用于事实性任务(如数据解析、代码生成)。

- 高温(Temperature>1):概率分布均匀化,输出多样但可能混乱,适用于创意写作(如文案、故事生成)。

- 动态调整:复杂任务可分阶段设置温度,例如“规划阶段高温发散思路,执行阶段低温确保准确”。

2. 上下文窗口:有限资源的最优分配

LLM的上下文窗口(如GPT-4的128k token)是稀缺资源,需通过以下策略优化:

- 前缀压缩:将固定指令(如系统提示)作为前缀缓存,动态内容后置,提升缓存命中率。

- 外部记忆:超长文本(如万字文档)存储为文件,Prompt中仅保留路径,通过工具按需读取。

- 信息分层:按重要性排序内容,核心约束(如安全规则)置顶,次要信息后置。

3. 模式对齐:用“强特征”引导模型行为

模型对“范式信号”敏感,例如:

- 字段名与格式:JSON中的键名(如"user_intent")、代码中的变量命名(如camelCase)会触发模型的格式记忆。

- 示例优先级:模型倾向模仿最近的示例,因此关键案例需放在示例集末尾。

- 否定提示:明确“不要做什么”(如“避免使用技术术语”)比仅说“要做什么”更有效。

四、实用技巧与最佳实践

基于数百个实战案例总结,以下技巧能显著提升Prompt效果:

1. 上下文构建:从“模糊需求”到“精准指令”

- 角色具象化:为AI分配具体角色(如“资深前端工程师”“产品经理”),并赋予背景(“5年React开发经验,熟悉Ant Design”)。

- 边界定义:明确能力范围,例如“仅使用提供的API文档,不调用外部工具”。

- 隐含需求显性化:将模糊描述转化为可执行条件,例如“现代设计”→“类似Linear的极简UI,主色调#5E6AD2,卡片圆角8px”。

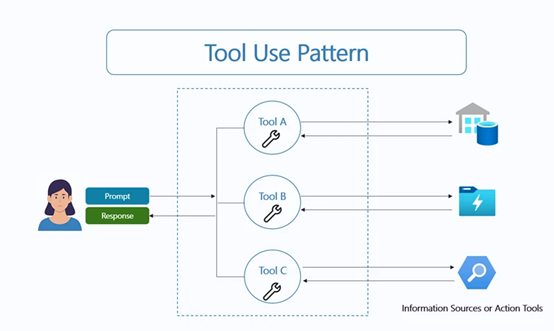

2. 工具调用与协作:Prompt驱动的智能体协同

- 工具列表前置:在Prompt开头列出可用工具及参数,例如:“你可以调用:1. web_search(query: str) 2. code_interpreter(code: str)”。

- 子智能体分工:通过Prompt定义子智能体角色,例如“让‘数据分析师’处理Excel,‘可视化专家’生成图表”,并指定协作规则(如“分析师输出CSV后@可视化专家”)。

- 多轮验证循环:在Prompt中嵌入自检机制,例如“生成代码后,先运行测试用例,若失败则修改并重新测试”。

3. 错误预防与调试:让Prompt“防呆”

- 歧义标注:对可能误解的术语添加注释,例如“‘用户活跃’指‘近7天登录≥3次’”。

- 反例警示:提供错误示例及原因,例如“错误:使用了过时API→正确:调用v2版本的getUser()”。

- 版本控制:像管理代码一样管理Prompt,通过Git追踪变更,便于回溯与A/B测试。

五、工具与自动化:提升Prompt工程效率

以下工具与方法可简化Prompt设计与管理:

1. 格式控制工具

- jsonprompt.ai:输入自然语言需求,自动生成格式约束Prompt,确保输出为JSON/XML等结构化数据。

- Cursor规则生成器:根据项目最佳实践,自动生成.mdc规则文件,规范AI代码生成行为(如强制ESLint标准)。

2. 上下文管理工具

- GitHub Copilot自定义指令:通过仓库级指令(如团队编码规范)、任务模板(如“生成单元测试”)统一Prompt行为。

- LangChain PromptTemplate:预定义Prompt模板,动态注入变量(如用户ID、当前时间),避免重复编写。

3. 自动化与协作平台

- Context Engineering模板:通过CLAUDE.md定义项目规则,examples/文件夹存放代码示例,实现Prompt的工程化管理。

- MCP协议:通过模型上下文协议(MCP)共享工具定义,让Prompt中的工具调用跨平台兼容(如Claude与GPT共享浏览器工具)。

六、应用案例:从代码生成到多智能体协作

1. 代码生成:结构化Prompt驱动高质量输出

以生成“带权限控制的用户API”为例,Prompt结构如下:

角色:资深后端工程师,熟悉Django REST Framework

任务:生成用户管理API(GET /users/{id})

约束:

- 权限:仅管理员可访问,返回403错误码

- 响应格式:{"id": int, "username": str, "roles": list[str]}

示例:

输入:GET /users/1(管理员token)

输出:{"id": 1, "username": "admin", "roles": ["admin"]}

通过明确角色、约束与示例,模型生成的代码直接符合项目规范,减少80%调试时间。

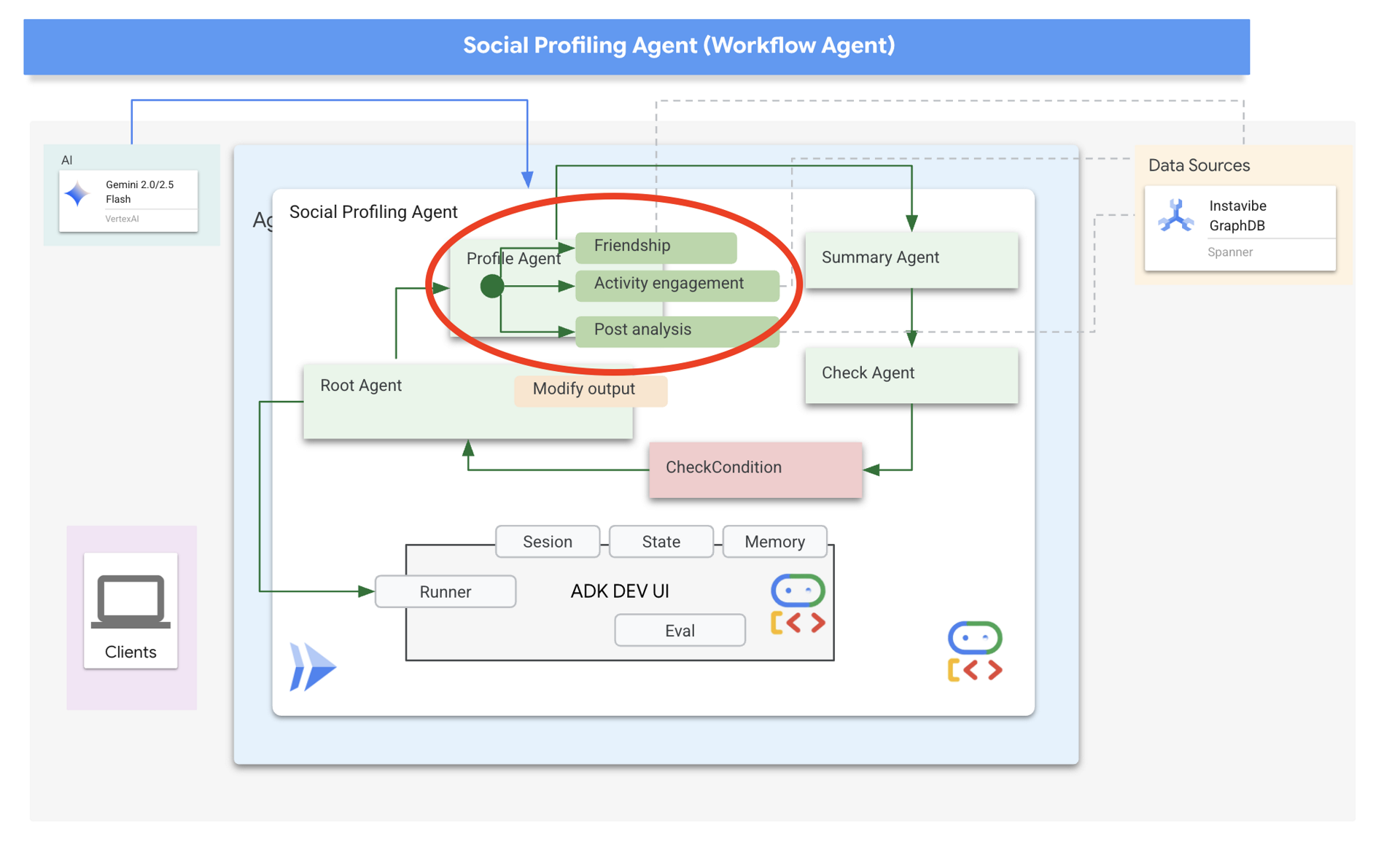

2. 多智能体协作:Prompt作为“团队操作手册”

微软ContraForce安全事件响应系统通过以下Prompt协调子智能体:

- 调度智能体:“接收事件→分配给影响评估智能体→结果同步至执行智能体”。

- 评估智能体:“分析日志关键词:‘login_failed’→风险等级:高→触发执行智能体:IP封禁”。

通过Prompt定义角色职责与协作流程,事件处理成本降低至<1美元/单事件。

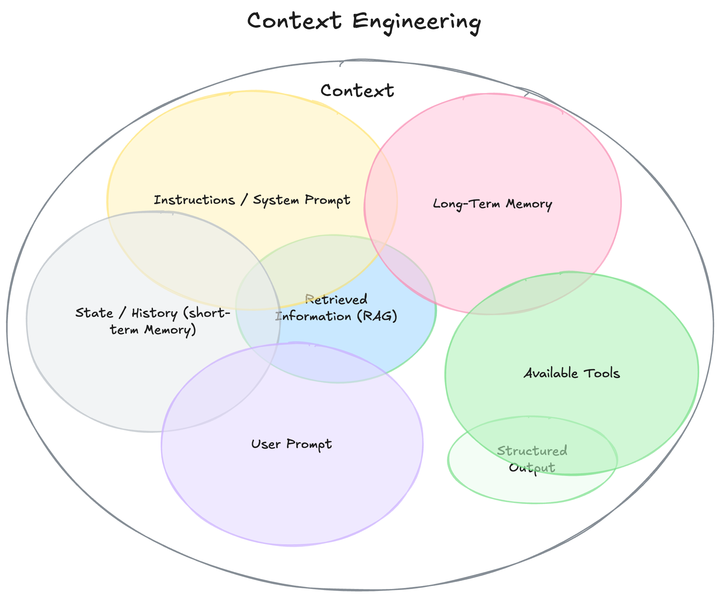

七、未来趋势:从Prompt工程到上下文工程

随着AI智能体的普及,Prompt工程正升级为上下文工程(Context Engineering)——不仅关注单轮指令,更需系统化管理“需求-工具-记忆-协作”全链路。例如:

- 记忆操作系统(MemOS):通过图结构存储用户偏好、历史交互,动态检索相关上下文注入Prompt。

- 自优化Prompt:AI通过分析输出反馈(如用户修改记录)自动调整Prompt,实现“使用即优化”。

正如OpenAI研究员Sean Grove所言:“AI时代的核心竞争力,从‘写代码’转向‘写规范’——而Prompt正是规范的最小单元。”掌握Prompt工程,本质是掌握人机协作的“语法”,这将成为知识工作者的核心技能。