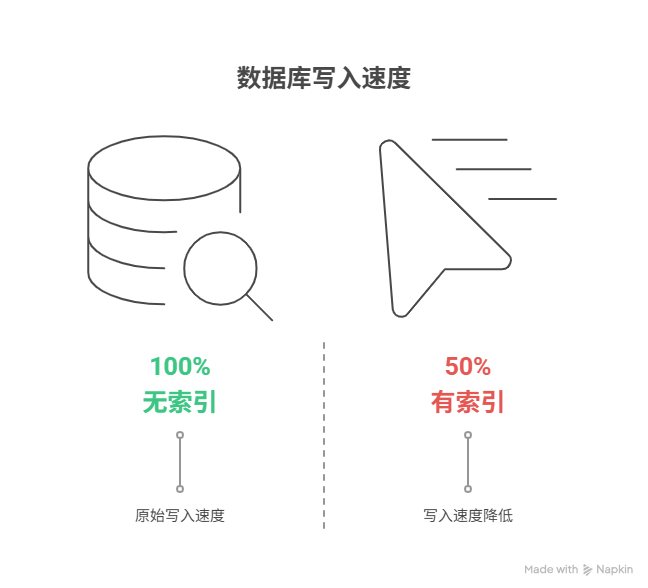

为什么给数据表加了索引,写入速度反而变慢了

为数据表增加索引后之所以会导致写入(包括插入、更新、删除)操作的速度变慢,其根本原因在于索引本质上是一个独立的、需要与主表数据保持实时同步的“数据结构”。这一机制的核心逻辑涵盖五个方面:因为索引本质上是一个“独立的数据结构”需要被“同步维护”、每次“插入”新数据时都必须向所有索引中“新增”条目、每次“删除”数据时也必须“移除”所有索引中的对应条目、当“更新”被索引的列时更涉及到“删除旧索引”与“添加新索引”的复杂操作、以及索引的数量与复杂度直接导致了“写操作”的成本增加。

具体来说,当一条新数据被插入主表时,数据库不仅要完成数据本身的写入,还必须承担一项额外的“维护”工作:数据库需要将新数据中被索引的列的值,分别地、按照预设的排序规则,插入到每一个相关的索引结构中去。这个“插入索引”的过程本身就是一个相对耗时的磁盘操作,并且表的索引越多,这份“额外负担”就越重,从而使得总体的写入性能呈现出明显的下降。

一、问题的“本质”、索引的“双面性”

在数据库性能优化的世界里,索引常被誉为提升查询速度的“银弹”。然而,这颗“银弹”却是一枚具有“双刃剑”效应的硬币,它在为“读”操作带来数量级性能提升的同时,也必然地会对“写”操作征收一笔不菲的“性能税”。

索引的核心价值在于加速“读”操作。一个没有索引的数据表在进行条件查询时,数据库只能进行“全表扫描”,即逐行检查每一条记录直到找到匹配的数据。这种方式在数据量小时尚可接受,但在一个拥有数千万行记录的大表中,一次全表扫描可能是秒级甚至分钟级的操作。一个设计良好的索引就如同书籍的“目录”,它允许数据库通过高效的查找算法快速“定位”到所需数据所在的物理位置,将查询的时间复杂度从“线性”级别降低到“对数”级别,从而实现查询速度的巨大飞跃。

这份极致的“读取”效率的代价,就是在每一次“写入”数据时都需要付出额外的“维护成本”。一个索引并非一个简单的“标记”,它是一个真实存在的、需要占用磁盘空间、并需要被严格维护的独立“数据结构”(最常见的是B+树结构)。“写”操作(包括插入、删除、更新)不仅仅是在修改“主数据表”,更是在同时修改“主数据表”和其身上所附带的“每一个索引”。索引越多,这张“税单”就越长,写入操作的总耗时也就越久。因此,是否要为一个表、一个列添加索引,以及添加什么样的索引,本质上是一场关于“读性能”与“写性能”之间的深刻“权衡取舍”。正如经济学家托马斯·索维尔所言:“世上没有解决方案,只有利弊权衡。”

二、“插入”操作的“写放大”效应

让我们首先来剖析最简单的“插入”操作是如何因为索引的存在而变得“昂贵”的。

在一个没有任何索引的“裸表”中,当一条新的记录需要被插入时,数据库所做的工作相对简单:它只需要在数据文件中找到一块足够大的、可用的空白空间,然后将这条新的行数据写入即可。

然而,当这张表拥有了一个或多个索引之后,一次看似简单的“插入”在其在数据库内部会触发一系列复杂得多的“连锁反应”。首先是写入主表数据,这个步骤与无索引时基本相同。其次是同步更新所有索引,这是性能开销的核心来源。对于这张表上所存在的每一个索引,数据库都必须执行一次“索引更新”操作。数据库需要从刚刚插入的那行新数据中提取出与该索引相关的“键值”,然后必须在这个索引的、独立的、通常是巨大的B+树结构中从根节点开始进行一次查找,以定位到这个新的“键值”应该被“插入”的、那个正确的、符合排序规则的“叶子节点”位置。最后数据库将这个新的“索引条目”(包含了键值和指向主表行的物理地址指针)插入到那个叶子节点中。如果这个插入操作导致了叶子节点“分裂”,那么其所引发的、对树状结构的“平衡性”调整将是更进一步的性能开销。

这个“写入数据 -> 查找索引位置 -> 插入索引条目”的过程,其成本会随着“索引数量”的增加而成倍地“叠加”。如果一张表上有5个索引,那么每一次的插入操作就意味着需要进行1次主表的数据写入和5次独立的、复杂的索引树写入。对于那些“写入”极其频繁的“流水日志”类数据表,过多的索引无疑是一场性能的灾难。

三、“删除”操作的“同步清理”

与“插入”操作的逻辑类似,“删除”操作同样需要为索引付出“同步维护”的代价。在一个没有索引的表中,删除一条记录的核心是找到那行数据并将其从数据文件中移除或标记为“已删除”。

而在一个有索引的表中,其过程则要复杂得多。第一步是定位并删除主表数据,如果删除的条件恰好能够利用到某个索引,那么“定位”这一步会非常快。第二步是同步删除所有索引中的条目。在删除了主表的行数据之后,数据库必须再次遍历这张表上的所有索引,并在每一个索引的B+树结构中都找到并删除那个指向刚刚被删除的、那一行数据的“索引条目”。

如果不进行这个“同步清理”的操作,那么这些索引中就会残留下来大量指向“空地址”的“僵尸”索引条目。这不仅会浪费磁盘空间,更会在未来的查询中引入不必要的计算和错误。

四、“更新”操作的“双重打击”

“更新”操作对于索引维护而言,是最复杂、也最能体现其“代价”的场景。我们需要将其分为两种截然不同的情况来讨论。

第一种情况是更新“非索引”列。例如 UPDATE users SET age = 31 WHERE id = 123;,假设age这个列上没有建立索引。在这种情况下,数据库只需要定位到id=123的行并直接地在“原地”修改age字段的值即可。因为所有被索引的列(例如可能存在的name或create_time列)其值并没有发生任何变化,所以所有的索引结构都无需进行任何的修改。这次操作的成本相对较低。

第二种情况是更新“索引”列,这是性能杀手。例如 UPDATE users SET name = '张三' WHERE id = 123;,假设name这个列上存在一个索引。在数据库的索引维护机制中,一次对“索引列”的“更新”操作,其本质几乎等同于一次“删除旧索引条目”加上一次“插入新索引条目”的、“双倍”成本的操作。数据库首先需要定位到id=123的行,然后更新主表中的name字段。此时数据库必须去name列的索引树中进行一次复杂的维护:它需要根据“旧”的值找到并删除那个原始的索引条目,然后它需要根据“新”的值“张三”在索引树中重新寻找一个新的、符合排序规则的位置并插入一个新的索引条目。一个简单的、只修改了一行数据的“更新”指令在底层可能会触发对多个、独立的、分布在磁盘不同位置的“索引”文件进行多次的、复杂的“读-删-写”操作,这种现象被称为“写放大”。

五、平衡的“艺术”、**索引设计**策略

既然索引是一把“双刃剑”,那么在实践中我们该如何进行“权衡”和“优化”,以求在“读性能”和“写性能”之间找到一个最佳的“平衡点”呢?

首先需要深刻理解业务的“读写比”,这是进行所有**索引设计**决策的第一个也是最重要的问题:“对于这张表,其日常的主要负载是‘读’操作还是‘写’操作?” 对于“读多写少”的场景,例如“商品信息”表或用于“数据分析”的报表系统,我们可以也应该为其建立相对完善的、多维度的索引来最大化地提升其核心价值——“快速查询”。而对于“写多读少”的场景,例如用于记录“用户行为”的“日志”表,其索引的创建必须保持极致的“克制”,每一个新增的索引都可能成为其“写入”性能的“瓶颈”。

其次,索引应该是“精准”的,而非“盲目”的。索引应该只为那些在WHERE, JOIN, ORDER BY子句中被频繁使用的列而建立。为一个几乎从未被用于“查询条件”的列建立索引是毫无意义的纯粹的“负资产”。如果一个查询常常需要同时对多个列进行过滤,那么创建一个包含了这多个列的“联合索引”其效率远高于为每一个列都单独地创建一个“独立索引”。如果一个查询所需要返回的所有字段恰好都已经包含在了某个索引之中,那么数据库就无需再去“回”到主表中去读取数据。这种只查询“索引”就能满足所有需求的查询被称为“覆盖索引”,其性能极高。

最后,随着数据的不断“增删改”,索引的内部结构可能会产生“碎片”导致其查询效率下降。数据库管理员需要定期地对索引进行“重建”或“重组”来保持其最佳的性能状态。

常见问答 (FAQ)

Q1: “索引”是不是越多越好?

A1: 绝对不是。索引是“双刃剑”。每一个新增的索引在提升特定“查询”性能的同时,都在增加所有“写入”(插入、更新、删除)操作的“成本”,并占用额外的“磁盘空间”。必须在“读性能”和“写性能”之间做出审慎的“权-衡”。

Q2: 为什么更新一个“没有被索引”的列,速度也可能会变慢?

A2: 这通常与数据库的底层存储机制有关。例如,如果你更新的是一个“变长”字段(如一个长文本),并且更新后的值比原始值长得多,导致当前的数据页无法再容纳下它,此时数据库就可能需要进行一次“行迁移”或“页分裂”的昂贵操作。

Q3: “主键”和“索引”是什么关系?

A3: “主键”是一种约束,它保证了表中每一行数据的“唯一性”。而在绝大多数数据库的实现中,当你为一个表定义一个“主键”时,数据库会自动地为这个主键列创建一个唯一的、通常是“聚集”的“索引”,以确保能够快速地通过主键来定位到唯一的一行数据。

Q4: 我应该如何找到我的数据库中,哪些是“低效”或“未使用”的索引?

A4: 主流的数据库管理系统(如MySQL, PostgreSQL)都提供了系统视图或命令来查询和分析“索引的使用情况统计”。通过查询这些统计信息,你可以清晰地看到哪些索引自上次服务器启动以来从未被任何查询所使用过。这些“零使用”的索引就是最主要的、需要被“清理”的候选对象。