AI工作负载“加速跑”,高性能网络如何“护航”?

在数字化浪潮下,人工智能(AI)正以前所未有的速度重塑我们的生产和生活方式。AI技术的迅猛发展在带来巨大机遇的同时,也对数据安全、网络基础设施等带来全新挑战。随着AI大模型在多领域的广泛应用,网络性能已成为制约AI发展的关键瓶颈——无论是模型训练的海量数据传输,还是推理阶段的实时响应,均对网络的高带宽、低时延、高稳定性提出了严苛需求。传统网络架构已难以满足这些严苛要求,构建高性能网络以保障AI工作负载势在必行。

AI工作负载的两大阶段:训练与推理

在AI训练阶段,AI模型需通过海量经验数据展开学习并优化自身参数,让模型掌握对特定任务高效预测、分类或内容生成,提升准确性。而在推理阶段,AI模型需将训练应用于实践,经过训练的AI模型接收到全新数据后,展开分类或预测,从而输出决策或得出结论。

AI模型的训练和推理规模大、时间周期长。AI训练过程中,仅单次计算迭代内梯度同步需要的通信量就达到百GB量级,远超单台服务器算力极限,必须依赖庞大的算力支撑。而进入推理阶段时,AI更需要与用户进行交互,实时响应并回答,网络的低时延显得尤为关键。为此,构建由大量服务器节点组成的分布式计算集群,并通过高带宽、高性能网络架构实现节点间的互联,才能确保传输速度和协同工作。

AI工作负载对网络的六大核心要求

高带宽

AI模型进行训练和推理过程中,单链路带宽需求普遍超过100Gbps,而集群间总带宽更需要达到Tbps级别。因此,只有高带宽的网络链路才能保障网络性能,确保算力集群的高效协同。

低时延与稳定性

低时延与稳定性对于AI工作负载至关重要。无论是AI聊天机器人、语音助手,还是SaaS平台的AI嵌入,响应延迟都会直接影响用户使用AI的交互体验。特别是高频交易系统、云虚拟机迁移及大规模分布式系统之间的数据同步等时间高敏感的AI应用场景,对网络时延的要求更高,公共互联网已难以满足此严苛的时延要求。

大规模组网能力

AI大模型训练需要构建大规模的分布式计算,以高效的大规模组网技术,支持大容量、高密度的网络设备部署,确保大量服务器节点间的参数同步效率。

安全保障

为确保合规性、保护敏感数据,及避免不可预测的安全状况,AI工作负载的网络架构需提升安全性能,并加强访问控制与身份认证。

自动化部署

AI模型训练和推理时,集群规模庞大且配置复杂,时常会遇到需要多台设备并行部署的情况。采用自动化部署配置方案不仅能显著提升AI大模型集群系统的运行可靠性,还能有效优化资源利用效率。

多云互联能力

混合云架构已成为AI工作负载的主流部署模式。不少企业会采用公有云训练、私有云推理等混合部署策略。因此需要提升AI工作负载时跨云平台之间的高速稳定连接能力。

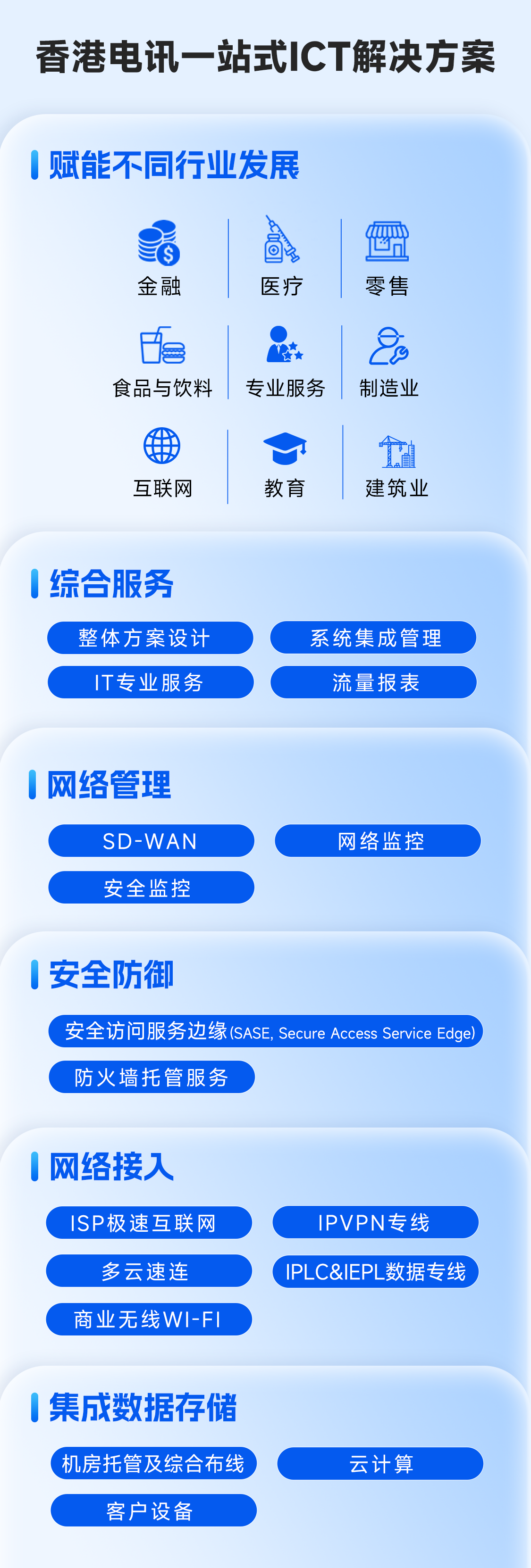

香港电讯高性能网络“护航”企业AI工作负载

面对AI工作负载对网络提出的严苛要求,无论是训练模型还是将其部署到生产环境中,又或是是使用云厂商提供的AI智能工具,香港电讯都能凭借领先的网络基础设施和多元的数字解决方案,为企业构建坚实且高性能的网络基石。

依托覆盖全球的网络资源,香港电讯为企业客户提供丰富的带宽选择、路由优化传输、稳定冗余的网络设计、自动化部署能力、集成多种安全防护以及高效连接国内外多云平台的能力,助力企业AI工作负载“加速跑”,抢占AI时代先机。