UNet改进(33):基于CBAM原理与PyTorch实战指南

1. 注意力机制在图像分割中的重要性

注意力机制源于人类视觉系统的工作方式——我们不会平等地处理视野中的所有信息,而是有选择地关注重要区域。在深度学习模型中引入注意力机制,可以使网络学会"关注"输入数据中最相关的部分,从而提高模型性能。

在图像分割任务中,注意力机制尤其重要,因为:

-

不同通道的特征图包含的信息重要性不同

-

图像空间区域的重要性存在差异

-

背景信息往往占据大部分区域但贡献较小

CBAM(Convolutional Block Attention Module)是一种轻量级的通用注意力模块,可以无缝集成到任何CNN架构中。它依次应用通道注意力和空间注意力,帮助模型关注"什么"和"哪里"是重要的。

2. CBAM模块的详细解析

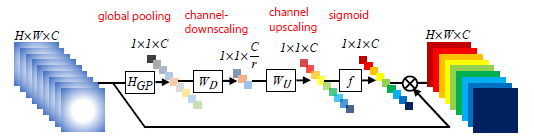

2.1 通道注意力模块

通道注意力关注"什么"特征是重要的。在我们的实现中,ChannelAttention类实现了这一功能:

class ChannelAttention(nn.Module):def __init__(self, in_channels, reduction_ratio=16):super(Channel