实时交互世界模型新标杆! Skywork AI 发布 Matrix-Game 2.0: 攻克实时交互难题,在实时性与视频生成质量上实现跨越式突破!

在科技飞速发展的当下,交互式世界模型研究备受瞩目,但推理速度慢、无法实时交互等问题,成为其迈向实际应用的关键阻碍。近日,Skywork AI 研究团队发布了 Matrix-Game 2.0,这是一个开源、实时、流式的交互式世界模型。它不仅能以 25 FPS 速度,在用户实时操作下生成高质量、高分辨率且长达数分钟的视频,还为交互式世界建模研究提供了新方向,推动该技术向真正可用的实时虚拟环境仿真大步迈进。

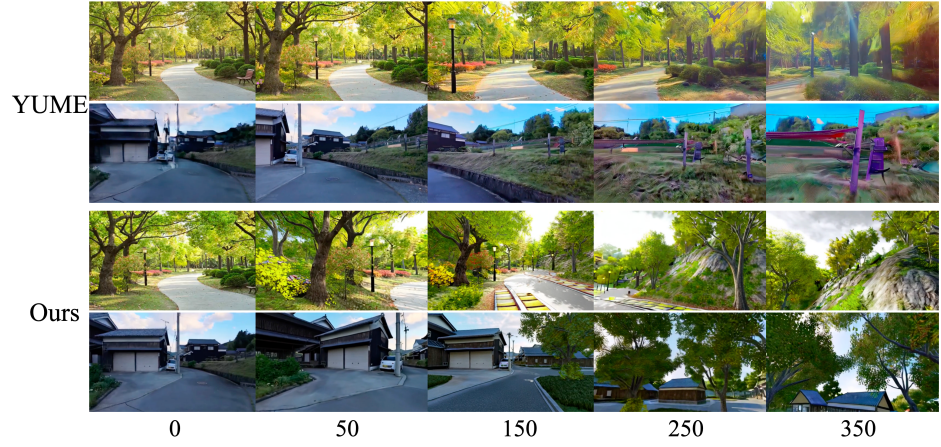

跨多种场景风格的生成

Matrix-Game 2.0 展示了跨多种场景风格的强大生成能力,具有不同的视觉美感和地形。

跨 GTA 场景的世代

Matrix-Game 2.0 展示了在 GTA 场景中生成精确控制视频的能力,同时也展示了建模场景动态的能力。

长视频生成

Matrix-Game 2.0 展示了强大的自回归生成能力,可用于制作长视频。

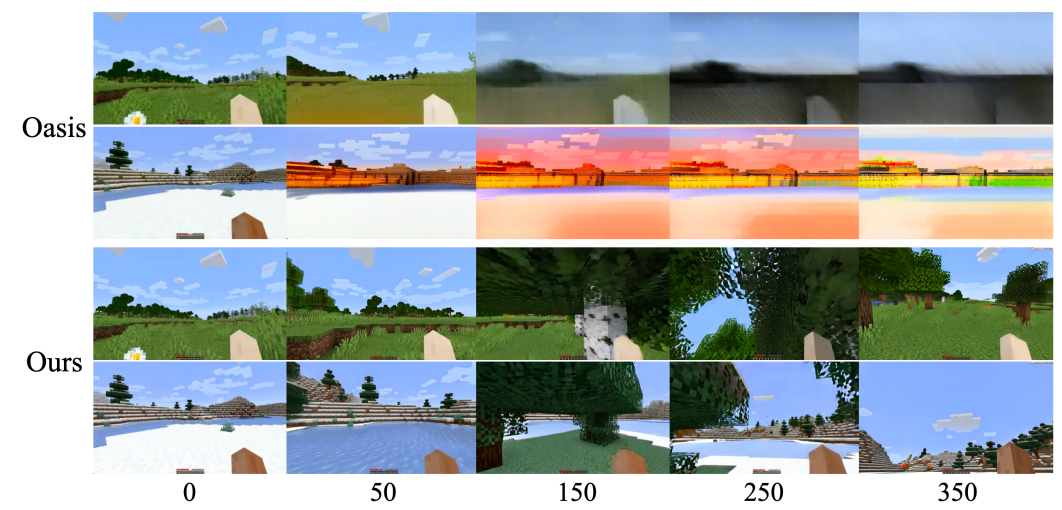

跨 MC 场景的生成

Matrix-Game 2.0 在 Minecraft 场景中展现出强大的生成能力,能够适应多样化的视觉风格和地形。

TempleRun 场景的生成

Matrix-Game 2.0 还可以应用于生成 TempleRun 场景中的交互式视频。

相关链接

论文:https://arxiv.org/abs/2508.13009

主页:https://matrix-game-v2.github.io

代码:https://github.com/skyworkai/matrix-game

试用:https://huggingface.co/Skywork/Matrix-Game-2.0

论文阅读

交互式视频生成领域的最新进展展现了扩散模型作为世界模型的潜力,它能够捕捉复杂的物理动态和交互行为。然而,现有的交互式世界模型依赖于双向注意力机制和冗长的推理步骤,严重限制了实时性能。因此,它们难以模拟现实世界的动态,因为现实世界的结果必须根据历史背景和当前行为即时更新。为了解决这个问题,论文提出了 Matrix-Game 2.0,这是一个交互式世界模型,它通过几步自回归扩散算法实时生成长视频。框架由三个关键组件组成:

一个适用于虚幻引擎和 GTA5 环境的可扩展数据生产流水线,可有效生成海量(约 1200 小时)包含丰富交互注释的视频数据;

一个动作注入模块,支持帧级鼠标和键盘输入作为交互条件;

基于随意架构的几步提炼,用于实时和流式视频生成。

Matrix Game 2.0 能够以 25 FPS 的超快速度跨不同场景生成高质量的分钟级视频。我们开源我们的模型权重和代码库,以推进交互式世界建模的研究。

模型概述

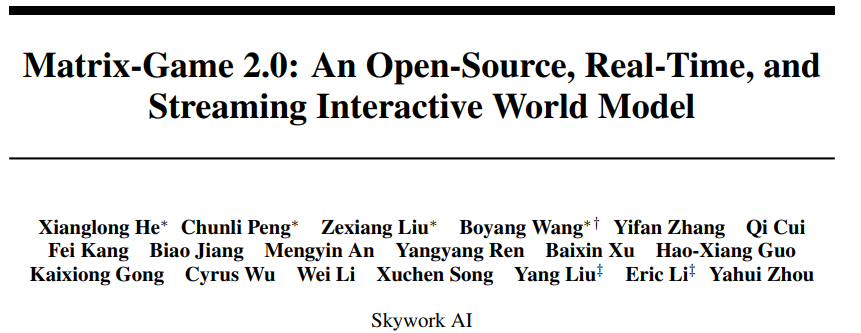

基础模型源自 WanX,通过移除文本分支并添加动作模块,该模型仅根据视觉内容和对应的动作来预测下一帧。

Matrix-Game 2.0 架构概述。 基础模型源自 Wan 的 I2V 设计。通过移除文本分支并添加类似 Matrix-Game 的动作模块,该模型仅根据视觉内容和相应的动作来预测下一帧。

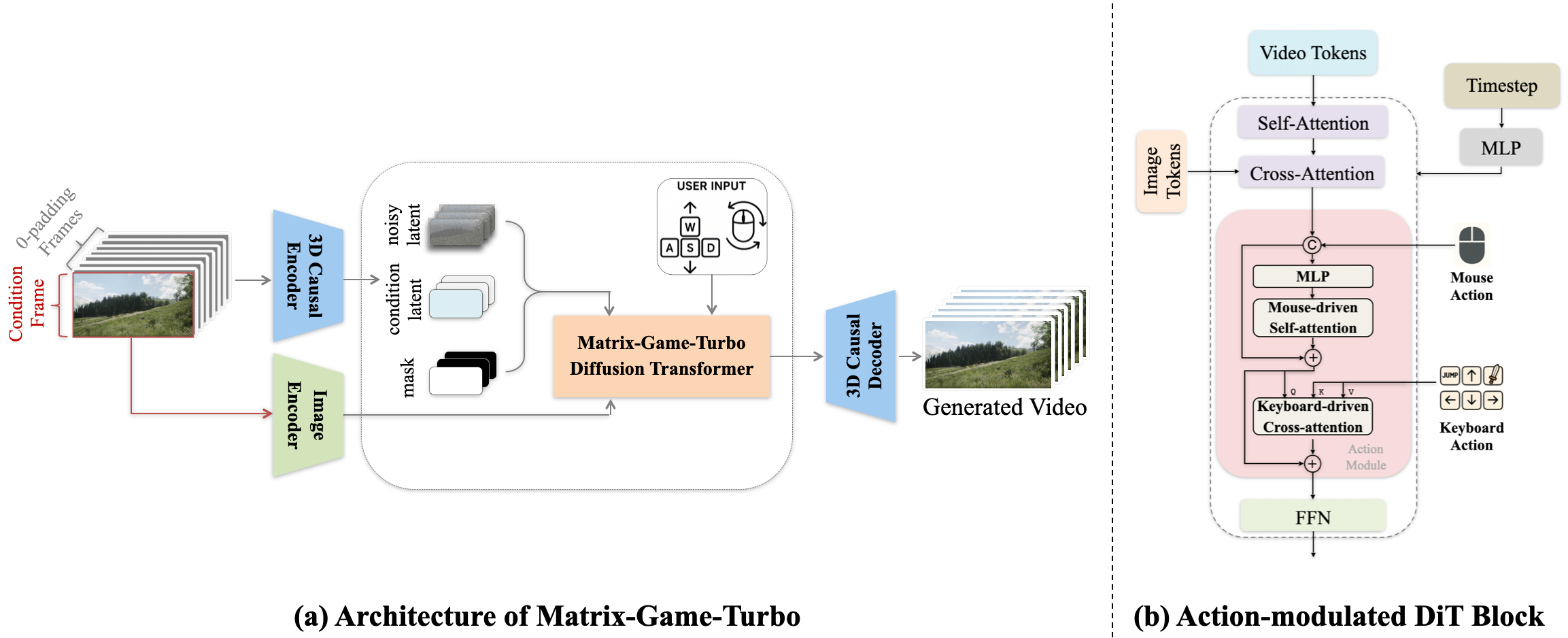

通过微分方程轨迹初始化因果学生模型。提出的初始化方法通过最优微分方程轨迹采样,从双向教师模型中导出一个几步因果学生模型,从而稳定后续的蒸馏训练。

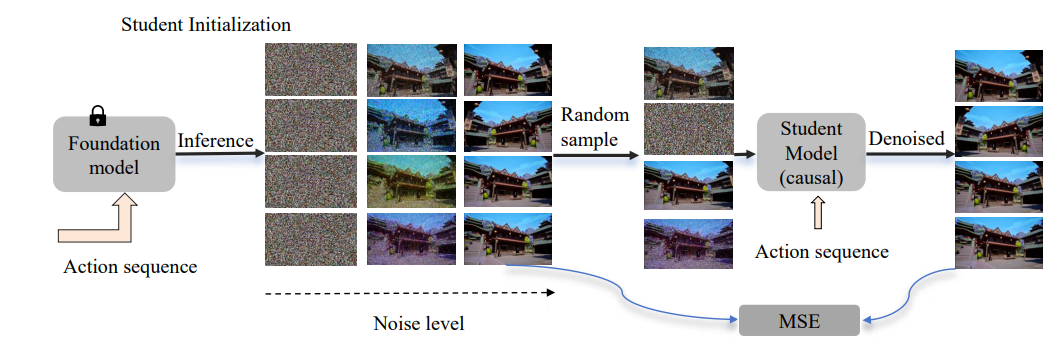

通过自强制进行因果扩散模型训练的概述。蒸馏过程 通过自调节生成,将学生模型的分布与教师模型的分布对齐。 这种方法有效地减少了误差累积,同时保持了生成质量。

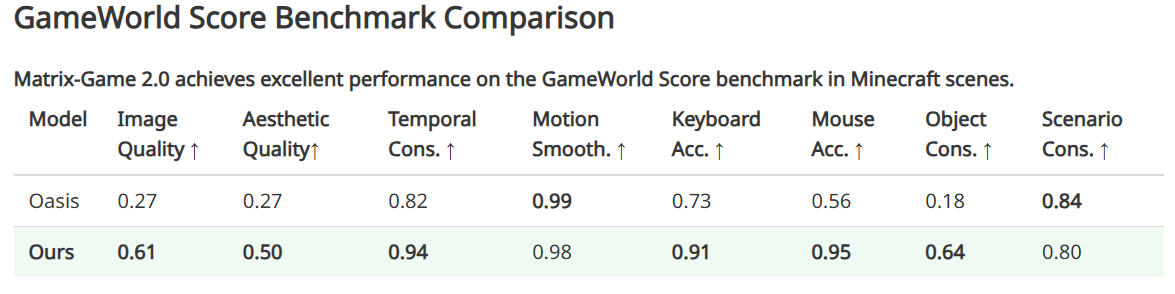

实验结果

Minecraft 场景生成的定性比较。与 Oasis 相比,该模型在长交互视频生成中展现出卓越的视觉性能。

野外场景生成的定性比较。对于野外图像输入,MatrixGame 2.0 展现出强大的泛化能力、快速的生成速度和准确的交互响应。

结论

Matrix-Game 2.0 通过精心构建的数据流水线和高效的训练框架,在实时交互式视频生成领域取得了显著进步。首先,开发了一套全面的数据生成流水线,克服了以往在获取交互式场景高质量训练数据方面的局限性。

其次引入了一个自回归扩散框架,该框架将动作条件调制与基于自强迫的蒸馏相结合。这种方法有效地缓解了传统上困扰长视频合成的误差累积问题,同时保持了实时性能。通过对扩散过程和 VAE 架构进行系统性优化,我们实现了 25 FPS 的生成速度,实现了无缝的人机交互。