操作系统:资源竞争或者同步问题;锁、信号量等机制

以下通过 CUDA 和 OpenCL 的实例,详细解释操作系统如何管理 GPU 资源竞争与同步问题,涵盖锁、信号量等核心机制:

一、GPU 资源竞争三大场景

1. 设备级竞争(多进程争用 GPU)

sequenceDiagram进程A ->> GPU驱动: cuCtxCreate()进程B ->> GPU驱动: clCreateContext()GPU驱动 ->> 操作系统: 请求设备访问操作系统->> GPU驱动: 返回虚拟GPU句柄(vGPU)进程A ->> vGPU: 提交内核Kernel1进程B ->> vGPU: 提交内核Kernel2vGPU ->> 操作系统: 触发时间片调度操作系统->> GPU硬件: 交替执行Kernel1/Kernel22. 内存级竞争(多线程访问显存)

// CUDA 多线程写冲突示例

__global__ void race_condition(int* data) {int idx = threadIdx.x + blockIdx.x * blockDim.x;data[0] += idx; // 数百线程同时写同一地址!

}3. 计算资源竞争(SM 占用冲突)

// OpenCL 多个内核抢占计算单元

clEnqueueNDRangeKernel(queue, kernel1, ...); // 占用80%SM

clEnqueueNDRangeKernel(queue, kernel2, ...); // 剩余SM不足二、操作系统级同步原语

1. 信号量 (Semaphore) - 控制资源访问量

// Linux DRM 信号量实现 (drivers/gpu/drm/drm_syncobj.c)

struct drm_syncobj {atomic_t count; // 可用资源计数wait_queue_head_t wait; // 等待队列

};// 进程等待信号量

void drm_syncobj_wait(struct drm_syncobj *obj) {if (atomic_dec_return(&obj->count) < 0)wait_event(obj->wait, atomic_read(&obj->count) > 0);

}// 释放信号量

void drm_syncobj_signal(struct drm_syncobj *obj) {atomic_inc(&obj->count);wake_up(&obj->wait);

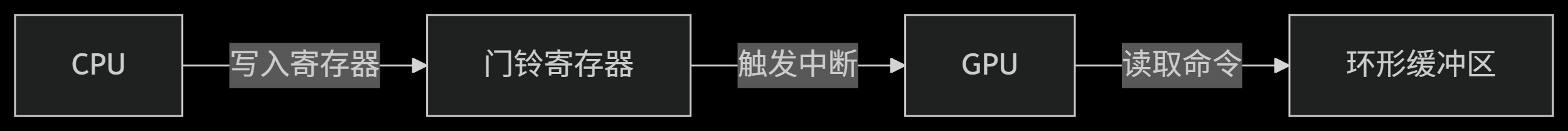

}2. 硬件门铃 (Doorbell) - 通知机制

三、CUDA 同步机制实战

1. 设备级锁 - 进程互斥

// 创建跨进程Mutex

cudaIpcMemHandle_t handle;

cudaMalloc(&mutex, sizeof(int));

cudaIpcGetMemHandle(&handle, mutex);// 进程A: 加锁

__global__ void lock(int* mutex) {while(atomicCAS(mutex, 0, 1) != 0); // CAS原子操作

}

// 进程B: 解锁

__global__ void unlock(int* mutex) {atomicExch(mutex, 0);

}2. 流同步 - 任务依赖

cudaStream_t stream1, stream2;

cudaStreamCreate(&stream1);

cudaStreamCreate(&stream2);// 内核1在stream1执行

kernelA<<<..., stream1>>>();// 创建事件作为屏障

cudaEvent_t event;

cudaEventCreate(&event);

cudaEventRecord(event, stream1);// 内核2等待事件

cudaStreamWaitEvent(stream2, event, 0);

kernelB<<<..., stream2>>>();3. 原子锁 - 显存访问控制

__global__ void safe_increment(int* data, int* lock) {// 获取锁bool acquired = false;while(!acquired) {int old = atomicCAS(lock, 0, 1); // 原子比较交换acquired = (old == 0);}// 临界区操作*data += 1;// 释放锁atomicExch(lock, 0);

}四、OpenCL 同步机制实战

1. 命令队列屏障

cl_command_queue queue = clCreateCommandQueue(...);clEnqueueNDRangeKernel(queue, kernel1, ...);

clEnqueueBarrierWithWaitList(queue); // 显式屏障

clEnqueueNDRangeKernel(queue, kernel2, ...); // kernel2等待kernel12. 内存栅栏 - 保证内存可见性

__kernel void memory_fence(__global int* data) {data[get_global_id(0)] = 1;// 全局内存栅栏mem_fence(CLK_GLOBAL_MEM_FENCE);// 此处所有线程看到更新后的dataint value = data[get_global_id(0) + 1];

}3. 管道 (Pipe) - 生产者消费者模型

// 定义管道

__pipe int my_pipe;__kernel void producer() {int data = ...;write_pipe(my_pipe, &data); // 阻塞写入

}__kernel void consumer() {int data;read_pipe(my_pipe, &data); // 阻塞读取

}五、操作系统调度策略对比

| 同步场景 | CUDA解决方案 | OpenCL解决方案 | 操作系统支持机制 |

|---|---|---|---|

| 进程间互斥 | cudaIpcMemHandle_t | POSIX信号量 | DRM GEM对象隔离 |

| 内核依赖 | cudaStreamWaitEvent() | clEnqueueBarrier() | 硬件命令队列调度 |

| 显存原子访问 | atomicCAS() | atomic_cmpxchg() | GPU缓存一致性协议 |

| 设备抢占 | MPS(Multi-Process Serv.) | CL_QUEUE_PRIORITY_KHR | WDDM时间片调度 |

| 数据传输同步 | cudaStreamSynchronize() | clFinish() | IOMMU映射管理 |

六、底层硬件同步原语

1. NVIDIA GPU 原子指令

// PTX 汇编实现原子锁

.reg .pred acquired;

.reg .b32 old_val;

loop:atom.cas.b32 old_val, [mutex], 0, 1; // CAS操作setp.eq.b32 acquired, old_val, 0;

@!acquired bra loop; // 未获取成功则重试2. AMD GPU 信号量

s_waitcnt lgkmcnt(0) // 等待内存操作完成

s_barrier // 波前内屏障

s_sendmsg sendmsg(MSG_SYS_SIGNAL_SEM) // 发送信号量信号3. Intel GPU 栅栏

fence.ivb // 内存栅栏

sync.all // 线程组同步七、资源竞争调试技巧

1. 死锁检测

# NVIDIA Nsight Systems

nsys profile --trace=cuda,nvtx ./app# 输出显示

[GPU] Stream 7: Waiting for Event 0x3 (75% utilization)

[WARNING] Event 0x3 never signaled!2. 竞争条件捕捉

// 使用Compute Sanitizer检测竞争

__global__ void data_race(int* data) {// 有风险的写操作data[threadIdx.x % 2] += 1;

}// 运行检测

compute-sanitizer --tool racecheck ./app3. 性能分析

# AMD ROCProf

rocprof --stats ./opencl_app# 输出关键指标

MemoryBusy : 85% # 显存带宽争用

VALUBusy : 45% # 计算单元利用率八、最佳实践总结

层级化同步

graph TDA[进程级] -->|cudaIpcMemHandle_t| B[设备级]B -->|cudaStream_t| C[线程块级]C -->|__syncthreads()| D[线程级]避免细粒度锁

- 用原子操作替代锁(如

atomicAdd) - 使用线程束同步(

__syncwarp())替代块同步

- 用原子操作替代锁(如

零拷贝优化

// CUDA 统一内存 cudaMallocManaged(&data, size); // OpenCL SVM clSVMAlloc(context, CL_MEM_READ_WRITE, size, 0);优先级控制

// 高优先级流 cudaStreamCreateWithPriority(&stream, cudaStreamDefault, -1);

通过操作系统的 DRM/WDDM 子系统,结合 CUDA/OpenCL 的同步原语,现代 GPU 实现了:

- 毫秒级进程切换(上下文保存/恢复)

- 微秒级线程同步(硬件原子操作)

- 零开销数据传输(UMA/SVM)

- 公平性资源分配(时间片轮转+优先级)

理解这些机制,能帮助开发者设计出避免死锁、提升吞吐的 GPU 应用。