数据处理到底能做什么?数据处理核心原理与流程拆解

目录

一、数据处理的定义与特点

1. 数据处理的定义

2. 数据处理的特点

二、数据处理的作用

1. 支持企业决策

2. 提高企业运营效率

3. 创新业务模式

4. 提升产品质量

5. 促进科学研究

三、数据处理的基本原理

1. 数据采集原理

2. 数据存储原理

3. 数据加工原理

4. 数据分析原理

5. 数据输出原理

Q&A常见问答

总结

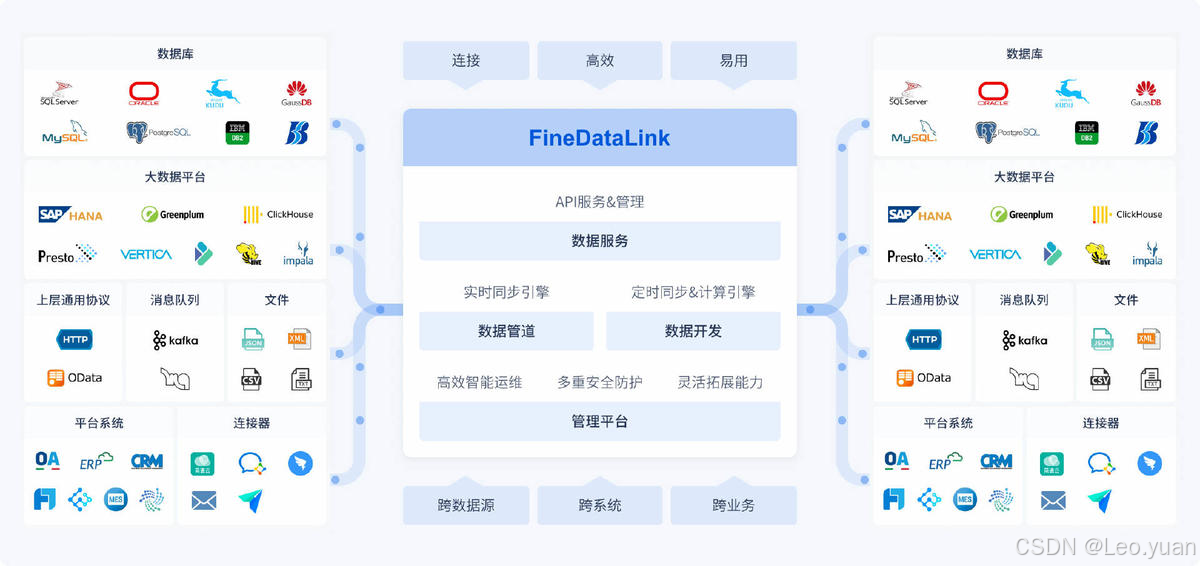

现在不管是企业日常运营,还是个人生活,都离不开数据。但这些刚产生的原始数据,大多是零散、杂乱的,就像堆在地上的原材料,不经过数据处理环节的话根本用不上。FineDataLink在数据处理这件事上做得很扎实,能帮企业把这些“原材料”变成能用的“成品”,更好地挖数据里的价值。接下来,我就跟大家好好聊聊数据处理的那些事,保证说的都是实在话,没什么虚的。

这份《数据仓库建设解决方案》里面包括调研、需求梳理、建设规范、建模全流程,从数据标准的规范到报表体系的建设都提供明确的建设思路,高效解决常见的口径不一致、报表查询慢等问题。需要自取:数据仓库建设解决方案 - 帆软数字化资料中心

一、数据处理的定义与特点

1. 数据处理的定义

简单来说,数据处理就是对数据做采集、存储、加工、分析,最后输出有用信息的一整套操作。说白了,就是把没用的“原始数据”变成能帮上忙的“有用信息”,核心目的就是从一堆看起来没规律的数据里,挖出有价值的东西,给做决策当参考。不是说随便把数据过一遍就行,每一步都得围绕“出有用信息”来做。你懂我意思吗?

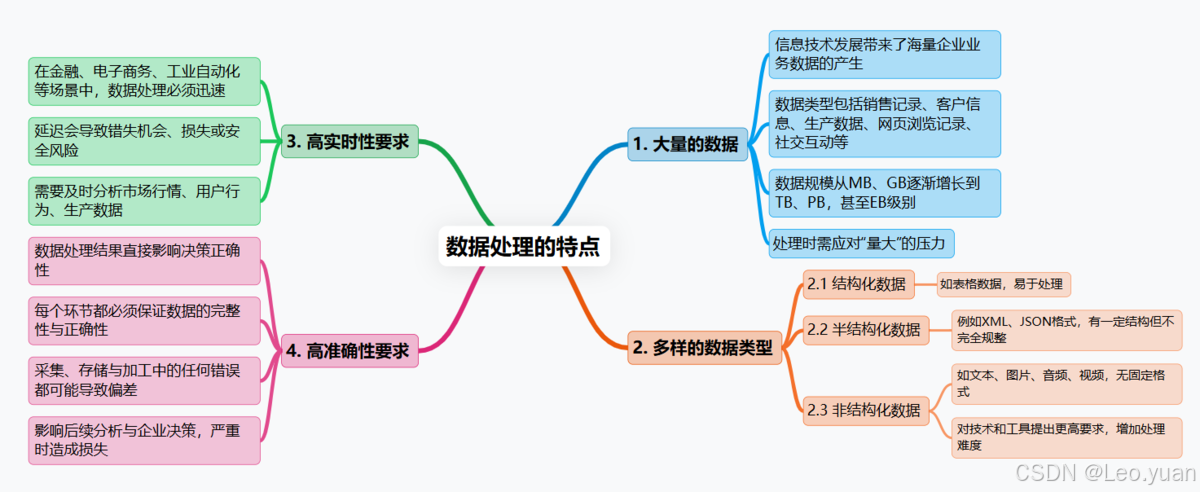

2. 数据处理的特点

- 数据量大:随着信息技术发展,企业每天产生的业务数据越来越多,比如销售记录、客户信息、生产过程中产生的数据,互联网公司更是要面对海量用户数据,像用户的网页浏览记录、社交媒体上的互动信息等等。这些数据的规模早就不是以前的MB、GB级别了,现在动不动就是TB、PB,甚至还有EB级别的,处理的时候首先就得扛住“量大”这个压力。

- 数据类型多样:以前处理的数据大多是规整的表格数据,也就是常说的结构化数据,好处理。但现在不一样了,除了结构化数据,还有半结构化数据,比如XML、JSON格式的数据,这些数据不算完全规整,但也有一定结构;更麻烦的是非结构化数据,像文本、图片、音频、视频这些,没有固定格式,处理方式和结构化数据完全不一样,这对数据处理的技术和工具都提出了更高要求,确实是个不小的挑战。

- 实时性要求高:很多场景下,数据处理慢了根本不行。比如金融交易的时候,得马上处理市场行情数据,才能及时做买卖决策,慢一秒可能就错过机会或者造成损失;电商做实时推荐,也得立刻分析用户当下的浏览、点击行为,才能推用户可能感兴趣的商品;工业自动化控制更不用说,数据处理延迟一点,都可能影响生产安全。所以实时性这块,要求真的不低。

- 准确性要求高:我一直强调,数据处理的结果准不准,直接关系到决策对不对。不管是采集数据的时候,还是存储、加工数据的时候,每一步都得保证数据是对的、是完整的。要是采集的时候漏了关键数据,或者存的时候出了错,再或者加工的时候把数据改歪了,后面的分析结果肯定会偏,基于这个结果做的决策也会受影响,严重的还会给企业带来损失。所以准确性这块,绝对不能马虎。

二、数据处理的作用

1. 支持企业决策

企业不管是定长远战略、规划日常业务,还是做市场分析,都不能靠感觉拍板,得有数据撑着。要是没数据,只凭经验判断,风险太大了。所以得把市场数据、客户数据、销售数据这些跟业务相关的数据,都好好处理分析一遍,才能知道当前的市场趋势是啥、客户真正的需求在哪里、竞争对手最近在做什么动作。有了这些信息,定出来的决策才科学、才合理,才能避免走弯路。

听着是不是很熟?现在很多企业都在做这件事,而FineDataLink能帮企业把这些数据高效采集处理好,不用在数据采集上花太多冤枉时间,给决策提供更准、更及时的信息>>>免费激活FDL

2. 提高企业运营效率

数据处理还能帮企业盯着运营过程中的数据,及时发现运营里的问题和瓶颈。比如:

- 生产环节,通过处理分析设备运行数据,能提前知道设备有没有可能出故障,早点做预防性维护,不用等设备真坏了才停线修理,这样停机时间少了,生产效率自然就提上去了。

- 物流方面,分析物流数据能找到更优的配送路线,不用绕远路,既能节省时间,又能降低物流成本。

- 客户服务上,把客户反馈的数据整理分析一下,就能知道服务哪里做得不好、客户有哪些不满,及时改进,客户满意度也会跟着提升。

说白了,数据处理就是帮企业把运营流程理顺,去掉那些没用的环节,让整个运营效率提上去。

3. 创新业务模式

数据里其实藏着很多没被发现的价值,数据处理就能把这些价值挖出来,给企业创新业务模式提供思路。不用一直困在原来的业务里,靠数据就能找到新的增长点。比如有些互联网企业,通过分析用户的社交数据和日常行为数据,摸清用户的偏好,然后推出针对性的服务,提升用户的参与度和忠诚度,这就是靠数据创新了服务模式。传统企业也一样,能靠数据处理跟其他行业合作,搞跨界,比如把自己的业务数据和其他行业的数据结合起来,找到新的商业机会,开发新的业务方向。

4. 提升产品质量

产品生产过程中会产生很多数据,比如每个生产环节的测试数据、设备参数数据等等,把这些数据处理分析好,就能及时发现产品的质量问题,找到问题出在哪,然后针对性改进。比如生产过程中,通过分析测试数据,能知道产品有没有潜在的缺陷、会不会在使用中出故障,这样就能及时调整生产工艺,让产品质量更稳定。另外,客户对产品的反馈数据也很重要,不管是好评还是差评,都能通过数据处理整理出来,分析这些数据能知道客户对产品满不满意、还有哪些需求没被满足,这样就能优化产品设计和功能,让产品更符合市场需求,质量也能跟着提升。

5. 促进科学研究

在科学研究领域,数据处理真的太重要了,几乎是不可或缺的工具。科学家做实验、做观测的时候,会得到大量的原始数据,这些数据如果不处理分析,就是一堆没用的数字或记录,根本没法发现自然规律、验证科学假设。比如研究天体,天文学家会通过望远镜获得大量的天体观测数据,这些数据不经过处理,根本没法了解星系是怎么演化的、宇宙的结构是什么样的;研究生物学,科学家会获取基因数据,不分析这些数据,也没法知道基因的功能、疾病是怎么发生的。可以说,没有数据处理,很多科学研究根本没法推进,更别说取得突破了。

三、数据处理的基本原理

1. 数据采集原理

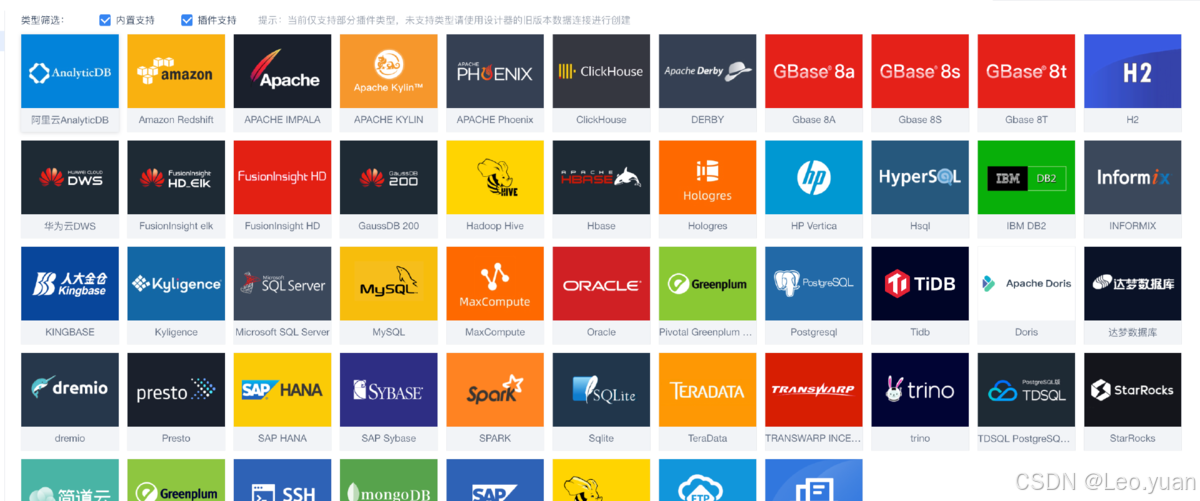

数据采集是数据处理的第一步,原理其实很简单,就是从各种数据源里把需要的数据拿出来。这些数据源主要分两种,一种是企业自己的内部数据源,比如日常用的业务系统、存储数据的数据库、设备产生的日志文件这些,都是企业自己能直接获取的数据;另一种是外部数据源,像社交媒体平台上的公开数据、行业网站发布的行业数据、政府部门公开的统计数据等等,这些需要从外部获取。

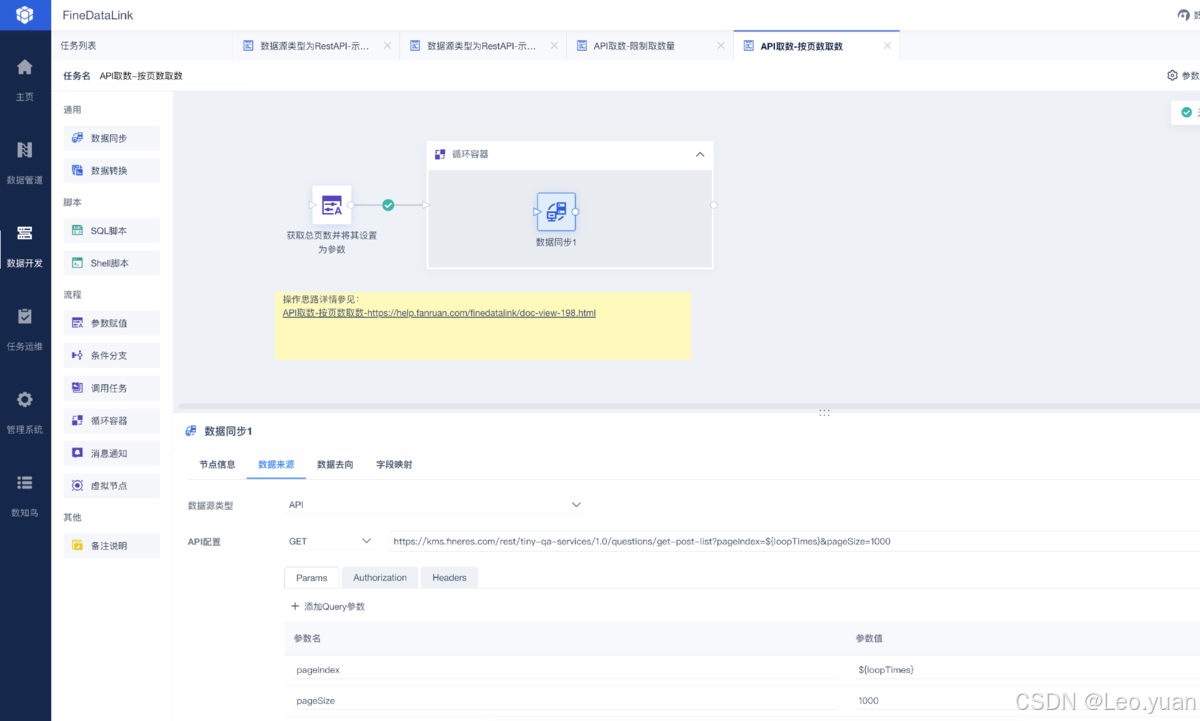

采集的方式也有很多种,比如想从业务系统里拿数据,可以通过API接口,直接对接系统获取;如果是文件形式的数据,就用文件传输的方式;要是需要从网站上获取公开数据,还能用网络爬虫。但有一点必须注意,采集的时候得保证数据是完整的、准确的,不能丢数据,也不能采到错误的数据,不然后面的处理都是白搭。FineDataLink在这方面做得不错,用的技术比较先进,不管是结构化、半结构化还是非结构化数据,都能高效、准确地采集下来,给后面的处理打下好基础。

2. 数据存储原理

采集来的数据不能随便放着,得好好存起来,不然后面处理分析的时候找不到、或者丢了,就麻烦了。但现在数据量这么大,得选合适的存储技术才行,不是随便找个地方存就行。

常见的存储方式有:

- 分布式文件系统,比如Hadoop的HDFS,它的好处是能把数据分散存储在多个节点上,这样一来,不仅能存更多数据,提升存储容量,而且就算某个节点出问题,其他节点还有备份,数据更可靠,不容易丢。

- 非关系型数据库,像MongoDB、Cassandra这些,它们的优势是灵活,适合存非结构化和半结构化数据,不用像关系型数据库那样有严格的表结构,处理起来更方便。

- 关系型数据库,主要存那些规整的结构化数据,比如企业的销售表格、客户信息表格这些,查询起来很方便。

另外,存数据的时候,一定要考虑备份和恢复的办法。不管用什么存储方式,都有可能出现数据丢失的情况,比如硬件故障、人为操作失误等等,所以定期备份数据很重要,万一数据丢了,能通过备份及时恢复,减少损失。

3. 数据加工原理

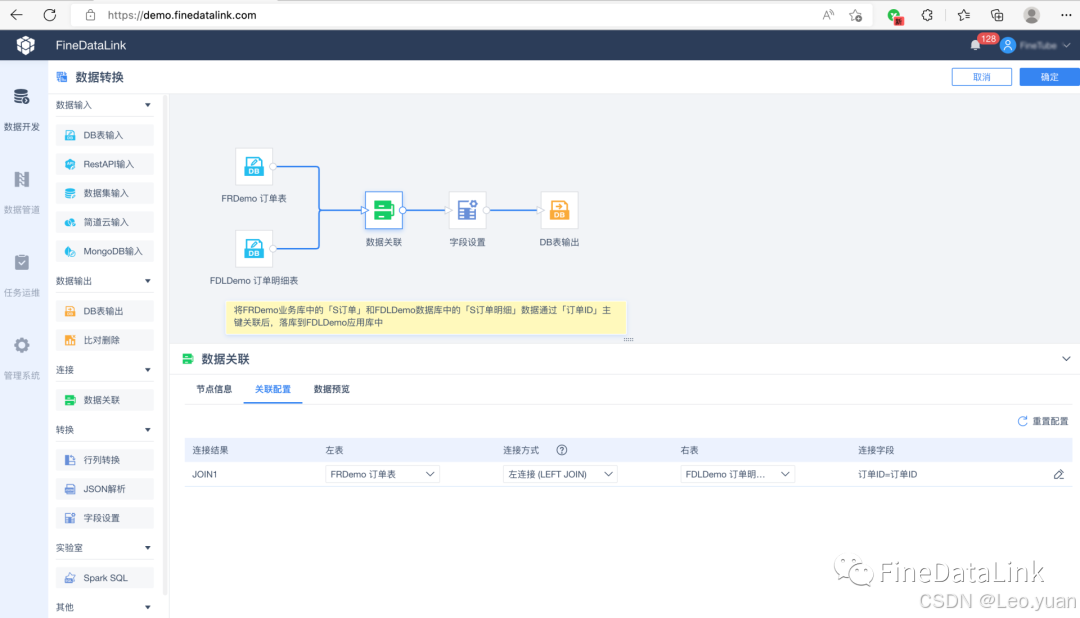

数据加工就是把采集来的原始数据,弄干净、弄准确、弄成能用的样子,主要包括清洗、转换、整合这几步,每一步都有它的作用,缺一不可。

- 数据清洗首先要做的,就是把数据里的“脏东西”去掉。比如数据里可能有重复的记录,得删掉重复的;有错误的数据,比如明显不符合逻辑的数值,得修正过来;还有没用的噪声数据,比如跟业务无关的冗余信息,得过滤掉。这样做的目的,就是保证数据的准确性和完整性,让后面的分析有可靠的基础。

- 数据转换就是把数据从一种格式改成另一种格式。因为采集来的数据格式可能不统一,或者不符合后面分析的要求,比如有的数据日期是字符串格式,而分析的时候需要标准的日期类型,就得把它转成日期类型;有的文本数据没法直接用算法分析,就得把它编码成数值数据;还有的时候,数据的尺度不一样,比如有的数据是几百,有的是几万,直接分析会受影响,就得做归一化处理,把它们调成一样的尺度。

- 数据整合就是把来自不同数据源的数据,合并到一起,建立关联,形成一个统一的数据视图。比如企业可能从业务系统里拿销售数据,从客户系统里拿客户数据,这两部分数据是相关的,就得把它们整合起来,让分析的时候能同时用到这两部分数据,不用来回切换数据源。在加工过程中,还会用到一些算法和模型,比如数据挖掘算法、机器学习算法,帮着把数据处理得更精准,更符合后续分析的需求。

4. 数据分析原理

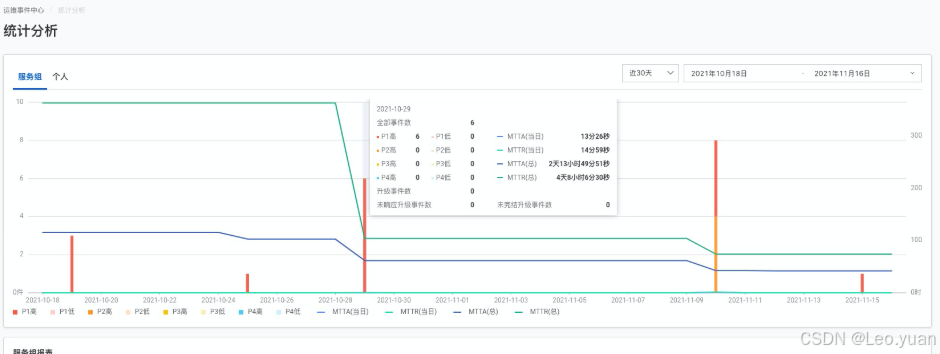

数据分析是往深了挖数据里的规律和模式,从数据里找出有价值的信息,这是数据处理里最核心的一步。常用的分析方法有统计分析、机器学习、深度学习这些,不同的方法适合不同的需求,不能随便用。

- 统计分析主要是帮着了解数据的基本情况,比如做描述性统计,计算数据的平均值、中位数、方差这些,能知道数据的整体特征;做相关性分析,能看看不同数据之间有没有关联,比如销售数据和广告投入数据之间是不是正相关。这种方法比较基础,适合做初步的数据分析。

- 机器学习则是通过训练模型,对数据进行分类、预测。比如可以用分类模型,把客户数据分成不同的客户群体;用预测模型,根据历史销售数据预测未来的销售趋势。机器学习需要用大量的数据训练模型,模型训练得越好,分析结果就越准确。

- 深度学习是更复杂的一种分析方法,能处理像图片、语音这种结构比较复杂的非结构化数据。它通过构建深层的神经网络,模拟人类的学习过程,从复杂数据里挖掘深层的规律。不过要注意,不同的业务需求得选不同的分析方法和模型,不是说哪种方法高级就用哪种,得看实际需要,比如只是做简单的趋势分析,用统计分析就够了,不用非得用深度学习。

5. 数据输出原理

数据输出就是把分析出来的结果,用用户能看懂、能用的方式呈现出来。要是分析结果做得太复杂,用户看不懂,那前面的工作就白做了。常见的输出方式有报表、图表、可视化界面这几种。

- 报表能把数据的各项指标、统计结果详细列出来,比如每个月的销售额、利润、客户数量这些,用户能清楚看到具体的数据,适合需要详细数据的场景。

- 图表则更直观,比如用折线图能看销售额的变化趋势,用柱状图能比不同产品的销量,用饼图能看不同客户群体的占比,用户一眼就能明白数据想表达的意思,不用再去翻一堆数字。

- 可视化界面还能做成交互式的,用户可以自己选择查看的数据范围、调整参数,更深入地了解分析结果,比如想看看某个季度某个地区的销售情况,直接在界面上选择就行。

输出的时候,得考虑用户的需求和使用习惯,不能自己觉得好就行,得让用户容易看、容易理解,这样分析结果才有意义。

Q&A常见问答

Q:数据处理需要具备哪些技能?

A:要做数据处理,得掌握好几方面的技能,缺一不可。

- 数据库知识:这是基础。得知道怎么设计数据库,怎么管理数据库,怎么操作数据库,还得能熟练用SQL语言查数据、处理数据,比如写查询语句、做数据过滤、分组统计这些,要是连SQL都不会,很多基础的数据处理工作都做不了。

- 编程语言:像Python、R这些,在数据处理和分析里用得特别多。Python的优势是功能全,有很多专门的数据处理库,比如Pandas能处理表格数据,NumPy能做数值计算,用起来很方便;R则更偏向统计分析,做数据可视化也很厉害。不会这些编程语言,很难深入处理复杂数据,只能做简单的基础操作。

- 数据挖掘和机器学习的基本算法、基本模型也得了解:得知道什么是分类算法、什么是回归算法、什么是聚类算法,知道在什么场景下用什么算法,比如想给客户分群就用聚类算法,想预测销量就用回归算法。还得会用相关的工具和库实现这些算法,比如用Scikit-learn做机器学习建模。

- 统计学知识:得会做描述性统计、推断性统计分析,能看懂数据背后的规律,比如知道什么是均值、中位数、标准差,什么是显著性检验,这样才能正确解读分析结果,不会误解数据。最后,数据可视化能力也不能少,得能把分析结果做成直观的图表或者报表,让别人能看懂,不然就算分析出结果,别人看不懂也没用。

Q:数据处理过程中如何保证数据安全?

A:保证数据安全在数据处理里特别重要,一旦数据泄露或者丢失,后果可能很严重,所以必须重视。

- 数据得加密:不管是数据传输的时候,还是数据存储的时候,都得用加密算法加密。

- 访问控制得严格:不是谁都能访问和操作数据,得先对用户身份进行认证;而且要给不同的人设不同的权限;管理员能改数据,但也得有日志记录,这样就算出了问题,也能查到是谁操作的。

- 定期备份数据:不管用什么存储方式,都有可能出现数据丢失的情况,所以定期备份数据很重要。备份的时候可以多备份几份,存在不同的地方,这样就算一个地方的备份丢了,还有其他备份能恢复。

- 得经常做安全审计和监控:要记录所有访问和操作数据的行为,比如谁在什么时候访问了什么数据、做了什么操作,定期检查这些日志,看看有没有异常的访问或者操作,比如有人突然访问了大量敏感数据,或者在非工作时间操作数据。同时要监控系统的安全状况,及时发现安全漏洞,比如系统有没有被攻击,有没有病毒入侵,发现问题赶紧处理,避免数据安全事故。

- 选数据处理工具和平台的时候,也得选安全性能好的。比如看看工具有没有加密功能、有没有访问控制功能、有没有安全审计功能,是不是有专业的团队维护安全,不然工具本身有漏洞,数据也不安全。

Q:数据处理的成本高吗?

A:数据处理的成本不是固定的,得看企业的具体情况,不能一概而论说高或者低。

- 如果企业自己有技术团队,技术能力强,能用开源的技术和工具做数据处理,成本就相对低一些。但这种方式需要投入不少人力,而且对技术人员的要求也高,得懂这些开源技术,不然玩不转。

- 要是企业自己没技术能力,或者不想自己投入太多人力,选商业软件和服务,成本就会高一些。

另外,数据处理的成本还包括硬件设备的钱

- 对小企业来说,这些成本可能有点压力,因为小企业预算有限,技术团队也可能不完善,所以得精打细算,比如优先用开源工具,或者找性价比高的第三方服务。

- 对大企业来说,数据处理带来的收益通常能覆盖这些成本,比如通过数据处理提高运营效率、增加销售额,这些收益比成本高很多,所以大企业愿意投入更多钱做数据处理。

总的来说,企业得根据自己的预算、技术能力、业务需求,选合适的方式和技术,把成本控制在能接受的范围里,不用盲目追求贵的,也不能只看便宜不看效果。

总结

总的来说,数据处理就是对数据进行采集、存储、加工、分析和输出的一整套操作,不是单一的步骤,而是一个完整的过程。企业在做数据处理的时候,也不能盲目跟风,得根据自己的需求和实际情况,选合适的技术和工具,既要保证数据安全,又要保证处理效果,这样才能充分发挥数据的价值,让数据真正成为企业发展的助力。