傅里叶变换+attention机制,深耕深度学习领域

来gongzhonghao【图灵学术计算机论文辅导】,快速拿捏更多计算机SCI/CCF发文资讯~

今天和大家分享一个深度学习领域潜力十足的研究方向:傅里叶变换 + attention 机制,当前这一方向尚未饱和,正是入局抢占前沿的绝佳时机!

自 FDAM 等将傅里叶变换与注意力调制结合的成果展现出显著优势后,这一方向在密集预测、多模态理解等领域的潜力持续释放,创新空间广阔且易形成完整问题闭环。

如今,通用框架已难突围,深耕垂直领域才是关键:针对特定任务(如语义分割、意图识别)设计频率 - 注意力协同机制,或探索跨模态频率对齐策略,都能快速产出高质量成果。

本文精心整理了 3 篇前沿论文,旨在助力大家洞悉前沿动态、把握研究思路。满满干货,点赞收藏不迷路~

Frequency-Dynamic Attention Modulation for Dense Prediction

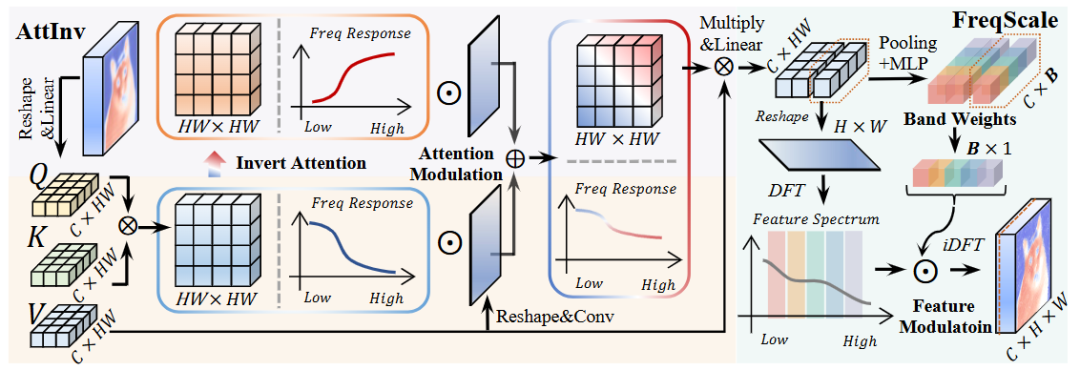

方法:这篇文章首次从电路理论出发,诊断并破解 Vision Transformer 在密集预测中因“逐层低通滤波”导致的高频信息消失与表征塌陷难题。

创新点:

提出 Attention Inversion(AttInv),通过频域反转注意力矩阵生成互补高通滤波器,实现低-高通动态融合;

设计 Frequency Dynamic Scaling(FreqScale),利用轻量级 MLP 实时生成逐频段可学习权重,对特征频谱进行精细重加权;

构建即插即用的 Frequency-Dynamic Attention Modulation(FDAM)框架,可在任意 ViT 上零侵入部署,仅增 0.2–2 M 参数即带来显著性能跃升。

总结:作者先在频域证明标准自注意力等价于低通滤波并导致高频指数衰减,随后用 AttInv 为每层生成可学习权重的高通支路并与原注意力加权组合,再通过 FreqScale 对特征图逐频段动态放大,最终形成贯穿所有层的全谱表征增强机制。

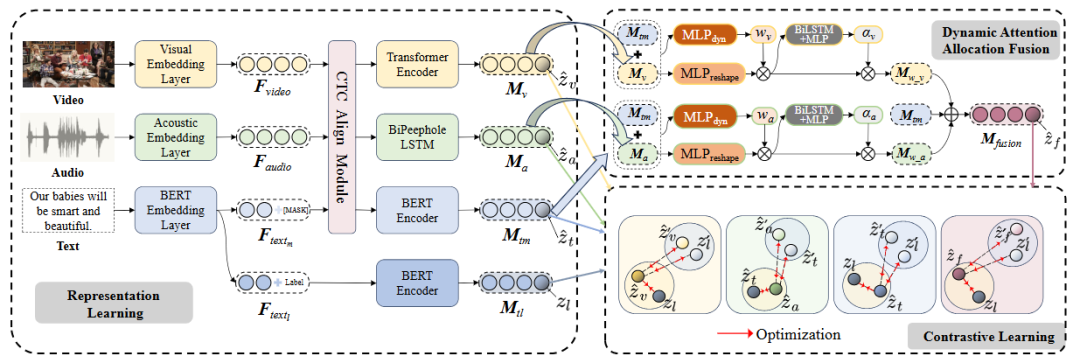

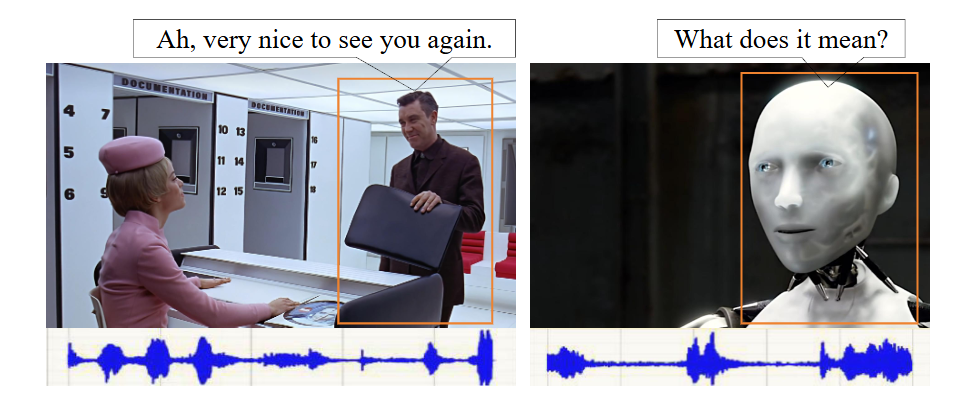

Adaptive Multimodal Fusion: Dynamic Attention Allocation for Intent Recognition

方法:这篇文章针对多模态意图识别任务中“不同样本、不同模态信息密度差异巨大”这一关键痛点,提出一种能够像人脑一样动态聚焦关键线索的自适应框架。

创新点:

设计了 Dynamic Attention Allocation Fusion(DAF)模块,可在样本级实时调整模态间及模态内注意力权重;

构建 Multi-View Contrastive Learning(MVCL-DAF)框架,将文本、视觉、声学及融合视角视为独立视图,以文本为主锚点进行对比对齐;

采用分布式编码策略,为每类模态配备专属网络(BERT-Encoder/Transformer/Bi-Peephole LSTM),先独立处理再融合,显著降低噪声干扰。

总结:作者先用 CTC 对齐三种模态序列,再用各自专用编码器提取表征;随后 DAF 根据文本引导动态计算声学、视觉的权重矩阵与模态门控,实现细粒度信息聚焦;最后 MVCL-DAF 以 InfoNCE 损失联合优化四个视图,使模型在 MIntRec 与 MIntRec 2.0 双数据集上全面刷新 SOTA。

纠结选题?导师放养?投稿被拒?对论文有任何问题的同学,欢迎来gongzhonghao【图灵学术计算机论文辅导】,获取顶会顶刊前沿资讯~

UniMamba: Unified Spatial-Channel Representation Learning with Group-Efficient Mamba for LiDAR-based 3D Object Detection

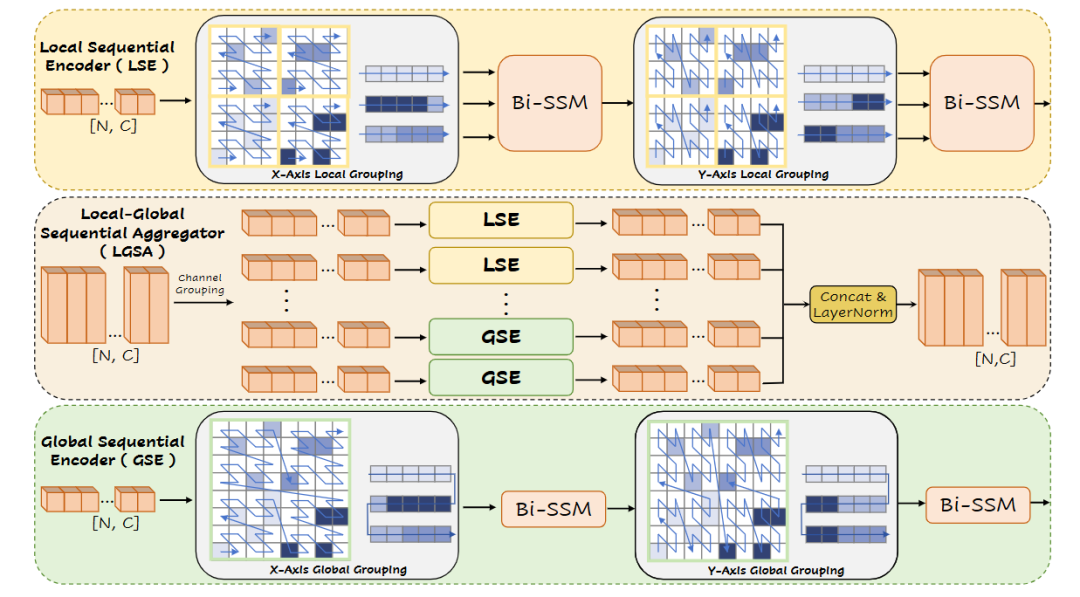

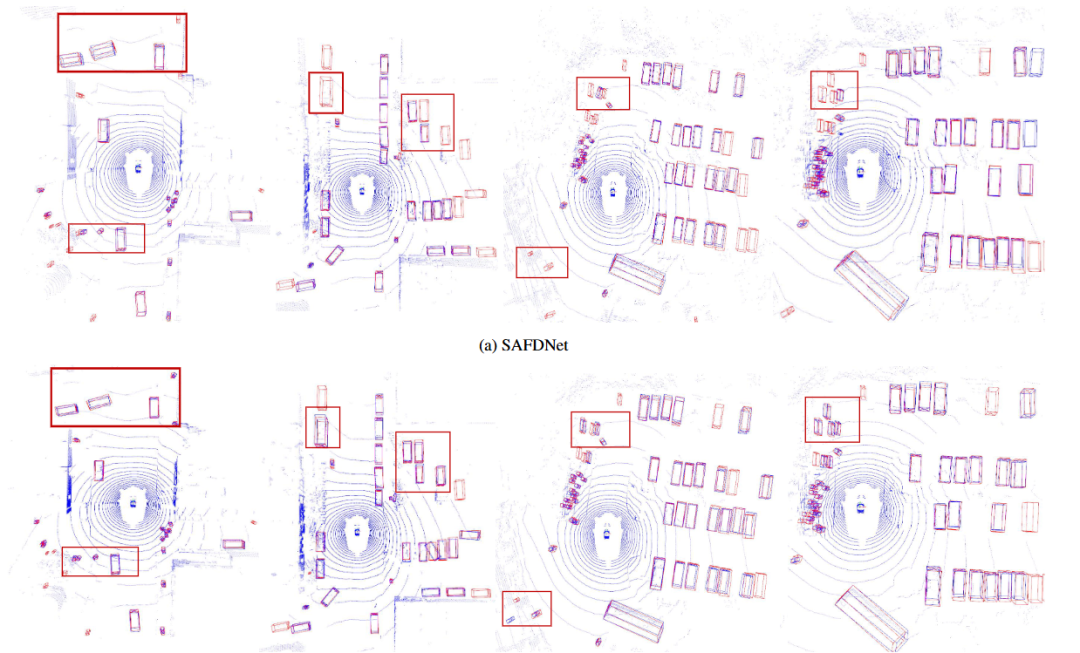

方法:这篇文章面向激光雷达 3D 目标检测,直击“Transformer 序列化破坏空间结构、SSM 全局建模丢失局部细节”两大痛点,提出兼具局部几何敏感与全局上下文捕获能力的统一骨干。

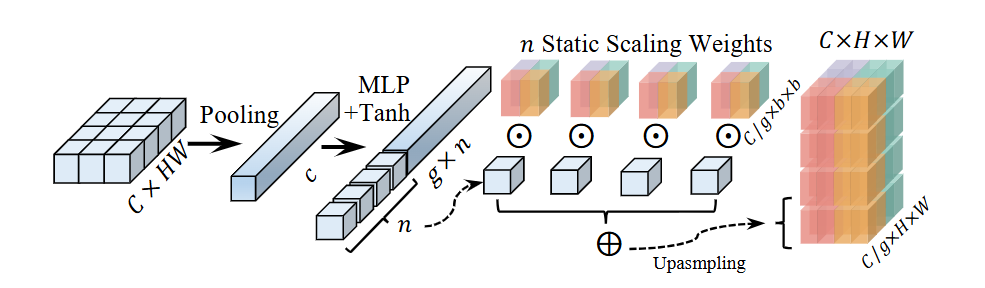

创新点:

设计 Spatial Locality Modeling 模块,用 3D 子流形卷积在序列化前显式编码细粒度邻域几何;

提出互补 Z-order 双向序列化,兼顾 x、y 轴保距性并仅 0.9 ms 完成索引;

构建 Local-Global Sequential Aggregator,通过通道分组并行运行窗口级 LSE 与全局 GSE,以线性复杂度同时建模局部与全局依赖。

总结:作者先用轻量 SubConv3D 补偿局部位置编码,随后以通道维度将特征切分为若干组,部分组送入窗口级双向 Mamba 捕获局部结构,其余组直接在全场景序列上用双向 Mamba 建模全局关系,最后将多尺度 UniMamba 块堆叠为编解码架构。

关注gongzhonghao【图灵学术计算机论文辅导】,快速拿捏更多计算机SCI/CCF发文资讯~