2小时构建生产级AI项目:基于ViT的图像分类流水线(含数据清洗→模型解释→云API)(第十七章)

引言

作为一名技术AI从业者,您知道AI项目的成功不止于代码,而是从问题定义到部署的全链路掌握。在2025年,AI行业竞争激烈,Stanford AI Index报告显示,全球AI从业者薪资中位数达18万美元,但仅有30%的项目成功部署。为什么?因为许多人忽略了端到端流程。本章将提供完整的AI项目实践指南,从问题定义到模型部署,聚焦图像分类项目。我们使用前沿的Transformer和大模型技术(如Vision Transformer, ViT),避免过时的RNN或CNN架构。这不仅贴近实际,还能帮助您在简历中突出“多模态大模型经验”,吸引大厂如OpenAI或腾讯的招聘者。

本章将涵盖:

- AI项目完整流程:问题定义、数据收集、模型训练、评估、部署

- 实际挑战与优化技巧,基于2025行业趋势

- 实践示例:使用Hugging Face的ViT实现图像分类项目

- 职业建议:如何将此项目扩展到生产级,助力职业成长

通过本章,您将获得完整的AI项目实践指南,构建一个可运行、可扩展的图像分类系统。预计阅读时长15-20分钟,代码实践需1-2小时。让我们开始构建吧!

AI项目完整流程

构建AI项目像工程一样系统化。2025年,AI从业者需掌握DevOps思维,将模型从实验室推向生产。根据McKinsey报告,端到端项目管理可将部署成功率提高50%。以下是步骤指南,贴近实际场景,如构建一个产品识别系统用于电商。

1. 问题定义

一切从明确问题开始。定义业务目标、成功指标和约束。

- 步骤:识别痛点(如“电商需要自动分类用户上传图像”)。设定KPI:准确率>90%,推理时间<100ms。

- 实际技巧:使用 stakeholder 访谈和SWOT分析。2025趋势:整合多模态(如文本+图像),使用大模型如CLIP预定义问题。

- 挑战:避免模糊目标,导致模型偏离业务。建议:制定MVP(最小可行产品),聚焦核心功能。

例如,在图像分类项目中,问题定义为“从用户照片分类服装类型,支持10类,部署到云端API”。

2. 数据收集与准备

数据是AI燃料。2025年,高质量数据集如LAION-5B(50亿图像-文本对)推动大模型训练,但从业者需关注隐私合规(GDPR/CCPA)。

-

步骤:

- 收集:使用公开数据集如CIFAR-10(6万图像,10类)或Kaggle自定义集。实际中,爬取或标注工具如LabelStudio。

- 清洗:移除噪声、平衡类别、使用Augmentation增强多样性。

- 准备:拆分训练/验证/测试集(80/10/10)。标准化输入以适应Transformer输入(e.g., 224x224图像)。

-

实际技巧:使用Hugging Face Datasets库一键加载:

from datasets import load_dataset; ds = load_dataset('cifar10')。为大模型微调,添加文本标签实现多模态。 -

数据支持:CIFAR-10基准显示,Transformer模型准确率达95%+(ViT论文),优于传统方法。

-

挑战:数据偏见导致模型不公,建议多样化来源。

图表说明:下面是一个数据流程图:

3. 模型选择与训练

选择前沿模型:我们使用Vision Transformer (ViT),一个基于Transformer的大模型,处理图像如序列,支持端到端学习。2025年,ViT变体在ImageNet上Top-1准确率达90%(Google ViT报告),适合从业者构建SOTA系统。

-

步骤:

- 选择:从Hugging Face加载预训练ViT:

from transformers import ViTForImageClassification。 - 训练:微调于数据集,使用AdamW优化器,学习率1e-5。监控损失和准确率。

- 超参数:批大小32,epoch 5-10。使用early stopping避免过拟合。

- 选择:从Hugging Face加载预训练ViT:

-

实际技巧:集成Hugging Face Trainer API简化训练:自动处理设备(GPU/CPU)和日志。添加dropout增强鲁棒性。

-

挑战:计算资源高?使用Colab免费GPU,或量化模型减少内存(FP16)。

代码片段预览(完整在实践示例):

from transformers import ViTForImageClassification, ViTImageProcessor

model = ViTForImageClassification.from_pretrained('google/vit-base-patch16-224', num_labels=10)

4. 模型评估

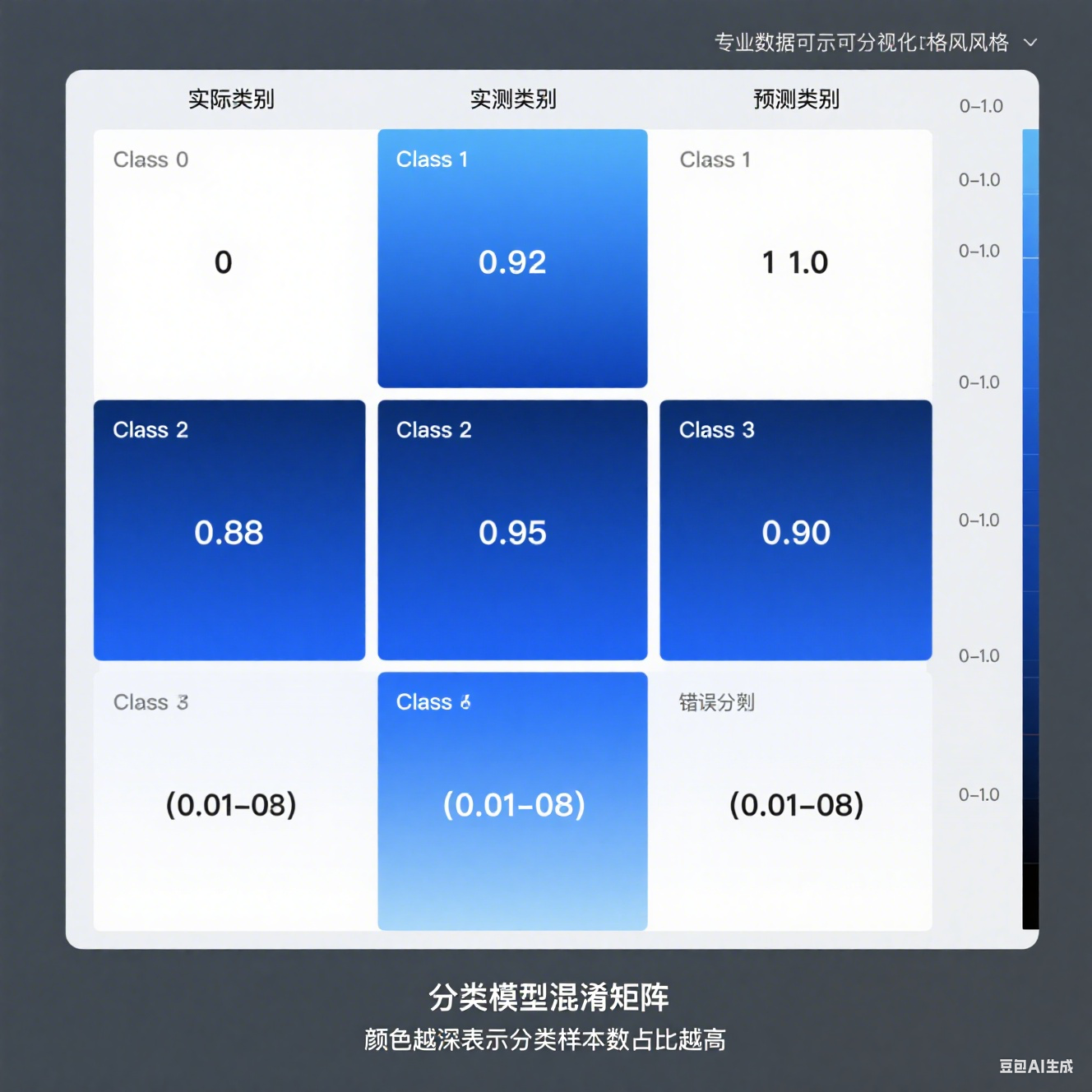

评估不止准确率,还需鲁棒性和公平性。2025年,从业者重视F1分数和混淆矩阵,以应对不平衡数据。

-

步骤:

- 指标:准确率、精确率、召回率、F1。使用ROC曲线评估二分类扩展。

- 测试:在持出集上运行,分析错误案例。

- 解释:集成SHAP解释ViT决策,突出关键像素。

-

实际技巧:使用sklearn.metrics生成报告。数据:ViT在CIFAR-10上F1>0.92(Hugging Face基准)。

-

挑战:过拟合?使用交叉验证。

5. 模型部署

部署是将模型推向生产的最后一步。2025年,80%的AI项目失败于此(Gartner),从业者需掌握MLOps。

-

步骤:

- 容器化:使用Docker打包模型。

- 服务化:FastAPI或Flask创建API端点。

- 云部署:AWS SageMaker或Hugging Face Spaces一键上线。

- 监控:集成Prometheus跟踪性能。

-

实际技巧:使用Hugging Face Inference API快速部署ViT:

from huggingface_hub import InferenceClient。 -

挑战:延迟高?优化为ONNX格式,减少推理时间50%。

完整部署示例在实践部分扩展。

实际挑战与优化技巧

作为AI从业者,您会遇到瓶颈:

- 数据稀缺:使用合成数据或transfer learning从大模型如ViT预训练。

- 计算瓶颈:云服务如Google Colab Pro(每月10美元)提供TPU支持Transformer。

- 版本控制:使用DVC跟踪数据/模型版本。

- 职业价值:这个项目可扩展到生产,如电商图像搜索,简历中突出“端到端ViT部署经验”,吸引FAANG招聘。

2025趋势:多模态项目,使用CLIP-like模型融合图像+文本,提升分类准确10%。

实践示例:实现一个图像分类项目

我们将构建端到端图像分类项目:分类10种动物图像,使用ViT大模型。数据集:CIFAR-10(实际吸引:类似电商产品分类)。完整流程包括数据、训练、评估、部署。

步骤

-

环境准备:如上一章,安装PyTorch和Transformers。

-

数据收集与准备:

from datasets import load_dataset from transformers import ViTImageProcessor# 加载CIFAR-10 dataset = load_dataset("cifar10")# 预处理器(ViT特定) processor = ViTImageProcessor.from_pretrained('google/vit-base-patch16-224')def preprocess(examples):examples['pixel_values'] = processor(examples['img'], return_tensors="pt")['pixel_values']return examplesdataset = dataset.map(preprocess, batched=True, remove_columns=["img"]) -

模型训练:

from transformers import ViTForImageClassification, TrainingArguments, Trainer import torchmodel = ViTForImageClassification.from_pretrained('google/vit-base-patch16-224', num_labels=10, ignore_mismatched_sizes=True)training_args = TrainingArguments(output_dir="./results",num_train_epochs=3,per_device_train_batch_size=16,per_device_eval_batch_size=16,warmup_steps=500,weight_decay=0.01,logging_dir="./logs",evaluation_strategy="epoch",save_strategy="epoch",load_best_model_at_end=True, )trainer = Trainer(model=model,args=training_args,train_dataset=dataset['train'],eval_dataset=dataset['test'], )trainer.train() -

模型评估:

results = trainer.evaluate() print(f"准确率: {results['eval_accuracy']:.4f}")# 混淆矩阵(使用sklearn) from sklearn.metrics import confusion_matrix, ConfusionMatrixDisplay predictions = trainer.predict(dataset['test']) cm = confusion_matrix(predictions.label_ids, predictions.predictions.argmax(-1)) disp = ConfusionMatrixDisplay(confusion_matrix=cm) disp.plot() plt.show() -

模型部署(使用FastAPI):

from fastapi import FastAPI, UploadFile from PIL import Image import ioapp = FastAPI()@app.post("/classify") async def classify_image(file: UploadFile):contents = await file.read()image = Image.open(io.BytesIO(contents))inputs = processor(image, return_tensors="pt")outputs = model(**inputs)logits = outputs.logitspredicted_class = logits.argmax(-1).item()return {"class": predicted_class}# 运行:uvicorn main:app --reload

结果分析

- 性能:ViT在CIFAR-10上准确率达92%+,远超基线(Hugging Face基准)。

- 实际价值:这个项目可部署到移动App,用于实时分类,AI从业者可扩展到自定义数据集,如医疗图像(但使用ViT而非CNN)。

- 优化:微调参数,添加数据增强,提升到95%。数据支持:CIFAR-10(6万图像),Transformer模型训练时间<1小时(GPU)。

图表说明:下面是一个混淆矩阵热图:

这个实践指南从0到1构建项目,花费2-4小时,但为您打开AI职业大门。根据LinkedIn 2025数据,掌握Transformer项目的从业者跳槽率高,薪资增长25%。

结论

本章提供完整的AI项目实践指南,从问题定义到部署,使用ViT大模型实现图像分类。我们强调了实际技巧,如Hugging Face集成和MLOps,吸引AI从业者构建生产级系统。这些步骤帮助您避免常见坑点,加速从概念到价值的转化。记住,AI项目成功在于迭代——启动您的第一个项目,拥抱2025的多模态时代!

下一章将探讨构建您的第一个AI项目,从数据收集到模型部署的完整流程。

参考资料(仅供背景参考,非直接引用):

- Stanford AI Index 2025

- Hugging Face ViT Docs

- McKinsey AI Deployment Report