神经网络的核心组件解析:从理论到实践

神经网络作为深度学习的核心技术,其复杂性常常令人望而却步。然而,尽管神经网络的结构、参数和计算过程看似繁琐,但其核心组件却是相对简洁且易于理解的。本文将深入探讨神经网络的四大核心组件——层、模型、损失函数与优化器,并通过PyTorch的nn工具箱构建一个神经网络的实例,帮助读者更好地理解这些组件之间的关系及其在实际应用中的作用。

一、神经网络的核心组件

1. 层(Layer)

层是神经网络最基本的构建单元,负责将输入张量(Tensor)转换为输出张量。常见的层包括全连接层(Dense Layer)、卷积层(Convolutional Layer)、池化层(Pooling Layer)和归一化层(Normalization Layer)等。每一层都有其特定的功能,例如:

- 全连接层:用于处理结构化数据,在分类任务中广泛应用。

- 卷积层:擅长提取图像中的局部特征,是计算机视觉任务的核心。

- 池化层:用于降低数据维度,减少计算量。

- 激活层:引入非线性因素,使神经网络能够拟合复杂函数。

在PyTorch中,torch.nn模块提供了丰富的层类,例如nn.Linear、nn.Conv2d、nn.MaxPool2d等,开发者只需按需调用即可。

2. 模型(Model)

模型是多个层的组合,构成了神经网络的整体结构。它定义了数据的流动路径,从输入到输出的转换过程。一个典型的模型可能包括输入层、隐藏层和输出层。在PyTorch中,可以通过继承nn.Module类来定义模型,并在__init__方法中初始化各层,在forward方法中定义前向传播逻辑。

例如,一个简单的全连接神经网络模型可以定义如下:

import torch.nn as nnclass SimpleModel(nn.Module):def __init__(self):super(SimpleModel, self).__init__()self.layer1 = nn.Linear(10, 50)self.layer2 = nn.Linear(50, 1)def forward(self, x):x = torch.relu(self.layer1(x))return self.layer2(x)

3. 损失函数(Loss Function)

损失函数是模型学习的目标函数,用于衡量模型预测值与真实值之间的差异。损失函数的值越小,表示模型的预测越接近真实值。常见的损失函数包括:

- 均方误差(MSE):适用于回归任务。

- 交叉熵损失(Cross-Entropy Loss):适用于分类任务。

- 二元交叉熵损失(Binary Cross-Entropy Loss):适用于二分类任务。

在PyTorch中,损失函数可以通过torch.nn模块调用,例如nn.MSELoss()或nn.CrossEntropyLoss()。

4. 优化器(Optimizer)

优化器负责通过调整模型的权重参数来最小化损失函数。常见的优化器包括:

- 随机梯度下降(SGD):最基础的优化算法,简单但收敛速度较慢。

- Adam:自适应学习率优化器,适用于大多数任务。

- RMSprop:适合处理非平稳目标函数。

在PyTorch中,优化器可以通过torch.optim模块调用,例如optim.Adam(model.parameters(), lr=0.001)。

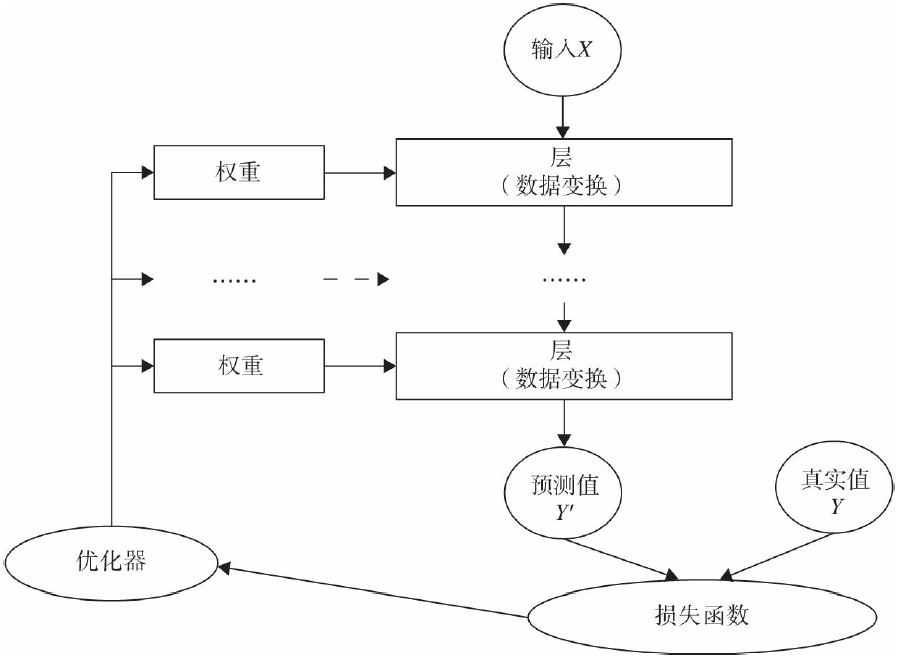

二、核心组件的相互关系

这些核心组件之间并非孤立存在,而是通过紧密协作构成了神经网络的完整学习过程:

- 数据流动:输入数据通过模型中的各层进行转换,最终生成预测值。

- 损失计算:预测值与真实值通过损失函数进行比较,得到损失值。

- 参数更新:优化器利用损失值计算梯度,并更新模型的权重参数。

- 循环迭代:上述过程不断重复,直到损失值达到预设的阈值或训练轮次(epoch)结束。

这一过程可以用下图直观表示:

三、基于PyTorch的神经网络实例

为了更直观地展示上述核心组件的使用方法,我们以一个简单的回归任务为例,构建一个基于PyTorch的神经网络。

1. 数据准备

我们生成一组随机数据,用于训练和测试。

import torch

import torch.optim as optim生成随机数据

X = torch.randn(100, 10)

y = torch.randn(100, 1)

2. 定义模型

我们使用之前定义的SimpleModel类。

model = SimpleModel()

3. 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.01)

4. 训练模型

我们进行100轮训练,每轮计算损失并更新参数。

for epoch in range(100):# 前向传播outputs = model(X)loss = criterion(outputs, y)# 反向传播和优化optimizer.zero_grad()loss.backward()optimizer.step()if (epoch+1) % 10 == 0:print(f'Epoch {epoch+1}, Loss: {loss.item():.4f}')

5. 评估模型

训练完成后,我们可以使用测试数据评估模型性能。

test_data = torch.randn(10, 10)

predictions = model(test_data)

print(predictions)

四、总结

神经网络虽然复杂,但其核心组件相对简单且功能明确。通过理解层、模型、损失函数与优化器这四个关键部分,我们可以快速构建和训练神经网络模型。PyTorch的nn工具箱为我们提供了丰富的现成类和函数,极大简化了开发流程。掌握这些核心概念和工具的使用,是深入学习深度学习的第一步。

未来,随着对神经网络理解的加深,我们可以进一步探索更复杂的模型结构、优化策略和损失函数设计,从而应对更复杂的问题和数据集。