gpt-oss-120b 模型:笔记本上的智能“奇幻之旅”

奇幻之言:

当 OpenAI 释放出 120B 开源巨兽 gpt-oss-120b(对标 GPT-4-mini),要求 80GB 显存、H100 起步时,我正拆开刚到手的游戏本。一查配置——显存达标,内存够用。仿佛这台机器,本就为这一刻而生。

当 OpenAI 释放出 120B 开源巨兽 gpt-oss-120b(对标 GPT-4-mini),要求 80GB 显存、H100 起步时,我正打开一台备用的刚升级的笔记本。一查配置——显存,内存都够用。仿佛这台机器,本就为这一刻而生。

1:部署工作

OpenAI 为 gpt-oss 系列模型打造了全面的私有化部署解决方案。借助原生 MXFP4 量化技术,显著降低了显存占用,让部署更加高效。

在工具选择上,提供了多种主流的部署方式,如 Transformers、vLLM、PyTorch / Triton、Ollama 和 LM Studio 等,满足不同用户的需求。

而我此次选用的是 LM Studio,大家可以直接前往其官网进行下载和安装。

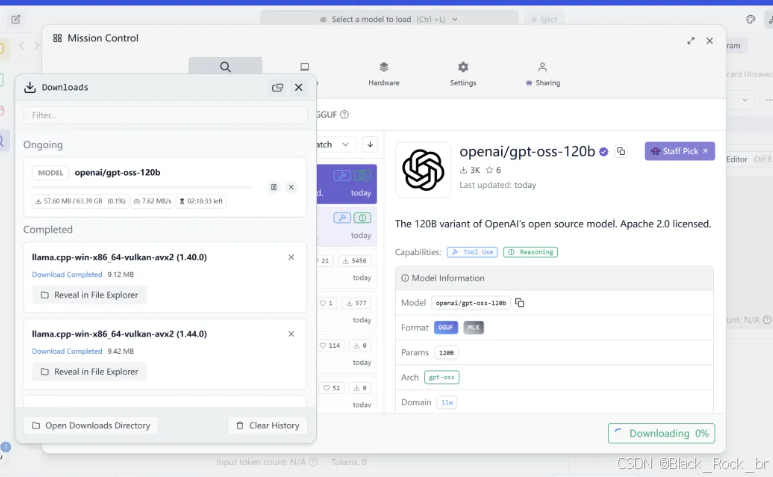

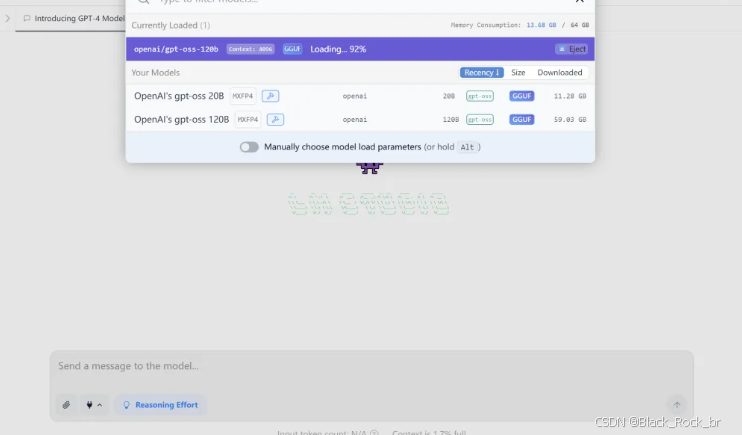

在 LM Studio 中支持一键拉取开源模型,只需搜索 gpt-oss-120b 并选择对应量化版本即可开始下载。

由于原始模型参数量高达 117B,完整版体积可达数十GB,建议预留充足存储空间并使用稳定网络连接

2:模型配置

模型下载完成后,还不能立即运行。

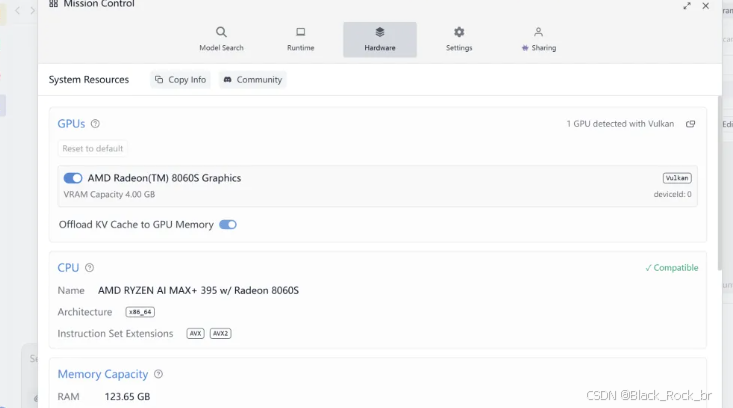

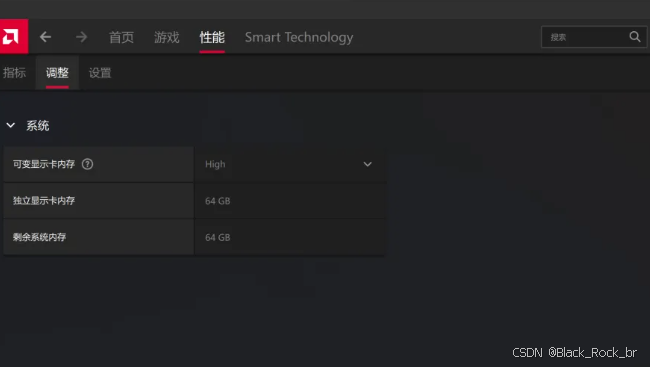

虽然系统采用统一内存架构,但默认分配给集成显卡的显存仅有 4GB,其余内存不会自动作为显存使用——这对运行百B级大模型远远不够

完成安装后,在 LM Studio 中点击「载入模型」按钮。

就在显存调完、配置改好后——进度条走完,提示弹出:“部署成功”。

这一刻,百B级模型,真正属于你的电脑了

3:推理效果:一探究竟

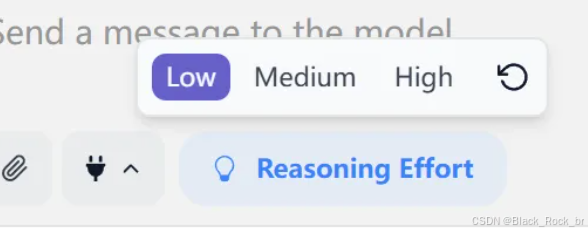

OpenAI 的这一模型提供了多种推理强度选项,涵盖“低”、“中”、“高”三个等级。

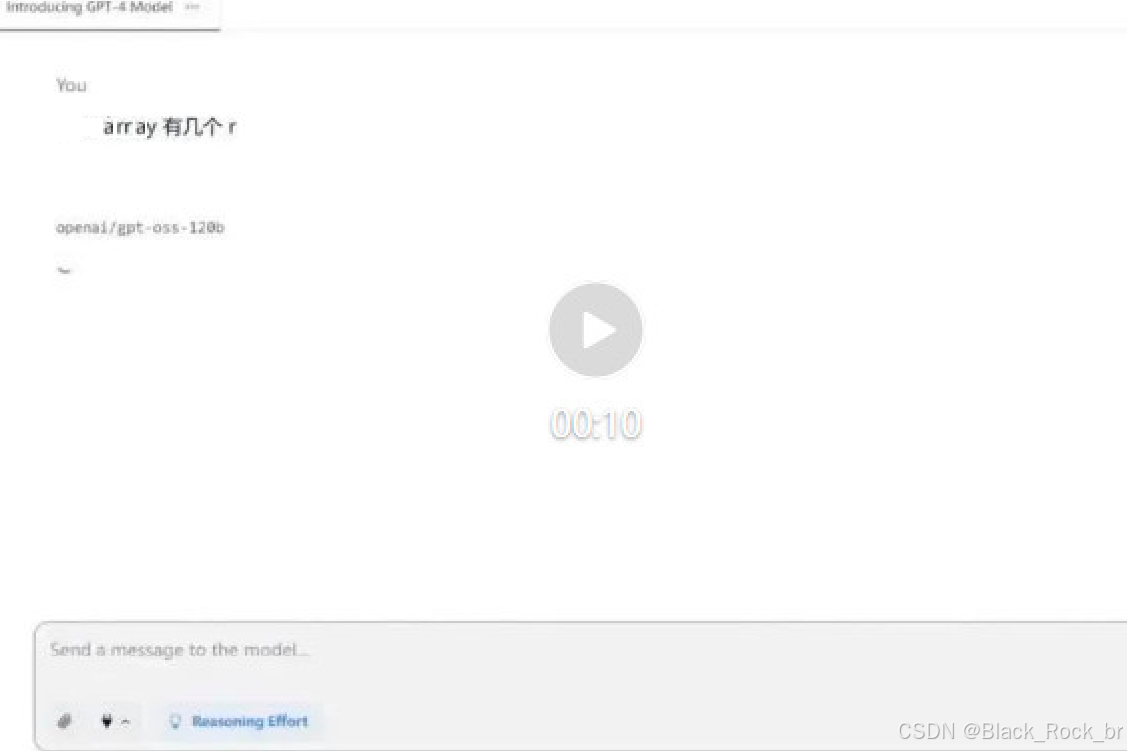

问题:单词 "array" 中有几个字母 r?

低负载模式下推理中……预计耗时 ≈8 秒 —— 别急,大模型也在“思考人生”。

高强度模式:耗时约0.6分钟

该模型还支持多种工具调用能力,例如可自定义配置 MCP(Model Control Protocol),进一步扩展功能。

在实际部署过程中,有两个细节值得注意,分享如下:

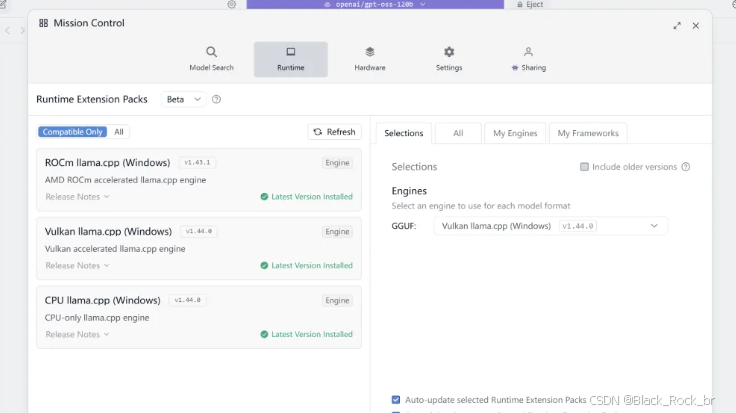

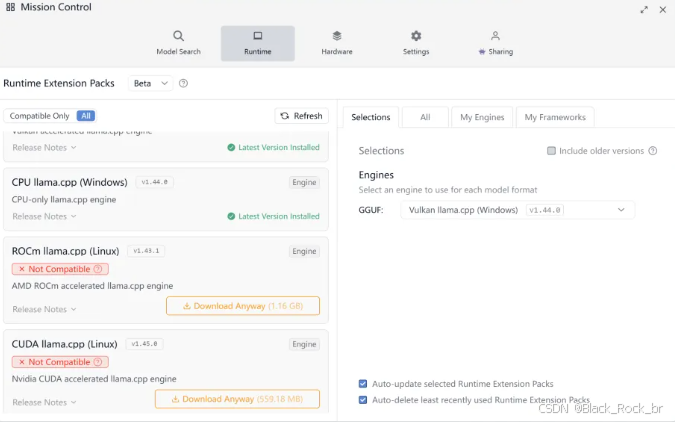

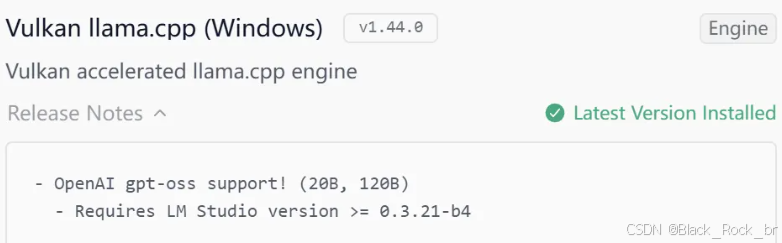

在 LM Studio 中,用户可以根据自身需求选择不同的 Runtime 环境,其支持的选项丰富多样,涵盖了 CUDA、Vulkan、ROCm、llama.cpp(GPU 版本)、llama.cpp(CPU 版本)等多种类型。

所以,这里推荐将显存分配设为 64GB,能保证完美运行。