安装AI高性能推理框架llama.cpp

基础知识:llama.cpp是什么?

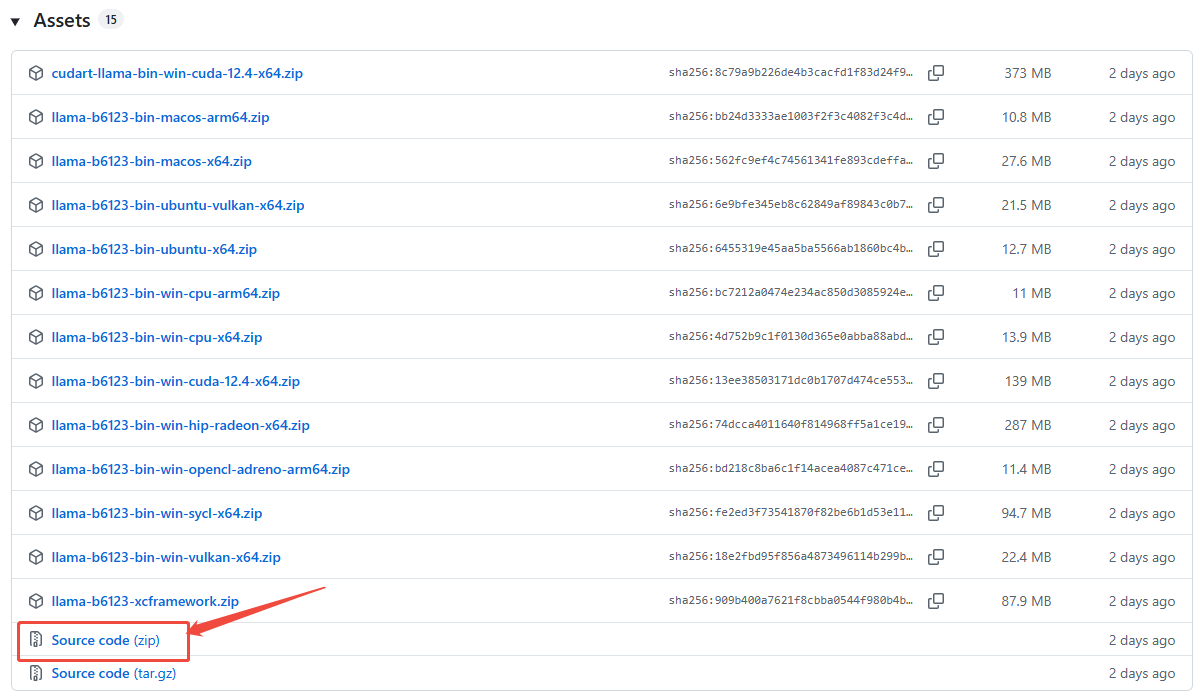

1.下载安装包

通过git下载主干源代码:

git clone --progress --branch master -v "https://github.com/ggml-org/llama.cpp.git" "./llama.cpp"也可以下载tag源码,例如,下载【Source code [zip]】文件:

https://github.com/ggml-org/llama.cpp/releases/tag/b6123 2.执行编译安装

2.执行编译安装

1)安装前准备

(1)安装前需确认是否已安装curl开发库。执行以下命令,确认curl开发库是否已安装?

- Ubuntu/Debian

# 检查头文件是否存在

ls /usr/include/x86_64-linux-gnu/curl/curl.h- CentOS/RHEL

# 检查头文件是否存在

ls /usr/include/curl/curl.h如果文件不存在,则说明curl开发库还没有安装好,需要执行以下命令进行安装:

- Ubuntu/Debian

sudo apt update

sudo apt install libcurl4-openssl-dev # 或 libcurl4-gnutls-dev- CentOS/RHEL

sudo yum install -y libcurl-devel(2)确认是否支持ccache?

执行以下命令确认是否支持ccache:

ccache --version如果提示命令不存在,执行以下命令进行安装:

- Ubuntu/Debian

sudo apt update

sudo apt install ccache- CentOS/RHEL

sudo yum install -y ccache(3)创建编译目录

把下载的离线安装解压后,进入到llama.cpp目录,执行以下命令创建build子目录:

mkdir build2)编译前检查

再进入build子目录,执行以下命令进行编译安装:

cd build # 进入构建目录

cmake .. # 生成构建系统(Makefile)

根据提示解决相关的库依赖问题(由于不同的环境预安装的库存在差异,因此,这里不再一一详细说明)。

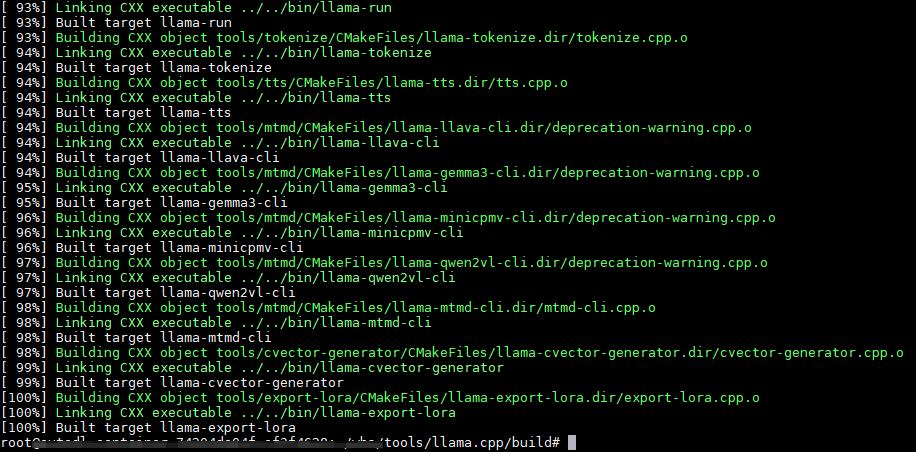

3)执行编译命令

执行以下命令进行编译:

make GGML_CUDA=1 # 编译项目,并支持CUDA加速版编译,如果没有nvidia的网卡和CUDA库,请直接使用不带参数的 make 命令。

编译过程会需要些时间,请耐心等候。出现以下提示表示

4)执行安装命令

make install # 安装3.验证安装效果

执行以下命令,验证安装效果:

llama-cli --version如果提示以下信息,表示已安装成功

![]()

如果提示以下信息,则说明要更新系统的动态链接库。

llama-cli: error while loading shared libraries: libllama.so: cannot open shared object file: No such file or directory更新系统的动态链接库的方法如下:

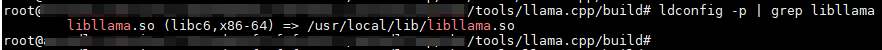

sudo ldconfig然后验证更新后的效果:

ldconfig -p | grep libllama返回以下信息,表示更新成功:

此时,再执行llama-cli --version命令即可看到正确的返回结果了。