【AI论文】高效智能体:在降低成本的同时构建高效能智能体

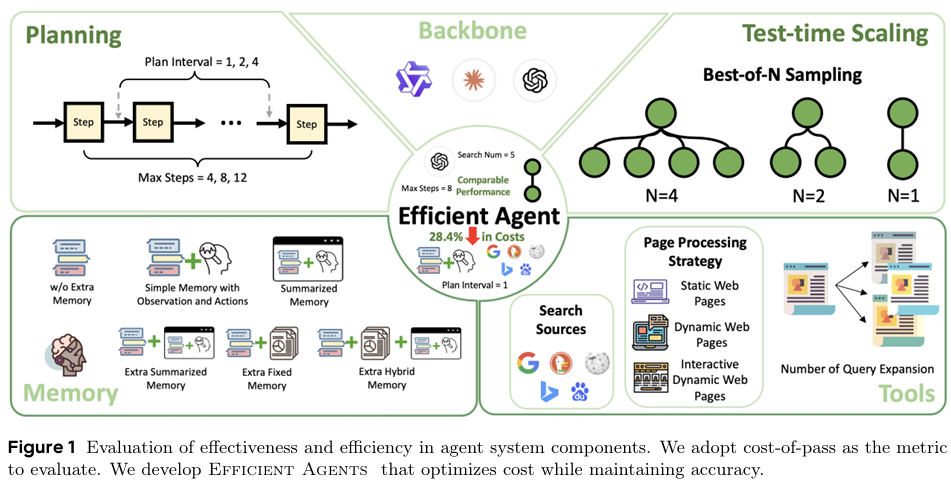

摘要:大型语言模型(LLM)驱动的智能体所具备的卓越能力,使得复杂的多步骤任务得以被精密系统所处理,但其不断攀升的成本却对系统的可扩展性和可及性构成了威胁。本研究首次对现代智能体系统中效率与效能之间的权衡关系进行了系统性探究,旨在满足在不牺牲性能的前提下实现经济高效设计的关键需求。我们着重探讨了三个核心问题:(1)智能体任务本身究竟需要多高的复杂度?(2)在何种情况下,增加额外模块所带来的收益会逐渐减少?(3)通过设计高效的智能体框架,能够提升多少效率?通过对GAIA基准测试集进行实证分析,我们评估了LLM主干模型的选择、智能体框架设计以及测试时扩展策略所产生的影响。我们采用“通过成本”(cost-of-pass)这一指标,对上述各维度上的效率与性能权衡关系进行了量化分析。基于这些发现,我们开发了“高效智能体”(Efficient Agents)这一新型智能体框架,该框架能够根据任务需求实现最优复杂度配置。与领先的开源智能体框架OWL相比,高效智能体在保持96.7%性能的同时,将运营成本从0.398降低至0.228,使“通过成本”提升了28.4%。本研究为设计高效、高性能的智能体系统提供了切实可行的见解,推动了AI驱动解决方案的可及性和可持续性发展。Huggingface链接:Paper page,论文链接:2508.02694

研究背景和目的

研究背景:

近年来,大型语言模型(LLMs)的推理和创造能力显著增强,为现实世界中的应用开辟了广阔前景。研究人员开发了众多基于LLM的智能体系统,这些系统能够处理复杂的多步骤任务,展现了强大的应用潜力。然而,随着模型规模的扩大和复杂度的提升,这些系统的运营成本也急剧上升,成为制约其广泛应用和可持续性的关键因素。例如,一些先进的智能体产品(如DeepResearch和Manus)虽然展现了令人印象深刻的能力,但由于LLM调用次数过多,导致运营成本高昂,难以大规模部署。

在此背景下,如何平衡智能体系统的效率与效能,成为了一个亟待解决的问题。传统上,NLP领域的研究往往先追求模型规模的扩大以实现性能突破,随后再关注效率、成本和环境影响的优化。然而,随着智能体系统复杂度的增加,这一模式已难以满足实际需求。因此,研究如何在不牺牲性能的前提下降低成本,成为推动智能体系统广泛应用和可持续发展的关键。

研究目的:

本研究旨在通过系统性分析现代智能体系统中的效率与效能权衡关系,为设计高效、低成本的智能体系统提供可行见解。具体而言,研究旨在回答以下三个关键问题:

- 智能体任务本身究竟需要多高的复杂度?

- 在何种情况下,增加额外模块所带来的收益会逐渐减少?

- 通过设计高效的智能体框架,能够提升多少效率?

通过解决这些问题,研究期望开发出一种新型智能体框架,能够在保持高性能的同时显著降低运营成本,从而推动AI驱动解决方案的可及性和可持续性发展。

研究方法

1. 实证分析:

本研究在GAIA基准测试集上进行了广泛的实证分析,评估了不同LLM主干模型、智能体框架设计以及测试时扩展策略对系统效率和性能的影响。GAIA基准测试集是一个具有挑战性的智能体评估平台,要求智能体执行复杂的推理任务以解决问题。

2. 变量控制:

为了准确评估各组件对系统效率和性能的影响,研究建立了默认设置,并逐一改变单个组件进行测试。具体而言,研究控制了以下变量:

- LLM主干模型:评估了包括GPT-4.1、o1、Claude-3.7等专有模型,以及Qwen3-235B-A22B、Qwen3-30B-A3B等开源模型在内的多种LLM。

- 智能体框架设计:包括规划机制、工具使用和记忆模块等。

- 测试时扩展策略:评估了Best-of-N(BoN)等测试时扩展策略对系统性能和效率的影响。

3. 评估指标:

研究采用“通过成本”(cost-of-pass)作为主要评估指标,该指标综合考虑了系统的准确性和计算成本。具体而言,“通过成本”定义为使用模型m解决问题p的预期货币成本,计算公式为:

\[ v(m,p) = \frac{C_m(p)}{R_m(p)} \]

其中,\( C_m(p) \) 为单次推理尝试的成本,\( R_m(p) \) 为成功率。这一指标能够有效量化系统的经济效率。

研究结果

1. LLM主干模型的选择对系统性能和效率有显著影响:

研究发现,高性能的LLM主干模型(如Claude-3.7 Sonnet)虽然准确率较高,但计算成本也显著增加。相比之下,一些轻量级模型(如Qwen3-30B-A3B)在保持较低计算成本的同时,仍能提供可接受的准确率。这表明,在选择LLM主干模型时,需要根据具体任务需求平衡性能和成本。

2. 智能体框架设计对系统效率和性能有重要影响:

- 规划机制:适度的规划复杂度能够显著提升系统性能,但超过一定阈值后,继续增加规划步骤对性能的提升有限,反而会增加计算成本。

- 工具使用:增加搜索源和简化浏览器操作能够显著提升系统效率和性能。具体而言,使用多个搜索源和简单的浏览器操作(如仅检索静态元素)能够在保持较低计算成本的同时,提高信息检索的准确性和效率。

- 记忆模块:简单的记忆设计(如仅保留智能体的观察和行动)在保持较低计算成本的同时,能够提供与复杂记忆设计相当的性能。这表明,在记忆模块设计中,应优先考虑简洁性和有效性。

3. 测试时扩展策略对系统性能和效率的影响有限:

研究发现,增加Best-of-N策略中的N值虽然能够略微提升系统性能,但计算成本显著增加。这表明,测试时扩展策略在提升系统性能方面存在边际效益递减的现象。

4. Efficient Agents框架的开发:

基于上述发现,研究开发了Efficient Agents这一新型智能体框架。该框架通过优化组件选择和设计,实现了性能与成本的最佳平衡。实验结果表明,Efficient Agents在保持96.7%性能的同时,将运营成本降低了28.4%,显著提升了系统的经济效率。

研究局限

尽管本研究在智能体系统的效率与效能权衡方面取得了显著成果,但仍存在以下局限:

1. 基准测试集的局限性:

GAIA基准测试集虽然具有挑战性,但仍可能无法完全覆盖现实世界中的所有复杂场景。因此,研究结果在实际应用中的泛化能力仍需进一步验证。

2. 模型选择的局限性:

本研究评估了多种LLM主干模型,但仍可能存在其他未评估的模型具有更好的性能与成本平衡。未来研究可以进一步扩大模型选择范围,以获得更全面的评估结果。

3. 组件交互的复杂性:

智能体系统中的各组件之间存在复杂的交互作用,本研究虽然通过控制变量法进行了评估,但仍可能无法完全捕捉这些交互作用对系统效率和性能的影响。未来研究可以采用更复杂的实验设计,以深入理解组件之间的交互作用。

未来研究方向

针对本研究的局限性和当前智能体系统的发展趋势,未来研究可以从以下几个方面展开:

1. 扩大基准测试集的应用范围:

未来研究可以在更多样化和复杂的基准测试集上评估智能体系统的效率和性能,以验证研究结果的泛化能力。同时,可以开发新的基准测试集,以更全面地覆盖现实世界中的复杂场景。

2. 探索新的LLM主干模型:

随着LLM技术的不断发展,未来研究可以探索新的LLM主干模型在智能体系统中的应用潜力。特别是那些具有更高性能和更低计算成本的模型,有望进一步提升智能体系统的经济效率。

3. 深入研究组件交互作用:

未来研究可以采用更复杂的实验设计和分析方法,深入研究智能体系统中各组件之间的交互作用。通过理解这些交互作用对系统效率和性能的影响,可以进一步优化智能体框架的设计。

4. 开发自适应智能体框架:

未来研究可以开发能够根据任务需求自适应调整复杂度的智能体框架。这种框架能够在保持高性能的同时,根据任务难度动态调整资源分配,从而进一步提升系统的经济效率。

5. 探索多智能体协作:

未来研究可以探索多智能体协作在复杂任务处理中的应用潜力。通过设计高效的协作机制和通信协议,可以进一步提升智能体系统在处理复杂任务时的效率和性能。

6. 关注可持续性和环境影响:

随着AI技术的广泛应用,其可持续性和环境影响日益受到关注。未来研究可以在智能体系统的设计中融入更多可持续性和环境影响的考量,推动AI技术的绿色发展。例如,通过优化模型结构和计算资源分配,降低智能体系统的能耗和碳排放。

本研究通过系统性分析现代智能体系统中的效率与效能权衡关系,为设计高效、低成本的智能体系统提供了可行见解。未来研究可以在此基础上进一步探索新的研究方向和应用场景,推动AI驱动解决方案的可及性和可持续性发展。