OpenAI隆重推出开源大模型:GPT-OSS

2025年8月5日,OpenAI 在 GitHub 同步发布了其最新开源项目 —— GPT‑OSS。这是自 2019 年 GPT‑2 以来,OpenAI 首次公布具备完整参数的语言模型。

项目地址为: https://github.com/openai/gpt-oss

本次发布包含两个版本:

-

gpt‑oss‑120b:1200 亿参数,支持单张 80GB GPU 运算;

-

gpt‑oss‑20b:200 亿参数,可在消费级设备(16GB 内存以上)本地运行。

| 模型名称 | 层数 | 总参数量 | 每个令牌的活跃参数 | 总专家数 | 每个令牌的活跃专家数 | 上下文长度 |

|---|---|---|---|---|---|---|

| GPT-OSS-120B | 36 | 1170亿 | 51亿 | 128 | 4 | 12.8万 |

| GPT-OSS-20B | 24 | 210亿 | 36亿 | 32 | 4 | 12.8万 |

🧠 模型定位

OpenAI 将 GPT‑OSS 定义为 “开放权重推理模型”(open-weight reasoning models),强调以下特性:

-

支持链式推理(Chain-of-Thought)

-

可在本地离线运行

-

可进行微调(fine-tuning),但不包含原始训练数据

-

不提供训练代码,因此不属于完全开源

模型使用 Apache 2.0 许可证发布,允许商用。

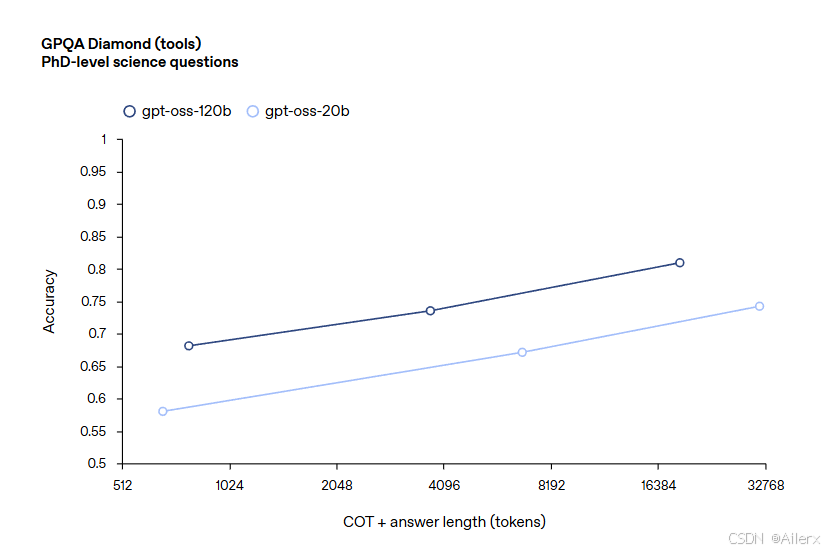

📊 性能表现

根据 OpenAI 提供的内部评估数据:

-

gpt‑oss‑120b 在推理、编程、数学任务中表现与 o4‑mini 接近;

-

gpt‑oss‑20b 表现与 o3‑mini 接近,适用于中小规模部署。

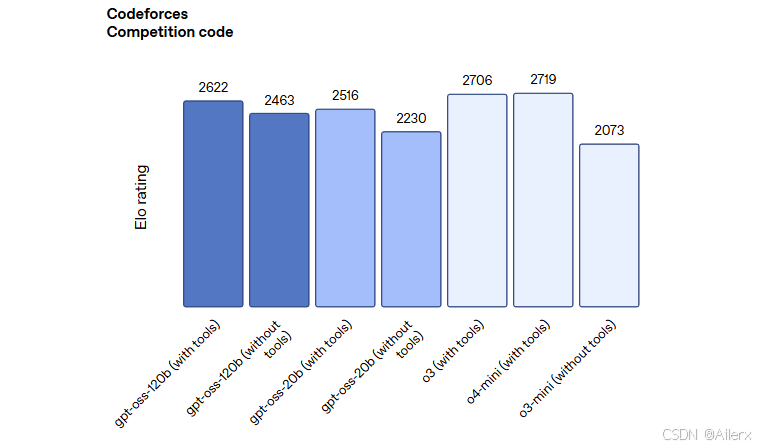

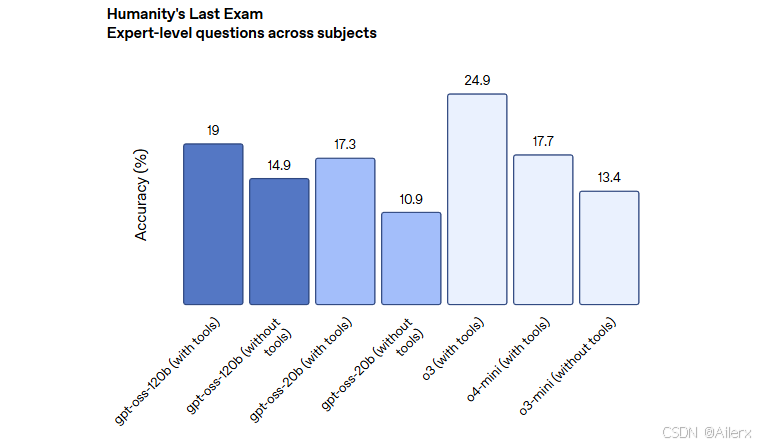

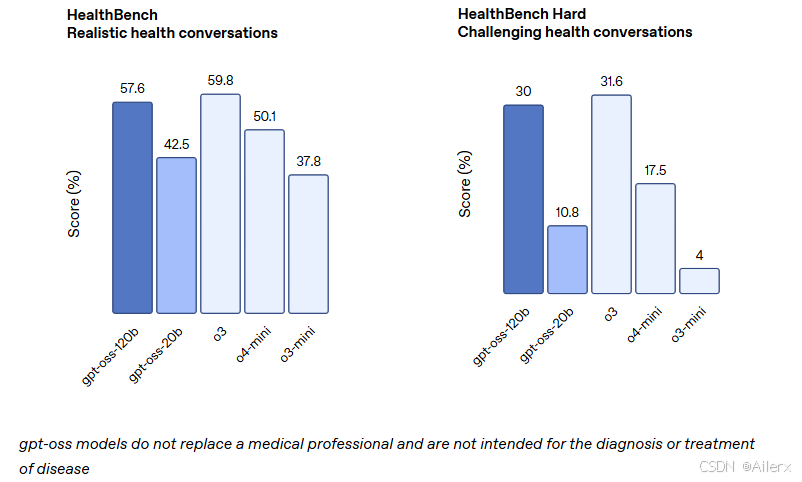

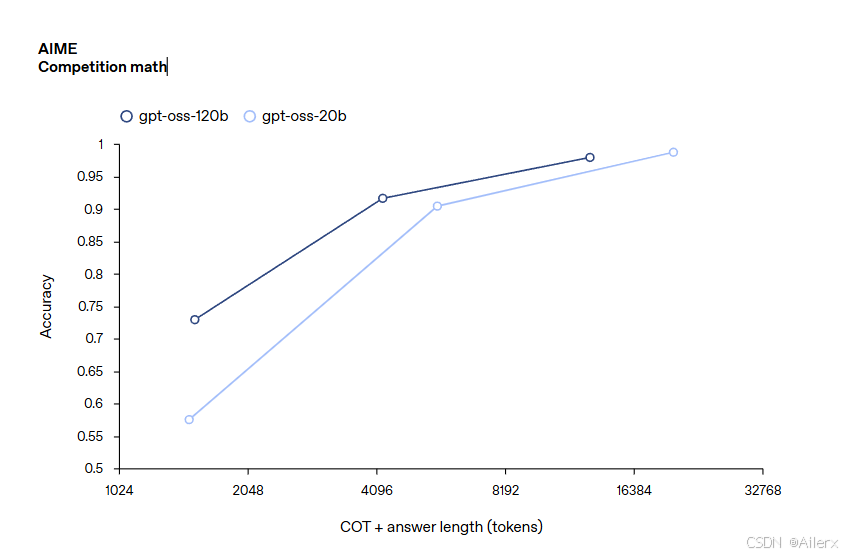

Gpt-oss-120b 在竞赛编程 (Codeforces)、通用问题解决 (MMLU 和 HLE) 以及工具调用 (TauBench) 方面表现优于 OpenAI o3‑mini,并与 OpenAI o4-mini 持平或超越其性能。此外,它在健康相关查询 (HealthBench) 和竞赛数学 (AIME 2024 和 2025) 方面表现得比 o4-mini 更好。尽管 gpt-oss-20b 的规模较小,但在这些相同的评估中,它与 OpenAI o3‑mini 持平或超越后者,甚至在竞赛数学和医疗方面表现得更好

📌 行业背景

当前,Meta(LLaMA)、Mistral、DeepSeek 等公司持续推进开源语言模型,OpenAI 长期坚持闭源政策。此次发布被业内视为其策略上的重要转向,有望在开源生态与产业实践之间寻求更平衡的发展路径。