一种基于潜在表征的轻量级无人机热成像超分辨率网络

A Lightweight Network With Latent Representations for UAV Thermal Image Super-Resolution

摘要

尽管无人机(UAV)热成像技术已取得显著进展,但分辨率不足这一普遍问题仍对热图像内容的理解构成严峻挑战。此外,在资源受限的无人机上部署超分辨率(SR)模型也面临诸多困难。为解决这些挑战,我们提出了一种轻量级热图像超分辨率(LTSR)模型,该模型能高效提取多尺度特征并学习潜在表征。首先,我们构建了一个多尺度知识蒸馏(MSKD)网络,用于从低分辨率(LR)输入中提取具有判别性的特征。为实现这一目标,我们采用不同膨胀率的卷积操作从多样的感受野中提取特征,并通过知识蒸馏对这些特征进行压缩。其次,为在潜在空间中有效建立特征间的连续关系,我们设计了一个包含多次扩散迭代的前向马尔可夫恢复过程。在每次迭代中,我们将轻量级MSKD网络与潜在神经表征整合到一个统一的端到端框架中。在具有挑战性的基准数据集上进行评估时,我们的方法不仅参数更少,而且在超分辨率精度上优于最先进的方法。大量消融分析验证了我们LTSR模型中各组件的有效性。

关键词——潜在表征;多尺度知识蒸馏(MSKD);热图像超分辨率(SR);无人机(UAV)。

1. 引言

在无人机领域,热成像技术能够在恶劣天气和低光照条件下对各类场景进行监测。因此,无人机热成像技术已在多个领域成功应用,包括智慧城市[1]、森林防火[2]和农业生产[3]等。然而,传感器的尺寸限制给无人机获取高分辨率热图像带来了巨大挑战。分辨率不足已成为制约无人机热图像理解的关键问题。

深度学习方法凭借强大的学习能力,在可见光图像超分辨率领域取得了显著进展。近年来的研究[4]、[5]、[6]不仅提升了低分辨率图像的视觉质量,还提高了重建图像在下游任务中的应用价值。尽管多种基于深度学习的方法[7]、[8]、[9]在处理无人机获取的低分辨率可见光资源时取得了令人满意的结果,但研究重点主要集中在可见光图像上,针对热图像的专门研究相对有限。

现有研究[10]、[11]通常需要利用高分辨率可见光图像来指导热图像的超分辨率重建。然而,获取此类指导信息本身存在困难,这使得这些方法不适用于大多数无人机应用场景。从这一角度来看,探索专为热图像超分辨率设计的深度学习方法,在无需先验知识的情况下实现优异的分辨率性能,仍具有重要的研究价值。

另一个值得探讨的问题是如何在资源有限、硬件受限的无人机上部署深度学习模型。从早期的超分辨率网络到近年来的先进架构,随着网络深度的增加,整体性能大幅提升。虽然更深的网络有望实现更高的性能,但其实际应用受到高内存和计算时间需求的限制。

对于可见光图像,神经架构搜索[12]、重参数化[13]和知识蒸馏[14]等策略已被证明能在保持重建质量的同时显著减少模型参数。在各类无人机应用中,轻量级超分辨率模型同样至关重要。我们认为,开发专为热图像设计的轻量级超分辨率模型可从以下三个方面获益:

- 更合理地利用指导信息:考虑到无人机可见光图像与热图像之间密切的空间关系,我们通过一个恢复模型同时优化两者的高分辨率重建。与[10]和[11]不同,该方法促使模型为热图像重建提供更多关于全局拓扑结构和局部纹理细节的线索。

- 更高效地挖掘判别性特征:一种有效的策略是聚合来自多个感受野的特征以增强紧凑性。为捕捉不同感受野的特征,我们采用不同膨胀率的卷积,而非使用不同尺寸的滤波器[15]、[16](这会需要额外的参数)。通过知识蒸馏,我们获得更具判别性的多尺度特征。

- 更全面地建模特征间的连续关系:我们将重建过程简化为一种连续的参数化表征[17]、[18]。在升采样过程中,我们融入多个基于坐标的多层感知器(MLPs)来建立特征间的映射关系。这种方法不仅能实现高保真重建,还能生成任意分辨率的高分辨率图像。

综上所述,本文的主要贡献如下:

- 提出了一种轻量级模型——轻量级热图像超分辨率(LTSR)模型,专为无人机热图像超分辨率设计。在推理过程中,LTSR无需额外先验知识,通过单次前向传播即可生成任意分辨率的高分辨率热图像。

- 构建了多尺度知识蒸馏(MSKD)网络,用于从不同感受野中提取具有判别性的多尺度特征。此外,引入反向马尔可夫恢复过程,助力模型学习潜在特征表征。

- 在基准数据集上的大量实验表明,我们的方法在评估指标和感知质量方面均优于最先进的方法。消融实验进一步验证了LTSR中关键组件的有效性。

本文的其余部分结构如下:第2节简要回顾相关工作;第3节详细描述所提出的方法;第4节进行模型分析并与最先进的方法进行比较;最后,第5节给出结论。

二、相关工作

鉴于与本文研究的相关性,我们将从以下四个角度回顾相关工作。

A. 单图像超分辨率

单图像超分辨率(SISR)是计算机视觉领域的一项经典任务,旨在将低分辨率(LR)图像重建为具有更高视觉质量的高分辨率(HR)图像。SRCNN[19]是一项开创性工作,它首次将卷积神经网络(CNN)引入单图像超分辨率领域,但该网络仅使用浅层网络学习从低分辨率到高分辨率的映射,导致重建精度较低。为了更好地利用深度学习模型的深度优势,Kim等人[20]提出了VDSR,将残差学习引入卷积神经网络,以解决深度网络中的梯度爆炸和收敛困难等问题。随后,许多研究[21]、[22]致力于通过增加网络深度来提升单图像超分辨率性能。以强大的表征能力著称的视觉Transformer[23]已被应用于各种计算机视觉任务。随着Transformer模型[24]、[25]的不断涌现,模型性能得到了进一步提升。然而,这些模型令人印象深刻的表达能力往往伴随着高昂的计算成本。

热像仪能够捕捉人眼不可见的温度变化,在低光照或无光照条件下无需外部照明即可有效工作,且不受环境因素影响。深度学习在单图像超分辨率领域的成功,推动了热图像超分辨率的研究。Choi等人[26]率先将卷积神经网络成功应用于热图像超分辨率任务。Prajapati等人[27]提出了ChasNet,这是一种基于卷积神经网络的框架,用于消除冗余特征。Kasliwal等人[28]引入了一种数据融合框架和正则化技术,用于热图像的引导超分辨率。鉴于无人机热成像的重要应用价值,已有多项研究[10]、[11]提出了专为无人机场景设计的热图像超分辨率方法。在众多应用中,轻量级模型对于无人机热图像单图像超分辨率任务至关重要。

B. 轻量级图像超分辨率

尽管一些单图像超分辨率方法表现出了显著的性能,但由于其计算开销大且参数数量多,在实际应用中难以推广。认识到这些问题后,许多研究人员现在专注于开发用于单图像超分辨率的轻量级模型。Hui等人[29]引入了IMDN来应对这些挑战。Li等人[30]提出了一种线性组装的像素自适应回归方案,将低分辨率到高分辨率的映射转化为线性系数回归问题。Tian等人[31]引入了特征提取块,用于学习和融合来自不同路径的特征。Zhu等人[32]提出了一种期望最大化注意力机制,以实现更好的参数平衡。Li等人[33]提出了一种高效的密集连接蒸馏网络。Huang等人[12]提出了一种可微分神经架构搜索方法,该方法同时使用单元级和网络级搜索空间。Zhang等人[13]提出了一种基于重参数化特征蒸馏网络的遥感图像超分辨率方法。Xie等人[14]引入了更高效的注意力块,以降低计算成本同时提高性能。此外,基于Transformer的单图像超分辨率模型提供了互补的解决方案。例如,Gao等人[34]设计了一种轻量级双模态网络,Choi等人[35]首次将N-Gram上下文引入基于Transformer的低级视觉任务中。对于无人机热图像,探索轻量级超分辨率模型是值得的。在本文中,我们从三个角度进行了全面研究,其见解在第一节中已阐述。

C. 生成式图像超分辨率

许多方法[36]、[37]通过隐式神经表征在连续图像超分辨率方面取得了显著进展。然而,这些方法生成的图像往往存在边缘模糊、细节过度平滑等问题。为了应对这些挑战,生成式图像超分辨率技术应运而生,包括基于生成对抗网络(GAN)的方法、变分自编码器(VAE)和自回归模型(ARM)等,旨在增强图像的精细细节。例如,GLEAN[38]引入了新的结构用于整合语义信息。尽管变分自编码器[39]、[40]结合了归一化流和随机变分推断,具有先进的分布学习能力,但在样本质量上仍不及基于生成对抗网络的方法。另一方面,自回归模型[41]、[42]在学习复杂分布方面表现出强大的性能,但由于训练成本高且顺序采样过程复杂,在处理低分辨率图像时存在局限性。

近年来,扩散模型[43]、[44]、[45]、[46]、[47]在低级视觉任务领域取得了重大进展。Rombach等人[43]基于扩散模型引入了一种交叉注意力条件机制,用于生成高分辨率图像。Chung等人[44]提出了一种基于逆扩散和非扩张映射正则化的磁共振图像去噪方法。Metzger等人[45]将引导各向异性扩散与深度卷积网络相结合,显著改善了大规模分辨率下的图像处理效果。然而,这些方法仍存在一些缺陷,如固定的放大倍数和复杂的两阶段流程。Cui等人[46]结合隐式神经表征和扩散建模的优势,提出了一种元扩散模型来处理高光谱图像。Gao等人[47]使用尺度自适应调整机制来控制生成内容的细节。在本文中,我们提出了一种高效的框架,探索如何使用轻量级网络提取判别性特征。通过有效地利用潜在表征来建模特征关系,该框架旨在使用更小的模型生成具有丰富信息的高分辨率热图像。

三、所提方法

在本节中,我们首先概述所提出的LTSR框架,随后详细介绍多尺度知识蒸馏(MSKD)网络和潜在特征表征。

A. 框架概述

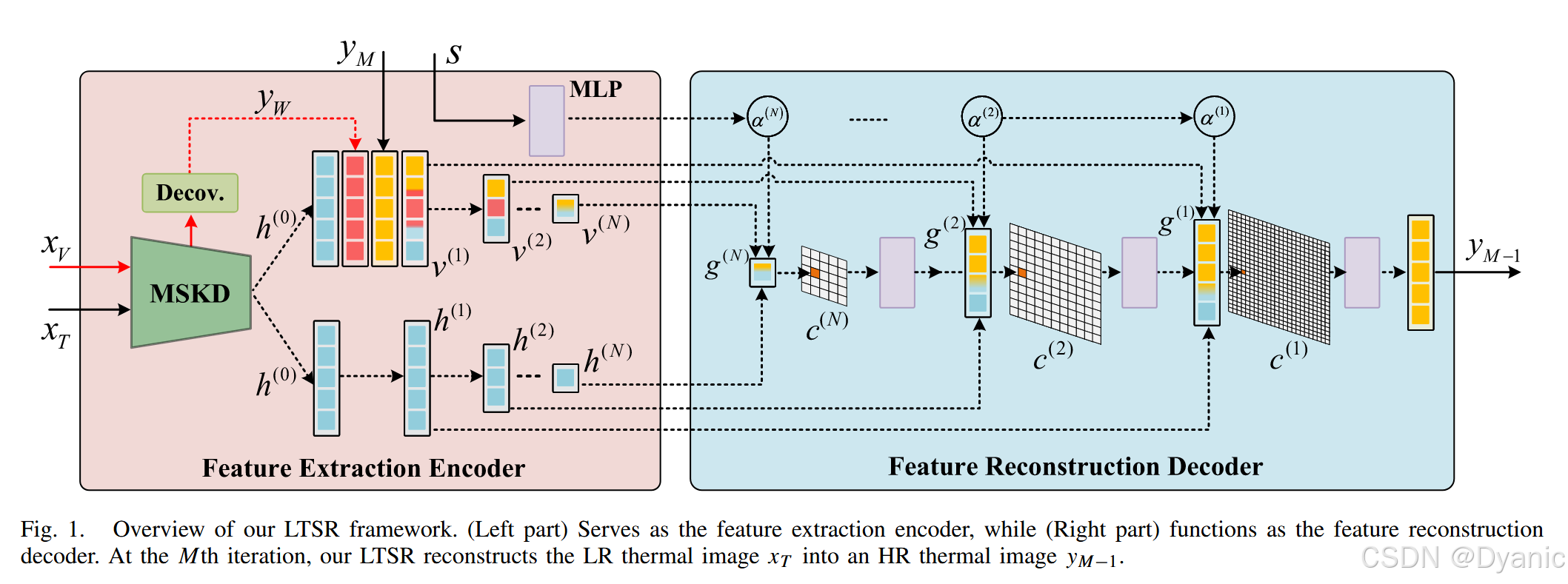

本文提出的LTSR框架如图1所示,该框架由特征提取编码器和特征重建解码器两部分组成。在训练和测试阶段,LTSR需经过M次迭代逐步重建图像xTx_TxT。在第M次迭代中,以低分辨率可见光图像xVx_VxV和热图像xTx_TxT作为输入,生成高分辨率热图像yM−1y_{M-1}yM−1作为输出。

在特征提取编码器中,我们构建了MSKD网络(如图2所示)以提取具有判别性的特征。对于xVx_VxV,经过MSKD网络和反卷积层后,可重建为高分辨率可见光图像yWy_WyW。我们采用均方误差损失约束yWy_WyW的生成,使MSKD具备恢复纹理细节的能力。对于xTx_TxT,通过MSKD网络以无监督方式生成多尺度特征h(0)h^{(0)}h(0)。随后,h(0)h^{(0)}h(0)被送入两个分支,每个分支通过堆叠的N个下采样卷积层提取深层特征。在上分支中,我们从h(0)h^{(0)}h(0)、yWy_WyW和yMy_MyM的组合中提取特征v(n)v^{(n)}v(n);在下分支中,直接从h(0)h^{(0)}h(0)中提取特征h(n)h^{(n)}h(n),其中n=1,2,…,Nn = 1, 2, \ldots, Nn=1,2,…,N。

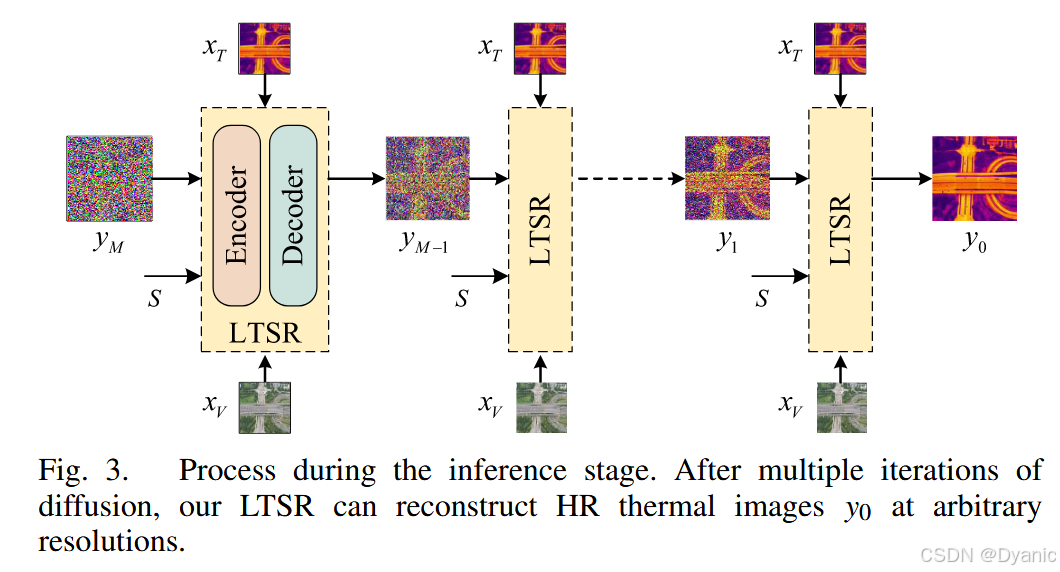

在特征重建解码器中,我们利用潜在特征表征来学习连续的图像表示。我们将缩放因子作为条件融入扩散过程,并通过调制v(n)v^{(n)}v(n)和h(n)h^{(n)}h(n)的尺度sss生成g(n)g^{(n)}g(n)。为了参数化隐式神经表征,我们在g(n)g^{(n)}g(n)的上采样过程中引入多个基于坐标的多层感知器(MLPs),这有助于在连续尺度范围内恢复高分辨率热图像。如图3所示,我们的LTSR经过MMM次迭代后,可将低分辨率输入重建为高分辨率热图像y0y_0y0。

对于热图像超分辨率任务,xTx_TxT实际上是通过对y0y_0y0以缩放因子sss进行下采样而退化得到的,其中sss以连续方式控制目标图像的分辨率。我们的LTSR的优化目标是通过一个长度为M的固定马尔可夫链来学习数据分布P(y∣x)P(y|x)P(y∣x)的参数近似。通过添加高斯噪声实现的前向马尔可夫扩散过程QQQ可定义为:

Q(y1:M∣y0)=∏m=1MQ(ym∣ym−1)(1)Q(y_{1:M}|y_0) = \prod_{m=1}^M Q(y_m|y_{m-1}) \tag{1}Q(y1:M∣y0)=m=1∏MQ(ym∣ym−1)(1)

Q(ym∣ym−1)=N(ym∣1−βmym−1,βmI)(2)Q(y_m|y_{m-1}) = \mathcal{N}(y_m|\sqrt{1 - \beta_m}y_{m-1}, \beta_m I) \tag{2}Q(ym∣ym−1)=N(ym∣1−βmym−1,βmI)(2)

其中,βm\beta_mβm表示第m次迭代中高斯噪声的方差。一旦得到y0y_0y0,我们可以确定ymy_mym的分布如下:

Q(ym∣y0)=N(ym∣γmy0,(1−γm)I)(3)Q(y_m|y_0) = \mathcal{N}(y_m|\sqrt{\gamma_m}y_0, (1 - \gamma_m)I) \tag{3}Q(ym∣y0)=N(ym∣γmy0,(1−γm)I)(3)

其中,γm=∏i=1m(1−βi)\gamma_m = \prod_{i=1}^m (1 - \beta_i)γm=∏i=1m(1−βi)。在逆扩散恢复过程中,我们的LTSR在训练期间学习条件分布Pθ(ym−1∣ym,xT)P_\theta(y_{m-1}|y_m, x_T)Pθ(ym−1∣ym,xT),以顺序重建潜在特征。因此,推理过程可以通过从yM∼N(0,I)y_M \sim \mathcal{N}(0, I)yM∼N(0,I)到目标热图像y0y_0y0的反向马尔可夫过程实现:

Pθ(y0:M∣xT)=P(yM)∏m=1MPθ(ym−1∣ym,xT)(4)P_\theta(y_{0:M}|x_T) = P(y_M) \prod_{m=1}^M P_\theta(y_{m-1}|y_m, x_T) \tag{4}Pθ(y0:M∣xT)=P(yM)m=1∏MPθ(ym−1∣ym,xT)(4)

P(yM)=N(yM∣0,I)(5)P(y_M) = \mathcal{N}(y_M|0, I) \tag{5}P(yM)=N(yM∣0,I)(5)

Pθ(ym−1∣ym,xT)=N(ym−1∣μθ(xT,ym,m),σm2I)(6)P_\theta(y_{m-1}|y_m, x_T) = \mathcal{N}(y_{m-1}|\mu_\theta(x_T, y_m, m), \sigma_m^2 I) \tag{6}Pθ(ym−1∣ym,xT)=N(ym−1∣μθ(xT,ym,m),σm2I)(6)

其中,N(0,I)\mathcal{N}(0, I)N(0,I)表示均值为0、方差为1的标准正态分布,μ\muμ和σ2\sigma^2σ2分别表示噪声的均值和方差。

为此,我们优化LTSR模型ξθ\xi_\thetaξθ,这相当于从带噪目标图像y~m=γmy0+(1−γm)1/2ε\tilde{y}_m = \sqrt{\gamma_m}y_0 + (1 - \gamma_m)^{1/2}\varepsilony~m=γmy0+(1−γm)1/2ε中恢复目标图像y0y_0y0。为了实现分辨率连续的输出,ξθ(xT,m,s,y~m,γm)\xi_\theta(x_T, m, s,\tilde{y}_m, \gamma_m)ξθ(xT,m,s,y~m,γm)应适用于任意尺度,同时确保预测噪声ε\varepsilonε的有效性。因此,我们的LTSR的优化目标可定义为:

E(xT,y)Eε,γm,m,s∥ε−ξθ(xT,m,s,y~m,γm)∥11(7)\mathbb{E}_{(x_T,y)}\mathbb{E}_{\varepsilon, \gamma_m, m, s} \|\varepsilon - \xi_\theta(x_T, m, s, \tilde{y}_m, \gamma_m)\|_1^1 \tag{7}E(xT,y)Eε,γm,m,s∥ε−ξθ(xT,m,s,y~m,γm)∥11(7)

其中,ε∼N(0,I)\varepsilon \sim \mathcal{N}(0, I)ε∼N(0,I),m∼{1,…,M}m \sim \{1, \ldots, M\}m∼{1,…,M},s∼U(1,S]s \sim \mathcal{U}(1, S]s∼U(1,S],SSS表示预定义的最大尺度,(xT,y)(x_T, y)(xT,y)是从低分辨率-高分辨率热图像对的训练集中随机采样的。

B. MSKD网络

近年来,众多多尺度特征提取块被提出并成功应用于图像超分辨率领域。一些方法[15], [16], [48]使用不同尺寸的滤波器从不同感受野中提取特征,为学习低分辨率到高分辨率的映射提供额外线索。然而,大尺寸滤波器的使用会引入大量额外参数。为解决这一问题,一些方法[49], [50]采用膨胀滤波器进行多尺度特征提取。基于此概念,我们开发了一种新颖的MSKD网络,该网络由K个结构相似的轻量级多尺度(LMS)块组成。

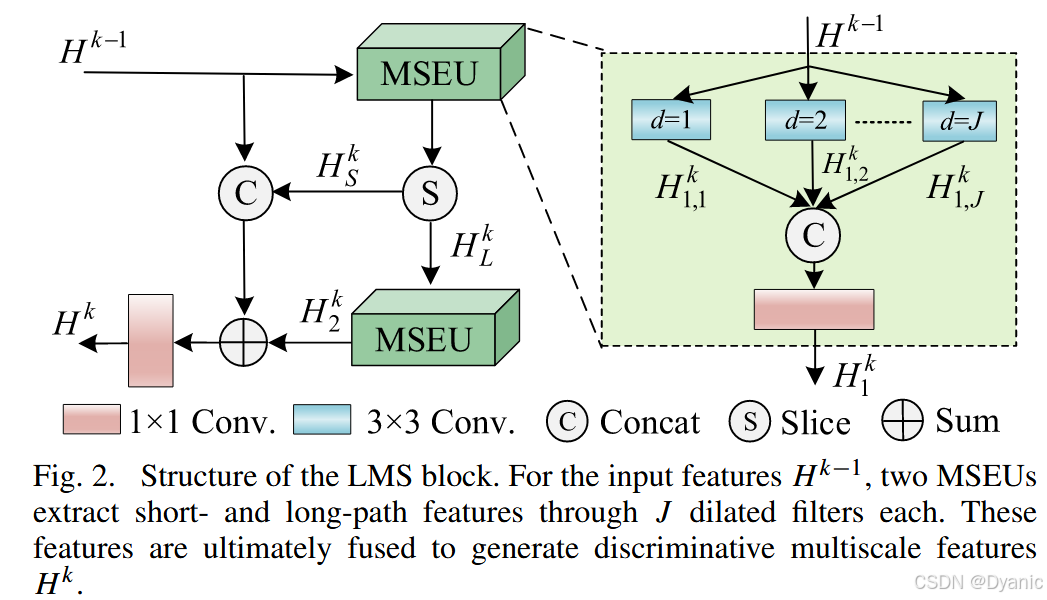

如图2所示,所提出的LMS块包含两个关键组件:1)每个多尺度提取单元(MSEU)内的多尺度特征提取;2)沿着长特征路径和短特征路径的两个MSEU之间的知识蒸馏。在每个LMS块中,“知识”指的是多尺度上下文细节,表明如何在不同感受野之间映射表征。“蒸馏”通过切片操作实现,该操作将来自第一个MSEU的特征分为短路径特征和长路径特征。这种方法帮助模型确定哪些特征(长路径)需要由第二个MSEU进一步提取知识,哪些特征(短路径)应保留以与初始特征融合。

与以往的多尺度块相比,LMS块的改进包括:1)能够使用更多样化的膨胀卷积层,通过消融实验探索更有效的膨胀卷积使用方式;2)利用来自长路径和短路径的知识蒸馏,从而最大限度地利用上下文信息。得益于这些有效的改进,基于LMS块构建的骨干网络可以为特征编码提供更具判别性的特征表示。

如图2(左)所示,LMS块由两个MSEU组成。通过切片操作,我们将来自第一个MSEU的特征图分为两部分:一部分保留为短路径特征,另一部分送入第二个MSEU以提取长路径特征。图2(右)展示了MSEU的结构。最初,使用L个膨胀滤波器从粗到细的感受野中提取特征,每个卷积滤波器的膨胀率为d。随后,将来自不同膨胀滤波器的特征沿通道拼接,最后应用1×1卷积融合多尺度特征。

显然,MSEU之间的知识蒸馏能够探索不同层次的多尺度特征,每个MSEU都能有效挖掘其相应层次的多尺度特征。假设Hk−1H^{k-1}Hk−1表示第k个LMS块的输入特征,则第一个MSEU中膨胀率为j的膨胀滤波器的输出可表示为:

H1,jk=σ(ω1,jk∗Hk−1+b1,jk)(8)H_{1,j}^k = \sigma\left(\omega_{1,j}^k * H^{k-1} + b_{1,j}^k\right) \tag{8}H1,jk=σ(ω1,jk∗Hk−1+b1,jk)(8)

其中,j=1,2,…,Jj = 1, 2, \ldots, Jj=1,2,…,J,ω\omegaω和bbb分别表示相应3×3膨胀滤波器的权重和偏置,σ(⋅)\sigma(\cdot)σ(⋅)表示ReLU激活函数。在将所有滤波器的特征图按通道拼接后,我们使用1×1卷积层进行降维。因此,第一个MSEU的输出可由下式得到:

H1k=ω1(1×1)k[H1,1k,H1,2k,…,H1,Jk]+b1(1×1)k(9)H_1^k = \omega_{1(1\times1)}^k \left[H_{1,1}^k, H_{1,2}^k, \ldots, H_{1,J}^k\right] + b_{1(1\times1)}^k \tag{9}H1k=ω1(1×1)k[H1,1k,H1,2k,…,H1,Jk]+b1(1×1)k(9)

其中,[⋅][\cdot][⋅]表示拼接操作,ω1(1×1)k\omega_{1(1\times1)}^kω1(1×1)k和b1(1×1)kb_{1(1\times1)}^kb1(1×1)k分别表示第kkk个LMS块的第一个MSEU中相应1×1滤波器的权重和偏置。我们使用切片操作将H1kH_1^kH1k沿通道维度分为两部分,分别记为HSkH_S^kHSk和HLkH_L^kHLk。前者表示短路径特征并被保留,后者送入第二个MSEU以提取长路径特征。因此,第二个MSEU中的第j个膨胀滤波器可表示为:

H2,jk=σ(ω2,jk∗HLk+b2,jk)(10)H_{2,j}^k = \sigma\left(\omega_{2,j}^k * H_L^k + b_{2,j}^k\right) \tag{10}H2,jk=σ(ω2,jk∗HLk+b2,jk)(10)

随后,我们以与式(9)相同的方式融合第二个MSEU的多尺度特征,得到长路径特征H2kH_2^kH2k。第kkk个LMS块的输出通过下式获得:

Hk=σ(ω1×1k[HSk,Hk−1+H2k]+b1×1k)(11)H^k = \sigma\left(\omega_{1\times1}^k \left[H_S^k, H^{k-1} + H_2^k\right] + b_{1\times1}^k\right) \tag{11}Hk=σ(ω1×1k[HSk,Hk−1+H2k]+b1×1k)(11)

其中,ω1×1k\omega_{1\times1}^kω1×1k和b1×1kb_{1\times1}^kb1×1k分别表示第k个LMS块中相应1×1滤波器的权重和偏置。

值得注意的是,对于MSKD的第一个LMS块,我们通过两个各配备64个滤波器的3×3卷积层提取其输入特征,这些提取的特征随后在式(8)中被视为Hk−1H^{k-1}Hk−1。对于低分辨率可见光图像,我们通过将MSKD与反卷积层相结合来重建高分辨率图像。对于低分辨率热图像,我们使用通过MSKD提取的更具判别性的特征H0H^0H0用于后续的潜在特征表征。

C. 用于坐标映射的潜在表征

与依赖额外先验的方法[38], [51]不同,我们仅提供编码的多分辨率特征,无需额外先验来建模潜在表征。通过MSKD网络,我们从xTx_TxT中提取初始超分辨率特征,记为h(0)h^{(0)}h(0),并通过双线性插值确保其与yWy_WyW和yMy_MyM的分辨率一致性。随后,h(0)h^{(0)}h(0)被送入两个独立的分支。在上分支中,我们将h(0)h^{(0)}h(0)与yWy_WyW和yMy_MyM拼接,并将结果输入编码器以进行初步的条件引导。同时,在下分支中,h(0)h^{(0)}h(0)直接送入编码器。上分支和下分支中第i个卷积提取的特征分别表示为:v(i)=Conv(i)(…,Conv(1)([h(0),yW,yM]),…)v^{(i)} = \text{Conv}^{(i)}(\ldots, \text{Conv}^{(1)}([h^{(0)}, y_W, y_M]), \ldots)v(i)=Conv(i)(…,Conv(1)([h(0),yW,yM]),…)和h(i)=Conv(i)(…,Conv(1)(h(0)),…)h^{(i)} = \text{Conv}^{(i)}(\ldots, \text{Conv}^{(1)}(h^{(0)}), \ldots)h(i)=Conv(i)(…,Conv(1)(h(0)),…),其中Conv(i)\text{Conv}^{(i)}Conv(i)表示具有双线性滤波下采样操作和Leaky ReLU激活的第iii个卷积层。

为了减轻固定缩放因子的限制,我们在扩散过程中引入sss作为条件,这使得放大倍数具有连续的分辨率。首先,我们定义一个区间(1,S](1, S](1,S],并在训练过程中从该区间随机选择sss。然后,我们基于sss对yMy_MyM进行重塑,以控制生成图像的分辨率。我们通过MLP将sss投影到一组缩放因子α={α1(1),α2(1),…,α1(i),α2(i),…,α1(N),α2(N)}\alpha = \{\alpha_1^{(1)}, \alpha_2^{(1)}, \ldots, \alpha_1^{(i)}, \alpha_2^{(i)}, \ldots, \alpha_1^{(N)}, \alpha_2^{(N)}\}α={α1(1),α2(1),…,α1(i),α2(i),…,α1(N),α2(N)},其中iii表示不同分辨率输出的深度索引。随后,对α1(i)\alpha_1^{(i)}α1(i)和α2(i)\alpha_2^{(i)}α2(i)进行归一化,以调整v(i)v^{(i)}v(i)和h(i)h^{(i)}h(i),过程如下:

α=Reshape(MLP(s))(12)\alpha = \text{Reshape}(\text{MLP}(s)) \tag{12}α=Reshape(MLP(s))(12)

αˉ1(i)=α1(i)α1(i)2+α2(i)2+δ(13)\bar{\alpha} _1^{(i)} = \frac{\alpha_1^{(i)}}{\sqrt{\alpha_1^{(i)2} + \alpha_2^{(i)2} + \delta}} \tag{13}αˉ1(i)=α1(i)2+α2(i)2+δα1(i)(13)

αˉ2(i)=α2(i)α1(i)2+α2(i)2+δ(14)\bar{\alpha} _2^{(i)} = \frac{\alpha_2^{(i)}}{\sqrt{\alpha_1^{(i)2} + \alpha_2^{(i)2} + \delta}} \tag{14}αˉ2(i)=α1(i)2+α2(i)2+δα2(i)(14)

g(i)=αˉ1(i)⋅h(i)+αˉ2(i)⋅v(i)(15)g^{(i)} = \bar{\alpha}_1^{(i)} \cdot h^{(i)} + \bar{\alpha} _2^{(i)} \cdot v^{(i)} \tag{15}g(i)=αˉ1(i)⋅h(i)+αˉ2(i)⋅v(i)(15)

其中,δ\deltaδ设置为1e-8以避免分母为零,g(i)g^{(i)}g(i)表示如图1所示的特征重建解码器的调制结果特征。

借鉴[36]和[47],我们使用隐式神经表征来学习连续的图像表示。在特征上采样中插入多个基于坐标的MLP,以参数化隐式神经表征,从而能够在连续尺度范围内恢复高保真的低分辨率图像。假设连续坐标c={c(1),…,c(i),…,c(N)}c = \{c^{(1)}, \ldots, c^{(i)}, \ldots, c^{(N)}\}c={c(1),…,c(i),…,c(N)}作为多分辨率特征的参考,则目标特征uup(i)u_{\text{up}}^{(i)}uup(i)可以基于当前特征ggg及其相应坐标ccc计算得到。具体过程如下:

uup(i)=Di(g^(i+1),c(i)−c^(i+1))(16)u_{\text{up}}^{(i)} = D_i\left(\hat{g}^{(i+1)}, c^{(i)} - \hat{c}^{(i+1)}\right) \tag{16}uup(i)=Di(g^(i+1),c(i)−c^(i+1))(16)

其中,DiD_iDi是一个隐藏维度为256的两层MLP,g^(i+1)\hat{g}^{(i+1)}g^(i+1)和c^(i+1)\hat{c}^{(i+1)}c^(i+1)分别通过计算第(i+1)层中g(i+1)g^{(i+1)}g(i+1)和c(i+1)c^{(i+1)}c(i+1)之间最近的欧氏距离进行插值得到。如图3所示,我们的LTSR由M次扩散迭代组成,最终将输入重建为高分辨率热图像y0y_0y0。

四、实验

在本节中,我们首先介绍实现细节,然后将所提出的LTSR与最先进的方法进行比较,最后通过消融分析验证关键组件的有效性。

A. 实现细节

-

数据集:我们在无人机基准数据集VGTSR[10]上进行实验,该数据集包含1025对高分辨率热图像及其对应的可见光图像。无人机拍摄的可见光图像和热图像的分辨率分别为1920×1080和640×512,涵盖校园、街景等多种场景。校园图像是在200米飞行高度拍摄的,展示了行人、车辆、植被和道路。街景图像是在500米高度拍摄的,主要呈现建筑物、道路、植被和车辆,由于高度较高,噪声更多。按照标准配置[10],我们使用800对图像进行训练,225对图像进行测试。在实验中,我们使用双三次插值对可见光图像和热图像进行下采样,以获得作为模型输入的低分辨率图像。

-

训练细节:我们在PyTorch框架中使用两块RTX 3090 GPU(每块显存为24 GB)实现所提出的方法。在模型训练过程中,我们最初使用固定的S×下采样尺度,对模型进行了100万次迭代优化。随后,我们又进行了50万次迭代优化,其中高分辨率图像根据均匀分布U(1, S)随机调整大小。在所提出的LTSR网络中,我们使用了4个LMS块,每个MSEU包含6个膨胀层。对于切片操作,我们将通道方向上的特征图平均分为两部分,分别用于提取长路径和短路径特征。我们使用Adam优化器,前100万次迭代的学习率固定为1e-4,其余迭代的学习率为2e-5。

-

评价指标:首先,我们使用基本的视觉质量评估指标[59],包括峰值信噪比(PSNR)和结构相似性(SSIM),来评估重建热图像的质量。这两个指标的值越高,结果越好。按照[10]中的方法,我们还使用了三个无参考图像质量指标,即自然图像质量评估器(NIQE)、基于感知的图像质量评估器(PIQE)和盲/无参考图像空间质量评估器(BRISQUE)。这些无参考指标的值越低,表明重建热图像的视觉质量越好。

B. 与最先进方法的比较

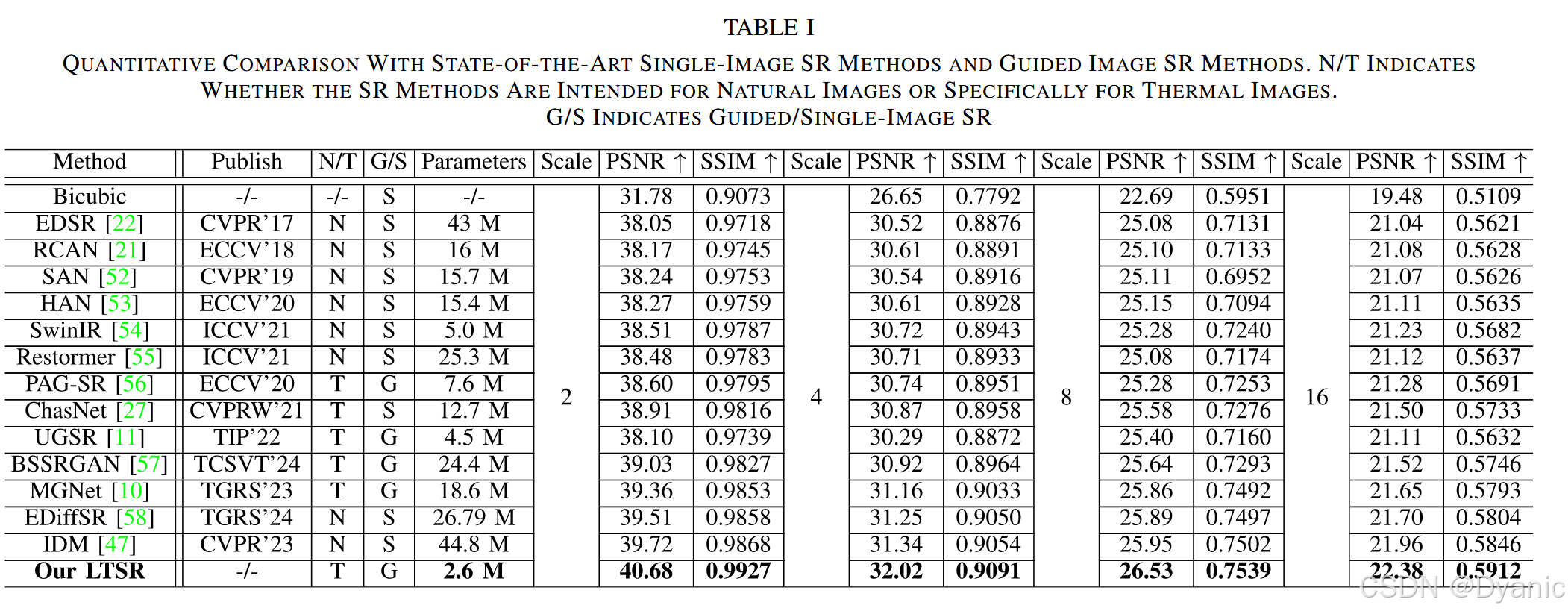

在表I中,我们将所提出的LTSR与基准数据集上的最先进方法进行了比较。比较的方法包括一般的单图像超分辨率方法,如EDSR[22]、RCAN[21]、SAN[52]、HAN[53]、SwinIR[54]和Restormer[55];一种单热图像超分辨率方法ChasNet[27];四种基于引导的热图像超分辨率方法,如PAG-SR[56]、UGSR[11]、BSSRGAN[57]和MGNet[10]。此外,还包括两种基于扩散的方法:EDiffSR[58]和IDM[47]。

如表I中不同尺度的超分辨率结果所示,我们的LTSR优于最先进的方法(即IDM):在2×超分辨率下,PSNR提高了0.96 dB,SSIM提高了0.0059;在4×超分辨率下,PSNR提高了0.68 dB,SSIM提高了0.0037。我们将这种改进归因于三个因素:1)为热图像超分辨率引入了有效的引导信息,在8×超分辨率下,我们的PSNR比MGNet高0.67 dB,在16×超分辨率下高0.73 dB;2)构建了更高效的网络来提取判别性特征,在8×超分辨率下,PSNR比经典的单图像超分辨率方法Restormer高1.45 dB,在16×超分辨率下高1.26 dB;3)使用扩散更有效地建模特征关系,在8×超分辨率下,PSNR比IDM高0.58 dB,在16×超分辨率下高0.42 dB。同时,我们的LTSR仅有260万个参数,明显少于其他方法。

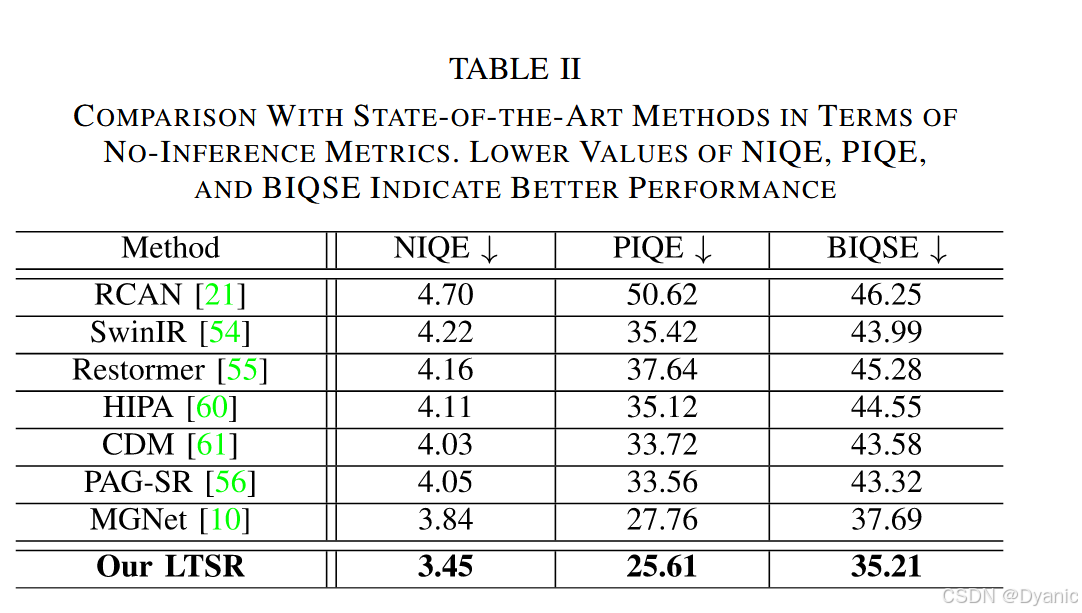

我们在表II中进一步比较了不同方法在无参考图像质量指标上的性能。显然,我们的LTSR在4×和8×尺度上都显著优于其他方法。在图4和图5中,我们提供了使用不同方法的视觉比较结果。可以观察到,其他方法得到的重建热图像可能存在令人难以接受的伪影,且局部纹理显得相对模糊。相比之下,我们的模型恢复出的热图像更清晰、更真实,与目标图像非常接近。这些结果有力地证明了我们方法的有效性。

C. 消融研究

为了实现有效且轻量的热图像超分辨率,我们的研究主要从三个方面展开。我们将通过消融实验依次讨论这三个方面的有效性。

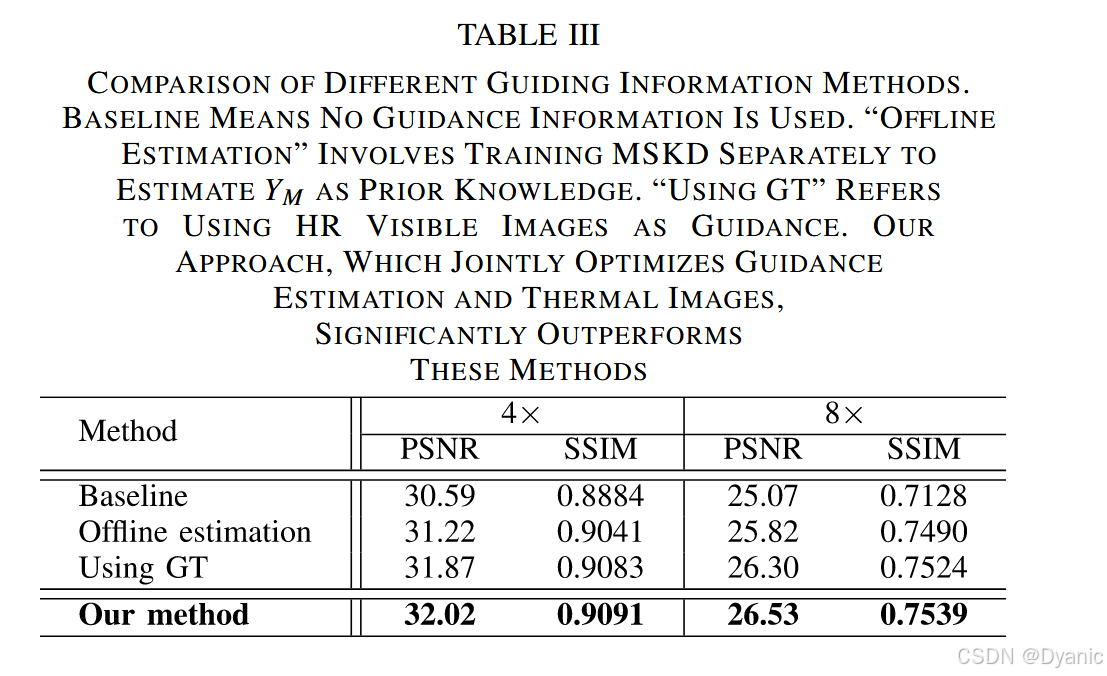

- 引导信息的有效性:我们首先将高分辨率可见光图像作为先验知识融入模型。与以往的方法[10]、[11]不同,我们没有直接获取高分辨率可见光图像,因为在无人机应用中这些图像不易获得。相反,我们使用MSKD网络重建高分辨率可见光图像。这种方法不仅为无监督热图像重建提供了更丰富的纹理细节,还通过与h0和yM融合提供了更多线索。

表III比较了不同引导信息方法在PSNR和SSIM方面的辅助作用。我们可以得出以下结论:1)与基线相比,离线生成引导信息带来了显著的性能提升,表明高分辨率可见光图像能够增强热图像的重建;2)直接使用真实值(GT)作为输入进一步提高了重建精度,说明更准确的引导信息对热图像超分辨率的辅助作用更大;3)联合引导估计和热图像重建使MSKD具备了恢复热图像纹理细节的能力。这不仅使我们的模型更适合实际应用场景,还能重建出更高质量的高分辨率热图像。

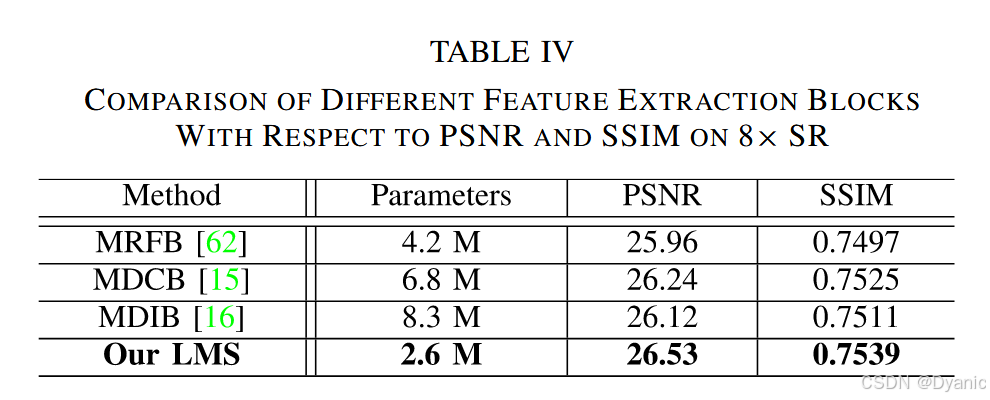

- 特征提取的有效性:我们首先研究了MSKD网络中LMS块的数量(记为K)和每个MSEU的膨胀卷积层数(记为J)的影响。如图6所示,随着K或J的增加,性能不断提高。我们选择K=4和J=6来构建MSKD网络,在精度和速度之间取得平衡。

为了验证有效性和效率,我们在无人机热图像超分辨率任务中,将我们的LMS块与其他特征提取块(即MRFB[62]、MDCB[15]和MDIB[16])进行了全面比较。通过在测试集上进行8×放大,我们在表IV中报告了消耗的内存、PSNR和SSIM。在改变MSKD网络中的特征提取块时,我们保持网络架构不变。表IV的结果表明,我们的LMS不仅参数数量更少,而且在重建精度方面也优于其他特征提取块。

- 潜在表征的有效性:通过特征重建解码器,我们将图像重建过程简化为连续的参数潜在表征。如图7所示,我们可视化了我们的方法和IDM在不同缩放因子值s下的结果,其中真实值的分辨率为32×32。随着相应放大倍数的增加,我们的LTSR能够重建出更真实、更丰富的纹理细节。这是因为缩放因子倾向于在高放大倍数超分辨率上为生成的特征分配更多权重。总体而言,我们使用的潜在表征可以生成任意分辨率的重建图像,并且通过动态调整缩放因子,促进生成更真实的纹理细节。

五、结论

在这项工作中,我们探索了通过融入可见光图像的引导信息来获取高分辨率无人机热图像的可行性。我们提出了一种名为LTSR的方法,专门为无人机热图像超分辨率设计。为了提高其在无人机应用中的适用性,我们致力于同时提高LTSR的处理速度和精度。

LTSR框架包括一个轻量级的MSKD网络,该网络从不同感受野中提取多尺度特征,并通过长路径和短路径对其进行聚合,以最大限度地利用上下文信息。这种方法为热图像超分辨率重建提供了更多线索。我们还集成了反向马尔可夫恢复策略,以逐步重建具有高视觉质量的热图像。

在基准数据集上的大量实验表明,我们的LTSR参数更少,但性能优于最先进的方法。消融研究证明了引导信息和潜在表征的有效性。鉴于无人机场景中更复杂的视觉退化问题,我们计划在未来的工作中专注于开发具有普遍适用性的轻量级无人机视觉恢复模型。