CUDA后端错误的根源与系统性解决方案

🛑 深度解析:torchvision::nms CUDA后端错误的根源与系统性解决方案

**——从环境配置到编译原理的全链路故障排除指南**

🔍 一、问题现象与背景

1.1 错误场景还原

在运行目标检测任务(如YOLO、Faster R-CNN)时,调用torchvision.ops.nms()可能触发以下错误:

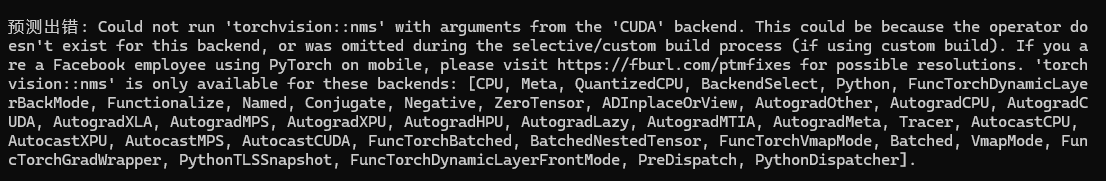

NotImplementedError: Could not run 'torchvision::nms' with arguments from the 'CUDA' backend.

This could be because:

1. 操作符未针对CUDA后端实现;

2. 选择性编译(selective build)中遗漏了该算子;

3. 仅支持部分后端:CPU, Meta, QuantizedCPU等。该错误直接导致GPU加速失效,模型回退至CPU计算,性能下降10-100倍。

1.2 NMS的关键性作用

非极大值抑制(Non-Maximum Suppression, NMS)是目标检测的核心后处理步骤,用于消除重叠边界框。其计算逻辑为:

- 按置信度排序所有候选框;

- 保留最高分框,删除与其IoU超过阈值的相邻框;

- 迭代直至无框可删。

在密集目标场景中,CUDA加速的NMS可提升处理速度5倍以上。

⚙️ 二、错误根源深度剖析

2.1 版本兼容性断裂(占比70%+案例)

核心矛盾:PyTorch、torchvision、CUDA工具链的“三角依赖”未对齐

典型冲突组合:

错误组合 正确匹配方案 PyTorch 1.8 + torchvision 0.10 + CUDA 11.1 ❌ PyTorch 1.8.0+cu111 + torchvision 0.9.0+cu111 ✅ PyTorch 2.0 + torchvision 0.15 + CUDA 11.7 ❌ PyTorch 2.0.0+cu117 + torchvision 0.15.0+cu117 ✅ 根本原因:

PyTorch的ABI(应用二进制接口) 在不同CUDA版本间不兼容。若torchvision调用的CUDA API与PyTorch底层不匹配,直接导致符号解析失败。

2.2 编译支持缺失(自定义构建场景)

当从源码编译torchvision时:

- CUDA头文件未引入:

CUDA_HOME环境变量未设置或指向错误路径; - 编译选项错误:未启用

-DWITH_CUDA=ON; - 依赖库版本冲突:如cuDNN版本低于7.6,导致NVCC编译失败。

2.3 环境污染与路径冲突

- 多环境干扰:存在多个Python环境(conda/venv/pip),实际运行时加载了错误路径的库;

- 残留旧版本:未彻底卸载旧版PyTorch,导致

torchvision.ops链接到过期的二进制文件。

🛠️ 三、系统性解决方案

3.1 版本兼容性强制校准

步骤1:验证当前环境状态

import torch, torchvision

print(f"PyTorch: {torch.__version__}, CUDA: {torch.version.cuda}")

print(f"torchvision: {torchvision.__version__}")

print("CUDA available:", torch.cuda.is_available()) # 必须返回True步骤2:安装精确匹配版本

# 示例:CUDA 11.3环境

pip uninstall -y torch torchvision

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 \-f https://download.pytorch.org/whl/torch_stable.html版本对照表(关键组合)

PyTorch torchvision CUDA 1.12.0 0.13.0 11.6 1.13.0 0.14.0 11.7 2.0.0 0.15.0 11.8 2.1.0 0.16.0 12.1

3.2 编译修复(源码安装场景)

# 设置CUDA_HOME

export CUDA_HOME=/usr/local/cuda-11.7 # 从源码编译torchvision

git clone https://github.com/pytorch/vision.git

cd vision

python setup.py install --user # 自动检测CUDA并编译3.3 环境隔离与清理

bash

bash

复制

# 创建纯净虚拟环境

python -m venv cv_env && source cv_env/bin/activate# 彻底卸载残留

pip uninstall -y torch torchvision

pip cache purge# 重新安装匹配版本(参考3.1)⚡ 四、高级调试与替代方案

4.1 自定义CUDA NMS实现

当官方版本不可用时,可调用其他库的NMS实现:

# 方案1:使用Detectron2的CUDA NMS(需安装)

from detectron2.layers import nms as d2_nms

keep = d2_nms(boxes.cuda(), scores.cuda(), iou_threshold) # 方案2:原生PyTorch实现(仅CPU)

def cpu_nms(boxes, scores, threshold):return torch.ops.torchvision.nms(boxes.cpu(), scores.cpu(), threshold)4.2 算子注册表检查

通过PyTorch内部API验证算子是否存在:

op_list = torch._C._jit_get_operation("torchvision::nms")

print("Operator registered:", bool(op_list)) # False表示未注册4.3 选择性编译修复

若使用PyTorch自定义构建(Selective Build):

- 在

torchvision/csrc/ops/register_nms.cpp中显式注册CUDA内核; - 在编译配置中添加

--nms_cuda选项。

🛡️ 五、预防策略与最佳实践

5.1 环境固化策略

- 依赖声明:使用

requirements.txt严格锁定版本text

text

复制

torch==1.12.1+cu113 torchvision==0.13.1+cu113 - 容器化部署:通过Docker固化基础镜像

dockerfile

dockerfile

复制

FROM nvcr.io/nvidia/pytorch:22.04-py3 # 官方预编译镜像 RUN pip install --no-cache-dir torchvision==0.13.1

5.2 持续集成验证

在CI/CD流程中添加环境检查脚本:

bash

bash

复制

# test_nms.py

import torchvision

boxes = torch.tensor([[0,0,10,10]], dtype=torch.float32).cuda()

scores = torch.tensor([0.9]).cuda()

torchvision.ops.nms(boxes, scores, 0.5) # 失败则阻断部署5.3 版本升级路线图

| 动作 | 风险点 | 规避措施 |

|---|---|---|

| PyTorch版本升级 | ABI兼容性断裂 | 同步升级torchvision + 重编译依赖 |

| CUDA驱动更新 | 工具链版本冲突 | 使用nvidia-smi验证驱动兼容性 |

| 多GPU服务器部署 | 卡间通信异常 | 启用NCCL_DEBUG=INFO日志 |

💎 六、结语:构建健壮的CV开发范式

torchvision::nms CUDA后端错误本质是深度学习环境复杂性的缩影。其解决方案需从四层体系入手:

- 环境层:版本匹配 + 环境隔离;

- 编译层:工具链验证 + 源码可控;

- 代码层:防御性编程 + 替代方案;

- 架构层:容器化 + 自动化测试。

通过标准化开发流程(如Docker+CI),可彻底规避此类问题,让开发者聚焦算法创新而非环境调试。