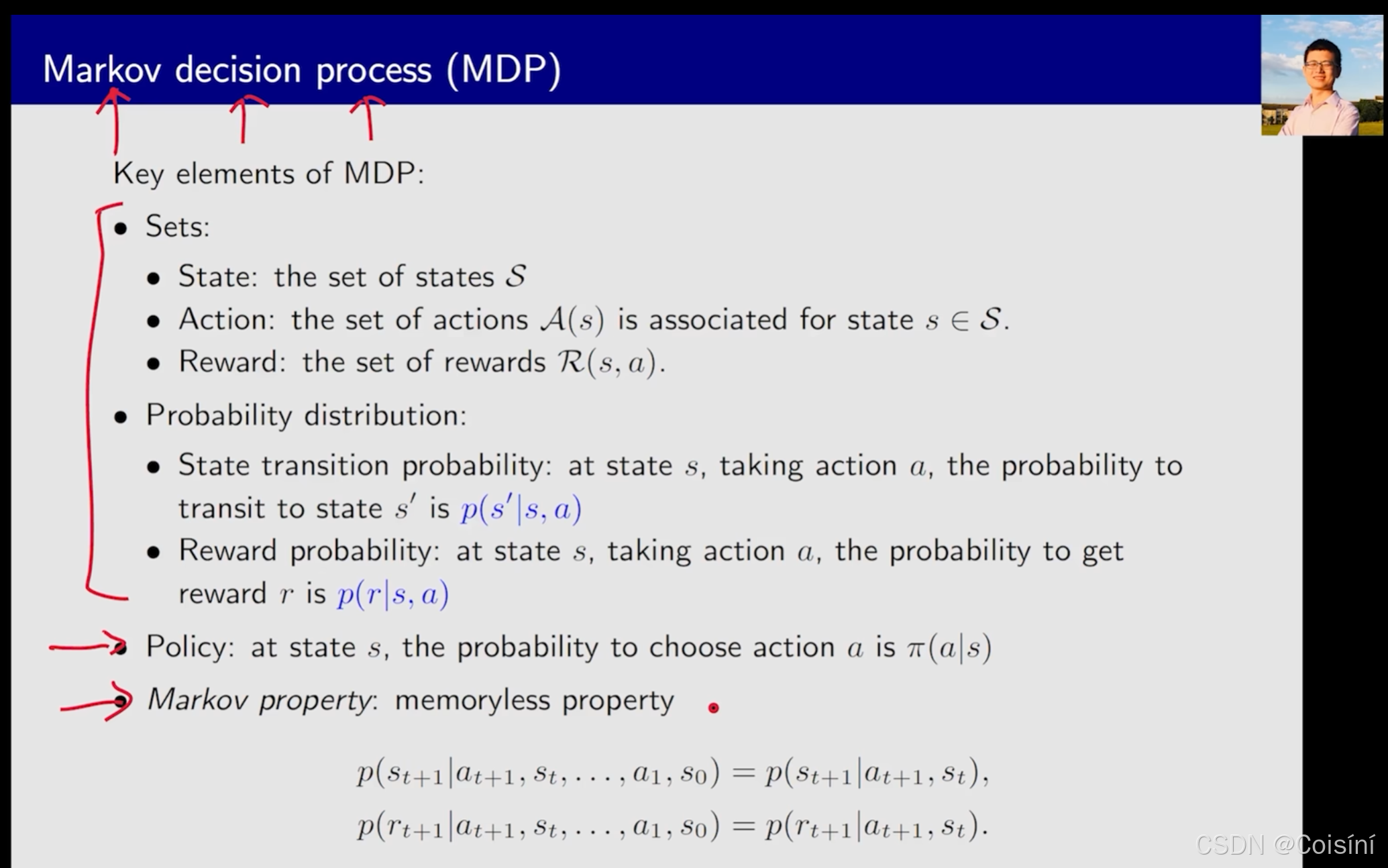

回顾MDP的概念

西湖大学赵世钰老师的课程中讲到如何准确地理解MDP的概念,可以拆分来看:

- Markov:对应了memoryless property,也就是记忆无关性。这也是马尔可夫决策过程的一个重要的性质。

- Decision:对应策略(Policy),因此policy在MDP中起到了决定作用,它描述了整个系统应该朝着什么方向优化。

- Process:对应于{State, Action, Reward}集合以及两个概率分布。其中,两个概率分布包括条件转移概率p(s′∣s,a)p(s'\mid s,a)p(s′∣s,a) 和回报概率 p(r∣s,a)p(r\mid s,a)p(r∣s,a)