信息量,惊奇度,熵、KL散度(相对熵),交叉熵、最大似然估计MLE与最小化交叉熵的等价证明、

一: 一些基本概念

1.1 信息量:特定事件所携带的信息多少

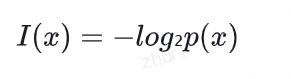

信息量衡量的是特定事件所携带的信息多少,其数学定义为:其中p(x)是事件x发生的概率。

核心思想:越罕见的事件,其携带的信息量越大;越常见的事件,其携带的信息量越小。

例如:

- 如果某事件必然发生(p(x)=1),信息量为0,意味着观察到它不会带来任何新信息

-如果某事件极其罕见(p(x)很小),信息量很大,观察到它提供了大量信息

1.2 惊奇度:观察到某事件时的"意外程度"

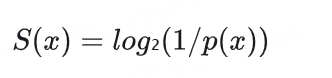

惊奇度表示观察到某事件时的"意外程度",其数学定义为:

核心思想:越意外的事件惊奇度越高,越预期的事件惊奇度越低。

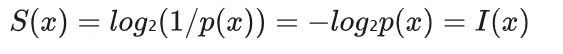

实际上,惊奇度和信息量是完全等价的数学表达式:

信息量强调的是事件所携带的信息内容

惊奇度强调的是事件发生的意外程度

1.3 熵 Entropy:度量随机变量的不确定性

信息论中的基本概念,用于度量随机变量(一个概率分布)的不确定性。

熵的概念可以从信息论角度推导:

- 定义信息量: 对于概率为 p 的事件,其信息量为 I( p )=-log2 ( p)

- 低概率事件携带更多信息(更"意外")

- 高概率事件携带更少信息(更"预期")

1.3.1 定义:熵是平均信息量

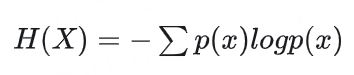

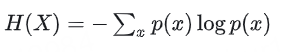

熵是平均信息量:

对于离散随机变量X,其熵定义为:

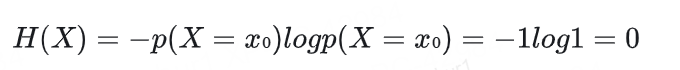

对于一个特例,p(X=x₀)=1,即随机变量 X 确定性地取值为 x₀,我们可以如下推导:

所以,p(X=x₀)=1表示随机变量 X 是一个确定性变量,它总是取值为 x₀,没有任何不确定性。这种情况下:

– 随机变量没有任何随机性

– 系统处于完全确定的状态

– 我们可以100%确定 X 的值熵为0正是反映了这种情况:当系统完全确定(无不确定性)时,熵达到最小值0,不需要任何额外信息就能预测其状态。

二元分布的熵与概率 p

- 横轴是第一个事件发生的概率 p(第二个事件的概率就是 1-p)

- 纵轴是对应的熵值

- 这个图会呈现出一个倒U形曲线,

- 在 p = 0.5 处达到最大值1比特。这是因为:

当 p 接近 0 或 1 时,分布非常不平衡,一个事件几乎必然发生,另一个几乎不可能发生,这种情况下熵接近于0(表示低不确定性)

当 p = 0.5 时,两个事件等可能发生,这是最不确定的情况,熵达到最大值1比特

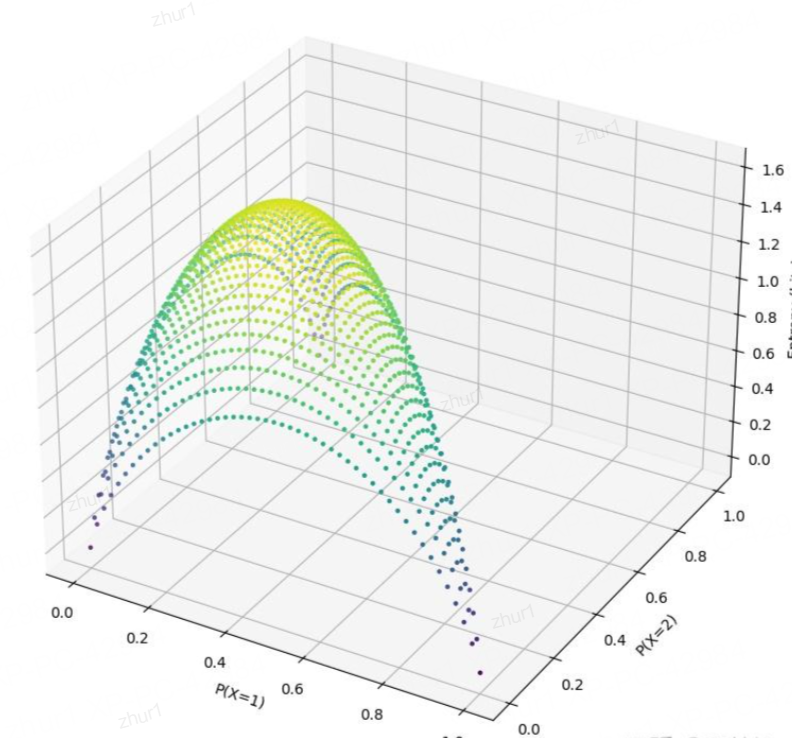

三元分布belike:

- 当分布均匀时(p1=p2=p3=1/3),熵达到最大值 log₂(3) ≈ 1.585 比特

- 当一个概率接近1,其他接近0时,熵接近0

- 当两个概率相等且较大,第三个较小时,熵介于log₂(2)和log₂(3)之间

- 分布越不均匀,熵值越低,表示不确定性越小

自由度解释:

三元分布有两个自由度时:

在一个有n个可能取值的概率分布中,因为所有概率之和必须等于1(∑p_i = 1),所以只有(n-1)个概率值可以自由选择。一旦确定了这(n-1)个值,最后一个值就被约束了。

例如:

二元分布:只有1个自由度。如果p₁ = 0.3,那么必然p₂ = 0.7

三元分布:有2个自由度。如果p₁ = 0.2,p₂ = 0.5,那么必然p₃ = 0.3

1.3.2 熵 Entropy和期望 Expectation

期望是随机变量的平均值或加权平均值,表示随机变量的"中心位置"。

对于离散随机变量 X,其期望定义为:

x 是随机变量 X 可能的取值、p(x) 是 X 取值为 x 的概率

对于连续随机变量 X,其期望定义为:

其中 f(x) 是 X 的概率密度函数。

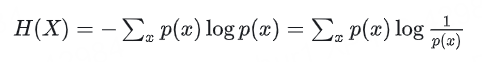

推导过程

第一步:熵的标准定义

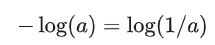

第二步:对数性质的应用

这一步是将负号移入对数内部,使用了对数的基本性质。

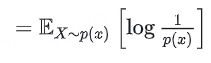

第三步:转换为期望形式

这一步表明熵是随机变量log(1/p(X))关于分布 p(x) 的期望。

熵是随机变量 X的"惊奇度"log2(1/p(X))的平均值。

1/p(x) 越大(即概率越小),惊奇度越高,贡献的信息量也越大。

熵是平均信息量 。换句话说,熵是对随机变量不确定性的平均度量,数学上就是信息量的期望(期望值)

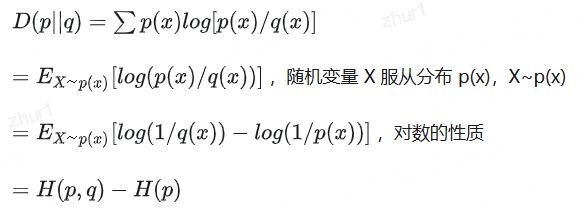

1.4 相对熵(KL散度)

KL散度的定义:

对于未知概率分布p(x),我们用q(x)去逼近p(x),并定义相对熵或称KL散度。

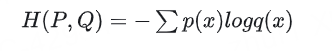

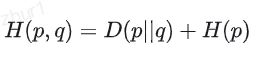

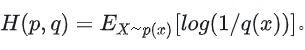

1.5 交叉熵 Cross Entropy:度量两个概率分布之间的差异

交叉熵定义:用于度量两个概率分布之间的差异

所以可以得到

这个公式可以从编码理论角度理解:

- H( p) - 使用最优编码方案(基于真实分布p)对来自分布p的数据进行编码所需的平均比特数

- H(p,q) - 使用基于估计分布q的编码方案对来自真实分布p的数据进行编码所需的平均比特数

- D(p||q) - 使用分布q的编码方案(而非最优编码方案p)所导致的额外编码成本

因此,这个公式表明:交叉熵 = 最优编码长度 + 使用错误分布造成的额外成本

二:从机器学习训练角度理解交叉熵与KL散度

2.1 模型训练目标:

有监督学习中:H( p) 是固定的,等价于最小化 D(p||q)

目标:最小化 p 和 q 之间的差异

在有监督学习中:

H( p)是固定的(取决于真实数据分布)

我们试图最小化H(p,q)(交叉熵损失)

这等价于最小化D(p||q)(KL散度)

p(x) 是数据的真实分布(由标签定义)

q(x) 是模型预测的分布(模型输出)

我们的目标是最小化 p 和 q 之间的差异

2.2 为什么使用交叉熵作为损失函数

最小化交叉熵等价于最大化对数似然

当我们使用交叉熵 H(p,q) 作为损失函数时:

我们实际上是在最小化 D(p||q),因为 H( p) 是固定的

最小化交叉熵等价于最大化对数似然(log-likelihood)

交叉熵容易计算,且梯度性质好

梯度下降最小化交叉熵,D(p||q)→0时,q→p

当我们通过梯度下降最小化交叉熵时:

我们在寻找能够使模型分布q最接近真实分布p的参数

在训练过程中,D(p||q)逐渐减小

理想情况下,当D(p||q)→0时,q→p,模型完美拟合数据

- 训练开始时:

q分布与p分布差异大,D(p||q)值高, 交叉熵损失值大- 训练进行中:

模型更新使q逐渐接近p, D(p||q)逐渐减小, 交叉熵损失逐渐降低

过拟合与正则化

如果模型过度专注于使训练数据的D(p||q)→0,可能会导致过拟合

正则化技术可以理解为对模型分布q施加额外约束,防止其过度拟合训练数据的p

2.3 具体例子

2.3.1 多分类问题

p 是one-hot编码的真实标签 [0,1,0,0,…]

q 是模型输出的softmax概率 [0.1,0.7,0.05,…]

交叉熵损失: H(p,q) = -∑p(x)log q(x)

因为p是one-hot编码,这简化为: -log q(正确类别)

2.3.2 在语言模型训练中

p是下一个token的真实分布

q是模型预测的下一个token的概率分布

最小化H(p,q)使模型预测分布尽可能接近真实分布

这种框架不仅解释了为什么交叉熵是首选损失函数,还帮助我们理解模型训练的本质:让模型分布逐渐接近数据真实分布的过程。

它帮助我们让模型分布q尽可能接近真实分布p,当q完全匹配p时,KL散度为0,交叉熵达到理论最小值H§ 。

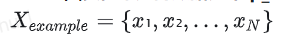

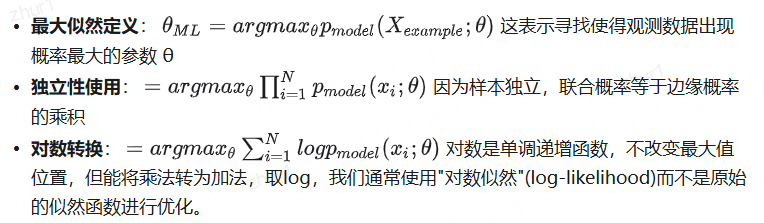

2.4 最大似然估计 MLE

最大似然估计是统计学习的核心原理,

MLE的本质:找到一组参数使模型生成观测数据的概率最大

基本概念

我们从真实但未知的数据分布 p_data(x) 中采样得到数据集

每个样本 x_i 都是独立同分布(i.i.d.)的

目标是估计模型参数 θ,使得模型分布Pmodel (x; θ)最接近真实分布

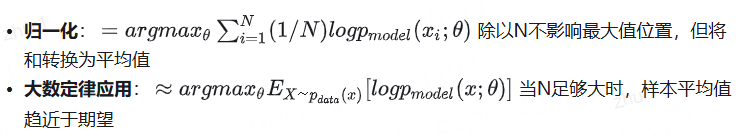

2.4.1 推导过程解析:MLE与交叉熵

这一步是对目标函数(也就是似然函数)取对数。这样做的原因是:

这一步是对目标函数(也就是似然函数)取对数。这样做的原因是:

- 对数是单调递增函数,所以最大化一个函数和最大化这个函数的对数是等价的,不会改变最大值对应的参数θ

- 将乘积转换为求和,计算上更加方便,特别是当我们需要计算导数时

- 避免数值计算中的下溢问题。直接计算很多小概率的乘积容易导致数值变得极小,超出计算机的表示范围

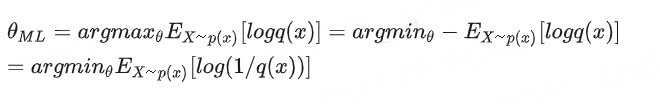

当我们将 p_model(x; θ) 记为 q(x),将 p_data(x) 记为 p(x) 时:

这最后一步正是最小化交叉熵

2.4.2 MLE的与交叉熵的等价性,

最小化交叉熵也等价于最小化KL散度

- MLE的本质

找到一组参数使模型生成观测数据的概率最大- 与交叉熵的等价性:

最大化似然等价于最小化真实分布与模型分布之间的交叉熵- 与KL散度的关系:

由于H(p,q) = H§ + D(p||q),而H§是常数,最小化交叉熵也等价于最小化KL散度- 实际应用:

这就是为什么在神经网络等模型训练中,我们使用交叉熵作为损失函数 - 它直接对应于最大似然估计原则