【论文阅读|V2M: VISUAL 2-DIMENSIONAL MAMBA FOR IMAGE REPRESENTATION LEARNING】

论文题目:V2M: VISUAL 2-DIMENSIONAL MAMBA FOR IMAGE REPRESENTATION LEARNING

年份:2024

期刊会议: arXiv

代码链接:https://github.com/wangck20/V2M

目录

-

- 现阶段存在的问题

-

-

- 1. 二维结构信息丢失

- 2. 一维 Mamba 架构的局限性

- 3. 提升视觉任务表现

- 相关研究

-

- 方法

-

-

-

- 二维状态空间模型设计:

-

- V2M流程

- 1. 输入与预处理

- 2. 四向旋转

- 3. 2D 状态空间模型 (2D SSM) 计算

- 4. 水平方向隐状态拆解与并行计算

- 5. 输入变换与拼接

- 6. 2D SSM输出拼接与旋转复原

- 7. 最终输出

- 实验

-

- 分类任务

- 消融实验

-

- 理论分析

-

现阶段存在的问题

Visual 2-Dimensional Mamba(V2M)提出的核心目的在于为视觉任务设计一种保留二维结构信息、同时具有高效状态空间建模能力的新型视觉骨干网络。其主要解决的痛点包括:

1. 二维结构信息丢失

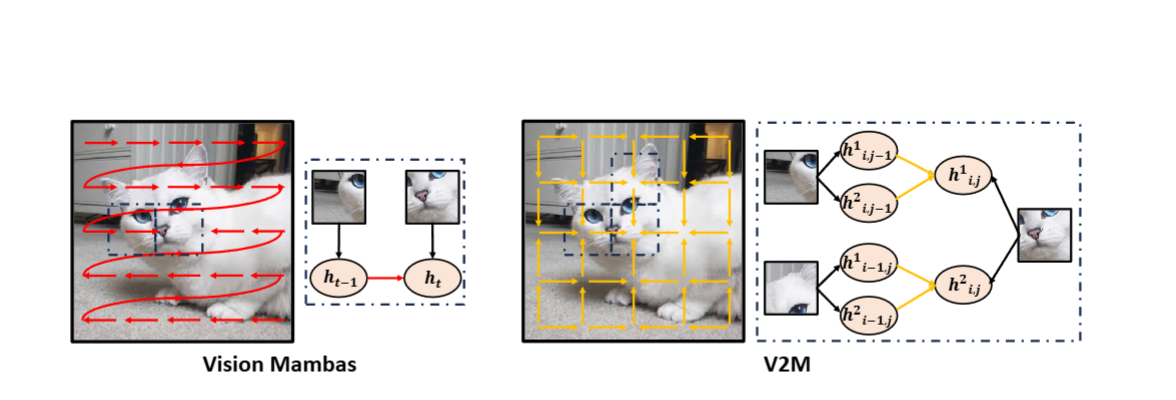

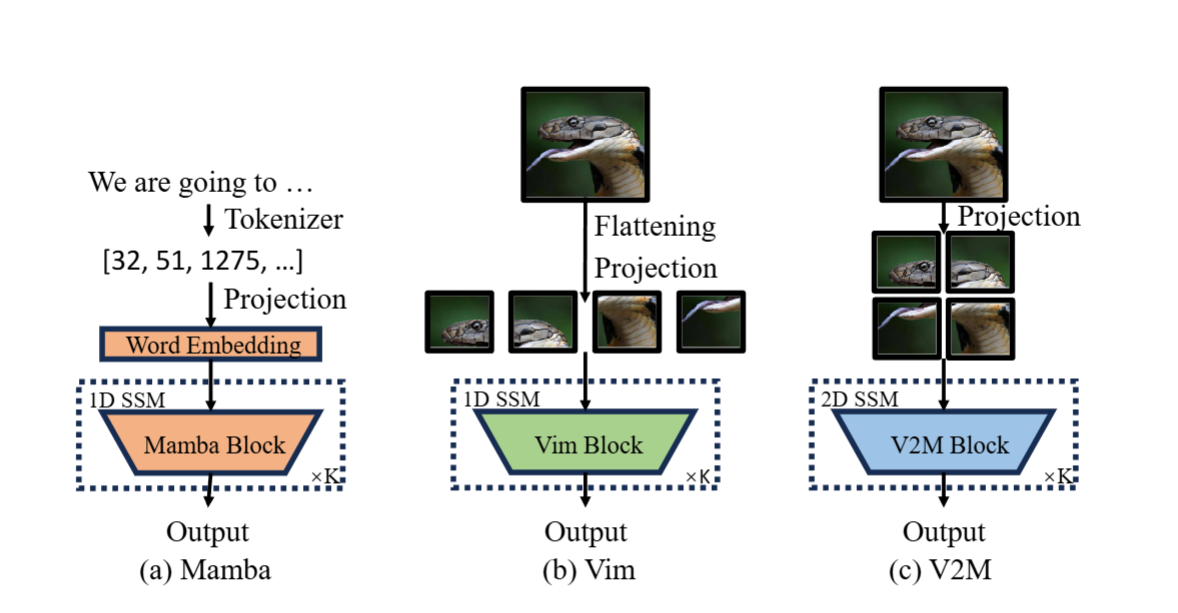

- 问题:传统 Mamba 属于一维序列模型,视觉任务通常将图像切成 patch,并展平成序列输入,这破坏了图像的二维局部结构(如邻域相关性)。

- 解决方案:V2M 将 SSM 从 1D 扩展至 2D,直接在二维网格上对状态进行递推,分别从行和列方向考虑邻接状态,保持局部空间结构。

2. 一维 Mamba 架构的局限性

- 问题:即使采用多种扫描策略,1D Mamba 仍难以重构原始二维空间关系。

- 解决方案:V2M 使用二维状态方程,以更加自然的方式在二维栅格上传播状态(从四个角开始),避免长路径扫描对空间连贯性的破坏。

3. 提升视觉任务表现

- 问题:1D Mamba 无法充分利用图像的二维结构表示。

- 解决方案:V2M 通过二维 SSM 建模,提升模型对局部与全局视觉信息的捕捉能力,在 ImageNet、COCO、ADE20K 等任务上超越基线模型。

相关研究

- CNN 系列:ResNet、RegNet 等

- Vision Transformers:ViT、Swin Transformer

- Visual-Mamba 系列:Vim(Zhu et al., 2024)、LocalMamba(Huang et al., 2024)

- 状态空间模型(SSM):S4 (Gu et al.,2021a)、Mamba (Gu & Dao,2023)

- 二维 SSM 基础:Roesser Model (Kung et al.,1977)

- 视觉表示学习:

- 监督:ResNet,MoCo 等

- 自监督:MAE、SimCLR、BYOL 等

方法

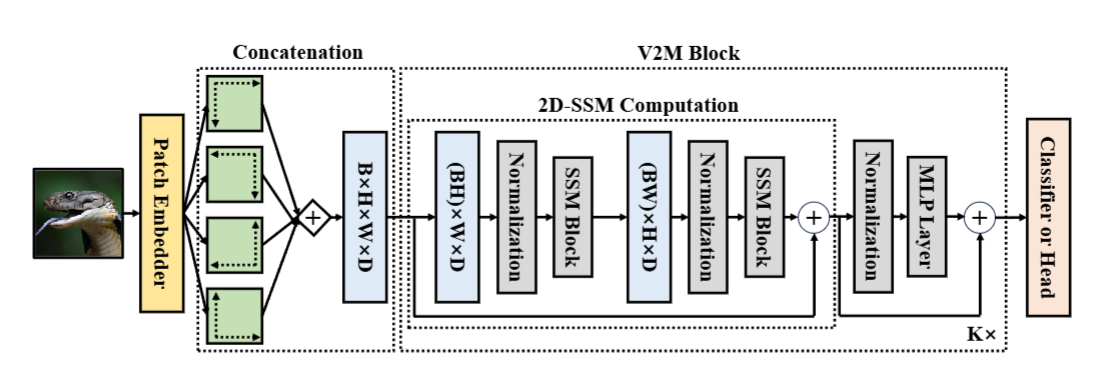

二维状态空间模型设计:

二维状态更新方程如下:

{ h 1 i , j + 1 = A 1 h 1 i , j + A 3 h 2 i , j + B 1 x i , j h 2 i + 1 , j = A 2 h 1 i , j + A 4 h 2 i , j + B 2 x i , j y i , j = C 1 h 1 i , j + C 2 h 2 i , j \begin{cases} h_1^{i,j+1} = A_1 h_1^{i,j} + A_3 h_2^{i,j} + B_1 x_{i,j} \\ h_2^{i+1,j} = A_2 h_1^{i,j} + A_4 h_2^{i,j} + B_2 x_{i,j} \\ y_{i,j} = C_1 h_1^{i,j} + C_2 h_2^{i,j} \end{cases} ⎩ ⎨ ⎧h1i,j+1=A1h1i,j+A3h2i,j+B1xi,jh2i+1,j=A2h1i,j+A4h2i,j+B2xi,jyi,j=C1h