yolo为什么可以作为目标检测框架?它的底层原理是什么?

YOLO作为目标检测框架的核心优势

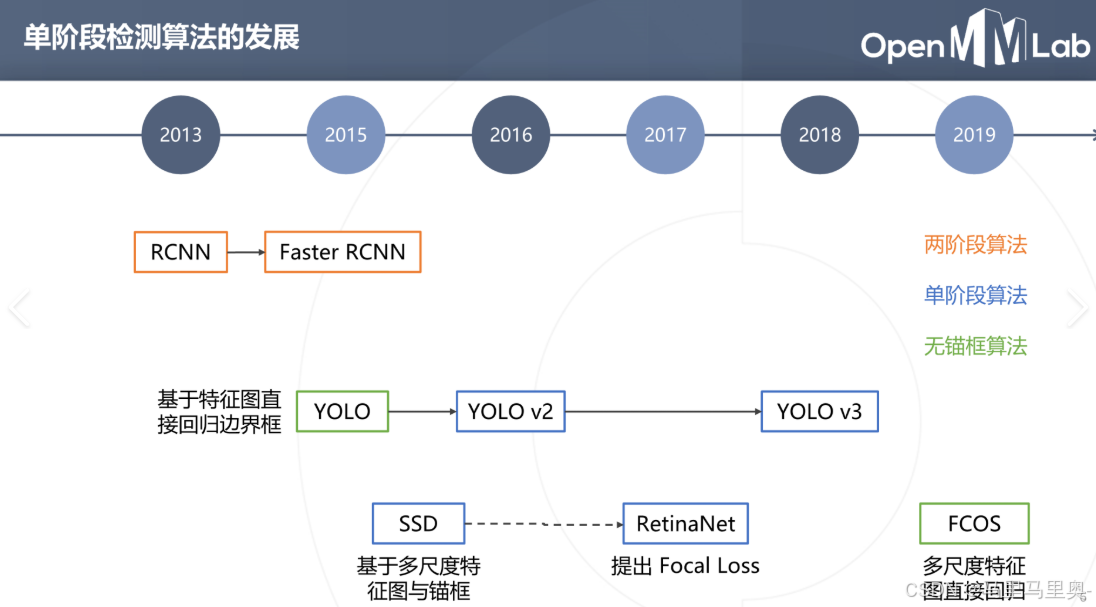

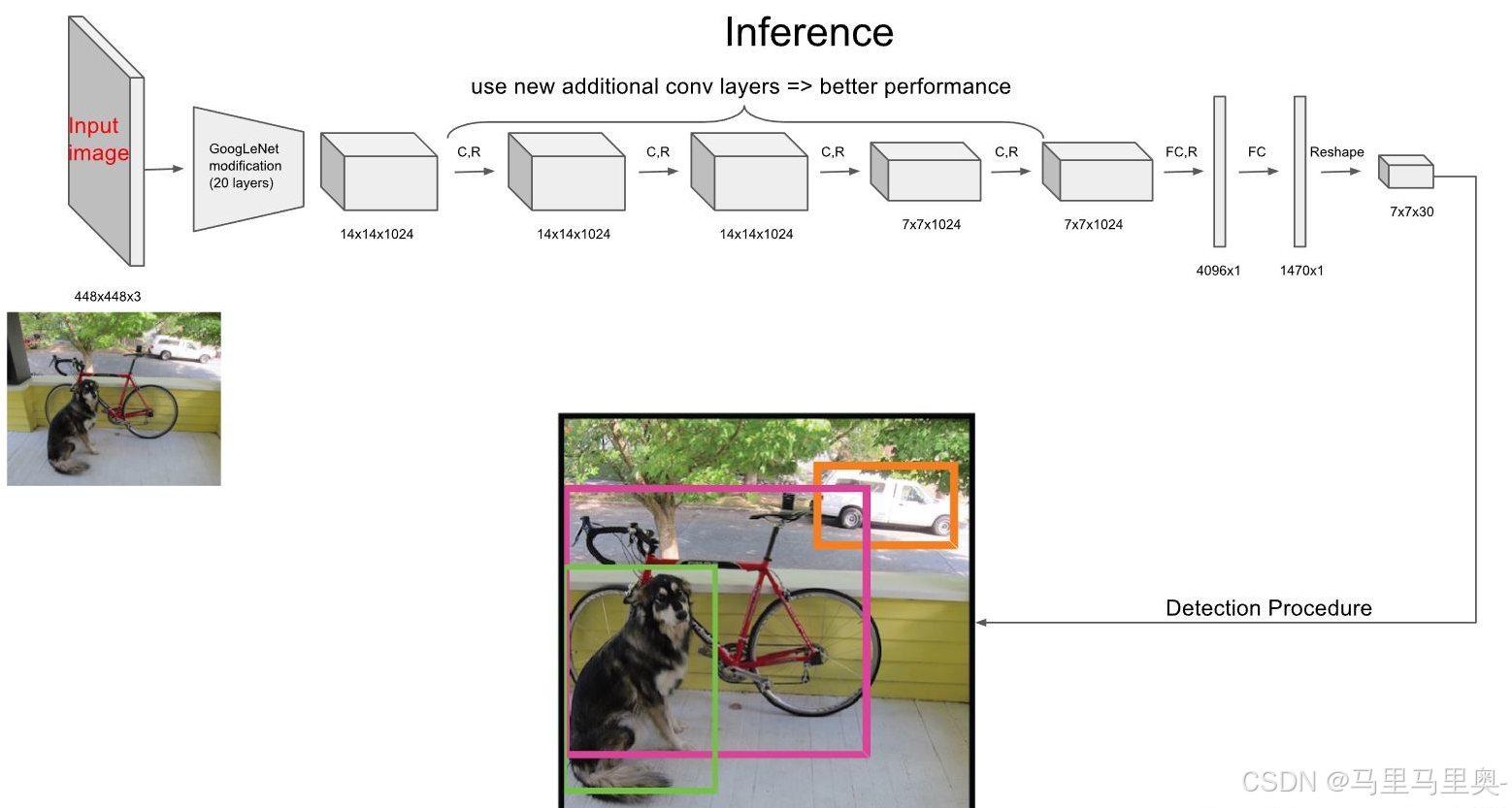

YOLO(You Only Look Once)是一种单阶段目标检测算法,其核心优势在于速度和精度的平衡。传统目标检测方法如R-CNN系列需要生成候选区域再分类,而YOLO将目标检测视为回归问题,直接在单次网络前向传播中预测边界框和类别概率。这种设计使得YOLO能够实现端到端训练,在保持较高检测精度的同时达到实时性能。

YOLO的架构通常由三部分组成:骨干网络(如Darknet)、特征金字塔网络(FPN)和检测头。骨干网络负责提取图像特征,FPN融合多尺度特征以适应不同大小的目标,检测头则输出最终的预测结果。这种设计在速度和精度之间取得了良好平衡。

YOLO的底层原理剖析

YOLO的核心思想是将输入图像划分为S×S的网格,每个网格负责预测B个边界框。每个边界框包含5个预测值:x、y、w、h和置信度。x和y表示边界框中心相对于网格单元的偏移量,w和h表示边界框相对于整个图像的宽度和高度,置信度反映边界框包含目标的可能性。

目标检测的损失函数由三部分组成:定位损失、置信度损失和分类损失。定位损失采用均方误差衡量预测框与真实框的差异,置信度损失使用交叉熵衡量目标存在的置信度,分类损失同样采用交叉熵衡量类别预测的准确性。

# YOLOv3的损失函数示例

def yolo_loss(y_true, y_pred):# 解析预测和真实值pred_box = y_pred[..., :4]pred_conf = y_pred[..., 4:5]pred_class = y_pred[..., 5:]true_box = y_true[..., :4]true_conf = y_true[..., 4:5]true_class = y_true[..., 5:]# 计算定位损失box_loss = K.sum(true_conf * K.square(true_box - pred_box))# 计算置信度损失conf_loss = K.binary_crossentropy(true_conf, pred_conf)# 计算分类损失class_loss = K.binary_crossentropy(true_class, pred_class)return box_loss + conf_loss + class_loss

YOLO的架构演进与创新

从YOLOv1到最新的YOLOv12,架构不断演进。YOLOv3引入特征金字塔网络(FPN)实现多尺度预测,显著提升了小目标检测能力。YOLOv4则通过引入CSPDarknet53骨干网络、Mish激活函数和SPP模块等创新进一步提升了性能。

YOLOv5采用自适应锚框计算和自动学习数据增强策略,简化了训练流程。YOLOv6和YOLOv7在骨干网络和特征融合方式上做出改进,而YOLOv8则引入更高效的网络结构和训练策略。

YOLO与其他检测框架的对比

与两阶段检测器(如Faster R-CNN)相比,YOLO在速度上具有明显优势,但在小目标检测精度上可能稍逊。与同为单阶段检测器的SSD相比,YOLO的特征融合策略通常更加有效。最新版本的YOLO在精度上已经能够与许多两阶段检测器媲美,同时保持实时性能。

YOLO的实际应用示例

YOLO广泛应用于实时视频分析、自动驾驶、工业检测等领域。以下是一个使用YOLOv5进行目标检测的简单示例:

import torch# 加载预训练模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s', pretrained=True)# 推理

img = 'https://ultralytics.com/images/zidane.jpg'

results = model(img)# 显示结果

results.print()

results.show()

最终预测过程如下:

对于每个锚框,计算各个类别的得分:类别概率×置信度设定一个得分阈值(如0.24),筛选出得分超过阈值的边界框使用非极大值抑制(NMS)进一步去除冗余框举个例子,假设一个网格内有5个锚框,它们对一张猫的图片的预测如下:

- 锚框1:置信度=0.8,类别=[猫:0.9, 狗:0.05, 鸟:0.05] 得分=[猫:0.72, 狗:0.04, 鸟:0.04]

- 锚框2:置信度=0.7,类别=[猫:0.8, 狗:0.1, 鸟:0.1] 得分=[猫:0.56, 狗:0.07, 鸟:0.07]

- 锚框3:置信度=0.3,类别=[猫:0.4, 狗:0.3, 鸟:0.3] 得分=[猫:0.12, 狗:0.09, 鸟:0.09]

- 锚框4:置信度=0.2,类别=[猫:0.3, 狗:0.6, 鸟:0.1] 得分=[猫:0.06, 狗:0.12, 鸟:0.02]

- 锚框5:置信度=0.6,类别=[猫:0.85, 狗:0.1, 鸟:0.05] 得分=[猫:0.51, 狗:0.06, 鸟:0.03]

应用阈值过滤后,我们得到三个候选框:

- 锚框1:猫,得分0.72

- 锚框2:猫,得分0.56

- 锚框5:猫,得分0.51

然后应用NMS(只去除对同一物体的多个预测,不同物体的预测会被保留):选择得分最高的锚框1作为参考计算锚框1与其他锚框的IoU如果IoU大于阈值(如0.5)且两者是同一个类别,则删除该锚框可能会删除锚框2和锚框5(如果它们与锚框1重叠很大)

YOLO的未来发展方向

YOLO系列仍在持续进化,未来可能的发展方向包括:更轻量化的网络设计、更高效的特征融合策略、自监督预训练方法的引入,以及与其他模态(如点云、文本)的融合。这些改进将进一步提升YOLO在复杂场景下的检测性能。