3. 卷积网络代码参数解读分析

1. 构建卷积神经网络

这里并不是实际的案例,这篇是讲一下卷积中的参数、分别有什么意义、对结果有什么影响,巩固一下对卷积的理解。

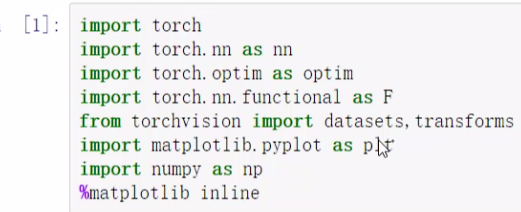

1.1 数据、参数

datesets中有一些数据集可以直接用,transforms可以用来做一些预处理(数据转换成 tensor...)

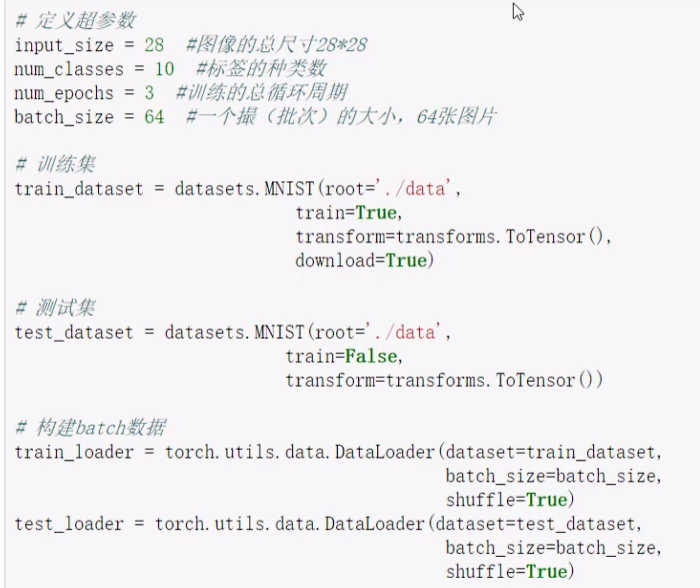

由于输入是灰度图像,做CNN卷积,所以 batch*1*28*28,之前的那个里是做全连接,batch*784。

之前的784个像素点,在全连接网络看来是没有关系的;但是在卷积中,我们是一个一个窗口算的,肯定会综合考虑窗口中像素点的关系,这种肯定更加合理,卷积网络更适合处理我们的数据。

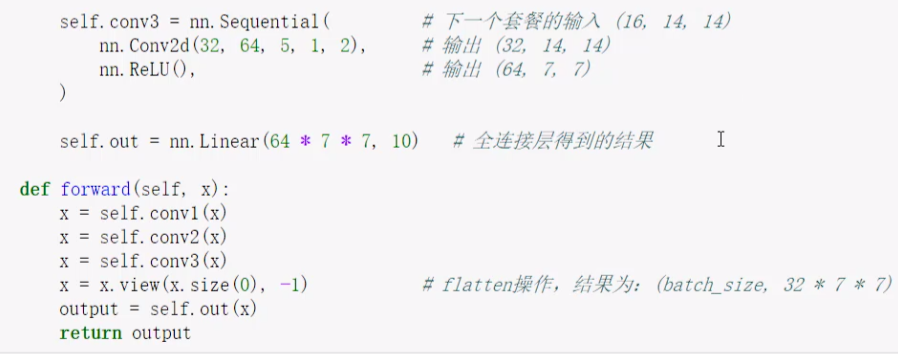

1.2 卷积网络模块构建

以后都是用现成的包,现在详细展开一下:

在一个 conv1 的 sequential 中

- nn.Conv2d就是用2d的卷积(图像任务),3d就是视频数据(很多张图像--时间维度),1d就是对结构化数据处理。

- nn.Conv2d 用的时候需要一些参数,如上图conv1中的。

- in_channels:刚开始输入的channel,RGB就是3,灰度就是1

。始终表示“进入这个卷积层(或卷积块)的特征图(channels)数量” - out_channels:卷积核的个数,输出特征图的个数

- kernel_size:3*3,5*5都行,小一点比较好

- stride:滑动窗口平移的单元格个数

- padding:对边界进行一个填充,为几就加几圈0,输出和输入的大小保持一致就靠这个padding; kernal_size==5 <=> padding==2; kernal_size==3 <=> padding==1。

- in_channels:刚开始输入的channel,RGB就是3,灰度就是1

- Relu,无论是全连接还是卷积,做一次特征提取后,都要做一次这个

- MaxPooling:做压缩,把特征图大小压一半。只会改特征图大小,数量不变。

这里的 conv 并不是单纯指“一个卷积层”(Conv2d),而是一个 “卷积块”(convolutional block)——它封装了一系列按顺序执行的操作。

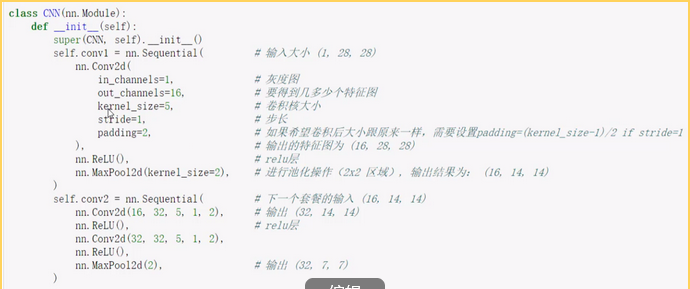

现在能得到特征了,我们最后要做分类,分出属于10个类别的概率。

做分类是wx+b的一个过程,我们得到的特征图并不是特征,要想办法把特征图转化成特征。

把特征图做一个拉长:64*7*7 的特征,然后做10分类

3个卷积块走完之后,还做了一个view,这个view和reshape一样,x是4维(batch,channel,h,w),x.size(0)就是保持batch不变,-1表示自动计算,一个维度确定,根据数据个数自动计算另一个维度。

特征图需要先变成一个二维矩阵,才能做全连接层出结果。

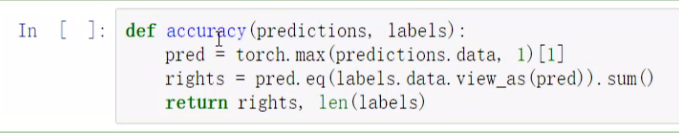

1.3 准确率作为评估标准

max的第一个返回值是最大的具体值,第二个是索引

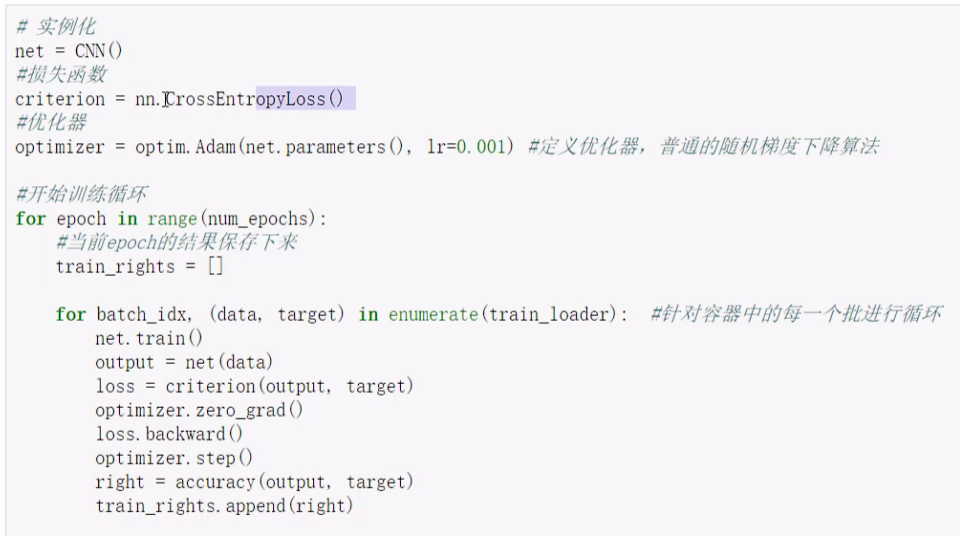

2. 训练网络模型

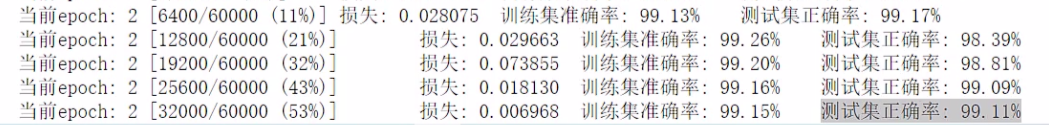

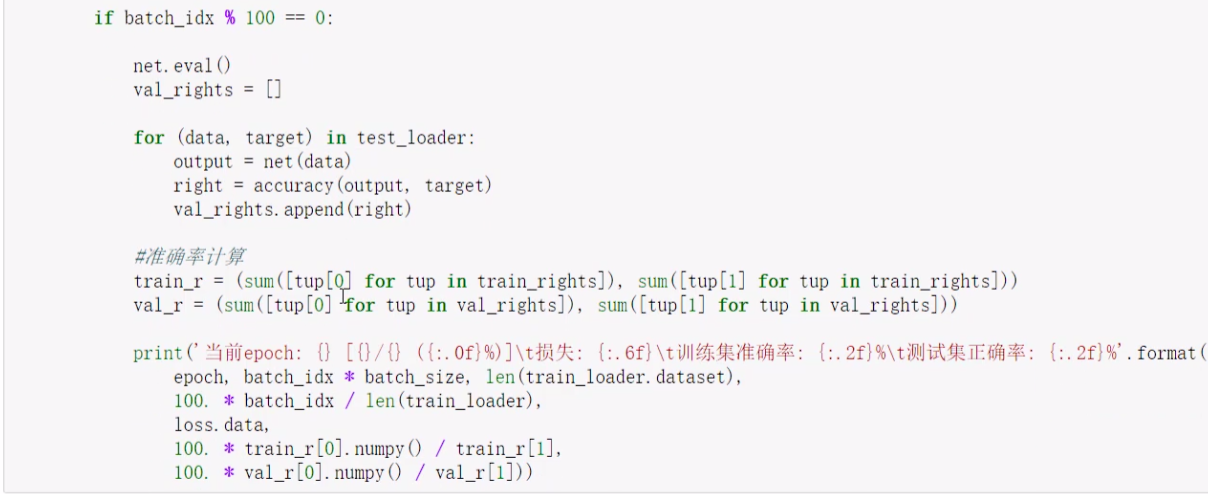

搞batch_idx就是为了在评估时固定步数计算一下准确率

之前用全连接做的最终结果是97%,现在测试集准确率已经99%了