2025暑期—05神经网络-BP网络

按误差反向传播(简称误差反传)训练的多层前馈网络

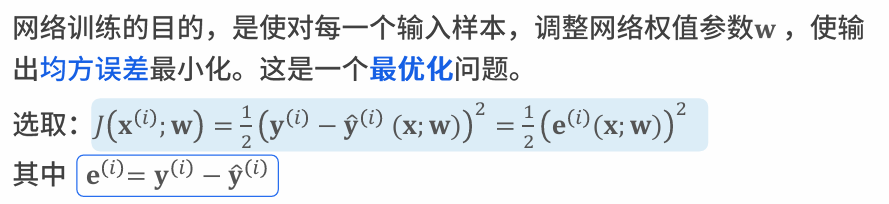

线性回归或者分类不需要使用神经元,原有最小二程即可。求解

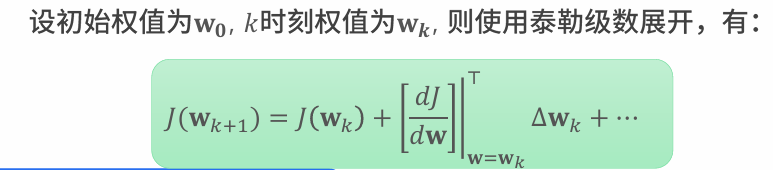

J依次变小。使用泰勒展开,只看第一阶。

J依次变小。使用泰勒展开,只看第一阶。

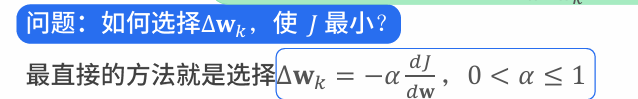

偏导是确定的,需要让J小于0的delta Wk

Wk构造完成后 J(Wk+1)已知,依次完成。构造出 内积,形成模的平方乘比例带负号。

梯度下降法,也是BP基本思想。

只看到坡的一小圈,下山要找下降最快的方向,一步一步向前走。沿负梯度走,步长alpha,所有的神经网络和深度学习都是这个原理。

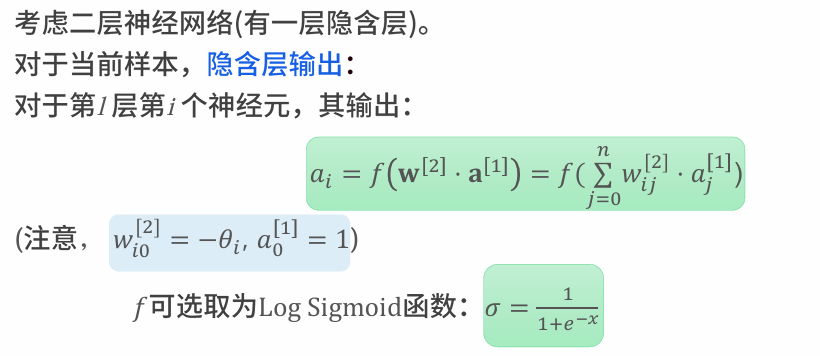

前向传播

第i个输出神经元a 是上一层神经元向量和权值共同作用的结果。

第i个输出神经元a 是上一层神经元向量和权值共同作用的结果。

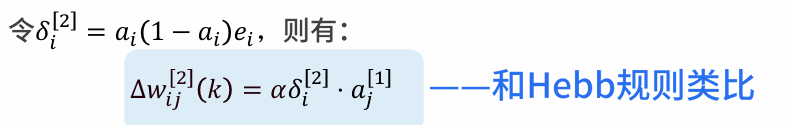

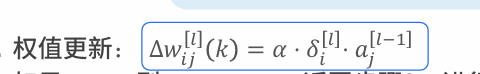

由链式求导更新w权重矩阵。Sigmoid函数求导特性导致计算简便性。 deta i 是隐含层 aj 连接第i个 神经元等效输出和第j个神经元输出 确定权值决定

deta i 是隐含层 aj 连接第i个 神经元等效输出和第j个神经元输出 确定权值决定

神经元在长期进化过程中学会了求偏导,Hebb的生物学定义完全一直

先要算出delta 也就是隐含层向输出层等效输出,再求前一层,直到输入层,这也是反向传播的意思。