什么是LLMs.txt?如何在线生成?robots.txt一键转LLMs.txt

随着人工智能和大型语言模型(LLMs)的快速发展,如何有效管理这些AI系统对网络内容的访问成为一个日益重要的问题。就像robots.txt文件控制传统网络爬虫一样,LLMs.txt文件应运而生,为AI系统提供访问规则。本文将全面介绍LLMs.txt的规范、作用、商业价值、发展现状及未来趋势,并重点推荐实用的生成工具。

一、LLMs.txt是什么?

1.1 定义与规范

LLMs.txt(官网:https://llmstxt.org/ )是一种类似于robots.txt的文本文件,专门用于指导大型语言模型(LLMs)如何访问和利用网站内容。与robots.txt控制传统网络爬虫不同,LLMs.txt专门针对AI/LLM类爬虫,允许网站所有者明确指定哪些内容可以被AI爬取用于训练,哪些内容应该被排除在外。

它由AI研究者和网络标准组织提出,旨在解决AI训练数据采集与网站内容版权保护之间的矛盾。主要包括:

• 文件应放置在网站根目录下(如https://example.com/llms.txt)

• 使用简单的文本格式,易于解析

• 支持通配符和路径匹配

• 可以指定允许或禁止特定AI系统访问

基本规范

LLMs.txt文件通常放置在网站的根目录下(如:https://example.com/llms.txt),其语法结构与robots.txt类似:

User-agent: [AI爬虫名称]

Allow: [允许访问的路径]

Disallow: [禁止访问的路径]主要AI爬虫标识

目前常见的AI爬虫User-agent包括:

• ChatGPT-User

• Google-Extended

• Anthropic-ai

• CCBot

• FacebookBot

国内主要AI爬虫标识(User-Agent)

百度系AI爬虫

User-Agent:

BaiduSpider(通用爬虫,可能用于AI训练)扩展标识: 百度可能未明确区分搜索爬虫和AI训练爬虫,但部分AI相关服务可能使用类似

Baidu-AI或Baidu-LLM的变体。用途: 用于文心一言(ERNIE)等大模型的数据采集。

字节跳动(今日头条/豆包)

User-Agent:

Bytespider(通用爬虫,可能覆盖AI训练)潜在标识: 豆包(Doubao)等AI产品可能使用

ByteDance-AI或Doubao-Bot。

阿里巴巴/达摩院

User-Agent:

AliSpider或Alibaba-Security(通用爬虫)AI相关: 通义千问(Qwen)可能使用

Qwen-Bot或Alibaba-LLM。

腾讯(混元大模型)

User-Agent:

TencentBot或QQBot(通用爬虫)AI相关: 混元大模型可能使用

Hunyuan-AI或WeChat-LLM。

科大讯飞(星火大模型)

User-Agent:

iFlytekSpider或Spark-Bot(需观察实际使用情况)。

360搜索与AI

User-Agent:

360Spider(可能用于360智脑训练)。

其他厂商

商汤(SenseTime): 可能使用

SenseBot。MiniMax: 可能使用

MiniMax-Bot。月之暗面(Kimi): 可能使用

Moonshot-AI。

1.2 与robots.txt的区别

特性 | robots.txt | LLMs.txt |

目标用户 | 传统网络爬虫 | 大型语言模型(LLMs) |

主要用途 | 控制网页抓取 | 控制内容被AI学习和使用 |

规范成熟度 | 已有标准(robots.txt规范) | 正在形成社区规范 |

指令集 | 简单指令(Allow/Disallow) | 更丰富的访问控制指令 |

二、LLMs.txt的作用与价值

2.1 核心作用

1. 内容保护:防止敏感或专有内容被AI系统未经授权学习使用

2. 版权控制:明确哪些内容可以合法用于AI训练

3. 质量管控:引导AI系统优先使用高质量内容

4. 商业策略:通过选择性开放内容实现差异化竞争

2.2 商业价值

1. 数据资产保护:防止核心业务数据被AI系统免费获取

2. 内容变现:通过控制访问权限实现内容付费模式

3. 品牌保护:防止AI生成内容中出现不当引用或歪曲

4. 合规管理:满足GDPR等数据隐私法规要求

三、LLMs.txt的发展现状

3.1 提出背景与倡导者

LLMs.txt的概念主要由以下群体推动:

• 内容创作者社区:如作家、记者和出版商协会

• 技术标准组织:如W3C相关工作组

• 搜索引擎公司:如Google、Bing等正在探索AI内容抓取规范

• 开源社区:GitHub上有多个相关提案讨论

3.2 采用现状

目前LLMs.txt仍处于早期采用阶段,但已有:

• 部分新闻网站开始部署

• 学术出版机构积极探索

• 内容聚合平台进行测试

• 开源工具链逐步完善

3.3 未来发展趋势

1. 标准化进程加速:预计1-2年内形成行业广泛接受的规范

2. 与法律框架结合:可能与数字版权法更紧密集成

3. AI系统原生支持:主流LLMs将内置对LLMs.txt的解析

4. 与区块链结合:可能实现内容使用授权的自动化验证

四、如何生成LLMs.txt文件

4.1 手动生成方法

基本语法示例:

# LLMs.txt 示例

User-agent: *

Disallow: /private/

Disallow: /user-content/Allow: /public/articles/

Crawl-delay: 10# 特定AI系统规则

User-agent: GPTBot

Disallow: /research/User-agent: ClaudeBot

Allow: /blog/4.2 推荐生成工具

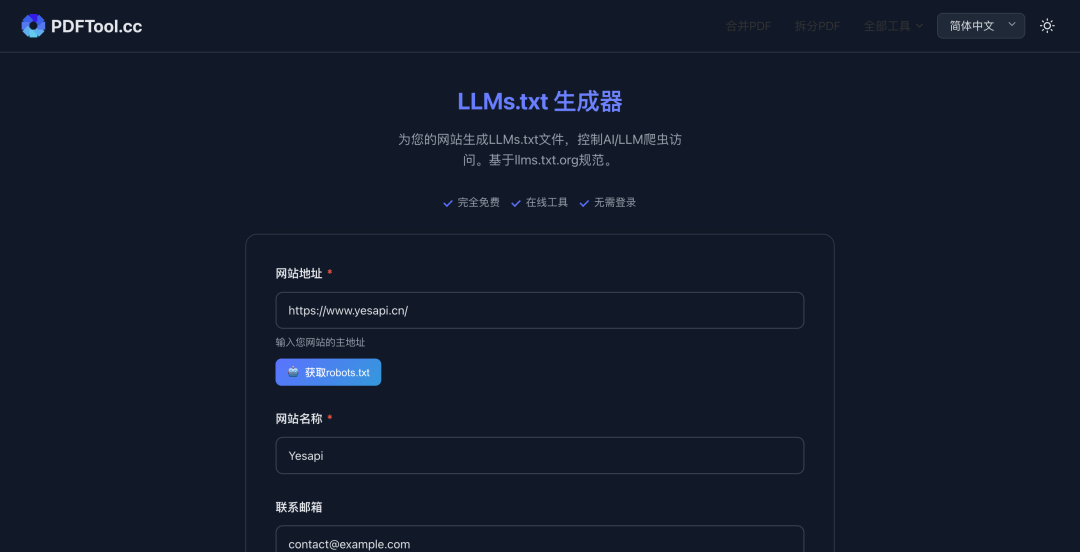

1. LLMs.txt 在线生成器:https://www.pdftool.cc/zh/llms-txt-generator

• 直观的图形界面

• 支持robots.txt一键转换

• 实时语法验证

• 多语言支持

2. 其他推荐工具:

• LLMs.txt Builder (GitHub开源项目)

• WebAI Access Control (商业工具)

• SEO平台集成功能(如SEMrush)

五、如何将robots.txt一键转换为LLMs.txt?

5.1 转换原理

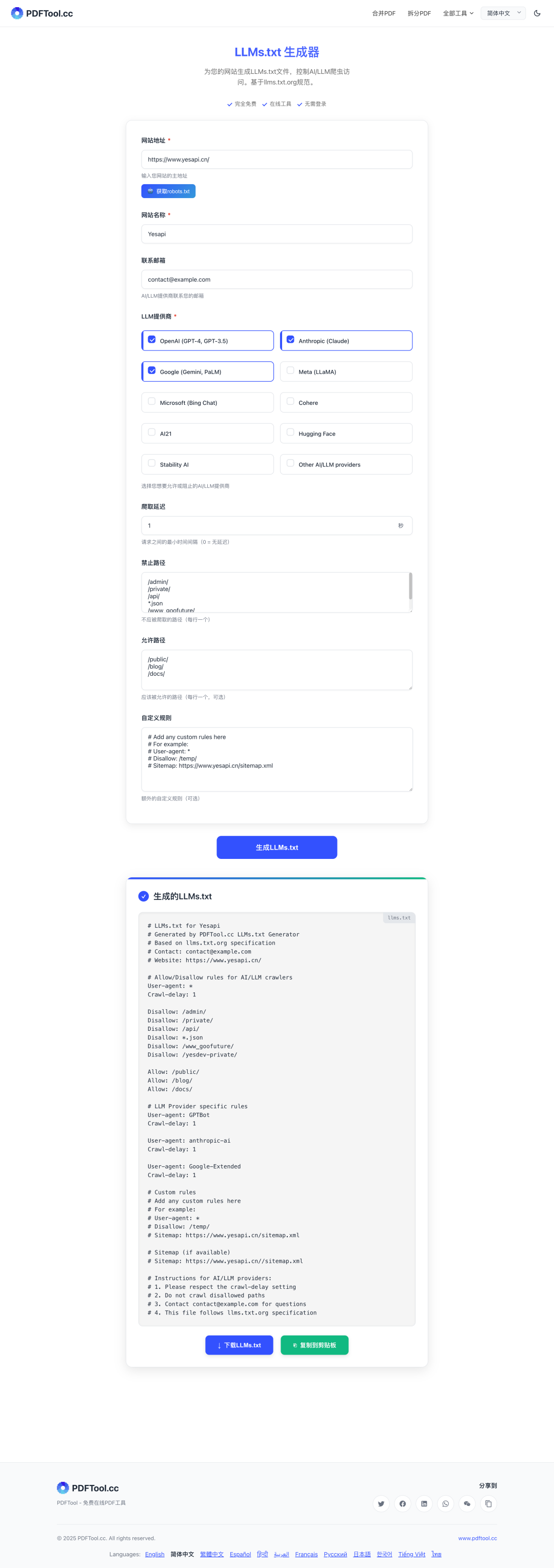

https://www.pdftool.cc/zh/llms-txt-generator 提供一键转换功能,其工作原理是:

1. 解析现有robots.txt文件结构

2. 将标准指令映射到LLMs.txt对应规则

3. 添加LLMs特有的指令扩展

4. 生成兼容性报告

5.2 转换步骤

1. 访问 https://www.pdftool.cc/zh/llms-txt-generator

2. 输入您的网站URL或直接粘贴robots.txt内容

3. 选择转换模式

4. 预览生成的LLMs.txt

5. 复制或下载或直接部署到网站根目录

六、最佳实践建议

1. 渐进式实施:先监控再限制,逐步完善规则

2. 定期审查:随着AI生态系统变化更新规则

3. 文档化:在网站明显位置说明您的AI访问政策

4. 组合使用:与API访问控制、版权声明等配合使用

5. 基础保护:至少禁止AI爬虫访问隐私内容和付费内容

6. 精细控制:对不同类型的AI爬虫设置不同规则

7. 定期更新:随着AI生态发展及时更新规则

8. 监控验证:通过服务器日志检查AI爬虫遵守情况

9. 法律声明:在网站条款中明确AI数据使用政策

结语

LLMs.txt代表了网络内容管理的新范式,为网站所有者提供了控制AI系统访问的有效工具。

随着AI技术的普及,这种新型访问控制文件的重要性将不断提升。LLMs.txt正在成为网站与AI生态系统交互的重要接口文件。通过合理配置LLMs.txt,网站所有者可以在享受AI技术红利的同时,有效保护自身内容价值。LLMs.txt 在线生成器等工具大大降低了技术门槛,使每个网站都能轻松应对AI时代的内容管理挑战。

LLMs.txt很可能成为网站标准配置的一部分。建议网站管理员未雨绸缪,尽早部署适合自身业务需求的LLMs.txt策略,为未来的网络生态变化做好准备。