人工智能概念之九:深度学习概述

文章目录

- 相关文章

- 一、深度学习的定位:AI时代的基石技术

- 1.1 技术生态全景图

- 1.2 技术革命的催化剂

- 二、深度学习的双面性:性能优势与技术挑战

- 2.1 技术优势全景扫描

- 2.2 技术挑战深度剖析

- 三、技术演进时间轴:70年的厚积薄发

- 四、主流框架生态对比

- 五、未来演进方向

相关文章

人工智能概念之二:人工智能核心概念:网页链接

一、深度学习的定位:AI时代的基石技术

1.1 技术生态全景图

深度学习处于人工智能(AI)技术金字塔的顶端,其技术层级关系可形象化为:

- 人工智能(AI):顶层目标,构建能模拟人类智能行为的系统

- 机器学习(ML):方法论核心,通过数据驱动实现任务优化(如决策树、SVM)

- 深度学习(DL):技术突破点,基于神经网络架构实现特征自学习(如ResNet、BERT)

类比:AI如同建造智能大厦的目标,机器学习是施工团队,深度学习则是团队掌握的高精度3D打印技术

1.2 技术革命的催化剂

深度学习通过以下方式重构传统机器学习:

- 特征工程革命:传统ML需要人工设计特征(如HOG、SIFT),DL通过多层网络自动提取特征(从边缘→纹理→物体的层级抽象)

- 端到端范式:输入原始数据(如像素值)直接输出结果(如分类标签),省去特征提取、降维等中间步骤

- 非线性建模能力:通过激活函数(ReLU、Sigmoid)和多层结构,逼近任意复杂函数

二、深度学习的双面性:性能优势与技术挑战

2.1 技术优势全景扫描

| 优势维度 | 典型表现 | 实际案例 |

|---|---|---|

| 精度突破 | 图像识别错误率<3%(超越人类水平) | AlphaGo击败李世石 |

| 数据适应性 | 处理高维非结构化数据(图像、语音、文本) | BERT处理自然语言理解 |

| 自动化程度 | 端到端训练省去人工特征工程 | 自动驾驶系统直接处理视频流 |

2.2 技术挑战深度剖析

-

可解释性黑洞

- 黑箱模型决策过程不可见(如医疗诊断中的误判难以追溯)

- 解决方案探索:Grad-CAM可视化、LIME解释框架

-

资源消耗困境

- 训练成本:GPT-3训练费用超460万美元(AWS TPU集群)

- 能效比:单块A100显卡功耗250W,相当于家用空调

-

数据依赖陷阱

- 数据质量要求:ImageNet需要1400万张标注图像

- 过拟合风险:小样本场景下模型性能急剧下降

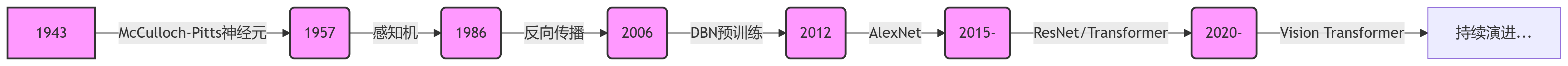

三、技术演进时间轴:70年的厚积薄发

关键转折点解析

- 2006年深度置信网络:通过无监督预训练解决梯度消失问题,使深层网络训练成为可能

- 2012年ImageNet革命:AlexNet将Top-5错误率从26%降至15%,引发CV领域范式转变

- 2015年残差网络:ResNet通过跳跃连接突破1000层网络训练难题

- 2017年Transformer:自注意力机制开启NLP大模型时代(BERT/GPT系列)

四、主流框架生态对比

| 框架 | 核心优势 | 适用场景 | 典型用户 |

|---|---|---|---|

| TensorFlow | 静态图优化、TFX生态 | 工业级部署(如Google Translate) | 谷歌、Uber |

| PyTorch | 动态图调试、学术友好 | 研究创新(CVPR论文占比85%+) | Meta、OpenAI |

| PaddlePaddle | 国产框架、产业模型库 | 工业质检、OCR | 国家电网、百度 |

| ONNX | 模型互操作性 | 跨框架部署 | AWS、Azure |

趋势洞察:PyTorch在学术界占据主导(2023年CVPR论文使用率91%),TensorFlow仍主导工业部署

五、未来演进方向

-

效率革命:

- 轻量化:MobileNetV3在手机端实现1ms级推理

- 算法创新:EfficientFormer实现Transformer轻量化

-

可解释性突破:

- 神经元可视化:CNN Filter可视化工具

- 因果推理:CausalML框架探索因果关系

-

小样本学习:

- 元学习:MAML实现5-shot图像分类

- 自监督:MAE通过掩码重建实现无监督预训练

-

绿色AI:

- 神经架构搜索(NAS):AutoML自动优化模型结构

- 低精度训练:FP16/INT8量化技术降低能耗