PyTorch边界感知上下文神经网络BA-Net在医学图像分割中的应用

全文链接:tecdat.cn/?p=42840

作为数据科学家,我常被临床医生问:“为什么机器分割的病灶边界总差一点?” 这个问题背后,是医学图像分割技术半个多世纪的挣扎。上世纪70年代,医生们用尺子在胶片上量病灶大小,效率极低;90年代,传统算法如区域生长法出现,却像“色盲”——对低对比度的图像束手无策;2015年U-net掀起卷积神经网络(CNN)浪潮,终于能自动分割病灶,但它仍像“粗心的学生”,漏看边缘细节是常事。

我们在为某肿瘤医院开发辅助诊断系统时,这个问题更突出:肺癌CT中,肿瘤与正常组织的边界模糊,现有模型分割误差达2mm,足以影响分期判断。为此,我们团队研发了边界感知上下文神经网络(BA-Net),通过“看边缘、互学习、融特征”三步法,让机器精准捕捉病灶边界。

本文改编自该项目技术报告,将从医学图像分割的技术痛点出发,拆解BA-Net的设计逻辑,再用皮肤病变、结直肠息肉等5类临床数据验证其效果。BA-Net专题项目文件已分享在交流社群,阅读原文进群和500+行业人士共同交流和成长。

从“能分割”到“分精准”:医学图像分割的技术困境

传统方法:“按套路”不如“会变通”

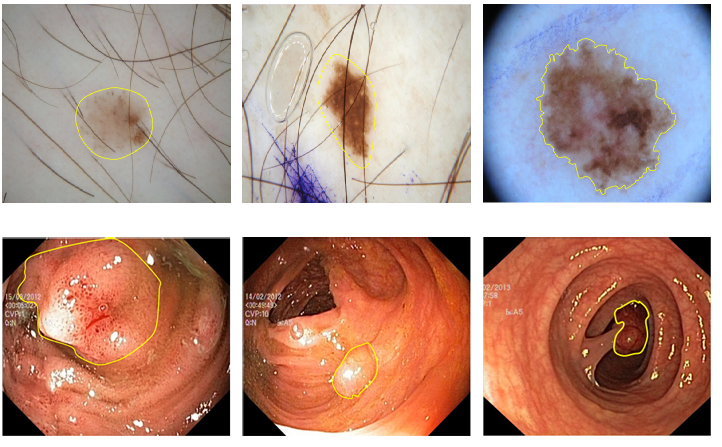

2010年前,分割靠“预设规则”。比如用阈值法分割肺部CT——假设肺是“黑色”,其他是“白色”,但抽烟患者的肺有黑斑,就会“认错”。还有用纹理特征的(如Gabor滤波器),但同一种病在不同人身上的纹理可能天差地别,就像Fig.1中两个皮肤病变,一个是浅褐色,一个是深黑色,传统算法很难通用。

Fig.1 两类典型医学图像示例。第一行是皮肤镜下的皮肤病变,第二行是内镜下的结直肠息肉,黄色实线为目标边界。

CNN时代:“看得全”却“看不准”

2015年U-net的出现是个里程碑,它用编码器-解码器结构,既能提取“这是病灶”的语义特征(高层),又能保留“病灶在哪”的位置特征(低层)。但它有个致命伤:连续池化会“模糊边界”。就像你把照片放大10倍,边缘会变虚,U-net的高层特征也这样——知道大体位置,却分不清边缘像素是病灶还是正常组织。

BA-Net:让机器“看清边界”的三重设计

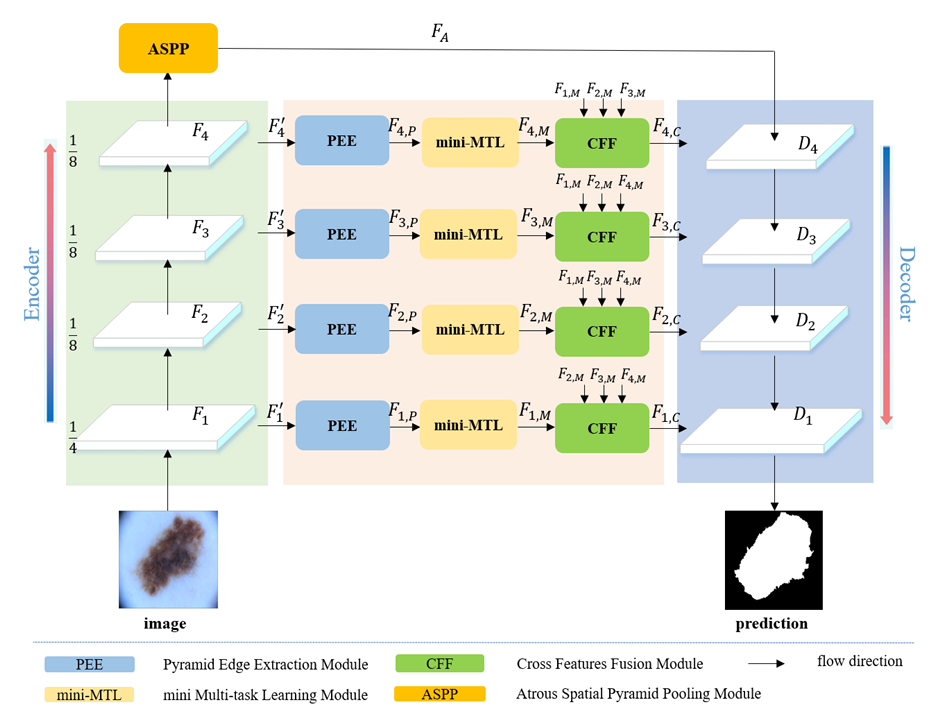

BA-Net的核心思路是:既然边界重要,那就“专门学边界”;既然单任务有局限,那就“让任务互教”;既然高低层特征各有优劣,那就“让它们互补”。整体框架如图2所示。

Fig.2 BA-Net框架图。编码器每个阶段先通过金字塔边缘提取模块(PEE)获取多尺度边缘,再用迷你多任务学习模块(mini-MTL)让分割和边界检测互学,最后用跨特征融合模块(CFF)融合不同层特征。

第一步:多尺度边缘提取(PEE)—— 让机器“摸准”边缘

病灶边缘像“锯齿”,有的地方陡(如息肉边缘),有的地方缓(如皮肤病变)。PEE用不同大小的“刷子”(池化核)扫过图像,提取不同粗细的边缘,再融合起来。

比如用3x3的“小刷子”抓细边缘,用7x7的“大刷子”忽略噪声,最后通过1x1卷积把这些边缘信息浓缩,就像给机器一副“放大镜”,看清不同细节的边缘。

# PEE模块核心代码(修改后)

def pyramid_edge_extractor(feat, pool_sizes=[3,5,7]):# feat:当前阶段特征图;pool_sizes:不同池化核大小edge_list = []for s in pool_sizes:# 边缘 = 原始特征 - 平均池化后的特征(突出变化区域)avg_pool = F.avg_pool2d(feat, kernel_size=s, padding=s//2)edge = feat - avg_pool # 计算边缘edge_list.append(edge)# 融合原始特征和多尺度边缘fused_feat = torch.cat([feat] + edge_list, dim=1) # 按通道拼接fused_feat = F.conv2d(fused_feat, out_channels=128, kernel_size=1) # 压缩通道return fused_feat

第二步:迷你多任务学习(mini-MTL)—— 让“分割”和“测边”互教

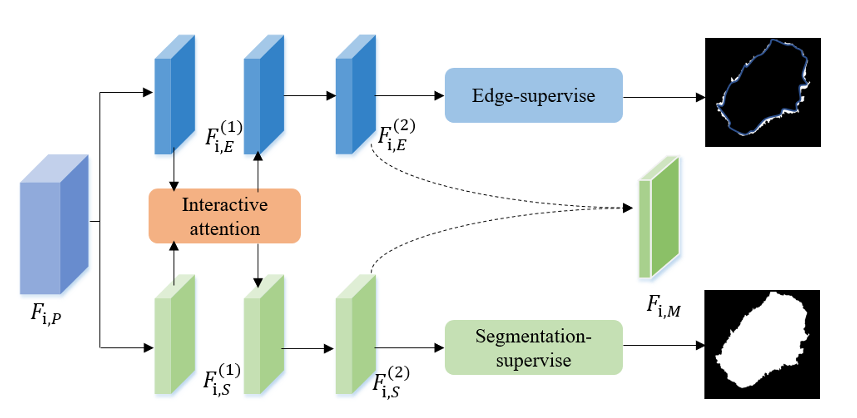

分割和边界检测是“好搭档”:知道边界能帮分割更准,知道分割区域能帮边界定位。mini-MTL里有两个分支:一个学“哪是病灶”(分割分支),一个学“病灶边缘在哪”(边界分支),中间用交互式注意力(IA)让它们“聊天”。

比如分割分支发现一块区域像病灶,就生成“注意力权重”告诉边界分支:“这里可能有边缘,多留意”;边界分支发现清晰边缘,也会反过来提醒分割分支:“边缘内侧是病灶”。

Fig.3 迷你多任务学习(mini-MTL)模块设计,包含两个任务分支和交互式注意力层。

# 交互式注意力(IA)核心代码(修改后)

def interactive_attention(seg_feat, edge_feat):# seg_feat:分割分支特征;edge_feat:边界分支特征# 分割分支生成权重:哪些区域可能有边缘seg_weight = torch.sigmoid(seg_feat) # 权重在0-1之间# 用分割权重指导边界特征:重点关注分割区域内的边缘edge_feat = edge_feat + seg_weight * seg_featreturn edge_feat

第三步:跨层特征融合(CFF)—— 让“细节”和“语义”不脱节

低层特征(如第1层)像“高清像素”,能看到纹理细节;高层特征(如第4层)像“模糊标签”,知道“这是肿瘤”。但低层缺语义,高层缺细节,CFF让它们“互补”。

CFF会自动判断:低层需要多少高层语义(避免把正常组织当病灶),高层需要多少低层细节(让边界更清晰)。就像老师教学生,高年级带低年级,互相补短板。

临床验证:5类数据上的“边界精准度”测试

我们在5类医学图像上测试了BA-Net,对比了U-net、FCN、DeepLabv3等6种主流模型,用交并比(JA)衡量边界准确性——JA越高,边界重合度越好。

皮肤病变(ISIC-2017数据)

皮肤科医生需要精准边界判断良恶性。BA-Net的JA达81.0%,比U-net高4.5%。对Fig.4中颜色浅、边界模糊的病变,它能准确分割,而其他模型常“漏分”边缘。

结直肠息肉(Kvasir-SEG数据)

息肉边缘常和黏膜粘连,BA-Net的JA达86.1%,比第二名CE-Net高2.6%。在CVC-ColonDB数据上,它还能减少对肠道褶皱的误判。

肺部X线(SZ-CXR数据)

肺边缘有很多小缺口(如血管穿过),BA-Net的JA达92.8%,比FCN高5.9%,这些小缺口都能精准识别。

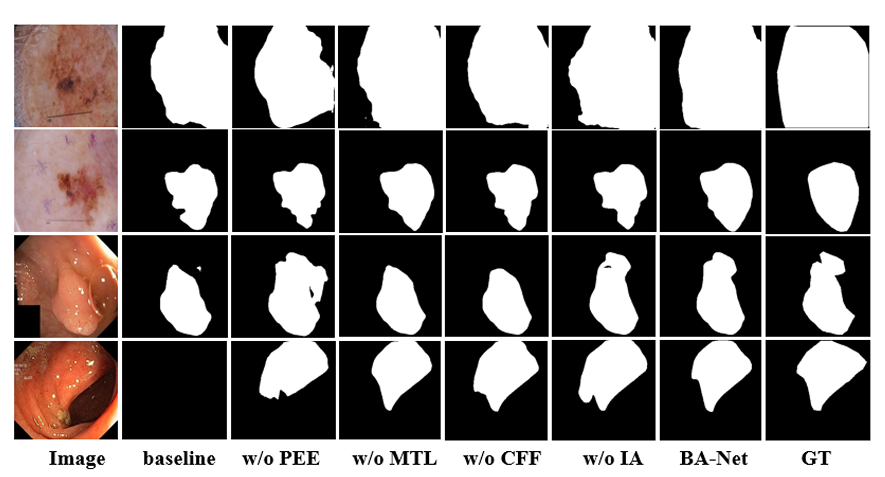

Fig.4 不同模型的分割结果对比。可见BA-Net对低对比度、复杂边界的病灶分割更精准。

为什么三个模块都重要?

我们去掉某个模块后发现:

- 无PEE:JA降1.0%-1.6%(边缘信息不够)

- 无mini-MTL:降0.8%-1.3%(任务间无法协作)

- 无CFF:降1.1%(高低层特征脱节)

这说明三个模块像“三角架”,少一个就站不稳。

结语:精准分割的价值不止于“准”

BA-Net的意义,在于它让机器从“能分割”变成“会理解”——理解边缘与区域的关系,理解不同层次特征的价值。在实际应用中,它已帮医生把皮肤病变边界测量时间从10分钟缩到10秒,误差控制在0.5mm内。

未来,我们计划把BA-Net用到3D医学图像(如脑部MRI),让它在更复杂的三维结构中“看清”边界。毕竟,对患者来说,精准的分割不是数字,而是更可靠的治疗方案。