【AI前沿】英伟达CEO黄仁勋ComputeX演讲2025|Token是AI时代的“新货币”

- 博主简介:努力学习的22级计算机科学与技术本科生一枚🌸

- 博主主页: @Yaoyao2024

- 往期回顾:【AlphaFold2】深入浅出,讲解Evoformer|学习笔记

- 每日一言🌼: 不飞则已,一飞冲天,不鸣则已,一鸣惊人——《史记·滑稽列传》🌺

前言

黄仁勋2025Computex演讲让我印象比较深的是开头放的一段讲解视频——“智慧就是这样形成的”,反复强调Tokens在人工智能时代的重要性,是人工智能的基石。

今天在看Alphafold3的时候,又看到将序列等输入进行Tokenization这个概念,其实这个概念本身并没有什么新奇,只不过是让我联想到为什么黄仁勋如此强调Token的重要性,为什么在2025主题演讲的开头放一段专门讲解“Token”的宣传片,并将其作为英伟达未来战略的关键概念:。今天就想来好好分析分析。

一、到底什么是Token?——从基础概念到AI时代的核心角色

1. Token的基本定义

Token(词元/标记) 是计算机处理自然语言时的最小语义单位。简单来说,它可以是:

- 一个单词(如 “hello”)

- 一个子词(如 “unhappiness” 拆解为 “un” + “happy” + “ness”)

- 一个符号或标点(如 “?”、“。”)

- 甚至是一个字符(如中文的每个字通常被视为一个Token)

示例:

- 英文句子

"I love AI!"可能被拆分为["I", "love", "AI", "!"](4个Token)。 - 中文句子

"我喜欢人工智能"可能被拆分为["我", "喜欢", "人工", "智能"](4个Token)。

2. Token在AI(尤其是大模型)中的作用

在AI领域,尤其是像ChatGPT、DeepSeek、Llama这样的大语言模型(LLM)中,Token是输入、计算和输出的基本单位:

- 输入阶段:模型接收的文本会被Token化(Tokenization),转换成数字ID,供模型处理。

- 计算阶段:模型基于Token之间的关系(如注意力机制)进行推理和预测。

- 输出阶段:模型生成的Token逐个组合,形成最终的回答。

示例:

- 当你问AI

"你好吗?",模型会:- 拆解为Token

["你", "好", "吗", "?"] - 计算每个Token的概率,预测下一个Token(如

"我"→"很好"→"!") - 最终输出

"我很好!"(同样由多个Token组成)。

- 拆解为Token

二. 为什么Token如此重要?

(1) Token决定AI的理解和生成能力

- 更长的Token序列 = 更复杂的语义理解(如处理长文档、代码、数学推理)。

- Token的拆分方式 影响模型对语言的理解(如中文按字还是按词拆分会影响效果)。

(2) Token数量直接影响算力需求

- 训练阶段:模型需要处理海量Token(如GPT-3训练了约3000亿Token)。

- 推理阶段:每次用户提问和AI回答都涉及Token的生成,消耗计算资源。

- 例如,生成1000个Token可能比生成100个Token多用10倍算力。

(3) Token成为AI经济的核心指标

- 云服务商按Token收费(如OpenAI的API定价是

$0.002 / 1K Tokens)。 - 企业优化模型时,会关注“每Token成本”(如:如何在相同算力下生成更多Token)。

三. 黄仁勋为什么在2025演讲中强调Token?

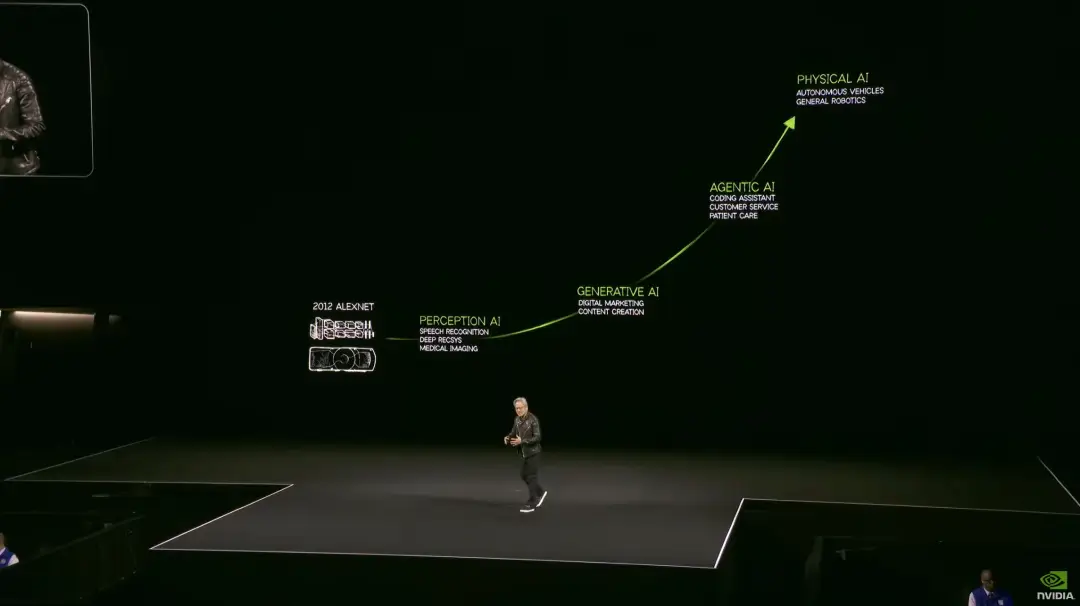

开场,老黄用40分钟解读了:Agentic AI时代,英伟达的立身之本——越来越高效地处理tokens(词元)。单位时间内能处理的tokens百倍万倍增长,同时单位算力成本和能耗下降。

-

AI进入“推理时代”:

- 早期AI(如GPT-3)主要训练时消耗Token,但未来Agentic AI(自主AI) 会在推理时消耗更多Token(如反复思考、验证答案)。总Token = 输入 + 中间计算 + 输出

- 例如,DeepSeek R1模型用8000 Token解决一个问题,而普通模型只用500 Token但答案错误。

Agentic AI(如DeepSeek R1)的独特之处:

它会在“思考过程”中生成大量中间Token(如尝试不同方案、验证逻辑、自我修正),这些不直接展示给用户,但消耗计算资源。 -

Token=AI时代的“新石油”:

- 就像工业时代依赖石油,AI时代依赖Token的生产效率。

- 英伟达的GPU(如Blackwell)优化Token处理能力,让企业以更低成本生成更多Token。

-

反驳“算力过剩论”:

- 有人质疑“AI是否需要这么多GPU?”,黄仁勋用Token需求增长(如Agentic AI需要100倍Token)证明:未来算力需求只会更大。

三. 未来趋势:Token经济学(Tokenomics)

- 更高效的Token生成 → 更强大的AI(如实时翻译、自动驾驶决策)。 黄仁勋“AI工厂”概念的核心——未来数据中心的价值,取决于它能多高效地将电力转化为Token(智能)。

- 更低成本的Token处理 → 让AI服务更便宜、更普及(如$0.0001/Token)。

- 英伟达的硬件(GPU/芯片)和软件(推理优化) 将成为Token经济的核心基础设施。

总结

- Token是AI语言的基本单位,就像人类语言的“单词”。

- AI理解和生成Token的能力决定了它的智能水平。

- 黄仁勋强调Token,是为了说明AI未来需要更强的算力(英伟达的GPU),并定义“Token经济学”这一新商业模式。