Prompt提示工程

基础大模型 --> 基础大量数据进行训练,文字接龙, 预测下一个词将会是什么

✅ 指令调整型模型--> 基础大量数据进行训练基础上,然后使用输入和输出指令来进行微调。RLHF(人类反馈强化学习)

原则:

1、编写明确和具体的指令

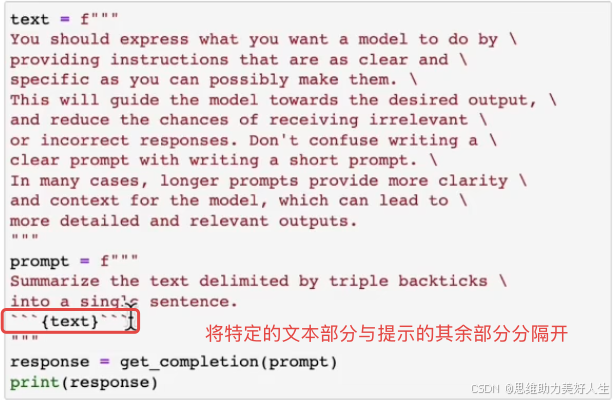

1> 使用分隔符清楚地指示输入的不同部分

使用分隔符还可以避免提示词冲突 , 目的是要求模型遵循我们想要的指令而不是用户的指令。

2>要求结构化输出 (请求使用HTML或JSON结构化输出)

好处是可以在Python中将其读入字典或列表中

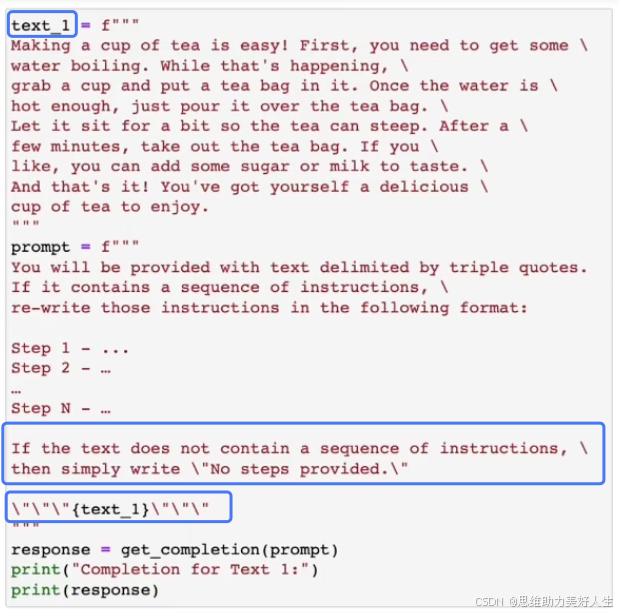

3>要求模型检查是否满足条件

如果不满足条件,可以不完全的执行任务

4>少量训练提示 (要求模型执行任务之前,提供成功执行任务的示例)

也就是给模型一个参考的示例,参考的模版。

2、给模型足够的时间来思考

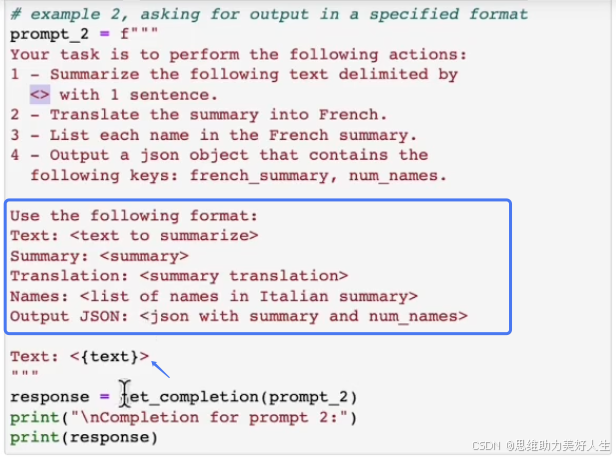

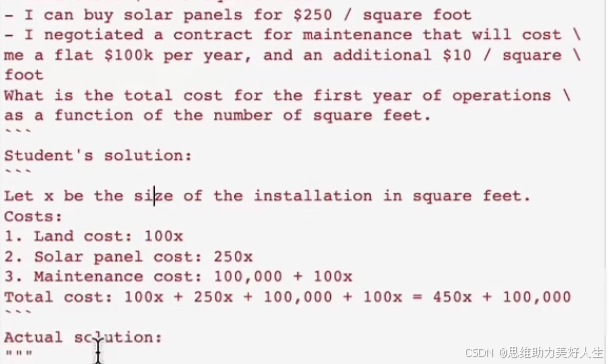

1> 模版化输出

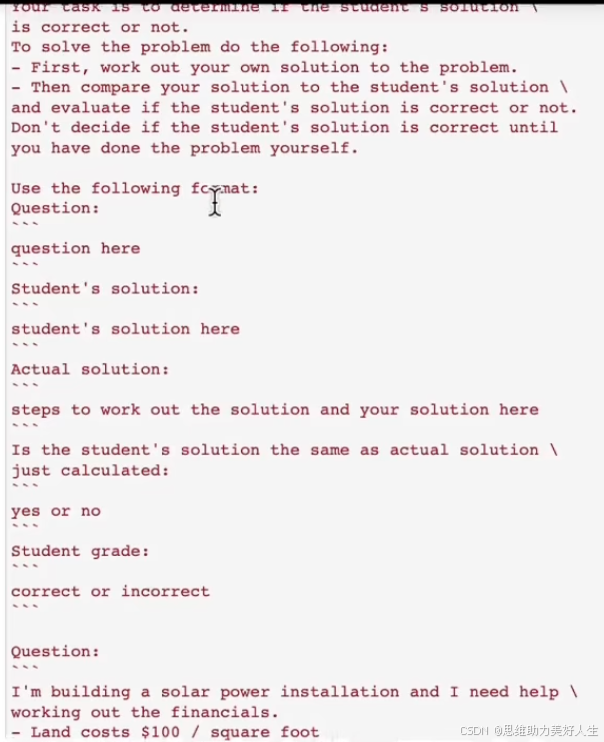

2>为了让模型不要匆匆忙忙进行判定,而有可能产生错误,因此应将模型自己计算的输出答案与给定的答案进行比较后得出结果

3>注意大模型的幻觉

减少幻觉的可能方式之一是: 要求模型首先从文本中找到任何相关的引用,然后要求它使用这些引用来回答问题,并且可以追溯答案回源文档。

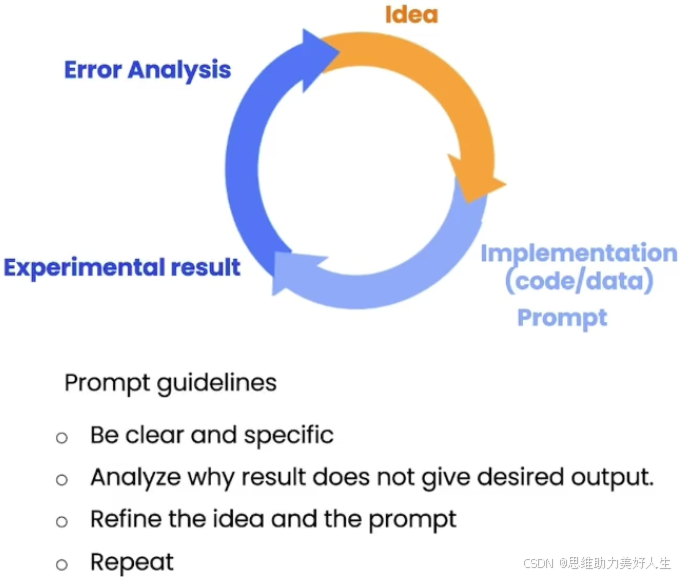

不断的找到适合的提示

不断循环调优的过程比如限制最大字数,仅让模型输出几句话,或者着重让模型介绍哪些方面等等

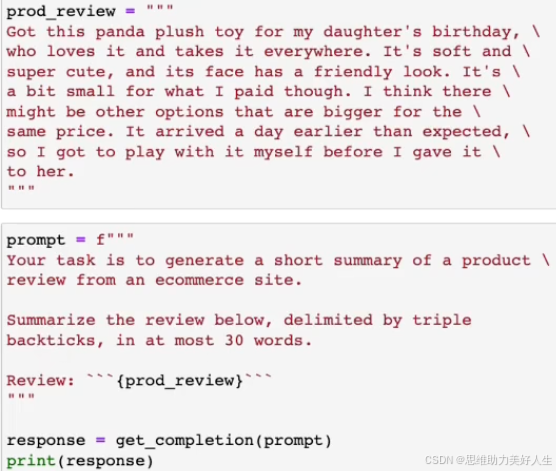

摘要

应用场景: 比如快速提取评论区的评论,通过快速生成摘要来感知所有用户的动态

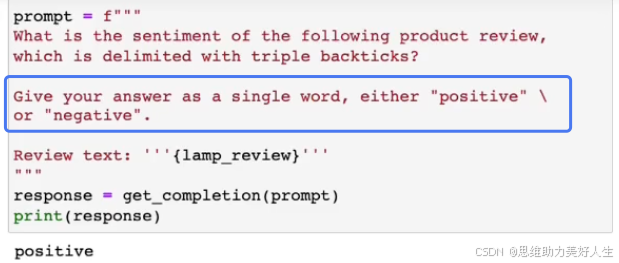

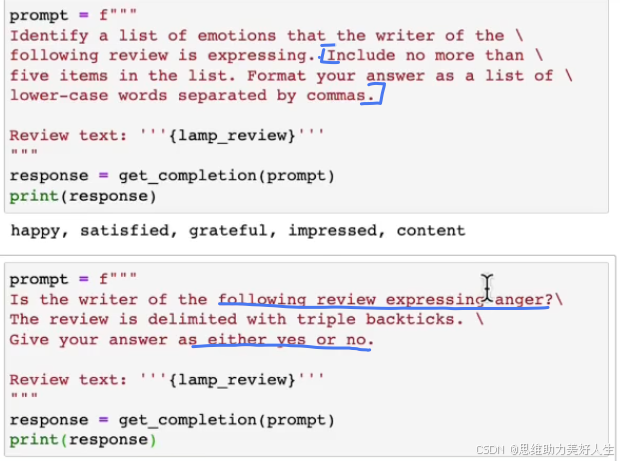

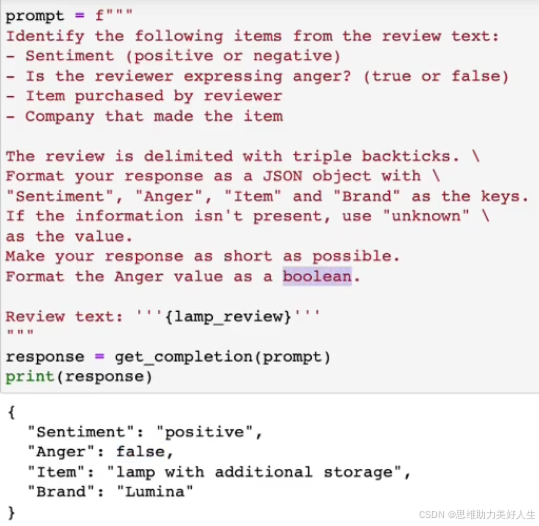

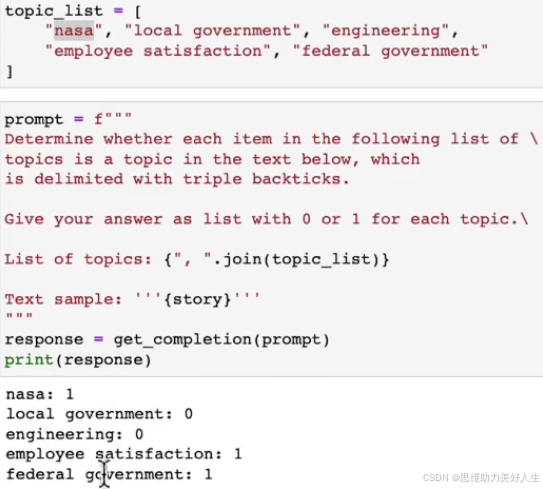

推理场景 -- 情感识别

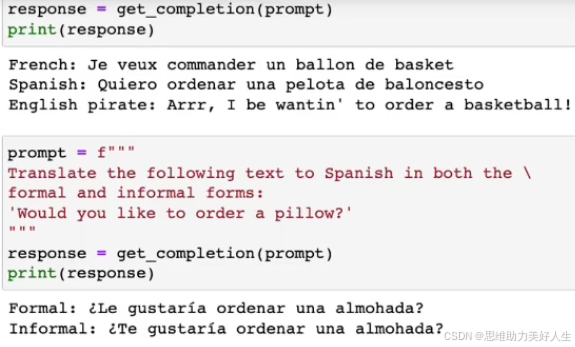

翻译的示例:

可以根据不同对应的对象,生成对应不同语气的内容,比如正式或非正式的风格

最好指定结构化的输入和输出

拼写检查

让模型进行修正 对比原文的修正

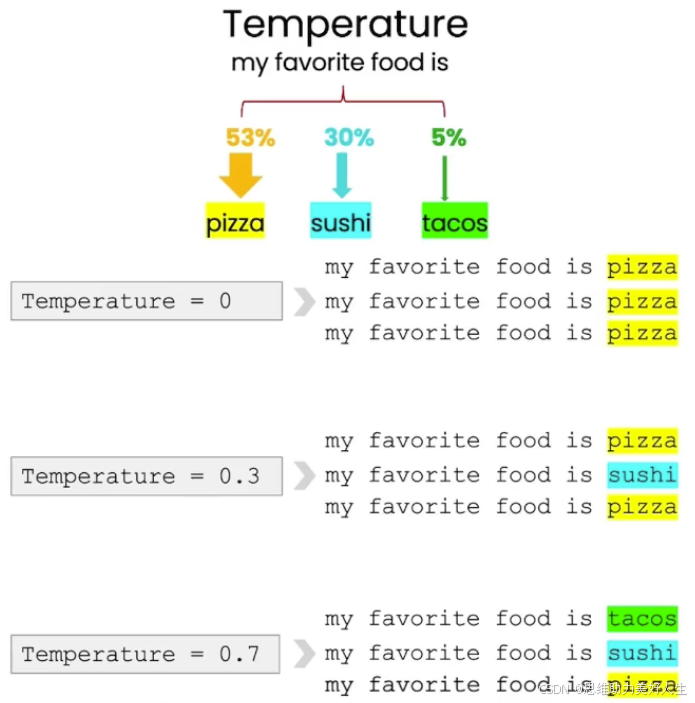

关于温度的参数

模型的探索程度或随机性

如果构建一个可靠和可预测的系统,应该设置温度为0。

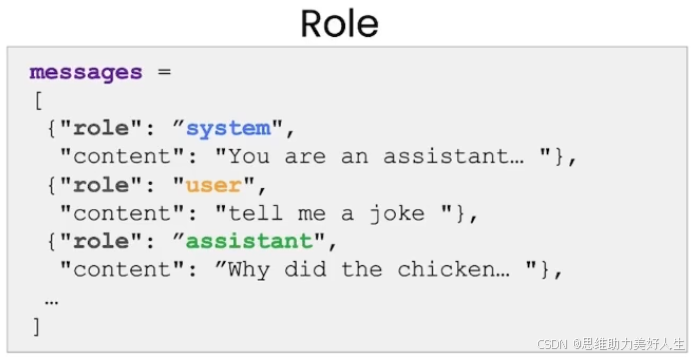

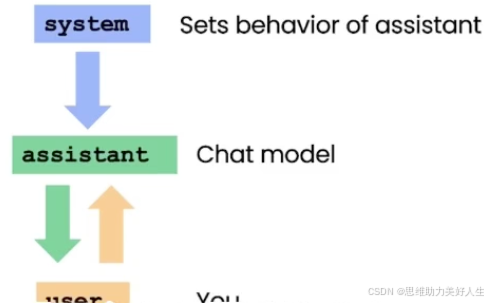

聊天

System的作用

为开发者提供了一种在不将请求本身作为对话的一部分的情况下引导助手并指导其回复的方式