Linux进程池详解:从入门到理解

引言

作为C++开发初学者,理解Linux下的进程池技术对于开发高性能服务器程序至关重要。本文将用通俗易懂的语言,配合直观的图示,帮助你掌握Linux进程池的基本概念、实现原理和应用场景。

什么是进程池?

进程池(Process Pool)是一种预先创建多个进程,然后重复利用这些进程来处理任务的技术。就像游泳池里预先蓄满了水一样,进程池里预先"蓄满"了进程,随时可以拿来使用。

为什么需要进程池?

在高并发服务器中,如果每收到一个请求就创建一个新进程来处理,会带来以下问题:

- 进程创建开销大:创建和销毁进程需要消耗大量系统资源和时间

- 系统负载高:大量进程同时运行会导致系统负载过高

- 资源浪费:每个进程都需要独立的内存空间,造成资源浪费

进程池通过预先创建一定数量的进程并重复使用它们,有效解决了上述问题。

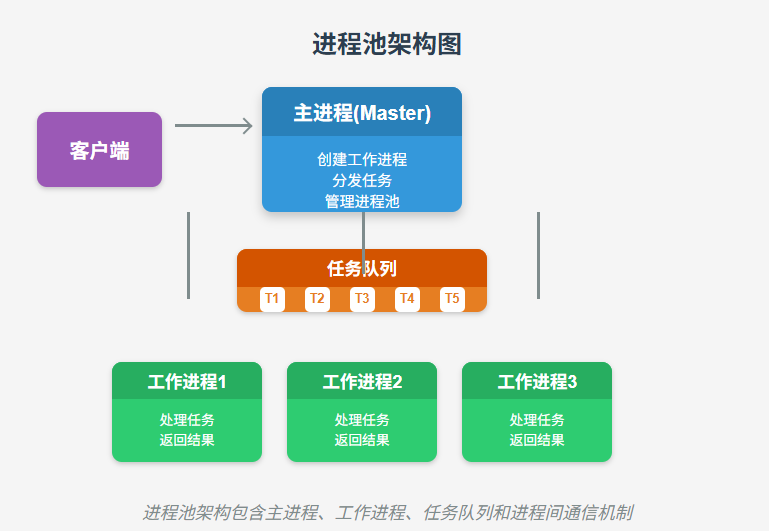

进程池的基本架构

一个典型的进程池架构包含以下组件:

- 主进程(Master Process):负责创建和管理工作进程,分发任务

- 工作进程(Worker Process):负责实际执行任务

- 任务队列:存储待处理的任务

- 进程间通信机制:主进程和工作进程之间的通信渠道

进程池的工作流程

进程池的典型工作流程如下:

1.初始化阶段:

- 主进程创建一定数量的工作进程

- 建立进程间通信机制(如管道、共享内存等)

- 工作进程进入等待状态,等待任务分配

2.任务处理阶段:

- 主进程接收客户端请求

- 主进程将任务放入任务队列

- 主进程通知空闲的工作进程处理任务

- 工作进程从任务队列获取任务并处理

- 工作进程处理完任务后返回结果给主进程

- 工作进程重新进入等待状态

3.结束阶段:

- 主进程发送终止信号给所有工作进程

- 工作进程接收到终止信号后退出

- 主进程回收资源并退出

进程池的实现方式

1. 基于fork()的简单进程池

最基本的进程池实现是使用fork()系统调用创建多个子进程,然后通过管道或其他IPC机制进行通信。

#include <stdio.h>#include <stdlib.h>#include <unistd.h>#include <sys/types.h>#include <sys/wait.h>#define PROCESS_NUM 5 // 进程池大小int main() {pid_t pid;int i;int pipefd[PROCESS_NUM][2]; // 用于主进程和工作进程通信的管道// 创建进程池for (i = 0; i < PROCESS_NUM; i++) {// 创建管道if (pipe(pipefd[i]) < 0) {perror("pipe error");exit(1);}// 创建子进程pid = fork();if (pid < 0) {perror("fork error");exit(1);} else if (pid == 0) { // 子进程close(pipefd[i][1]); // 关闭写端char buffer[256];int task_id;printf("Worker process %d started\n", i);// 工作进程循环等待任务while (1) {// 从管道读取任务ssize_t s = read(pipefd[i][0], &task_id, sizeof(task_id));if (s <= 0) {break; // 管道关闭或出错,退出循环}// 处理任务printf("Worker %d processing task %d\n", i, task_id);sleep(1); // 模拟任务处理时间printf("Worker %d completed task %d\n", i, task_id);}close(pipefd[i][0]);exit(0);} else { // 父进程close(pipefd[i][0]); // 关闭读端}}// 主进程分发任务for (int task_id = 1; task_id <= 10; task_id++) {// 简单的轮询方式分配任务int worker_id = (task_id - 1) % PROCESS_NUM;printf("Assigning task %d to worker %d\n", task_id, worker_id);write(pipefd[worker_id][1], &task_id, sizeof(task_id));usleep(500000); // 模拟任务到达间隔}// 等待一段时间让工作进程处理完任务sleep(5);// 关闭所有管道,通知工作进程退出for (i = 0; i < PROCESS_NUM; i++) {close(pipefd[i][1]);}// 等待所有子进程结束for (i = 0; i < PROCESS_NUM; i++) {wait(NULL);}printf("All workers have exited, main process exiting\n");return 0;}2. 基于共享内存的进程池

使用共享内存可以实现更高效的进程间通信,特别是当需要传输大量数据时。

// 共享内存结构定义struct shared_memory {int task_queue[MAX_TASKS];int front;int rear;int count;sem_t mutex; // 互斥访问共享内存的信号量sem_t slots; // 队列空槽位的信号量sem_t items; // 队列中任务数的信号量};// 主进程代码片段void master_process() {// 创建并初始化共享内存int shmid = shmget(IPC_PRIVATE, sizeof(struct shared_memory), IPC_CREAT | 0666);struct shared_memory *shm = (struct shared_memory*)shmat(shmid, NULL, 0);// 初始化信号量sem_init(&shm->mutex, 1, 1);sem_init(&shm->slots, 1, MAX_TASKS);sem_init(&shm->items, 1, 0);// 创建工作进程for (int i = 0; i < PROCESS_NUM; i++) {if (fork() == 0) {worker_process(shm, i);exit(0);}}// 添加任务到队列for (int task_id = 1; task_id <= 20; task_id++) {sem_wait(&shm->slots); // 等待空槽位sem_wait(&shm->mutex); // 获取互斥锁// 添加任务到队列shm->task_queue[shm->rear] = task_id;shm->rear = (shm->rear + 1) % MAX_TASKS;shm->count++;sem_post(&shm->mutex); // 释放互斥锁sem_post(&shm->items); // 增加任务计数}// 等待所有子进程结束for (int i = 0; i < PROCESS_NUM; i++) {wait(NULL);}// 清理共享内存和信号量shmdt(shm);shmctl(shmid, IPC_RMID, NULL);}// 工作进程代码片段void worker_process(struct shared_memory *shm, int worker_id) {while (1) {sem_wait(&shm->items); // 等待任务sem_wait(&shm->mutex); // 获取互斥锁// 从队列获取任务int task_id = shm->task_queue[shm->front];shm->front = (shm->front + 1) % MAX_TASKS;shm->count--;sem_post(&shm->mutex); // 释放互斥锁sem_post(&shm->slots); // 增加空槽位计数// 处理任务printf("Worker %d processing task %d\n", worker_id, task_id);sleep(1); // 模拟任务处理时间printf("Worker %d completed task %d\n", worker_id, task_id);// 检查是否需要退出if (task_id < 0) {break;}}}3. 预连接的进程池

在网络服务器中,可以使用预连接的进程池模式,每个工作进程都预先连接到主进程,等待任务分配。

// 预连接进程池的简化实现void preconnected_process_pool() {int listen_fd, conn_fd;int sockpairs[PROCESS_NUM][2]; // Unix域套接字对// 创建监听套接字listen_fd = socket(AF_INET, SOCK_STREAM, 0);// 绑定地址和端口bind(listen_fd, ...);// 开始监听listen(listen_fd, 5);// 创建工作进程for (int i = 0; i < PROCESS_NUM; i++) {// 创建Unix域套接字对socketpair(AF_UNIX, SOCK_STREAM, 0, sockpairs[i]);if (fork() == 0) { // 子进程close(sockpairs[i][0]); // 关闭父进程端close(listen_fd); // 子进程不需要监听套接字// 工作进程循环while (1) {// 等待主进程发送客户端连接描述符int client_fd;recv_fd(sockpairs[i][1], &client_fd);// 处理客户端请求handle_client(client_fd);close(client_fd);}exit(0);} else { // 父进程close(sockpairs[i][1]); // 关闭子进程端}}// 主进程循环接受连接并分发int next_worker = 0;while (1) {// 接受新连接conn_fd = accept(listen_fd, NULL, NULL);// 轮询方式选择工作进程send_fd(sockpairs[next_worker][0], conn_fd);next_worker = (next_worker + 1) % PROCESS_NUM;close(conn_fd); // 主进程不需要这个连接}}进程池的优化策略

1. 动态调整进程数量

根据系统负载动态调整进程池大小,可以更好地适应不同的工作负载。

// 动态调整进程池大小的示例代码void adjust_pool_size(int *current_size) {// 获取系统负载double load = get_system_load();// 根据负载调整进程池大小if (load > HIGH_THRESHOLD && *current_size < MAX_PROCESSES) {// 增加进程for (int i = 0; i < INCREMENT_SIZE; i++) {if (*current_size >= MAX_PROCESSES) break;create_worker_process();(*current_size)++;}printf("Increased pool size to %d\n", *current_size);} else if (load < LOW_THRESHOLD && *current_size > MIN_PROCESSES) {// 减少进程for (int i = 0; i < DECREMENT_SIZE; i++) {if (*current_size <= MIN_PROCESSES) break;terminate_worker_process();(*current_size)--;}printf("Decreased pool size to %d\n", *current_size);}}2. 任务优先级管理

实现任务优先级队列,确保重要任务优先处理。

// 带优先级的任务结构struct task {int id;int priority; // 优先级,数值越小优先级越高void *data;};// 优先级队列的简单实现void enqueue_task(struct task_queue *queue, struct task *task) {pthread_mutex_lock(&queue->mutex);// 找到合适的位置插入任务int i;for (i = queue->count - 1; i >= 0; i--) {if (queue->tasks[i].priority <= task->priority) {break;}queue->tasks[i + 1] = queue->tasks[i];}queue->tasks[i + 1] = *task;queue->count++;pthread_mutex_unlock(&queue->mutex);}3. 负载均衡策略

不同的负载均衡策略可以更有效地分配任务:

- 轮询(Round Robin):依次将任务分配给每个工作进程

- 最少连接:将任务分配给当前负载最轻的工作进程

- 加权轮询:根据工作进程的处理能力分配任务

// 最少连接负载均衡示例int least_connections_worker() {int min_tasks = workers[0].task_count;int selected_worker = 0;for (int i = 1; i < PROCESS_NUM; i++) {if (workers[i].task_count < min_tasks) {min_tasks = workers[i].task_count;selected_worker = i;}}return selected_worker;}进程池与线程池的比较

进程池和线程池是两种常见的并发处理模型,各有优缺点:

| 特性 | 进程池 | 线程池 |

|---|---|---|

| 隔离性 | 高(独立内存空间) | 低(共享内存空间) |

| 资源消耗 | 高 | 低 |

| 创建开销 | 大 | 小 |

| 上下文切换开销 | 大 | 小 |

| 通信方式 | IPC(较复杂) | 共享变量(简单) |

| 适用场景 | CPU密集型、需要高隔离性 | I/O密集型、需要频繁通信 |

进程池的应用场景

进程池在以下场景中特别有用:

- Web服务器:如Nginx、Apache等使用进程池处理并发HTTP请求

- 数据库服务器:如MySQL、PostgreSQL等使用进程池管理数据库连接

- 批处理系统:处理大量独立的计算任务

- 高可靠性系统:进程隔离可以防止单个任务崩溃影响整个系统

进程池的实际应用示例

Nginx的进程池模型

Nginx采用多进程模型,包含一个主进程和多个工作进程:

- 主进程负责读取配置、绑定端口、创建工作进程

- 工作进程负责处理实际的客户端请求

- 使用共享内存进行进程间通信

- 实现了优雅的进程重启机制

自定义HTTP服务器示例

以下是一个简化的HTTP服务器进程池实现:

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <signal.h>

#include <sys/wait.h>#define PORT 8080

#define PROCESS_NUM 4void handle_client(int client_fd) {char buffer[1024] = {0};read(client_fd, buffer, 1024);// 简单的HTTP响应char *response = "HTTP/1.1 200 OK\r\nContent-Type: text/html\r\n\r\n<html><body><h1>Hello from Process Pool Server!</h1></body></html>";write(client_fd, response, strlen(response));close(client_fd);

}void worker_process(int listen_fd) {while (1) {// 接受新连接struct sockaddr_in client_addr;socklen_t client_len = sizeof(client_addr);int client_fd = accept(listen_fd, (struct sockaddr*)&client_addr, &client_len);if (client_fd < 0) {perror("accept error");continue;}printf("Worker %d: Accepted new connection\n", getpid());handle_client(client_fd);}

}int main() {int server_fd;struct sockaddr_in address;// 创建套接字server_fd = socket(AF_INET, SOCK_STREAM, 0);if (server_fd == 0) {perror("socket failed");exit(EXIT_FAILURE);}// 设置套接字选项int opt = 1;setsockopt(server_fd, SOL_SOCKET, SO_REUSEADDR, &opt, sizeof(opt));// 绑定地址和端口address.sin_family = AF_INET;address.sin_addr.s_addr = INADDR_ANY;address.sin_port = htons(PORT);if (bind(server_fd, (struct sockaddr*)&address, sizeof(address)) < 0) {perror("bind failed");exit(EXIT_FAILURE);}// 开始监听if (listen(server_fd, 10) < 0) {perror("listen failed");exit(EXIT_FAILURE);}printf("Server started on port %d\n", PORT);// 创建工作进程for (int i = 0; i < PROCESS_NUM; i++) {pid_t pid = fork();if (pid < 0) {perror("fork error");exit(EXIT_FAILURE);} else if (pid == 0) { // 子进程printf("Worker process %d started\n", getpid());worker_process(server_fd);exit(0);}}// 主进程等待子进程结束for (int i = 0; i < PROCESS_NUM; i++) {wait(NULL);}return 0;

}进程池开发的最佳实践

- 合理设置进程池大小:通常设置为CPU核心数的1-2倍

- 实现优雅的进程重启:能够在不中断服务的情况下重启工作进程

- 健康检查机制:定期检查工作进程状态,及时重启异常进程

- 资源限制:为工作进程设置资源限制,防止单个进程消耗过多资源

- 日志与监控:实现完善的日志记录和监控机制,便于问题排查

总结

进程池是一种高效的并发处理模型,通过预先创建和重用进程,大大减少了进程创建和销毁的开销,提高了系统的并发处理能力。

对于初学者来说,理解进程池的工作原理和实现方式,是掌握高性能服务器开发的重要一步。从简单的基于fork()的实现开始,逐步学习更复杂的共享内存和预连接模型,最终能够根据实际需求设计和优化自己的进程池。

希望本文能帮助你理解Linux进程池的基本概念和实现方式,为你的高性能服务器开发之路打下坚实基础!