本地部署 DeepSeek R1(最新)【从下载、安装、使用和调用一条龙服务】

文章目录

- 一、安装 Ollama

- 1.1 下载

- 1.2 安装

- 二、下载 DeepSeek 模型

- 三、使用 DeepSeek

- 3.1 在命令行环境中使用

- 3.2 在第三方软件中使用

一、安装 Ollama

1.1 下载

官方网址:Ollama

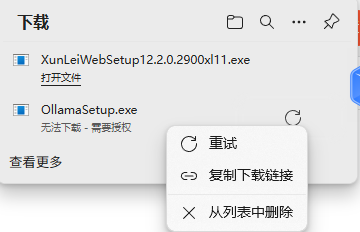

官网下载很慢,甚至出现了下载完显示 无法下载,需要授权

目前有两个解决方式:

-

复制下载链接,使用迅雷进行下载【右键点击正在下载文件,然后点击复制下载链接】

-

使用已经下载好的文件,这里分享一下我已经下载好的文件:attachment; filename=OllamaSetup.exe【如果没有会员,下载速度和官网半斤八两就是了】

1.2 安装

- 打开下载好的安装程序

- 点击

Install,等待安装

- 安装完成后,可以验证一下,是否安装成功,打开命令行【

win +R,输入cmd】,输入ollama如果出现下面信息,则安装成功!

二、下载 DeepSeek 模型

- 访问官网:Ollama ,点击

Models,在点击deepseek-r1

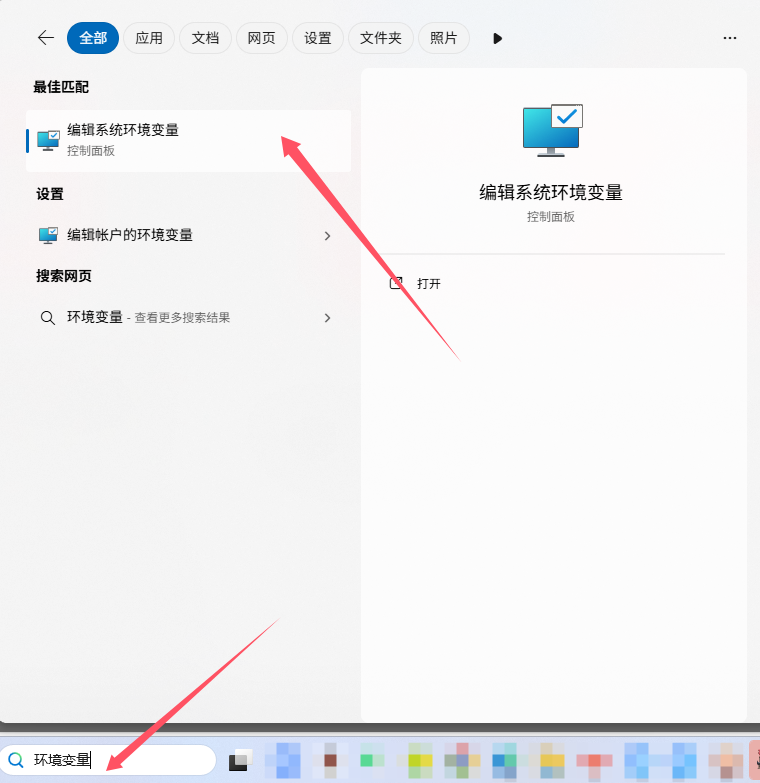

- 在下载之前最好先配置一下环境变量,ollama 默认是下载在

C盘的,如果要换盘,则需要添加环境变量。- 在搜索框中搜索 环境变量,并点击。

- 在 高级 模块,点击 环境变量

- 在 系统变量 模块,点击 新建

- 变量名必须为

OLLAMA_MODELS,变量值可以选择其他盘的一个文件夹【就是你想指定的下载位置】,输入完点击 确定 。

【配置完重启一下 ollama 】

【这个变量只能控制模型的下载位置,不能控制 ollama 的下载位置,就算先添加变量,ollama 还是安装在 C 盘,有点蠢的设计】

- 在搜索框中搜索 环境变量,并点击。

- 对于自己的私人电脑,后几个模型就不用考虑了,电脑一般带不动。

【一般来说,deepseek-r1:xb 中,x 数字越大,模型能力就越强,需要的资源就越大】

【一个简单的判断方法就是,看显卡的显存和 Size 进行比较,一般 Size 小于等于显存是比较好的】

【当然实际也可以安装超过显存的,只要内存+显存大于等于 Size 就行,就是可能速度比较慢】【没有显卡那就只能靠内存了】

- 选择好要下载模型,点击进入到对应模型界面,复制 模型下载指令【我这里选择的是 14 b,记得要安装自己电脑的配置选择】

- 将复制的命令输入到

cmd中【win + R,输入cmd,即可打开cmd界面】,等待下载

- 出现

success一般就表示安装成功了!

- 可以

Ctrl + d退出使用,然后输入ollama list,可以查看自己已经下载的模型。

三、使用 DeepSeek

3.1 在命令行环境中使用

- 打开命令行【win + R ,输入 cmd】,输入命令

ollama run deepseek-r1:14b

【如果是其他模型,改一下参数,比如如果是 8b,则输入命令ollama run deepseek-r1:8b】

- 输入你的问题

【简单问题,一般就直接回答出来了,如 ① 所示】

【复杂问题,就需要进行思考,然后回答,如 ② 所示】

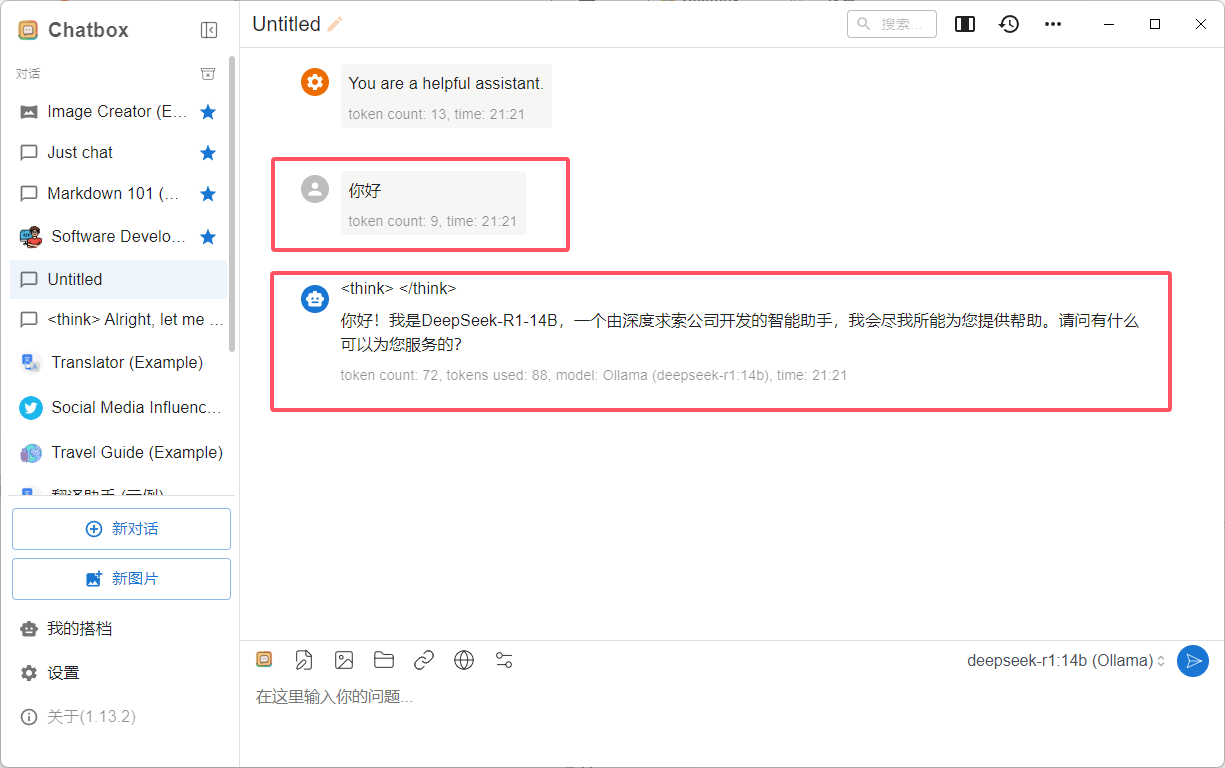

3.2 在第三方软件中使用

【可以在第三方软件中接入 API ,例如:Chatbox AI】

【如果想在其他第三方软件中使用,具体可以查看官方的 API 接口文档:Ollama API】

- 访问官网:Chatbox AI,下载 Chatbox AI ,

- 打开下载好的安装程序,点击 下一步

- 修改 安装位置,点击 安装 ,等待安装完成

- 点击 完成 ,顺便打开 Chatbox

- 点击 选用自己的 API Key 或者本地模型

- 选择 Ollama API

- 输入 API 地址,点击 获取

- 选择自己安装的模型,点击

+号即可

- 点击新对话

- 就可以进行正常使用