LangGraph framework

目录

- Agent 架构

- Router(路由)

- 工具调用代理(Tool-calling Agent)

- 工具调用

- 记忆机制(Memory)

- 规划机制(Planning)

- 自定义 Agent 架构

- 人类参与(Human-in-the-loop)

- 并行化(Parallelization)

- 子图(Subgraphs)

- 反思机制(Reflection)

- 工作流与智能体(Workflows and Agents)

- 构建模块:增强型大语言模型(Augmented LLM)

- 提示链(Prompt chaining)

- 并行处理(Parallelization)

- 路由(Routing)

- 协调者-执行者(Orchestrator-Worker)

- 评估者-优化者(Evaluator-optimizer)

- Agent(智能体)

- Graphs

- Graph API

- StateGraph

- State

- Schema

- Reducers

- 图状态中的消息处理

- 在图中使用消息

- 序列化

- MessagesState

- 节点(Nodes)

- START 节点

- END 节点

- 节点缓存(Node Caching)

- 边(Edges)

- 普通边(Normal Edges)

- 条件边(Conditional Edges)

- 入口点(Entry Point)

- 条件入口点(Conditional Entry Point)

- Send(发送)

- Command(命令对象)

- 配置

- 递归限制

- LangGraph 运行时

- 如何使用 Graph API

- 定义与更新状态

- 定义状态

- 更新状态

- 使用 Reducer 处理状态更新

- 定义输入与输出 Schema

- 在节点之间传递私有状态

- 使用 Pydantic 模型作为状态

- 添加运行时配置

- 添加重试策略(Add retry policies)

- 添加节点缓存

- 创建步骤序列

- 创建分支

- 并行运行图节点

- 延迟节点执行

- 条件分支

- Map-Reduce 与 Send API

- 创建和控制循环

- 设置递归限制

- 异步(Async)

- 结合控制流和状态更新 —— 使用 Command

- 在父图中导航到某个节点

- 使用工具内部更新状态

- 可视化你的图

- Mermaid

- PNG 格式

- 流式传输(Streaming)

- 流式输出API(Stream outputs)

- 流式传输图状态(Stream graph state)

- 子图支持(Subgraphs)

- 调试模式(Debugging)

- LLM Tokens(语言模型 Token)

- 按 LLM 调用标签过滤(Filter by LLM invocation)

- 按节点过滤(Filter by node)

- 流式传输自定义数据(Stream custom data)

- 使用任意 LLM(Use with any LLM)

- 针对特定聊天模型禁用流式传输

- 持久化

- 概念

- 线程

- 检查点

- 获取状态

- 获取状态历史

- Replay

- 更新状态(Update state)

- 内存存储(Memory Store)

- Checkpointer 库

- Checkpointer 接口

- 序列化器(Serializer)

- 添加持久化

- 添加短期内存

- 使用子图(Subgraphs)

- 在 Functional API 中使用短期内存【可选】

- 管理检查点

- 添加长期内存

- 生产环境中使用长期存储

- 使用语义搜索

- 内存(Memory)

- 概念

- 短期内存

- 管理长对话历史

- 编辑消息列表

- 总结历史对话

- 何时删除消息

- 长期记忆

- 记忆类型

- 语义记忆

- 情景记忆

- 程序记忆

- 写入记忆

- 管理记忆(Manage memory)

- 裁剪消息(Trim messages)

- 摘要消息(Summarize messages)

- 删除消息(Delete messages)

- 人类参与环节(Human-in-the-loop)

- 添加人类参与环节

- interrupt 函数

- 设计范式

- 批准或拒绝

- 审核并编辑状态

- 工具调用审核

- 验证人工输入

- 使用 Command 原语继续执行

- 常见误区

- 副作用

- 作为函数调用的子图

- 使用多个 interrupt

- 断点(Breakpoints)

- 静态断点

- 动态断点

- 与子图一起使用

- 时间旅行

- 工具(Tools)

- 使用工具(Use tools)

- 创建工具(Create tools)

- 访问配置(Access config)

- 短期记忆(Short-term memory)

- 读取状态(Read state)

- 更新状态(Update state)

- 长期记忆(Long-term memory)

- 读取长期记忆

- 更新长期记忆

- 将工具附加到模型(Attach tools to a model)

- 使用工具(Use tools)

- 使用预构建 Agent(Use prebuilt agent)

- 使用预设 ToolNode

- 错误处理

- 处理大量工具

Agent 架构

许多 LLM 应用在调用大语言模型前或后,会实现特定的控制流程。例如,RAG(检索增强生成)在模型调用前会检索与用户问题相关的文档,并将这些文档传递给 LLM,从而让模型的回答基于文档上下文。

有时我们不想写死固定的控制流程,而是希望 LLM 系统自行选择流程来解决更复杂的问题。这就是“代理(Agent)”的一种定义:代理是一个使用 LLM 决定应用控制流程的系统。LLM 控制应用的方式有很多:

- LLM 可以在两个路径间进行选择

- LLM 可以决定调用哪个工具

- LLM 可以判断当前结果是否足够,是否需要进一步处理

因此,存在多种不同的代理架构,LLM 在其中拥有不同程度的控制权。

Router(路由)

Router 允许 LLM 在一组预定义选项中选择一个步骤。它体现了一种控制权相对有限的代理架构,因为模型只做出一次决策,并从一组有限的选项中选择输出。Router 通常依赖几个关键概念来实现。

结构化输出通过指定格式或模式,让 LLM 以特定方式作答。它与工具调用类似但更通用。结构化输出常见实现方式包括:

- Prompt Engineering:通过提示词指引模型以特定格式作答

- 输出解析器(Output Parsers):对模型输出进行后处理以提取结构化数据

- 工具调用:使用支持结构化输入输出的 LLM 工具调用能力

结构化输出对于 Router 很关键,它确保模型决策可被系统可靠解析和执行。

工具调用代理(Tool-calling Agent)

相比 Router,工具调用代理扩展了模型的两个关键能力:

- 多步骤决策能力:模型可以进行一系列连续决策

- 工具访问能力:模型可调用多个不同的工具完成任务

ReAct 架构(论文:https://arxiv.org/abs/2210.03629)是一个流行的通用代理架构,它结合了以下三大核心概念:

- 工具调用:允许模型选择并调用外部工具

- 记忆能力(Memory):让代理保留并使用先前步骤中的信息

- 规划能力(Planning):使模型能够制定并执行多步骤计划以达成目标

这种架构使代理行为更复杂灵活,能进行动态问题求解。现代代理基于消息流实现,借助 LLM 的工具调用能力。

在 LangGraph 中,你可以使用预构建的代理快速开始构建工具调用型代理。

工具调用

当代理需要与外部系统(如 API)交互时,工具就派上用场了。外部系统通常要求特定格式的输入,而非自然语言。当我们将某个 API 绑定为工具时,就为模型提供了其输入 schema 的认知。模型会根据用户的自然语言输入选择合适的工具,并生成符合格式要求的输入。

许多 LLM 提供商支持工具调用,LangChain 中的工具接口也很简单:你可以将任何 Python 函数传给 ChatModel.bind_tools(function) 即可。

记忆机制(Memory)

记忆对代理至关重要,使其能在多步骤任务中保持上下文。记忆可分为:

- 短期记忆:记录当前会话中的中间信息

- 长期记忆:存储跨会话的信息,如过往的消息历史

LangGraph 提供了对记忆机制的完整控制:

- State:用户自定义的 schema,定义要保留的记忆结构

- Checkpointer:在每一步中持久化状态,用于会话间同步

- Store:用于存储用户级或应用级的全局数据

通过这些机制,你可以灵活实现所需的记忆功能。具体参考教程:如何为图添加记忆。

良好的记忆管理能提升代理的上下文保持能力,增强学习能力,并做出更明智的决策。

规划机制(Planning)

在工具调用型代理中,LLM 通常运行在一个 while 循环中。每一步模型都会:

- 决定调用哪些工具

- 给出这些工具的输入

- 执行工具调用

- 接收返回结果作为观察反馈,继续下一轮调用

这个循环会在模型判断“已有足够信息”时停止,不再继续调用工具。

自定义 Agent 架构

除了常见的 Router 与工具调用代理(如 ReAct),在具体任务中构建自定义代理架构常常能带来更优的性能。LangGraph 提供以下特性支持定制化开发。

人类参与(Human-in-the-loop)

人类参与对于提高代理可靠性至关重要,尤其在敏感任务中。人类可以:

- 审核某些行为

- 提供反馈以更新代理状态

- 在复杂判断中提供指导

在无法完全自动化的场景中,这种模式尤为重要。详见:Human-in-the-loop 指南。

并行化(Parallelization)

并行处理对多代理系统和复杂任务非常重要。LangGraph 的 Send API 支持:

- 并发处理多个状态

- 实现 map-reduce 类型操作

- 高效处理互不依赖的子任务

参考教程:Map-Reduce 架构实现

子图(Subgraphs)

在多代理系统中,子图对管理复杂架构很有帮助:

- 为各个子代理提供独立状态管理

- 实现代理团队的分层结构

- 控制主图与子图之间的数据交换

子图通过共享状态 schema 的部分字段与主图通信,从而实现灵活、模块化的代理设计。可参考:子图使用指南。

反思机制(Reflection)

反思机制可提升代理的稳健性:

- 检查任务是否完成、结果是否正确

- 提供改进反馈,实现迭代优化

- 实现自我纠错与学习

反思可以由 LLM 实现,也可以基于确定性机制。例如在编程任务中,可通过编译错误作为反馈信号。参见示例视频:LangGraph 自我纠错生成代码。

通过灵活使用这些功能,LangGraph 可构建出功能强大、任务专用的代理系统,支持复杂流程、代理协作、自我改进等高级行为。

工作流与智能体(Workflows and Agents)

本指南回顾了智能体系统(agentic systems)中的常见模式。在描述这些系统时,区分“工作流”与“智能体”是非常有帮助的。Anthropic 在其博客《Building Effective Agents》中很好地阐明了这一区别:

- 工作流是指通过预定义的代码路径来编排 LLM 和工具的系统。

- 智能体则是 LLM 动态引导其自身流程和工具使用的系统,具备对任务完成方式的控制能力。

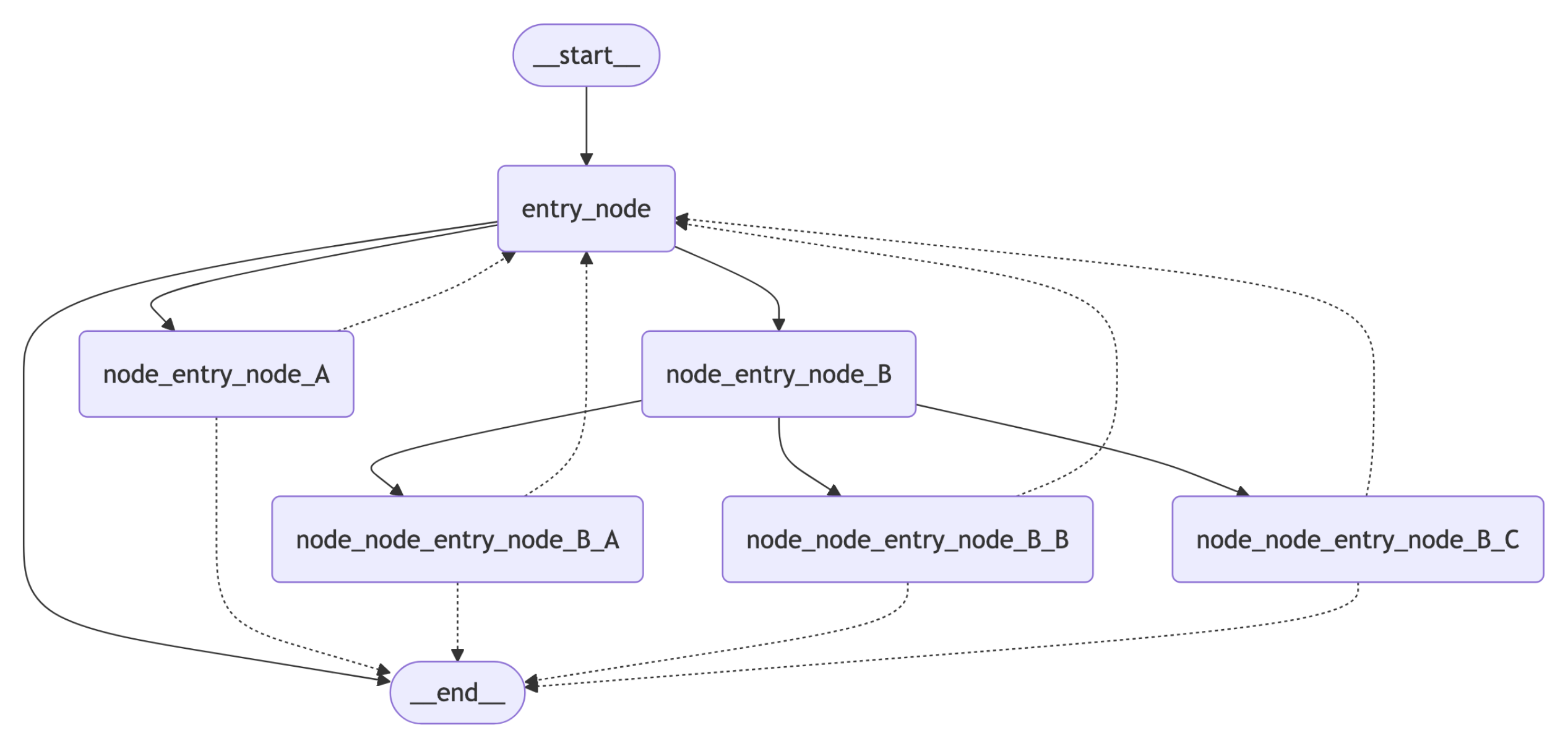

以下是一个简单的方式来可视化这两者的区别:

构建智能体与工作流时,LangGraph 提供了以下优势:

- 持久化(Persistence)

- 流式处理(Streaming)

- 调试支持(Debugging)

- 部署能力(Deployment)

你可以使用任何支持结构化输出与工具调用的聊天模型。以下是使用 Anthropic 模型时的依赖安装、API Key 设置、结构化输出和工具调用测试流程。

安装依赖

pip install langchain langchain-anthropic

初始化 LLM

import os

import getpass

from langchain_anthropic import ChatAnthropicdef _set_env(var: str):if not os.environ.get(var):os.environ[var] = getpass.getpass(f"{var}: ")_set_env("ANTHROPIC_API_KEY")llm = ChatAnthropic(model="claude-3-5-sonnet-latest")

构建模块:增强型大语言模型(Augmented LLM)

大语言模型(LLM)拥有一些增强能力,可用于构建工作流和智能体。这些增强包括结构化输出(Structured Outputs)和工具调用(Tool Calling),如下图所示,摘自 Anthropic 的博客《Building Effective Agents》:

# Schema for structured output

from pydantic import BaseModel, Fieldclass SearchQuery(BaseModel):search_query: str = Field(None, description="Query that is optimized web search.")justification: str = Field(None, description="Why this query is relevant to the user's request.")# Augment the LLM with schema for structured output

structured_llm = llm.with_structured_output(SearchQuery)# Invoke the augmented LLM

output = structured_llm.invoke("How does Calcium CT score relate to high cholesterol?")# Define a tool

def multiply(a: int, b: int) -> int:return a * b# Augment the LLM with tools

llm_with_tools = llm.bind_tools([multiply])# Invoke the LLM with input that triggers the tool call

msg = llm_with_tools.invoke("What is 2 times 3?")# Get the tool call

msg.tool_calls

提示链(Prompt chaining)

在提示链中,每次 LLM 调用都会处理上一步的输出。

正如 Anthropic 的博客《Building Effective Agents》中所指出的:

提示链将一个任务分解为一系列步骤,每一步由一个 LLM 调用完成,处理的是上一步的输出。你可以在任意中间步骤中添加编程式校验(参见下图中的“gate”)以确保流程仍在正确轨道上。

何时使用此工作流: 当任务可以被清晰地拆解为固定的子任务时,这种工作流非常适用。其主要目标是在牺牲一些延迟的情况下换取更高的准确率 —— 因为每一步 LLM 的处理任务都更简单。

图形 API(Graph API):

from typing_extensions import TypedDict

from langgraph.graph import StateGraph, START, END

from IPython.display import Image, display# Graph state

class State(TypedDict):topic: strjoke: strimproved_joke: strfinal_joke: str# Nodes

def generate_joke(state: State):"""First LLM call to generate initial joke"""msg = llm.invoke(f"Write a short joke about {state['topic']}")return {"joke": msg.content}def check_punchline(state: State):"""Gate function to check if the joke has a punchline"""# Simple check - does the joke contain "?" or "!"if "?" in state["joke"] or "!" in state["joke"]:return "Pass"return "Fail"def improve_joke(state: State):"""Second LLM call to improve the joke"""msg = llm.invoke(f"Make this joke funnier by adding wordplay: {state['joke']}")return {"improved_joke": msg.content}def polish_joke(state: State):"""Third LLM call for final polish"""msg = llm.invoke(f"Add a surprising twist to this joke: {state['improved_joke']}")return {"final_joke": msg.content}# Build workflow

workflow = StateGraph(State)# Add nodes

workflow.add_node("generate_joke", generate_joke)

workflow.add_node("improve_joke", improve_joke)

workflow.add_node("polish_joke", polish_joke)# Add edges to connect nodes

workflow.add_edge(START, "generate_joke")

workflow.add_conditional_edges("generate_joke", check_punchline, {"Fail": "improve_joke", "Pass": END}

)

workflow.add_edge("improve_joke", "polish_joke")

workflow.add_edge("polish_joke", END)# Compile

chain = workflow.compile()# Show workflow

display(Image(chain.get_graph().draw_mermaid_png()))# Invoke

state = chain.invoke({"topic": "cats"})

print("Initial joke:")

print(state["joke"])

print("\n--- --- ---\n")

if "improved_joke" in state:print("Improved joke:")print(state["improved_joke"])print("\n--- --- ---\n")print("Final joke:")print(state["final_joke"])

else:print("Joke failed quality gate - no punchline detected!")

函数式 API(Functional API):

from langgraph.func import entrypoint, task# Tasks

@task

def generate_joke(topic: str):"""First LLM call to generate initial joke"""msg = llm.invoke(f"Write a short joke about {topic}")return msg.contentdef check_punchline(joke: str):"""Gate function to check if the joke has a punchline"""# Simple check - does the joke contain "?" or "!"if "?" in joke or "!" in joke:return "Fail"return "Pass"@task

def improve_joke(joke: str):"""Second LLM call to improve the joke"""msg = llm.invoke(f"Make this joke funnier by adding wordplay: {joke}")return msg.content@task

def polish_joke(joke: str):"""Third LLM call for final polish"""msg = llm.invoke(f"Add a surprising twist to this joke: {joke}")return msg.content@entrypoint()

def prompt_chaining_workflow(topic: str):original_joke = generate_joke(topic).result()if check_punchline(original_joke) == "Pass":return original_jokeimproved_joke = improve_joke(original_joke).result()return polish_joke(improved_joke).result()# Invoke

for step in prompt_chaining_workflow.stream("cats", stream_mode="updates"):print(step)print("\n")

Prompt chaining 的核心思想是把一个任务分解成多个步骤,每一步用一次 LLM 调用来完成,下一步的输入依赖于上一步的输出。

就像在流水线上,每个工人(LLM)都只做一小部分工作,最后拼出完整的产品。

比如你想让 LLM 写一篇博客:

- 第一步:让 LLM 根据标题生成提纲

- 第二步:用提纲写段落草稿

- 第三步:润色草稿,生成最终版本

这就是一个 prompt chaining 流程。每个步骤是一个 LLM 调用,前一步的结果喂给下一步。

Anthropic 的博客强调了两点:

-

提示链可以让任务更容易处理

一次性叫 LLM 写整篇文章难度很大,但把它拆成 3 步,每步任务都更简单,结果反而可能更好。 -

你可以在中间步骤插入程序逻辑做“检查”

比如你可以在“提纲生成”后加个判断逻辑:提纲是否包含至少 3 个要点?不合格就让 LLM 重写。这种机制叫 gate(门)。

什么时候适合用 Prompt Chaining?

- 任务是 线性步骤(不能乱序)

- 每步逻辑相对清晰

- 希望提高 准确率或可靠性

- 不介意多花一些延迟时间(因为多次 LLM 调用)

如果任务流程会分叉(比如调用不同工具、需要多轮决策),那就不适合用 prompt chaining,而需要更复杂的 agent 架构 或 LangGraph 之类的图调度模型。

Prompt chaining 是最简单的 agent 架构,用多个 LLM 调用组成一个固定顺序的任务处理链,可以插入逻辑检查提升可靠性,适用于流程简单但对准确率有要求的任务。

并行处理(Parallelization)

通过并行处理,多个 LLM 可以同时协作完成任务:

LLM 有时可以同时处理一个任务,并通过程序将它们的输出聚合起来。这种工作流程被称为并行化(parallelization),主要有两种形式:

- 任务分段(Sectioning):将任务拆解为相互独立的子任务,并行执行。

- 投票机制(Voting):对同一个任务运行多次,获取多样化的输出。

适用场景:

- 当子任务可以独立并行执行,以提高处理速度。

- 当任务需要从多个角度出发,或需要多次尝试以获得更高置信度的结果。

对于需要多方面考虑的复杂任务,让每个方面分别由独立的 LLM 调用处理,往往能带来更好的表现,因为每次调用都能专注于某一个具体方面。

假设你想用 LLM 写一篇电影评论,但希望从剧情、表演、视觉效果这三个不同角度来分析。

传统顺序做法(串行):

- 先让 LLM 写剧情点评

- 再让 LLM 写表演点评

- 最后写视觉效果点评

- 把三部分合成一篇评论

并行处理做法:

- 把任务拆成3个独立子任务,分别给3个 LLM 同时写剧情、表演和视觉效果点评

- 三个 LLM 同时工作,互不干扰,节省时间

- 把3个输出合起来,组成完整评论

好处:

- 更快:因为三个部分同时写,不用等前一个完成才开始后一个

- 更专注:每个 LLM 只关注一个角度,输出更精准

再举一个投票机制的例子:

你让 LLM 给“这部电影值得推荐吗?”这个问题回答3次,得到3个答案,分别是:

- 是,很精彩

- 还可以,有优点也有缺点

- 不推荐,剧情无聊

然后你通过程序“投票”决定最终答案,比如取出现频率最高的那个,或者综合分析这三个答案的理由。

这样,并行处理就帮你同时多方面探索问题,最后综合结果,既提高效率,也提升了答案质量。

Graph API:

# Graph state

class State(TypedDict):topic: strjoke: strstory: strpoem: strcombined_output: str# Nodes

def call_llm_1(state: State):"""First LLM call to generate initial joke"""msg = llm.invoke(f"Write a joke about {state['topic']}")return {"joke": msg.content}def call_llm_2(state: State):"""Second LLM call to generate story"""msg = llm.invoke(f"Write a story about {state['topic']}")return {"story": msg.content}def call_llm_3(state: State):"""Third LLM call to generate poem"""msg = llm.invoke(f"Write a poem about {state['topic']}")return {"poem": msg.content}def aggregator(state: State):"""Combine the joke and story into a single output"""combined = f"Here's a story, joke, and poem about {state['topic']}!\n\n"combined += f"STORY:\n{state['story']}\n\n"combined += f"JOKE:\n{state['joke']}\n\n"combined += f"POEM:\n{state['poem']}"return {"combined_output": combined}# Build workflow

parallel_builder = StateGraph(State)# Add nodes

parallel_builder.add_node("call_llm_1", call_llm_1)

parallel_builder.add_node("call_llm_2", call_llm_2)

parallel_builder.add_node("call_llm_3", call_llm_3)

parallel_builder.add_node("aggregator", aggregator)# Add edges to connect nodes

parallel_builder.add_edge(START, "call_llm_1")

parallel_builder.add_edge(START, "call_llm_2")

parallel_builder.add_edge(START, "call_llm_3")

parallel_builder.add_edge("call_llm_1", "aggregator")

parallel_builder.add_edge("call_llm_2", "aggregator")

parallel_builder.add_edge("call_llm_3", "aggregator")

parallel_builder.add_edge("aggregator", END)

parallel_workflow = parallel_builder.compile()# Show workflow

display(Image(parallel_workflow.get_graph().draw_mermaid_png()))# Invoke

state = parallel_workflow.invoke({"topic": "cats"})

print(state["combined_output"])

函数式API

@task

def call_llm_1(topic: str):"""First LLM call to generate initial joke"""msg = llm.invoke(f"Write a joke about {topic}")return msg.content@task

def call_llm_2(topic: str):"""Second LLM call to generate story"""msg = llm.invoke(f"Write a story about {topic}")return msg.content@task

def call_llm_3(topic):"""Third LLM call to generate poem"""msg = llm.invoke(f"Write a poem about {topic}")return msg.content@task

def aggregator(topic, joke, story, poem):"""Combine the joke and story into a single output"""combined = f"Here's a story, joke, and poem about {topic}!\n\n"combined += f"STORY:\n{story}\n\n"combined += f"JOKE:\n{joke}\n\n"combined += f"POEM:\n{poem}"return combined# Build workflow

@entrypoint()

def parallel_workflow(topic: str):joke_fut = call_llm_1(topic)story_fut = call_llm_2(topic)poem_fut = call_llm_3(topic)return aggregator(topic, joke_fut.result(), story_fut.result(), poem_fut.result()).result()# Invoke

for step in parallel_workflow.stream("cats", stream_mode="updates"):print(step)print("\n")

我们注意到这里的状态机是没有messages字段的,为什么这个示例没有用 messages?

- 这是一个基于函数式调用的示例,

llm.invoke(prompt)直接传入字符串 prompt,返回一个响应。 - 它把每个步骤的输出直接存储在

State里(如 joke/story/poem),并用状态图管理任务节点之间的依赖关系。 - 这种方式更像是传统的“调用接口拿结果,存储状态”的工作流,不是基于对话上下文传递 messages。

状态机是否必须有 messages 字段?

- 不一定。

- 有的系统或库设计上用

messages作为状态,因为它是对话模型核心的上下文单元(特别是基于 ChatCompletion 的模型)。 - 但也可以用纯结构化字段来管理状态,只要你调用 LLM 的接口支持纯文本 prompt,这种设计就行得通。

这里是两种不同思路的区别:

| 方面 | 基于 messages 的状态机 | 基于结构化 State 的工作流 |

|---|---|---|

| 状态表现 | 通过 messages 数组体现对话历史 | 用 State 的字段体现任务结果、数据 |

| LLM 调用 | 通常是 chat.completions.create(messages=...) | 直接调用 llm.invoke(prompt_string) |

| 优势 | 方便对话式上下文管理 | 灵活处理非对话类任务,状态字段清晰,易编排 |

| 使用场景 | 需要上下文连续、多轮对话 | 独立任务节点结果处理,适合多任务并行和聚合 |

路由(Routing)

路由对输入进行分类,并将其引导到后续的专门任务。正如 Anthropic 在《构建高效代理》一文中所指出的:

路由会对输入进行分类,并将其引导到一个专门的后续任务。该工作流允许关注点分离,构建更专业化的提示语。没有这种工作流,为某一类输入进行优化可能会影响对其他输入的表现。

何时使用此工作流:路由适用于复杂任务中存在明显类别且这些类别更适合分别处理的情况,且分类能够被准确处理(无论是由大型语言模型还是传统的分类模型/算法完成)。

from typing_extensions import Literal

from langchain_core.messages import HumanMessage, SystemMessage# Schema for structured output to use as routing logic

class Route(BaseModel):step: Literal["poem", "story", "joke"] = Field(None, description="The next step in the routing process")# Augment the LLM with schema for structured output

router = llm.with_structured_output(Route)# State

class State(TypedDict):input: strdecision: stroutput: str# Nodes

def llm_call_1(state: State):"""Write a story"""result = llm.invoke(state["input"])return {"output": result.content}def llm_call_2(state: State):"""Write a joke"""result = llm.invoke(state["input"])return {"output": result.content}def llm_call_3(state: State):"""Write a poem"""result = llm.invoke(state["input"])return {"output": result.content}def llm_call_router(state: State):"""Route the input to the appropriate node"""# Run the augmented LLM with structured output to serve as routing logicdecision = router.invoke([SystemMessage(content="Route the input to story, joke, or poem based on the user's request."),HumanMessage(content=state["input"]),])return {"decision": decision.step}# Conditional edge function to route to the appropriate node

def route_decision(state: State):# Return the node name you want to visit nextif state["decision"] == "story":return "llm_call_1"elif state["decision"] == "joke":return "llm_call_2"elif state["decision"] == "poem":return "llm_call_3"# Build workflow

router_builder = StateGraph(State)# Add nodes

router_builder.add_node("llm_call_1", llm_call_1)

router_builder.add_node("llm_call_2", llm_call_2)

router_builder.add_node("llm_call_3", llm_call_3)

router_builder.add_node("llm_call_router", llm_call_router)# Add edges to connect nodes

router_builder.add_edge(START, "llm_call_router")

router_builder.add_conditional_edges("llm_call_router",route_decision,{ # Name returned by route_decision : Name of next node to visit"llm_call_1": "llm_call_1","llm_call_2": "llm_call_2","llm_call_3": "llm_call_3",},

)

router_builder.add_edge("llm_call_1", END)

router_builder.add_edge("llm_call_2", END)

router_builder.add_edge("llm_call_3", END)# Compile workflow

router_workflow = router_builder.compile()# Show the workflow

display(Image(router_workflow.get_graph().draw_mermaid_png()))# Invoke

state = router_workflow.invoke({"input": "Write me a joke about cats"})

print(state["output"])

协调者-执行者(Orchestrator-Worker)

在协调者-执行者模式中,协调者将任务拆解,并将每个子任务分配给执行者。如 Anthropic 在《构建高效代理》一文中所述:

在协调者-执行者工作流中,中央的 LLM 动态拆分任务,将其委派给多个执行者 LLM,并综合它们的结果。

何时使用此工作流:该工作流非常适合于无法预先确定所需子任务的复杂任务(例如在编程中,需要修改的文件数量以及每个文件修改的内容通常依赖于具体任务)。虽然在结构上与并行化类似,但其关键区别在于灵活性——子任务不是预先定义的,而是由协调者根据具体输入动态决定。

from typing import Annotated, List

import operator# Schema for structured output to use in planning

class Section(BaseModel):name: str = Field(description="Name for this section of the report.",)description: str = Field(description="Brief overview of the main topics and concepts to be covered in this section.",)class Sections(BaseModel):sections: List[Section] = Field(description="Sections of the report.",)# Augment the LLM with schema for structured output

planner = llm.with_structured_output(Sections)

在 LangGraph 中创建执行者(Workers)

由于协调者-执行者工作流非常常见,LangGraph 提供了 Send API 来支持这一模式。它允许你动态创建执行者节点,并向每个执行者发送特定的输入。每个执行者拥有自己的状态,所有执行者的输出都会写入一个共享的状态键,协调者图可以访问该键。这使协调者能够获取所有执行者的输出,并将它们综合成最终结果。

from langgraph.constants import Send# Graph state

class State(TypedDict):topic: str # Report topicsections: list[Section] # List of report sectionscompleted_sections: Annotated[list, operator.add] # 并行执行者写入这里final_report: str # Final report# Worker state

class WorkerState(TypedDict):section: Sectioncompleted_sections: Annotated[list, operator.add]# Nodes

def orchestrator(state: State):"""Orchestrator that generates a plan for the report"""# Generate queries# 用一个带结构化输出能力的 LLM planner,基于主题规划报告章节(返回章节列表)。report_sections = planner.invoke([SystemMessage(content="Generate a plan for the report."),HumanMessage(content=f"Here is the report topic: {state['topic']}"),])return {"sections": report_sections.sections}def llm_call(state: WorkerState):"""Worker writes a section of the report"""# Generate sectionsection = llm.invoke([SystemMessage(content="Write a report section following the provided name and description. Include no preamble for each section. Use markdown formatting."),HumanMessage(content=f"Here is the section name: {state['section'].name} and description: {state['section'].description}"),])# Write the updated section to completed sectionsreturn {"completed_sections": [section.content]}def synthesizer(state: State):"""Synthesize full report from sections"""# List of completed sectionscompleted_sections = state["completed_sections"]# Format completed section to str to use as context for final sectionscompleted_report_sections = "\n\n---\n\n".join(completed_sections)return {"final_report": completed_report_sections}# Conditional edge function to create llm_call workers that each write a section of the report

def assign_workers(state: State):"""Assign a worker to each section in the plan"""# Kick off section writing in parallel via Send() APIreturn [Send("llm_call", {"section": s}) for s in state["sections"]]# Build workflow

orchestrator_worker_builder = StateGraph(State)# Add the nodes

orchestrator_worker_builder.add_node("orchestrator", orchestrator)

orchestrator_worker_builder.add_node("llm_call", llm_call)

orchestrator_worker_builder.add_node("synthesizer", synthesizer)# Add edges to connect nodes

orchestrator_worker_builder.add_edge(START, "orchestrator")

orchestrator_worker_builder.add_conditional_edges("orchestrator", assign_workers, ["llm_call"]

)

orchestrator_worker_builder.add_edge("llm_call", "synthesizer")

orchestrator_worker_builder.add_edge("synthesizer", END)# Compile the workflow

orchestrator_worker = orchestrator_worker_builder.compile()# Show the workflow

display(Image(orchestrator_worker.get_graph().draw_mermaid_png()))# Invoke

state = orchestrator_worker.invoke({"topic": "Create a report on LLM scaling laws"})from IPython.display import Markdown

Markdown(state["final_report"])

评估者-优化者(Evaluator-optimizer)

在评估者-优化者工作流中,一个 LLM 调用生成响应,另一个则在循环中提供评估和反馈:

何时使用该工作流:当我们拥有明确的评估标准,且迭代改进能带来可衡量的价值时,这种工作流特别有效。适用的两个标志是:第一,当人工明确表达反馈时,LLM 的响应可以明显提升;第二,LLM 本身能提供这种反馈。这类似于人类作者在撰写精炼文档时所经历的反复迭代过程。

# Graph state

class State(TypedDict):joke: strtopic: strfeedback: strfunny_or_not: str# Schema for structured output to use in evaluation

class Feedback(BaseModel):grade: Literal["funny", "not funny"] = Field(description="Decide if the joke is funny or not.",)feedback: str = Field(description="If the joke is not funny, provide feedback on how to improve it.",)# Augment the LLM with schema for structured output

evaluator = llm.with_structured_output(Feedback)# Nodes

def llm_call_generator(state: State):"""LLM generates a joke"""if state.get("feedback"):msg = llm.invoke(f"Write a joke about {state['topic']} but take into account the feedback: {state['feedback']}")else:msg = llm.invoke(f"Write a joke about {state['topic']}")return {"joke": msg.content}def llm_call_evaluator(state: State):"""LLM evaluates the joke"""grade = evaluator.invoke(f"Grade the joke {state['joke']}")return {"funny_or_not": grade.grade, "feedback": grade.feedback}# Conditional edge function to route back to joke generator or end based upon feedback from the evaluator

def route_joke(state: State):"""Route back to joke generator or end based upon feedback from the evaluator"""if state["funny_or_not"] == "funny":return "Accepted"elif state["funny_or_not"] == "not funny":return "Rejected + Feedback"# Build workflow

optimizer_builder = StateGraph(State)# Add the nodes

optimizer_builder.add_node("llm_call_generator", llm_call_generator)

optimizer_builder.add_node("llm_call_evaluator", llm_call_evaluator)# Add edges to connect nodes

optimizer_builder.add_edge(START, "llm_call_generator")

optimizer_builder.add_edge("llm_call_generator", "llm_call_evaluator")

optimizer_builder.add_conditional_edges("llm_call_evaluator",route_joke,{ # Name returned by route_joke : Name of next node to visit"Accepted": END,"Rejected + Feedback": "llm_call_generator",},

)# Compile the workflow

optimizer_workflow = optimizer_builder.compile()# Show the workflow

display(Image(optimizer_workflow.get_graph().draw_mermaid_png()))# Invoke

state = optimizer_workflow.invoke({"topic": "Cats"})

print(state["joke"])

代码逻辑解释:

-

状态结构体(State)

包含当前笑话 (joke)、主题 (topic)、反馈 (feedback)、是否有趣 (funny_or_not) 等字段,贯穿整个流程。 -

生成节点(llm_call_generator)

LLM 根据主题生成一个笑话。如果有反馈,会基于反馈重新生成改进版本。 -

评估节点(llm_call_evaluator)

另一个 LLM 评估笑话是否“有趣”,并给出改进建议(反馈)。 -

条件路由(route_joke)

如果评估结果是“有趣”,流程结束;否则,带着反馈回到生成节点,重新生成改进笑话。 -

流程控制

- 初始从生成节点开始

- 生成笑话后,进入评估节点

- 评估结果决定是结束流程还是返回重新生成

这个示例想表达什么?

-

这是一个迭代循环流程:生成 → 评估 → 反馈 → 改进 → 重新生成 → …,直到满意为止。

-

两种角色分工:

- **生成者(Generator)**负责输出内容(比如笑话)

- **评估者(Evaluator)**负责评价输出的质量,给出反馈

适用场景举例

- 文本内容创作:写文章、故事、广告文案、代码片段等,生成后让模型评估质量并反馈改进建议。

- 自动化调优:模型自我检测输出错误或不足,循环改进直到符合标准。

- 复杂任务求解:每次输出一个方案,由另一个模块评价,保证结果逐步优化。

- 教学或训练辅助:模型作为学生写答案,另一个模型作为老师给反馈,引导改进。

这个工作流适合明确有评判标准,且能通过多轮迭代改进输出质量的任务。

Agent(智能体)

智能体通常是指基于大语言模型(LLM),在一个循环中根据环境反馈执行动作(通过调用工具)。正如 Anthropic 关于构建高效智能体的博客中所述:

智能体能够处理复杂任务,但其实现往往比较简单。它们通常只是利用工具,根据环境反馈循环调用 LLM。因此,设计工具集及其文档时,必须清晰且用心。

何时使用智能体:智能体适用于那些步骤数难以预测或无法硬编码固定路径的开放式问题。LLM 可能需要多轮操作,这时你需要对其决策能力有一定信任。智能体的自主性使它们非常适合在可信环境中扩展任务处理。

from langchain_core.tools import tool# Define tools

@tool

def multiply(a: int, b: int) -> int:"""Multiply a and b.Args:a: first intb: second int"""return a * b@tool

def add(a: int, b: int) -> int:"""Adds a and b.Args:a: first intb: second int"""return a + b@tool

def divide(a: int, b: int) -> float:"""Divide a and b.Args:a: first intb: second int"""return a / b# Augment the LLM with tools

tools = [add, multiply, divide]

tools_by_name = {tool.name: tool for tool in tools}

llm_with_tools = llm.bind_tools(tools)

图API

from langgraph.graph import MessagesState

from langchain_core.messages import SystemMessage, HumanMessage, ToolMessage# Nodes

def llm_call(state: MessagesState):"""LLM decides whether to call a tool or not"""return {"messages": [llm_with_tools.invoke([SystemMessage(content="You are a helpful assistant tasked with performing arithmetic on a set of inputs.")]+ state["messages"])]}def tool_node(state: dict):"""Performs the tool call"""result = []for tool_call in state["messages"][-1].tool_calls:tool = tools_by_name[tool_call["name"]]observation = tool.invoke(tool_call["args"])result.append(ToolMessage(content=observation, tool_call_id=tool_call["id"]))return {"messages": result}# Conditional edge function to route to the tool node or end based upon whether the LLM made a tool call

def should_continue(state: MessagesState) -> Literal["environment", END]:"""Decide if we should continue the loop or stop based upon whether the LLM made a tool call"""messages = state["messages"]last_message = messages[-1]# If the LLM makes a tool call, then perform an actionif last_message.tool_calls:return "Action"# Otherwise, we stop (reply to the user)return END# Build workflow

agent_builder = StateGraph(MessagesState)# Add nodes

agent_builder.add_node("llm_call", llm_call)

agent_builder.add_node("environment", tool_node)# Add edges to connect nodes

agent_builder.add_edge(START, "llm_call")

agent_builder.add_conditional_edges("llm_call",should_continue,{# Name returned by should_continue : Name of next node to visit"Action": "environment",END: END,},

)

agent_builder.add_edge("environment", "llm_call")# Compile the agent

agent = agent_builder.compile()# Show the agent

display(Image(agent.get_graph(xray=True).draw_mermaid_png()))# Invoke

messages = [HumanMessage(content="Add 3 and 4.")]

messages = agent.invoke({"messages": messages})

for m in messages["messages"]:m.pretty_print()

LangGraph 还提供了一个预构建的方法来创建上述定义的智能体(使用 create_react_agent 函数):

https://langchain-ai.github.io/langgraph/how-tos/create-react-agent/

from langgraph.prebuilt import create_react_agent# 传入:

# (1) 带工具增强的大语言模型(LLM)

# (2) 工具列表(用于创建工具节点)

pre_built_agent = create_react_agent(llm, tools=tools)# 显示智能体结构图

display(Image(pre_built_agent.get_graph().draw_mermaid_png()))# 调用智能体

messages = [HumanMessage(content="Add 3 and 4.")]

messages = pre_built_agent.invoke({"messages": messages})

for m in messages["messages"]:m.pretty_print()

Graphs

Graph API

LangGraph 核心是将智能体工作流建模为图结构。你通过三个关键组成部分定义智能体的行为:

-

State(状态):表示应用当前快照的共享数据结构。可以是任意 Python 类型,通常是 TypedDict 或 Pydantic BaseModel。

-

Nodes(节点):Python 函数,编码智能体的逻辑。它们接收当前 State 作为输入,执行计算或副作用,返回更新后的 State。

-

Edges(边):Python 函数,根据当前 State 决定下一个执行的节点。可以是条件分支或固定跳转。

通过组合节点和边,可以创建复杂且带有循环的工作流,使 State 随时间演化。LangGraph 的真正强大之处在于它如何管理 State。强调一点:节点和边本质上只是 Python 函数——它们可以包含大模型调用,也可以是普通的 Python 代码。

简而言之:

- 节点负责执行任务,

- 边负责指示下一步执行哪个节点。

LangGraph 底层的图算法使用消息传递来定义通用程序。节点完成操作后,沿一条或多条边发送消息到其他节点。接收节点执行其函数,将结果消息传递给下一组节点,循环往复。此机制受 Google Pregel 系统启发,程序以离散的“超级步”(super-step)进行。

超级步可以看作图节点的一次迭代。并行运行的节点属于同一超级步,顺序执行的节点属于不同超级步。执行开始时,所有节点处于非激活状态。节点在其任一入边(或“通道”)接收到新消息(状态)时被激活,执行函数并返回更新。每个超级步结束时,无入消息的节点投票停止,将自身标记为非激活。所有节点非激活且无消息传输时,图执行终止。

StateGraph

StateGraph 类是主要的图类,由用户定义的 State 对象参数化。

构建图时,先定义 State,再添加节点和边,最后进行编译。编译是什么,为什么需要?

编译过程很简单。它会对图结构做基本检查(例如无孤立节点等)。同时可在此指定运行时参数,如检查点和断点。调用 .compile 方法即可编译图:

graph = graph_builder.compile(...)

你必须先编译图,才能使用它。

State

定义图的第一步是定义图的 State(状态)。State 包含图的 schema(结构)和 reducer 函数,用于指定如何将更新应用到状态。State 的 schema 是图中所有节点(Nodes)和边(Edges)的输入结构,通常是 TypedDict 或 Pydantic 模型。所有节点都会输出对 State 的更新,这些更新通过指定的 reducer 函数进行应用。

Schema

定义图的 schema 主要用 TypedDict,也支持使用 Pydantic BaseModel,以便添加默认值和额外的数据校验。

默认情况下,图的输入输出 schema 相同。如果需要区分输入输出,可以显式指定输入和输出 schema。这在键较多且部分键专门用于输入,部分专门用于输出时非常有用。

通常,图中所有节点使用单一 schema,意味着它们读写相同的状态通道。但有时需要更细致控制:

- 内部节点可能传递图的输入/输出中不需要的信息。

- 可能想为图定义不同的输入/输出 schema,比如输出只包含一个关键字段。

- 节点可以写入图内部的私有状态通道,用于节点间内部通信。只需定义一个私有 schema,如 PrivateState,详见指南。

- 也可为图定义显式的输入和输出 schema,同时定义一个“内部” schema,包含所有与图操作相关的键。输入和输出 schema 是“内部” schema的子集,用于限制输入输出。

示例代码:

class InputState(TypedDict):user_input: strclass OutputState(TypedDict):graph_output: strclass OverallState(TypedDict):foo: struser_input: strgraph_output: strclass PrivateState(TypedDict):bar: strdef node_1(state: InputState) -> OverallState:return {"foo": state["user_input"] + " name"}def node_2(state: OverallState) -> PrivateState:return {"bar": state["foo"] + " is"}def node_3(state: PrivateState) -> OutputState:return {"graph_output": state["bar"] + " Lance"}builder = StateGraph(OverallState, input=InputState, output=OutputState)

builder.add_node("node_1", node_1)

builder.add_node("node_2", node_2)

builder.add_node("node_3", node_3)

builder.add_edge(START, "node_1")

builder.add_edge("node_1", "node_2")

builder.add_edge("node_2", "node_3")

builder.add_edge("node_3", END)graph = builder.compile()

graph.invoke({"user_input": "My"})

# 返回 {'graph_output': 'My name is Lance'}

这里有两个要点:

- 输入 schema 给 node_1 是 InputState,但 node_1 写出了 foo(OverallState 的通道)。这是因为节点可以写入图状态中定义的任意通道,图状态是初始化时所有状态通道的并集,包括 OverallState 和 InputState、OutputState。

- 图初始化时未传入 PrivateState,node_2 依然可以写入 PrivateState,这是因为只要定义了状态 schema,节点就能声明额外状态通道,图也能访问它们。

Reducers

Reducer 是理解节点更新如何应用到 State 的关键。State 中每个键都有独立的 reducer 函数。若未显式指定 reducer,则默认更新会直接覆盖该键。

以下两个例子展示了如何使用默认的 reducer:

示例 A:

from typing_extensions import TypedDictclass State(TypedDict):foo: intbar: list[str]# 假设图输入 {"foo": 1, "bar": ["hi"]}

# 节点返回 {"foo": 2},更新后 State 为 {"foo": 2, "bar": ["hi"]}

# 下一个节点返回 {"bar": ["bye"]},更新后 State 为 {"foo": 2, "bar": ["bye"]}

示例 B:

from typing import Annotated

from typing_extensions import TypedDict

from operator import addclass State(TypedDict):foo: intbar: Annotated[list[str], add]# 输入同上

# 节点1返回 {"foo": 2},更新后 State 为 {"foo": 2, "bar": ["hi"]}

# 节点2返回 {"bar": ["bye"]},更新后 State 为 {"foo": 2, "bar": ["hi", "bye"]}

# 这里 bar 键的更新是列表合并(add操作)

图状态中的消息处理

为什么用消息?

现代大模型提供的聊天接口接受消息列表作为输入。LangChain 的 ChatModel 接受 Message 对象列表输入,消息类型包括 HumanMessage(用户输入)、AIMessage(模型响应)等。

在图中使用消息

通常需要在图状态中存储对话历史消息列表。为此,可以在状态中添加一个消息列表键(通道),并用 reducer 函数进行注解(例如示例中的 messages 键)。reducer 告诉图如何用节点的更新修改消息列表。若无 reducer,状态更新会覆盖消息列表。想要追加消息,可以用 operator.add。

但若希望手动更新消息(如人工干预),用 operator.add 会导致追加而非替换消息。为避免此问题,可以用预置的 add_messages 函数。该函数对新消息追加,对已有消息根据 ID 覆盖更新。

序列化

add_messages 函数会尝试将消息反序列化为 LangChain Message 对象,支持以下输入格式:

{"messages": [HumanMessage(content="message")]}

{"messages": [{"type": "human", "content": "message"}]}

消息总会被反序列化为 Message 对象,因此访问消息属性应用点操作符,如 state["messages"][-1].content。

示例:

from langchain_core.messages import AnyMessage

from langgraph.graph.message import add_messages

from typing import Annotated

from typing_extensions import TypedDictclass GraphState(TypedDict):messages: Annotated[list[AnyMessage], add_messages]

MessagesState

因为消息列表很常用,已有预构建状态 MessagesState,内含 messages 键(AnyMessage 列表,使用 add_messages reducer)。通常状态还有其他字段,用户可继承该状态扩展更多字段:

from langgraph.graph import MessagesStateclass State(MessagesState):documents: list[str]

节点(Nodes)

在 LangGraph 中,节点通常是 Python 函数(同步或异步),第一个位置参数为状态(state),可选的第二个位置参数是一个 “config”,包含可选的配置参数(如 thread_id 等)。

与 NetworkX 类似,你可以使用 add_node 方法将这些节点添加到图中:

API 参考:

RunnableConfig|StateGraph

from langchain_core.runnables import RunnableConfig

from langgraph.graph import StateGraphbuilder = StateGraph(dict)def my_node(state: dict, config: RunnableConfig):print("In node: ", config["configurable"]["user_id"])return {"results": f"Hello, {state['input']}!"}# 第二个参数是可选的

def my_other_node(state: dict):return statebuilder.add_node("my_node", my_node)

builder.add_node("other_node", my_other_node)

在内部,这些函数会被转换为 RunnableLambda,它们为你的函数增加了批处理和异步支持,同时内置了跟踪和调试功能。

如果你添加节点时没有显式指定名称,它将使用函数名作为默认名称:

builder.add_node(my_node)

# 之后可以通过字符串 "my_node" 来连接该节点

START 节点

START 节点是一个特殊节点,表示用户输入流入图的入口节点。它的主要作用是确定图的起始节点:

from langgraph.graph import STARTgraph.add_edge(START, "node_a")

END 节点

END 节点是一个特殊节点,表示终止节点。你可以使用它来表示某些边在处理完后没有后续动作:

from langgraph.graph import ENDgraph.add_edge("node_a", END)

节点缓存(Node Caching)

LangGraph 支持基于输入的任务/节点缓存。使用缓存需要以下两个步骤:

- 在编译图(或指定入口点)时指定缓存;

- 为节点指定缓存策略(cache policy):

每个缓存策略支持以下内容:

key_func:用于根据节点输入生成缓存 key,默认使用pickle的哈希;ttl:缓存的有效时间(秒)。如果不指定,缓存将永久有效。

例如:

import time

from typing_extensions import TypedDict

from langgraph.graph import StateGraph

from langgraph.cache.memory import InMemoryCache

from langgraph.types import CachePolicyclass State(TypedDict):x: intresult: intbuilder = StateGraph(State)def expensive_node(state: State) -> dict[str, int]:# 耗时计算time.sleep(2)return {"result": state["x"] * 2}builder.add_node("expensive_node", expensive_node, cache_policy=CachePolicy(ttl=3))

builder.set_entry_point("expensive_node")

builder.set_finish_point("expensive_node")graph = builder.compile(cache=InMemoryCache())print(graph.invoke({"x": 5}, stream_mode='updates'))

# [{'expensive_node': {'result': 10}}]print(graph.invoke({"x": 5}, stream_mode='updates'))

# [{'expensive_node': {'result': 10}, '__metadata__': {'cached': True}}]

builder.set_entry_point() 和 builder.set_finish_point() 本质上就是在内部帮你设置了 START 和 END 节点的连接关系。它们是对 graph.add_edge(START, ...) 和 graph.add_edge(..., END) 的简化封装。

具体来说:

builder.set_entry_point("node_a")

等价于手动添加:

graph.add_edge(START, "node_a")

表示:从特殊的 START 节点出发,首先执行 "node_a"。

builder.set_finish_point("node_b")

等价于手动添加:

graph.add_edge("node_b", END)

表示:执行完 "node_b" 之后,图流程结束。

边(Edges)

边定义了图中逻辑的流转方式以及图何时停止。这是代理(agent)工作方式和不同节点之间通信的核心组成部分。主要有以下几种边的类型:

- 普通边(Normal Edges):从一个节点直接跳转到下一个节点。

- 条件边(Conditional Edges):通过调用函数判断接下来跳转到哪个节点。

- 入口点(Entry Point):指定当用户输入到达时首先调用哪个节点。

- 条件入口点(Conditional Entry Point):通过函数判断当用户输入到达时首先调用哪些节点。

一个节点可以拥有多个出边。如果一个节点有多个出边,所有目标节点会在下一个“超级步骤(superstep)”中并行执行。

普通边(Normal Edges)

如果你总是希望从节点 A 跳转到节点 B,可以直接使用 add_edge 方法:

graph.add_edge("node_a", "node_b")

条件边(Conditional Edges)

如果你希望有条件地跳转到一个或多个节点(或有条件地终止),可以使用 add_conditional_edges 方法。该方法接收一个节点名和一个“路由函数”,此函数会在该节点执行后被调用:

graph.add_conditional_edges("node_a", routing_function)

与节点类似,routing_function 接收图当前的 state,并返回一个值。

默认情况下,routing_function 的返回值会被当作下一个要跳转的节点名(可以是单个节点或多个节点的列表),这些节点会在下一个“超级步骤”中并行执行。

你也可以选择传入一个字典,手动将 routing_function 的返回值映射到下一个节点名:

graph.add_conditional_edges("node_a", routing_function, {True: "node_b", False: "node_c"})

💡 提示:

如果你希望在一个函数中同时进行状态更新和路由判断,可以使用Command,而不是conditional edges。

入口点(Entry Point)

入口点是图开始执行时首先运行的节点。你可以使用虚拟的 START 节点通过 add_edge 指定入口:

from langgraph.graph import STARTgraph.add_edge(START, "node_a")

条件入口点(Conditional Entry Point)

条件入口点允许你根据自定义逻辑从不同节点开始执行。你可以通过从 START 添加条件边实现:

from langgraph.graph import STARTgraph.add_conditional_edges(START, routing_function)

同样,你也可以提供一个映射字典,将函数返回值映射为对应的下一个节点名:

graph.add_conditional_edges(START, routing_function, {True: "node_b", False: "node_c"})

Send(发送)

默认情况下,节点(Nodes)和边(Edges)都是预先定义好的,并且它们在同一个共享状态(State)上运行。然而,有些场景下:

- 你事先无法确定边的具体数量;

- 或者你希望在图中同时存在多个版本的状态(State)。

一个典型的例子是 Map-Reduce 模式。在这种设计模式中,一个初始节点可能会生成一个对象列表,你可能希望对这些对象分别应用另一个节点的逻辑。

这时候存在两个问题:

- 你事先并不知道要生成多少个对象(也就不知道边的数量);

- 传递给下游节点的 State 应该是不同的(每个对象对应一个独立的 State)。

为支持这种模式,LangGraph 允许在条件边(conditional edges)中返回 Send 对象。

Send 接收两个参数:

- 第一个参数是 目标节点名称;

- 第二个参数是要传递给该节点的 状态(state)。

例如:

def continue_to_jokes(state: OverallState):return [Send("generate_joke", {"subject": s}) for s in state['subjects']]graph.add_conditional_edges("node_a", continue_to_jokes)

在这个例子中:

state['subjects']是一个主题列表;- 会为每个主题生成一个新的状态并发送给

generate_joke节点; - 这样多个任务就可以并行执行,每个任务处理一个主题。

Send 是 LangGraph 中的一个核心机制,它允许你动态地控制数据如何流向图中的下一个节点,即:

它不是告诉图 “接下来去哪个节点”,而是告诉图 “去哪个节点” + “传什么状态过去”。

为什么需要 Send?

在普通的边(edge)中,我们这么写:

graph.add_edge("node_a", "node_b")

意思是:node_a 执行完后,结果会传给 node_b。传的内容就是 node_a 输出的那个 state,是统一的一份状态。

但是假如你要 Map 一堆数据,比如:

state = {"subjects": ["cat", "dog", "duck"]}

你想要分别给每个 subject 生成笑话,这样你需要对每个 subject 单独传一个状态给 generate_joke:

{"subject": "cat"}

{"subject": "dog"}

{"subject": "duck"}

这时候如果还用普通的边是不行的,因为它一次只能传一个 state。而你现在要传 3 个不同的 state,还要都交给同一个节点执行。

Send 是 LangGraph 提供的一个机制,表示:

我要给这个节点发一个“定制的 state”。

结构上看就是:

Send("generate_joke", {"subject": "cat"})

意思是:把 {"subject": "cat"} 这个状态传给 generate_joke 节点。

你可以返回多个 Send,比如:

return [Send("generate_joke", {"subject": "cat"}),Send("generate_joke", {"subject": "dog"}),Send("generate_joke", {"subject": "duck"}),

]

这就相当于你动态地建立了 3 条边,每条边都指向 generate_joke,但传递的状态不同。

| 概念 | 作用 | 对比普通方式 |

|---|---|---|

Send("节点名", 状态) | 显式控制传输目标 + 传输数据 | 普通边只控制目标,不能分发多个不同的数据 |

| 典型应用 | MapReduce / 多路并发 / fan-out 分发 | 无法用普通 add_edge 实现 |

这类场景在多任务处理、MapReduce、动态任务分发中非常常见。下面列出几个典型场景:

✅ 场景 1:MapReduce 风格(批量并发任务)

需求: 你有一批数据(如多个产品 ID),每个都要并发做一个处理,比如调用大模型生成描述或摘要。

state = {"product_ids": [101, 102, 103]}

你希望每个 ID 都发给一个节点做处理:

# fan-out

return [Send("summarize_product", {"product_id": pid}) for pid in state["product_ids"]]

✅ 场景 2:并发生成(如多个提示词、多轮问答)

需求: 给定多个主题(subject),希望大模型为每个生成笑话:

state = {"subjects": ["cat", "dog", "duck"]}

你希望:

return [Send("generate_joke", {"subject": "cat"}),Send("generate_joke", {"subject": "dog"}),Send("generate_joke", {"subject": "duck"}),

]

每个 generate_joke 节点拿到的是独立状态、并行处理。

✅ 场景 3:多用户状态并发(每个用户独立执行)

需求: 有多个用户同时发消息给系统:

state = {"users": [{"id": 1, "input": "Hi"},{"id": 2, "input": "Help"},{"id": 3, "input": "Hello"},]

}

你希望为每个用户分发任务到 chat_handler:

return [Send("chat_handler", user_state) for user_state in state["users"]]

这样每个用户有自己的独立处理流程。

✅ 场景 4:分支聚合前的 fan-out

配合之后的 join_node 使用:

- 用

Send分发多个子任务; - 等所有任务完成后聚合结果;

非常类似 MapReduce 或流水线中的“并发执行 + 汇总”流程。

✅ 总结:你应该在这些时候使用 Send:

| 使用场景 | 是否适用 Send |

|---|---|

| 动态 fan-out,数量不定 | ✅ 非常适合 |

| 给多个对象应用相同逻辑 | ✅ 适合 |

| 每个对象有独立状态 | ✅ 适合 |

| 所有对象共享全局状态 | ❌ 不适用(普通边即可) |

| 固定流程节点、线性执行 | ❌ 不需要 Send |

Command(命令对象)

在实际应用中,我们常常希望在一个节点中同时完成状态更新和控制流跳转。例如:

- 你可能希望在一个节点中既修改状态(如添加字段),又根据结果跳转到下一个节点。

LangGraph 提供了 Command 对象来支持这种写法 —— 你可以在节点函数中返回一个 Command 对象,来同时指定状态更新和跳转逻辑。

✅ 示例:

def my_node(state: State) -> Command[Literal["my_other_node"]]:return Command(update={"foo": "bar"}, # 状态更新goto="my_other_node" # 跳转到下一个节点)

你也可以写动态跳转逻辑(和条件边的效果一样):

def my_node(state: State) -> Command[Literal["my_other_node"]]:if state["foo"] == "bar":return Command(update={"foo": "baz"}, goto="my_other_node")

⚠️ 注意:

使用Command时,必须在函数返回类型里写明所有可能跳转到的节点名,如:

Command[Literal["my_other_node"]]

这是为了让 LangGraph 能够正确生成图形结构。

什么时候用 Command 而不是条件边?

| 场景 | 推荐方式 |

|---|---|

| 只需要根据状态跳转(无状态修改) | 使用 add_conditional_edges() |

| 需要同时更新状态和控制跳转 | 使用 Command() |

例如:在多智能体系统中,一个 agent 需要“交接任务”给另一个 agent,并传递中间状态,这种情况非常适合用 Command。

跳转到父图节点(跨子图跳转)

如果你使用了子图(subgraph),而你希望从子图中的一个节点跳转到父图的其他节点,可以使用:

return Command(update={"foo": "bar"},goto="other_subgraph", # 跳转目标是父图中的节点graph=Command.PARENT # 显示声明跳出子图

)

⚠️ 注意:

如果你要更新的字段同时在子图和父图的状态定义中都存在,那么必须在父图中为该字段定义 reducer(状态合并函数)。

常见应用场景

📌 在工具内部使用 Command 更新状态

例如:在客服系统中,开局阶段通过用户输入的账号查找其基本信息,并更新对话状态。这类逻辑适合在工具内部调用后返回 Command 进行跳转和状态更新。

📌 人类参与流程(Human-in-the-loop)

在中断执行(如等待用户输入)时,LangGraph 提供 interrupt() 机制暂停流程,用户输入后使用:

Command(resume="用户的输入")

恢复执行。这是 Command 在 HITL 流程中的核心机制。

配置

创建图时,你可以标记图中的某些部分为可配置的。通常这样做是为了方便在不同模型或系统提示间切换。这允许你创建一个统一的“认知架构”(即图),但可以拥有多个不同的实例。

你可以在创建图时选择性地指定一个配置模式(config_schema)。

class ConfigSchema(TypedDict):llm: strgraph = StateGraph(State, config_schema=ConfigSchema)

然后可以通过 configurable 配置字段将配置传入图中。

config = {"configurable": {"llm": "anthropic"}}graph.invoke(inputs, config=config)

之后你可以在节点函数或条件边中访问并使用这个配置:

def node_a(state, config):llm_type = config.get("configurable", {}).get("llm", "openai")llm = get_llm(llm_type)...

Configuration(配置)在 LangGraph 里的作用其实主要是让同一个图结构(Graph)能够复用,不用改代码就能切换行为或底层实现。总结来说:

-

不是单纯“传递一个配置”这么简单,而是给整个图提供一个“可配置的参数集合”(config_schema 定义了这些参数的结构和类型)。

-

这个配置会被传递到图中每个节点(node)和条件边(conditional edge)里去使用,节点函数可以根据配置调整它们的行为,比如选用不同的模型、调用不同的接口,或者调整某些处理逻辑。

-

也就是说,图的逻辑是固定的(节点和边的关系),但具体“做什么”和“用哪个模型”是动态的,通过配置来驱动。

-

这样做的好处是:

- 你维护一个“认知架构”图

- 不用改代码,就能运行不同版本的模型(比如切换 OpenAI GPT、Anthropic,或者不同的参数)

- 支持多实例,便于测试和线上灰度切换

简化理解:

Configuration = 图的“参数开关”,用于灵活控制图内部节点的具体执行行为和调用的资源,而不是重新写图或节点代码。

举个例子:

- 你写了一个聊天对话图,里面有个节点调用语言模型生成回答。

- 你定义了一个

llm配置字段,可以是"openai"或"anthropic"。 - 调用图时传入不同配置,节点里根据配置动态选择不同模型服务接口。

- 图结构没变,但行为根据配置变了。

这样你就可以用一套代码跑多个模型,或者快速切换提示词、参数等,提升灵活性和复用性。

递归限制

递归限制定义图在单次执行过程中能执行的最大超步数(super-step)。一旦达到限制,LangGraph 会抛出 GraphRecursionError。默认限制为25步。

递归限制可以在运行时对任何图进行设置,通过传递 config 字典中的 recursion_limit 参数给 .invoke 或 .stream 方法实现。

重要的是,recursion_limit 是独立的配置项,不应放在 configurable 键里(configurable 用于用户定义的配置)。示例如下:

graph.invoke(inputs, config={"recursion_limit": 5, "configurable": {"llm": "anthropic"}})

你应该直接把 recursion_limit 放在传给 graph.invoke 的顶层 config 字典里,和 configurable 同级,而不是放到 configurable 里。

举个例子:

graph.invoke(inputs,config={"recursion_limit": 5, # 这是独立配置项"configurable": {"llm": "anthropic"} # 这是用户定义的配置}

)

换句话说:

configurable这个字段专门用来放你自定义的配置参数,供节点使用。recursion_limit是 LangGraph 自身的控制参数,属于框架级的配置,独立存在。

所以它们在同一个字典里,但互相是平级关系,不嵌套。

LangGraph 运行时

Pregel 实现了 LangGraph 的运行时,负责管理 LangGraph 应用程序的执行过程。

编译一个 StateGraph 或创建一个入口点(entrypoint)会生成一个 Pregel 实例,可以通过输入数据调用它。

本指南从高层次介绍该运行时,并提供了直接使用 Pregel 实现应用程序的说明。

注意:Pregel 运行时的命名来源于 Google 的 Pregel 算法,该算法是一种用于大规模并行图计算的高效方法。

在 LangGraph 中,Pregel 将参与者(actors)和通道(channels)结合为一个应用程序整体。参与者从通道中读取数据并向通道写入数据。

Pregel 依据 Pregel 算法(也称 BSP - Bulk Synchronous Parallel)模式将应用程序的执行划分为多个步骤。

每个步骤包含三个阶段:

-

计划(Plan):

决定在本步骤中要执行哪些参与者。

例如,在第一个步骤中选择订阅了特殊输入通道的参与者;在后续步骤中选择那些订阅了上一步中更新过的通道的参与者。 -

执行(Execution):

并行执行所有选中的参与者,直到全部完成,或某个失败,或达到超时。

注意:在这个阶段中,参与者无法看到本步骤内的通道更新,直到下一个步骤开始。 -

更新(Update):

用本步骤内参与者写入的值来更新通道。

上述过程将持续,直到没有参与者被选中执行,或者达到设定的最大步骤数。

参与者(Actors)

参与者在 Pregel 中被称为 PregelNode。

它们订阅通道,从中读取数据,并将数据写入通道。

可以将它类比为 Pregel 算法中的“计算节点”。

每个 PregelNode 都实现了 LangChain 的 Runnable 接口。

通道(Channels)

通道用于在参与者之间(即 PregelNode)进行通信。

每个通道具有以下属性:

- 值类型(value type)

- 更新类型(update type)

- 更新函数(update function):接收多个更新操作并修改存储值。

通道可以用于:

- 在不同链之间传递数据;

- 或在未来的步骤中将数据返回给自身。

LangGraph 提供了一些内置通道类型:

-

LastValue:

默认通道,保存最近一次写入的值。适用于输入/输出,或将数据从某一步传递给下一步。 -

Topic:

可配置的发布-订阅主题。适合多个值在参与者之间传递或累积输出。可配置去重或累加策略。 -

BinaryOperatorAggregate:

持久存储值,使用二元运算符(如加法)逐步更新,适合跨步骤聚合数据。

例如:total = BinaryOperatorAggregate(int, operator.add)

示例

虽然大多数用户会通过 StateGraph API 或 entrypoint 装饰器使用 Pregel,但你也可以直接操作 Pregel 实例。

以下是几个使用 Pregel API 的示例:

from langgraph.channels import EphemeralValue

from langgraph.pregel import Pregel, NodeBuildernode1 = (NodeBuilder().subscribe_only("a").do(lambda x: x + x).write_to("b")

)app = Pregel(nodes={"node1": node1},channels={"a": EphemeralValue(str),"b": EphemeralValue(str),},input_channels=["a"],output_channels=["b"],

)app.invoke({"a": "foo"})

高层 API LangGraph 提供了两个高级 API 用于构建 Pregel 应用:

- StateGraph(图形 API)

- 函数式 API

StateGraph(图形 API):

StateGraph 是一个更高级别的抽象,简化了 Pregel 应用的创建过程。

它允许你定义节点和边组成的图结构。

当你编译图结构时,StateGraph API 会自动为你创建 Pregel 应用。

from typing import TypedDict, Optional

from langgraph.constants import START

from langgraph.graph import StateGraphclass Essay(TypedDict):topic: strcontent: Optional[str]score: Optional[float]def write_essay(essay: Essay):return {"content": f"Essay about {essay['topic']}",}def score_essay(essay: Essay):return {"score": 10}builder = StateGraph(Essay)

builder.add_node(write_essay)

builder.add_node(score_essay)

builder.add_edge(START, "write_essay")# 编译图结构,返回一个 Pregel 实例

graph = builder.compile()

你可以通过打印以下内容查看生成的节点和通道:

print(graph.nodes)

输出类似:

{'__start__': <langgraph.pregel.read.PregelNode at 0x7d05e3ba1810>,'write_essay': <langgraph.pregel.read.PregelNode at 0x7d05e3ba14d0>,'score_essay': <langgraph.pregel.read.PregelNode at 0x7d05e3ba1710>

}

print(graph.channels)

你将看到类似这样的内容(具体内容视编译结果而定)。

{'topic': <langgraph.channels.last_value.LastValue at 0x7d05e3294d80>,'content': <langgraph.channels.last_value.LastValue at 0x7d05e3295040>,'score': <langgraph.channels.last_value.LastValue at 0x7d05e3295980>,'__start__': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e3297e00>,'write_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e32960c0>,'score_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e2d8ab80>,'branch:__start__:__self__:write_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e32941c0>,'branch:__start__:__self__:score_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e2d88800>,'branch:write_essay:__self__:write_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e3295ec0>,'branch:write_essay:__self__:score_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e2d8ac00>,'branch:score_essay:__self__:write_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e2d89700>,'branch:score_essay:__self__:score_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e2d8b400>,'start:write_essay': <langgraph.channels.ephemeral_value.EphemeralValue at 0x7d05e2d8b280>}

如何使用 Graph API

本指南展示了 LangGraph 的 Graph API 的基本用法,涵盖了状态的使用,以及如何构建常见的图结构,如顺序执行、分支和循环。还介绍了 LangGraph 的控制功能,包括用于 map-reduce 工作流的 Send API,以及将状态更新与节点跳转相结合的 Command API。

安装 langgraph:

%pip install -qU langgraph

定义与更新状态

下面介绍如何在 LangGraph 中定义和更新状态。

- 如何使用状态来定义图的 schema(结构)

- 如何使用 reducer 控制状态更新的处理方式

定义状态

LangGraph 中的状态可以是 TypedDict、Pydantic 模型或 dataclass。以下我们使用 TypedDict,如需了解使用 Pydantic,请参考相关章节。

默认情况下,图的输入和输出使用相同的 schema,状态决定了该 schema。如需定义不同的输入与输出 schema,也有相应的支持。

我们来看一个简单的消息处理示例。这是许多 LLM 应用中通用的状态表示方式。更多细节请见概念页。

from langchain_core.messages import AnyMessage

from typing_extensions import TypedDictclass State(TypedDict):messages: list[AnyMessage]extra_field: int

这个状态结构跟踪消息对象的列表,以及一个额外的整数字段。

更新状态

构建一个包含单节点的简单图。节点是一个 Python 函数,读取并更新图的状态。其第一个参数始终是状态。

from langchain_core.messages import AIMessagedef node(state: State):messages = state["messages"]new_message = AIMessage("Hello!")return {"messages": messages + [new_message], "extra_field": 10}

该节点向消息列表添加一条新消息,并设置额外字段。

⚠️ 注意:节点应直接返回更新后的状态,而不是原地修改状态。

接下来定义包含此节点的图:

from langgraph.graph import StateGraphbuilder = StateGraph(State)

builder.add_node(node)

builder.set_entry_point("node")

graph = builder.compile()

可以可视化图结构:

from IPython.display import Image, display

display(Image(graph.get_graph().draw_mermaid_png()))

执行一次调用:

from langchain_core.messages import HumanMessageresult = graph.invoke({"messages": [HumanMessage("Hi")]})

result

输出结果包含完整的状态:

{'messages': [HumanMessage(...), AIMessage(...)], 'extra_field': 10}

消息内容可通过 .pretty_print() 打印:

for message in result["messages"]:message.pretty_print()

使用 Reducer 处理状态更新

状态中的每个字段都可以定义自己的 reducer 函数,控制如何合并来自不同节点的更新。未指定 reducer 时,默认更新会覆盖原值。

为 TypedDict 类型的状态定义 reducer 示例:

from typing_extensions import Annotateddef add(left, right):return left + rightclass State(TypedDict):messages: Annotated[list[AnyMessage], add]extra_field: int

此时节点函数可简化为:

def node(state: State):new_message = AIMessage("Hello!")return {"messages": [new_message], "extra_field": 10}

编译并运行:

from langgraph.graph import STARTgraph = StateGraph(State).add_node(node).add_edge(START, "node").compile()

result = graph.invoke({"messages": [HumanMessage("Hi")]})

================================ Human Message =================================Hi

================================== Ai Message ==================================Hello!

在实际应用中,更新消息列表时需要额外考虑以下几点:

- 我们可能希望更新状态中已存在的消息;

- 我们可能希望接受简化的消息格式输入,例如 OpenAI 的格式。

为此,LangGraph 提供了一个内置的 reducer —— add_messages,可以处理上述情况。

示例:

from langgraph.graph.message import add_messagesclass State(TypedDict):messages: Annotated[list[AnyMessage], add_messages]extra_field: int

输入消息支持简写形式:

input_message = {"role": "user", "content": "Hi"}

此外,LangGraph 还提供内建的 MessagesState 类型,可用于简化定义:

from langgraph.graph import MessagesStateclass State(MessagesState):extra_field: int

定义输入与输出 Schema

可为图指定不同的输入与输出 schema。节点之间仍使用内部 schema 进行通信。

示例:

from langgraph.graph import StateGraph, START, END

from typing_extensions import TypedDictclass InputState(TypedDict):question: strclass OutputState(TypedDict):answer: strclass OverallState(InputState, OutputState):passdef answer_node(state: InputState):return {"answer": "bye", "question": state["question"]}builder = StateGraph(OverallState, input=InputState, output=OutputState)

builder.add_node(answer_node)

builder.add_edge(START, "answer_node")

builder.add_edge("answer_node", END)

graph = builder.compile()print(graph.invoke({"question": "hi"})) # {'answer': 'bye'}

在节点之间传递私有状态

在某些情况下,你可能希望节点之间交换一些对中间逻辑非常关键的信息,但这些信息并不需要成为图的主要状态结构(主 schema)的一部分。这种私有数据与图的整体输入/输出无关,只应在特定的节点之间共享。

下面我们将创建一个由三个节点(node_1、node_2 和 node_3)组成的**顺序图(sequential graph)**示例,其中私有数据在前两个节点(node_1 和 node_2)之间传递,而第三个节点(node_3)只能访问公共的整体状态。

from langgraph.graph import StateGraph, START, END

from typing_extensions import TypedDict# The overall state of the graph (this is the public state shared across nodes)

class OverallState(TypedDict):a: str# Output from node_1 contains private data that is not part of the overall state

class Node1Output(TypedDict):private_data: str# The private data is only shared between node_1 and node_2

def node_1(state: OverallState) -> Node1Output:output = {"private_data": "set by node_1"}print(f"Entered node `node_1`:\n\tInput: {state}.\n\tReturned: {output}")return output# Node 2 input only requests the private data available after node_1

class Node2Input(TypedDict):private_data: strdef node_2(state: Node2Input) -> OverallState:output = {"a": "set by node_2"}print(f"Entered node `node_2`:\n\tInput: {state}.\n\tReturned: {output}")return output# Node 3 only has access to the overall state (no access to private data from node_1)

def node_3(state: OverallState) -> OverallState:output = {"a": "set by node_3"}print(f"Entered node `node_3`:\n\tInput: {state}.\n\tReturned: {output}")return output# Connect nodes in a sequence

# node_2 accepts private data from node_1, whereas

# node_3 does not see the private data.

builder = StateGraph(OverallState).add_sequence([node_1, node_2, node_3])

builder.add_edge(START, "node_1")

graph = builder.compile()# Invoke the graph with the initial state

response = graph.invoke({"a": "set at start",}

)print()

print(f"Output of graph invocation: {response}")

Entered node `node_1`:Input: {'a': 'set at start'}.Returned: {'private_data': 'set by node_1'}

Entered node `node_2`:Input: {'private_data': 'set by node_1'}.Returned: {'a': 'set by node_2'}

Entered node `node_3`:Input: {'a': 'set by node_2'}.Returned: {'a': 'set by node_3'}Output of graph invocation: {'a': 'set by node_3'}

使用 Pydantic 模型作为状态

StateGraph 在初始化时接受一个 state_schema 参数,用于指定图中各个节点可以访问和更新的状态的“结构”(即状态的形状)。

在示例中,我们通常使用 Python 原生的 TypedDict 来作为 state_schema,但实际上 state_schema 可以是任意类型。

在这里,我们将看到如何使用 Pydantic 的 BaseModel 作为 state_schema,以便在运行时对输入进行校验。

已知限制

- 图的输出目前不会是 Pydantic 模型的实例。

- 运行时校验仅发生在节点的输入上,而不会校验节点的输出。

- Pydantic 报错信息中不会标明错误发生在哪个节点。

示例:

from langgraph.graph import StateGraph, START, END

from typing_extensions import TypedDictfrom pydantic import BaseModel# The overall state of the graph (this is the public state shared across nodes)

class OverallState(BaseModel):a: strdef node(state: OverallState):return {"a": "goodbye"}# Build the state graph

builder = StateGraph(OverallState)

builder.add_node(node) # node_1 is the first node

builder.add_edge(START, "node") # Start the graph with node_1

builder.add_edge("node", END) # End the graph after node_1

graph = builder.compile()# Test the graph with a valid input

graph.invoke({"a": "hello"})

{'a': 'goodbye'}

如果输入非法(如 {"a": 123}),将抛出验证异常:

try:graph.invoke({"a": 123}) # Should be a string

except Exception as e:print("An exception was raised because `a` is an integer rather than a string.")print(e)

An exception was raised because `a` is an integer rather than a string.

1 validation error for OverallState

aInput should be a valid string [type=string_type, input_value=123, input_type=int]For further information visit https://errors.pydantic.dev/2.9/v/string_type

添加运行时配置

有时你希望在调用图时进行配置。例如,你可能希望在运行时指定使用哪个 LLM 或系统提示,而不希望用这些参数污染图的状态。

要添加运行时配置,请按以下步骤操作:

- 指定配置的 schema;

- 在节点或条件边的函数签名中添加配置;

- 将配置传入图中。

from langchain_core.runnables import RunnableConfig

from langgraph.graph import END, StateGraph, START

from typing_extensions import TypedDict# 1. 指定配置 schema

class ConfigSchema(TypedDict):my_runtime_value: str# 2. 定义一个在节点中访问配置的图

class State(TypedDict):my_state_value: strdef node(state: State, config: RunnableConfig):if config["configurable"]["my_runtime_value"] == "a":return {"my_state_value": 1}elif config["configurable"]["my_runtime_value"] == "b":return {"my_state_value": 2}else:raise ValueError("未知的值。")builder = StateGraph(State, config_schema=ConfigSchema)

builder.add_node(node)

builder.add_edge(START, "node")

builder.add_edge("node", END)graph = builder.compile()# 3. 在运行时传入配置:

print(graph.invoke({}, {"configurable": {"my_runtime_value": "a"}}))

print(graph.invoke({}, {"configurable": {"my_runtime_value": "b"}}))# 输出:

# {'my_state_value': 1}

# {'my_state_value': 2}

以下是一个更复杂的示例,展示如何同时在运行时配置两个参数:使用的 LLM 模型和系统提示词(system message)。

from typing import Optional

from langchain.chat_models import init_chat_model

from langchain_core.messages import SystemMessage

from langchain_core.runnables import RunnableConfig

from langgraph.graph import END, MessagesState, StateGraph, START

from typing_extensions import TypedDict# 配置 schema

class ConfigSchema(TypedDict):model: Optional[str]system_message: Optional[str]MODELS = {"anthropic": init_chat_model("anthropic:claude-3-5-haiku-latest"),"openai": init_chat_model("openai:gpt-4.1-mini"),

}# 节点逻辑:支持系统提示词注入

def call_model(state: MessagesState, config: RunnableConfig):model = config["configurable"].get("model", "anthropic")model = MODELS[model]messages = state["messages"]if system_message := config["configurable"].get("system_message"):messages = [SystemMessage(system_message)] + messagesresponse = model.invoke(messages)return {"messages": [response]}# 构建图

builder = StateGraph(MessagesState, config_schema=ConfigSchema)

builder.add_node("model", call_model)

builder.add_edge(START, "model")

builder.add_edge("model", END)graph = builder.compile()

添加重试策略(Add retry policies)

有许多用例中,你可能希望你的节点拥有自定义的重试策略,比如调用 API、查询数据库或调用 LLM 等。LangGraph 允许你为节点添加重试策略。

要配置重试策略,将 retry 参数传递给 add_node。retry 参数接受一个 RetryPolicy 命名元组对象。下面示例中,我们用默认参数实例化一个 RetryPolicy 对象并将其关联到一个节点:

from langgraph.pregel import RetryPolicybuilder.add_node("node_name",node_function,retry=RetryPolicy(),

)

默认情况下,retry_on 参数使用 default_retry_on 函数,它会对除了以下异常之外的所有异常进行重试:

ValueErrorTypeErrorArithmeticErrorImportErrorLookupErrorNameErrorSyntaxErrorRuntimeErrorReferenceErrorStopIterationStopAsyncIterationOSError

此外,对于来自流行的 HTTP 请求库如 requests 和 httpx 的异常,它仅在状态码为 5xx 时重试。

下面我们向节点传递了两种不同的重试策略:

import sqlite3

from typing_extensions import TypedDictfrom langchain.chat_models import init_chat_modelfrom langgraph.graph import END, MessagesState, StateGraph, START

from langgraph.pregel import RetryPolicy

from langchain_community.utilities import SQLDatabase

from langchain_core.messages import AIMessagedb = SQLDatabase.from_uri("sqlite:///:memory:")model = init_chat_model("anthropic:claude-3-5-haiku-latest")def query_database(state: MessagesState):query_result = db.run("SELECT * FROM Artist LIMIT 10;")return {"messages": [AIMessage(content=query_result)]}def call_model(state: MessagesState):response = model.invoke(state["messages"])return {"messages": [response]}# 定义一个新的图

builder = StateGraph(MessagesState)

builder.add_node("query_database",query_database,retry=RetryPolicy(retry_on=sqlite3.OperationalError),

)

builder.add_node("model", call_model, retry=RetryPolicy(max_attempts=5))

builder.add_edge(START, "model")

builder.add_edge("model", "query_database")

builder.add_edge("query_database", END)graph = builder.compile()

添加节点缓存

节点缓存适用于你想避免重复执行某些操作的场景,比如执行耗时或高成本的操作。LangGraph 允许你为图中的节点添加个性化的缓存策略。

配置缓存策略时,将 cache_policy 参数传递给 add_node 函数。以下示例中,实例化了一个 CachePolicy 对象,设置生存时间(TTL)为 120 秒,并使用默认的 key_func 生成器。然后将该缓存策略与某个节点关联:

from langgraph.types import CachePolicybuilder.add_node("node_name",node_function,cache_policy=CachePolicy(ttl=120),

)

接着,为了启用图的节点级缓存,在编译图时设置 cache 参数。下面的例子使用 InMemoryCache 来搭建一个带有内存缓存的图,也可以使用 SqliteCache。

from langgraph.cache.memory import InMemoryCachegraph = builder.compile(cache=InMemoryCache())

创建步骤序列

下面演示如何构建一个简单的步骤序列。内容包括:

- 如何构建一个顺序图

- 构建类似图的内置简写方法

我们使用图的 .add_node 和 .add_edge 方法来添加一系列节点:

from langgraph.graph import START, StateGraphbuilder = StateGraph(State)# 添加节点

builder.add_node(step_1)

builder.add_node(step_2)

builder.add_node(step_3)# 添加边

builder.add_edge(START, "step_1")

builder.add_edge("step_1", "step_2")

builder.add_edge("step_2", "step_3")

也可以使用内置简写 .add_sequence:

builder = StateGraph(State).add_sequence([step_1, step_2, step_3])

builder.add_edge(START, "step_1")

为什么用 LangGraph 将应用步骤拆分为序列?

举个端到端的例子,我们创建三个步骤的序列:

- 在状态的一个键中填充值

- 更新同一个值

- 填充不同的值

首先定义状态。状态决定了图的模式(schema),也可以指定如何应用更新。详见相关章节。

这里我们仅跟踪两个值:

from typing_extensions import TypedDictclass State(TypedDict):value_1: strvalue_2: int

节点即 Python 函数,读取图的状态并做更新。该函数的第一个参数始终是状态:

def step_1(state: State):return {"value_1": "a"}def step_2(state: State):current_value_1 = state["value_1"]return {"value_1": f"{current_value_1} b"}def step_3(state: State):return {"value_2": 10}

注意

在发出状态更新时,每个节点只需指定想更新的键对应的值。

默认行为是覆盖对应键的值。你也可以使用 reducer 控制更新的处理方式,比如将连续的更新追加到键上。详见相关章节。

最后,定义图。使用 StateGraph 创建基于此状态的图。

然后用 add_node 和 add_edge 填充图并定义控制流:

from langgraph.graph import START, StateGraphbuilder = StateGraph(State)# 添加节点

builder.add_node(step_1)

builder.add_node(step_2)

builder.add_node(step_3)# 添加边

builder.add_edge(START, "step_1")

builder.add_edge("step_1", "step_2")

builder.add_edge("step_2", "step_3")

指定自定义节点名称,可以通过 .add_node 指定节点自定义名称:

builder.add_node("my_node", step_1)

注意事项:

.add_edge需要节点名称,函数默认名称为node.__name__- 必须指定图的入口点,即从

START节点连出一条边 - 图在没有更多节点可执行时停止运行

接下来编译图。编译时会进行基本结构检查(如发现孤立节点)。如果程序有持久化需求,可以通过 checkpointer 传入。

graph = builder.compile()

LangGraph 提供了内置工具用于图形可视化。下面查看我们的序列,详见可视化指南:

from IPython.display import Image, displaydisplay(Image(graph.get_graph().draw_mermaid_png()))

简单调用示例:

graph.invoke({"value_1": "c"})

返回结果:

{'value_1': 'a b', 'value_2': 10}

说明:

- 调用时传入了单个状态键的初始值,必须至少提供一个键的值

- 第一个节点覆盖了传入的值

- 第二个节点更新了该值

- 第三个节点填充了不同的键值

langgraph>=0.2.46 包含内置简写 add_sequence 用于添加节点序列。可按如下方式编译相同的图:

builder = StateGraph(State).add_sequence([step_1, step_2, step_3])

builder.add_edge(START, "step_1")graph = builder.compile()graph.invoke({"value_1": "c"})

创建分支

节点的并行执行对于加快整体图的运行速度至关重要。LangGraph 原生支持节点的并行执行,这可以显著提升基于图的工作流性能。

这种并行化是通过扇出(fan-out)和扇入(fan-in)机制实现的,利用标准边(edges)和条件边(conditional_edges)。

以下是一些示例,展示如何添加并创建适合你的分支数据流。

并行运行图节点

在本示例中,我们从节点 A 扇出到节点 B 和 C,随后再扇入到节点 D。通过状态(state),我们指定了 reducer 的加法操作(add operation)。这会将特定键(key)对应的值进行合并或累积,而不是简单地覆盖原有值。对于列表类型来说,这意味着将新的列表与已有列表拼接。关于使用 reducer 更新状态的更多细节,请参见上文关于状态 reducer 的部分。

import operator

from typing import Annotatedfrom typing_extensions import TypedDictfrom langgraph.graph import StateGraph, START, ENDclass State(TypedDict):# operator.add 作为 reducer 函数,使其只能追加aggregate: Annotated[list, operator.add]def a(state: State):print(f'Adding "A" to {state["aggregate"]}')return {"aggregate": ["A"]}def b(state: State):print(f'Adding "B" to {state["aggregate"]}')return {"aggregate": ["B"]}def c(state: State):print(f'Adding "C" to {state["aggregate"]}')return {"aggregate": ["C"]}def d(state: State):print(f'Adding "D" to {state["aggregate"]}')return {"aggregate": ["D"]}builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)

builder.add_node(c)

builder.add_node(d)

builder.add_edge(START, "a")

builder.add_edge("a", "b")

builder.add_edge("a", "c")

builder.add_edge("b", "d")

builder.add_edge("c", "d")

builder.add_edge("d", END)

graph = builder.compile()from IPython.display import Image, displaydisplay(Image(graph.get_graph().draw_mermaid_png()))

使用 reducer,可以看到每个节点中添加的值都会被累积。

graph.invoke({"aggregate": []}, {"configurable": {"thread_id": "foo"}})

执行结果:

Adding "A" to []

Adding "B" to ['A']

Adding "C" to ['A']

Adding "D" to ['A', 'B', 'C']{'aggregate': ['A', 'B', 'C', 'D']}

注意

在上述示例中,节点 “b” 和 “c” 会在同一个超级步(superstep)中并发执行。由于它们处于同一步骤,节点 “d” 会在 “b” 和 “c” 都执行完毕后再执行。

需要注意的是,来自并行超级步的更新可能不会有一致的顺序。如果需要确定的顺序,应该将输出写入状态中的独立字段,并携带排序用的值。

LangGraph 在“超级步骤”(supersteps)中执行节点,这意味着虽然并行分支会同时执行,但整个超级步骤是事务性的。如果任何一个分支抛出异常,则该超级步骤内所有更新都不会应用到状态(整个超级步骤会报错)。

重要的是,当使用检查点(checkpointer)时,超级步骤内成功节点的结果会被保存,恢复时不会重复执行。

如果你的流程中有容易出错的部分(例如需要处理不稳定的 API 调用),LangGraph 提供了两种解决方案:

- 你可以在节点中编写常规的 Python 代码来捕获和处理异常。

- 你可以设置

retry_policy,让图在遇到特定类型异常时自动重试节点。只有失败的分支会被重试,不用担心重复工作。

这两种方式结合使用,可以让你实现并行执行的同时,完全掌控异常处理。

延迟节点执行

延迟节点执行(Deferring node execution)在你想要推迟某个节点的执行,直到所有其他待处理任务完成时非常有用。这在分支长度不一致的情况下尤为重要,比如在类似 Map-Reduce 的工作流中经常遇到。

上面的示例展示了当每条路径只有一步时如何实现扇出(fan-out)和扇入(fan-in)。但如果某个分支有多于一步呢?我们来给“b”分支添加一个名为“b_2”的节点:

import operator

from typing import Annotatedfrom typing_extensions import TypedDictfrom langgraph.graph import StateGraph, START, ENDclass State(TypedDict):aggregate: Annotated[list, operator.add]def a(state: State):print(f'Adding "A" to {state["aggregate"]}')return {"aggregate": ["A"]}def b(state: State):print(f'Adding "B" to {state["aggregate"]}')return {"aggregate": ["B"]}def b_2(state: State):print(f'Adding "B_2" to {state["aggregate"]}')return {"aggregate": ["B_2"]}def c(state: State):print(f'Adding "C" to {state["aggregate"]}')return {"aggregate": ["C"]}def d(state: State):print(f'Adding "D" to {state["aggregate"]}')return {"aggregate": ["D"]}builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)

builder.add_node(b_2)

builder.add_node(c)

builder.add_node(d, defer=True) # 延迟执行

builder.add_edge(START, "a")

builder.add_edge("a", "b")

builder.add_edge("a", "c")

builder.add_edge("b", "b_2")

builder.add_edge("b_2", "d")

builder.add_edge("c", "d")

builder.add_edge("d", END)

graph = builder.compile()from IPython.display import Image, displaydisplay(Image(graph.get_graph().draw_mermaid_png()))graph.invoke({"aggregate": []})

执行结果:

Adding "A" to []

Adding "B" to ['A']

Adding "C" to ['A']

Adding "B_2" to ['A', 'B', 'C']

Adding "D" to ['A', 'B', 'C', 'B_2']{'aggregate': ['A', 'B', 'C', 'B_2', 'D']}

在此示例中,节点 “b” 和 “c” 仍然在同一个超级步并发执行。我们对节点 d 设置了 defer=True,表示它会等到所有待执行任务完成后才执行。这里的意思是,节点 d 会等待整个 “b” 分支完成后才执行。

条件分支

如果你希望扇出路径在运行时基于状态动态变化,可以使用 add_conditional_edges,根据图状态选择一条或多条路径。下面示例中,节点 a 生成一个状态更新,决定后续执行哪个节点。

import operator

from typing import Annotated, Literalfrom typing_extensions import TypedDictfrom langgraph.graph import StateGraph, START, ENDclass State(TypedDict):aggregate: Annotated[list, operator.add]which: str # 用于决定分支走向的状态字段def a(state: State):print(f'Adding "A" to {state["aggregate"]}')return {"aggregate": ["A"], "which": "c"}def b(state: State):print(f'Adding "B" to {state["aggregate"]}')return {"aggregate": ["B"]}def c(state: State):print(f'Adding "C" to {state["aggregate"]}')return {"aggregate": ["C"]}builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)

builder.add_node(c)

builder.add_edge(START, "a")

builder.add_edge("b", END)

builder.add_edge("c", END)def conditional_edge(state: State) -> Literal["b", "c"]:# 这里根据状态决定下一节点return state["which"]builder.add_conditional_edges("a", conditional_edge)graph = builder.compile()from IPython.display import Image, displaydisplay(Image(graph.get_graph().draw_mermaid_png()))result = graph.invoke({"aggregate": []})

print(result)

输出:

Adding "A" to []

Adding "C" to ['A']

{'aggregate': ['A', 'C'], 'which': 'c'}

提示

你的条件边可以路由到多个目标节点,例如:

def route_bc_or_cd(state: State) -> list[str]:if state["which"] == "cd":return ["c", "d"]return ["b", "c"]

Map-Reduce 与 Send API

默认情况下,节点(Nodes)和边(Edges)是在运行前预先定义好的,并且它们操作的是同一个共享状态(shared state)。然而,有些情况下,具体的边在运行前可能未知,或者你可能希望同时存在多个不同版本的状态。这种情况在 Map-Reduce 设计模式中很常见。在这种设计模式中,第一个节点可能会生成一个对象列表,你希望对这些对象分别应用另一个节点。对象的数量事先未知(意味着边的数量也未知),且下游节点接收到的输入状态应该是不同的——每个生成的对象对应一个输入状态。

为了支持这种设计模式,LangGraph 允许在条件边(conditional edges)中返回 Send 对象。Send 接受两个参数:第一个是节点的名称,第二个是传递给该节点的状态。

def continue_to_jokes(state: OverallState):return [Send("generate_joke", {"subject": s}) for s in state['subjects']]graph.add_conditional_edges("node_a", continue_to_jokes)

下面我们实现一个简单示例,模拟使用大语言模型(LLMs)来完成以下步骤:(1)生成一个主题列表(其长度事先未知),(2)并行生成笑话,和(3)选择“最佳”笑话。值得注意的是,扇出节点的输入状态不同于整个图的总体状态。

import operator

from typing import Annotated

from typing_extensions import TypedDictfrom langgraph.types import Send

from langgraph.graph import END, StateGraph, STARTclass OverallState(TypedDict):topic: strsubjects: listjokes: Annotated[list, operator.add] # 累积所有生成的笑话best_selected_joke: strclass JokeState(TypedDict):subject: strdef generate_topics(state: OverallState):# 模拟 LLM 生成主题列表return {"subjects": ["lions", "elephants", "penguins"]}def generate_joke(state: JokeState):# 模拟 LLM 生成笑话joke_map = {"lions": "Why don't lions like fast food? Because they can't catch it!","elephants": "Why don't elephants use computers? They're afraid of the mouse!","penguins": "Why don’t penguins like talking to strangers at parties? Because they find it hard to break the ice.",}return {"jokes": [joke_map[state["subject"]]]}def continue_to_jokes(state: OverallState):# 为每个主题返回一个 Send 对象,指向 generate_joke 节点,传递对应状态return [Send("generate_joke", {"subject": s}) for s in state["subjects"]]def best_joke(state: OverallState):return {"best_selected_joke": "penguins"}builder = StateGraph(OverallState)

builder.add_node("generate_topics", generate_topics)

builder.add_node("generate_joke", generate_joke)

builder.add_node("best_joke", best_joke)

builder.add_edge(START, "generate_topics")

builder.add_conditional_edges("generate_topics", continue_to_jokes, ["generate_joke"])

builder.add_edge("generate_joke", "best_joke")

builder.add_edge("best_joke", END)

graph = builder.compile()from IPython.display import Image, displaydisplay(Image(graph.get_graph().draw_mermaid_png()))for step in graph.stream({"topic": "animals"}):print(step)

输出示例:

{'generate_topics': {'subjects': ['lions', 'elephants', 'penguins']}}

{'generate_joke': {'jokes': ["Why don't lions like fast food? Because they can't catch it!"]}}

{'generate_joke': {'jokes': ["Why don't elephants use computers? They're afraid of the mouse!"]}}

{'generate_joke': {'jokes': ['Why don’t penguins like talking to strangers at parties? Because they find it hard to break the ice.']}}

{'best_joke': {'best_selected_joke': 'penguins'}}

创建和控制循环

当创建带有循环的图时,我们需要一种机制来终止执行。最常见的做法是添加一个条件边(conditional edge),当满足某个终止条件时,跳转到 END 节点。

调用或流式执行图时,你还可以设置图的递归限制(recursion limit)。递归限制规定图允许执行的超级步骤(supersteps)数量,超过后会抛出错误。关于递归限制的概念,可以参考相关文档。

让我们通过一个简单的带循环的图来更好地理解这些机制。

创建循环时,可以包含一个条件边来指定终止条件:

builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)def route(state: State) -> Literal["b", END]:if termination_condition(state):return ENDelse:return "b"builder.add_edge(START, "a")

builder.add_conditional_edges("a", route)

builder.add_edge("b", "a")

graph = builder.compile()

控制递归限制时,可以在配置中指定 "recursion_limit"。当超出限制时,会抛出 GraphRecursionError,你可以捕获并处理它:

from langgraph.errors import GraphRecursionErrortry:graph.invoke(inputs, {"recursion_limit": 3})

except GraphRecursionError:print("Recursion Error")

下面定义一个带简单循环的图。注意这里使用条件边实现了终止条件。

import operator

from typing import Annotated, Literal

from typing_extensions import TypedDict

from langgraph.graph import StateGraph, START, ENDclass State(TypedDict):# operator.add 作为 reducer 函数,使其只追加不删除aggregate: Annotated[list, operator.add]def a(state: State):print(f'Node A sees {state["aggregate"]}')return {"aggregate": ["A"]}def b(state: State):print(f'Node B sees {state["aggregate"]}')return {"aggregate": ["B"]}# 定义节点

builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)# 定义边

def route(state: State) -> Literal["b", END]:if len(state["aggregate"]) < 7:return "b"else:return ENDbuilder.add_edge(START, "a")

builder.add_conditional_edges("a", route)

builder.add_edge("b", "a")

graph = builder.compile()from IPython.display import Image, display

display(Image(graph.get_graph().draw_mermaid_png()))

该架构类似于 ReAct agent,其中节点 “a” 是调用工具的模型,节点 “b” 代表具体的工具。

在条件边 route 中,我们指定当状态中 “aggregate” 列表长度超过阈值时结束循环。

调用图时,可以看到节点 “a” 和 “b” 交替执行,直到达到终止条件才停止。

graph.invoke({"aggregate": []})

输出示例:

Node A sees []

Node B sees ['A']

Node A sees ['A', 'B']

Node B sees ['A', 'B', 'A']

Node A sees ['A', 'B', 'A', 'B']

Node B sees ['A', 'B', 'A', 'B', 'A']

Node A sees ['A', 'B', 'A', 'B', 'A', 'B']{'aggregate': ['A', 'B', 'A', 'B', 'A', 'B', 'A']}

设置递归限制

在某些应用中,无法保证一定会达到终止条件。这时可以设置图的递归限制。超过限制后会抛出 GraphRecursionError,你可以捕获并处理该异常:

from langgraph.errors import GraphRecursionErrortry:graph.invoke({"aggregate": []}, {"recursion_limit": 4})

except GraphRecursionError:print("Recursion Error")

输出示例:

Node A sees []

Node B sees ['A']

Node A sees ['A', 'B']

Node B sees ['A', 'B', 'A']

Recursion Error

注意这次执行在第四步时终止。默认递归限制为 25。

其次,我们可以不抛出 GraphRecursionError,而是在状态中引入一个新键,用于跟踪距离递归限制还有多少步。然后可以用这个键来判断是否应该结束运行。LangGraph 实现了一个特殊的注解 RemainingSteps。在底层,它会创建一个 ManagedValue 通道——一个仅在图运行期间存在的状态通道。

import operator

from typing import Annotated, Literal

from typing_extensions import TypedDict

from langgraph.graph import StateGraph, START, END

from langgraph.managed.is_last_step import RemainingStepsclass State(TypedDict):# operator.add 作为 reducer 函数,使其只追加不删除aggregate: Annotated[list, operator.add]remaining_steps: RemainingStepsdef a(state: State):print(f'Node A sees {state["aggregate"]}')return {"aggregate": ["A"]}def b(state: State):print(f'Node B sees {state["aggregate"]}')return {"aggregate": ["B"]}# 定义节点

builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)# 定义边

def route(state: State) -> Literal["b", END]:if state["remaining_steps"] <= 2:return ENDelse:return "b"builder.add_edge(START, "a")

builder.add_conditional_edges("a", route)

builder.add_edge("b", "a")

graph = builder.compile()# 测试运行

result = graph.invoke({"aggregate": []}, {"recursion_limit": 4})

print(result)

运行输出:

Node A sees []

Node B sees ['A']

Node A sees ['A', 'B']

{'aggregate': ['A', 'B', 'A']}

为了更好地理解递归限制的工作原理,我们来看一个更复杂的例子。下面实现了一个循环,但其中一步分支成了两个节点:

import operator

from typing import Annotated, Literal

from typing_extensions import TypedDict

from langgraph.graph import StateGraph, START, ENDclass State(TypedDict):aggregate: Annotated[list, operator.add]def a(state: State):print(f'Node A sees {state["aggregate"]}')return {"aggregate": ["A"]}def b(state: State):print(f'Node B sees {state["aggregate"]}')return {"aggregate": ["B"]}def c(state: State):print(f'Node C sees {state["aggregate"]}')return {"aggregate": ["C"]}def d(state: State):print(f'Node D sees {state["aggregate"]}')return {"aggregate": ["D"]}# 定义节点

builder = StateGraph(State)

builder.add_node(a)

builder.add_node(b)

builder.add_node(c)

builder.add_node(d)# 定义边

def route(state: State) -> Literal["b", END]:if len(state["aggregate"]) < 7:return "b"else:return ENDbuilder.add_edge(START, "a")

builder.add_conditional_edges("a", route)

builder.add_edge("b", "c")

builder.add_edge("b", "d")

builder.add_edge(["c", "d"], "a")

graph = builder.compile()from IPython.display import Image, display

display(Image(graph.get_graph().draw_mermaid_png()))

这个图看起来复杂,但可以理解为一个超级步骤的循环:

- 节点 A

- 节点 B

- 节点 C 和 D(并发执行)

- 节点 A

- ……

我们有一个由四个超级步骤组成的循环,其中节点 C 和 D 并行执行。像之前一样调用图,我们会看到在达到终止条件前,完成了两个完整的“圈”:

result = graph.invoke({"aggregate": []})Node A sees []

Node B sees ['A']

Node D sees ['A', 'B']

Node C sees ['A', 'B']

Node A sees ['A', 'B', 'C', 'D']

Node B sees ['A', 'B', 'C', 'D', 'A']

Node D sees ['A', 'B', 'C', 'D', 'A', 'B']

Node C sees ['A', 'B', 'C', 'D', 'A', 'B']

Node A sees ['A', 'B', 'C', 'D', 'A', 'B', 'C', 'D']

但是如果我们将递归限制设置为 4,则只完成一圈,因为每圈包含四个超级步骤:

from langgraph.errors import GraphRecursionErrortry:result = graph.invoke({"aggregate": []}, {"recursion_limit": 4})

except GraphRecursionError:print("Recursion Error")Node A sees []

Node B sees ['A']

Node C sees ['A', 'B']

Node D sees ['A', 'B']

Node A sees ['A', 'B', 'C', 'D']

Recursion Error

异步(Async)

使用异步编程范式在并发运行 IO 密集型代码时(例如,对聊天模型提供者发起并发 API 请求),可以显著提升性能。

要将同步实现的图转换为异步实现,你需要:

- 将节点函数从

def改为async def。 - 在函数内部适当使用

await。 - 根据需求,使用

.ainvoke或.astream调用图。

由于许多 LangChain 对象实现了 Runnable 协议,且所有同步方法都有对应的异步版本,通常将同步图升级为异步图相对简单快捷。

以下示例演示了如何调用底层大语言模型(LLM)的异步接口,我们将以聊天模型为例:

安装命令: