在Windows本地部署Dify详细操作

Dify官网文档:产品简介 - Dify Docs

1.硬件要求

2.部署方式选择

本次我选择Docker Compose 部署,接下来我将根据官方文档指引,在windows电脑上完成dify本地部署

3.DockerCompose本地部署Dify

3.1 安装WSL2

官方安装WSL2的操作说明入口:

查看自己系统版本快捷键:Win+I—>系统—>系统信息

根据自己电脑版本,选择wsl2安装方式:

3.2 安装docker desktop

根据dify官网文档给的windows docker desktop安装方式,下载docker desktop

下载后,直接双击.exe文件安装

3.3 docker desktop配置

配置docker镜像下载地址:

启动docker-desktop,不需要登录,点击左上角【设置】

在【Docker Engine】里,配置docker镜像为国内下载地址,然后右下角点击【Apply&restart】

{

"registry-mirrors": [

"https://mirror.aliyuncs.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io"

]

}

3.4 安装dify

1.查看dify版本:https://github.com/langgenius/dify

2.克隆 dify 源代码至本地:

git clone https://github.com/langgenius/dify.git --branch 1.3.1 D:\dify-1.3.1

3.配置dify源码

将克隆下来的源码docker⽬录,重命名为: docker-dify-1.3.1

修改后:

在docker-dify-1.3.1⽬录下,将 .env.example ⽂件复制⼀份,重命名为 .env

复制重命名后:

4.启动dify容器

启动docker desktop

检查启动状态:

启动dify容器方法一:在线下载镜像并启动dify

在cmd下进入 docker-dify-1.3.1 目录,执⾏命令:

docker compose up -d

docker会⾃动下载dify所需的镜像,并启动dify,如下图:

下载过程:

下载完后自动启动:

启动完成后,进入docker desktop页面,会看到dify容器

以后只需要启动docker desktop即可启动dify

如果因为网络原因下载失败,可以使⽤离线的dify镜像包启动dify

启动dify容器方法二:使用离线的dify镜像包

dify-1.3.1-离线镜像包下载链接:

链接:https://pan.baidu.com/s/1oaOQ7p7Ojp466hvwSeM7og

提取码:H7s3

将dify-1.3.1-离线镜像包.zip 解压,放在任意⼀个英文目录下。在cmd下,进⼊到镜像包解压后的目录,依次执⾏命令:

docker load -i dify-api.tar

docker load -i dify-sendbox.tar

docker load -i dify-web.tar

docker load -i nginx.tar

docker load -i postgres.tar

docker load -i redis.tar

docker load -i squid.tar

docker load -i weaviate.tar

执⾏下面的命令,检查镜像是否都已经成功导⼊。

docker images

在cmd下进⼊到docker-dify-1.3.1 目录下,执⾏以下命令启动dify镜像

docker compose up -d

查看docker下面的镜像:

docker images

4.访问dify

- 如果dify安装在本地:登录地址:http://localhost/apps

- 如果dify安装在其他计算机或者本地虚拟机里:登录地址为:http://计算机ip/apps,比如我公司里由于禁用docker desktop,dify是通过wsl2里的docker engine部署的,那登录地址为:http://172.23.67.XX/apps (172.23.67.XX是wsl2的地址)

第一次访 问需要注册

5.添加大模型到Dify平台

5.1 添加ollama管理的本地大模型

启动ollama:菜单栏双击羊驼的图标

查看ollama的本地大模型:ollama list

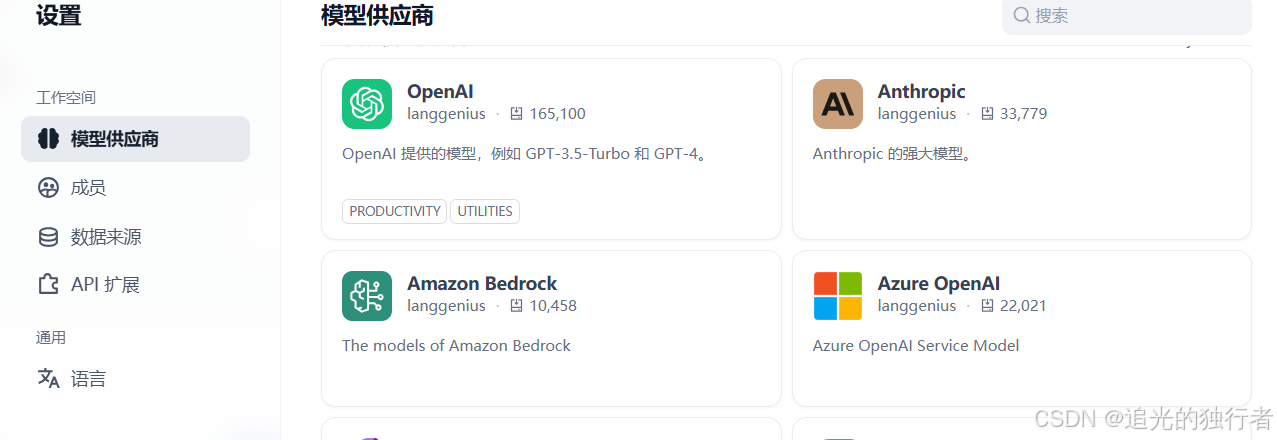

dify右上角个人头像——>设置——>模型供应商

在列表中找到对应的大模型——>安装

插件安装完成后,回到模型供应商页面,会在待配置列表里多出来一条记录:

在待配置列表点击【添加模型】

模型名称:Ollama本地管理的模型名称,通过ollama list指令查看

基础URL:是指dify访问ollama的地址

- 如果ollama和dify安装在同一台计算机上:默认:http://host.docker.internal:11434

- 如果ollama和dify是安装在不同的计算机,或者dify是安装在虚拟机里,这个地址是指:ollama所在计算机的地址。至于端口,ollama的端口默认是11434,但是要看自己的计算机11434端口是否被占用。

比如我公司里计算机11434端口被占用,安装ollama时系统环境变量里配置了端口:

变量名:OLLAMA_HOST

变量值(端⼝)::8000(8000前⾯有个冒号)

由于公司禁用docker desktop ,dify是安装在pc的里,pc的地址为:添加大模型时我的这个地址为:http://10.219.24.xx:8000 (10.219.24.xx是我的pc计算机ip)

添加完成后,会在模型列表中看到ollama:

5.2 添加远端大模型

5.2.1 添加硅基流动

在模型供应商里找到硅基流动

安装插件:

在待配置列表里右下角点击【添加模型】

在待配置列表里右下角点击【添加模型】

模型名称获取方式:打开硅基流动平台——>模型广场,点击模型,复制名称

API Key获取方式:打开硅基流动平台——>API秘钥,复制Key

API Key申请方式:请查阅我的另外一篇文章:申请deepseek Api Key的三种方式

右下角保存后,回到模型供应商可以看到硅基流动

5.2.2 添加火山引擎

大模型供应商列表里找到火山引擎

安装插件:

在待配置列表右下角点击【添加模型】

在待配置列表右下角点击【添加模型】

模型名称:火山引擎平台——>模型广场,复制模型名称

鉴权方式:Api Key

API Key:火山引擎平台——>API Key管理,复制Key

火山引擎地域:不用管

API Endpoint Host:不用管

Endpoint ID:火山引擎平台——>在线推理,复制接入点ID

API Key和Endpoint ID申请方法请查阅我的另外一篇文章:申请deepseek Api Key的三种方式

基础模型:下拉找到你想要的模型

最后右下角点击【保存】后,在回到模型供应商可以看到火山引擎了