建筑兔零基础人工智能自学记录101|Transformer(1)-14

Transformer

谷歌提出,一组编码-解码器

可以同时处理,通过位置编码来处理单词

实质是token词语接龙(只是有不同的概率)

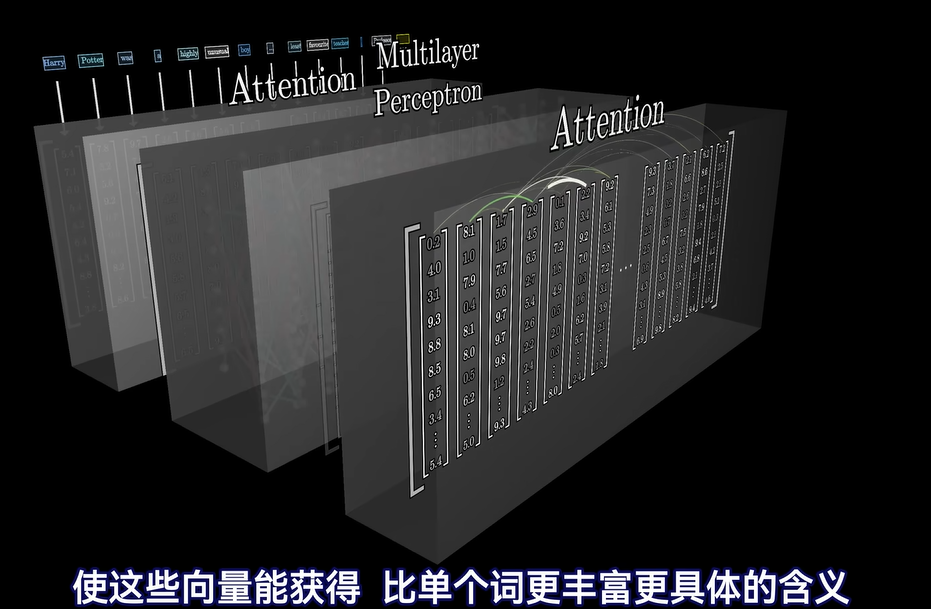

token对应向量

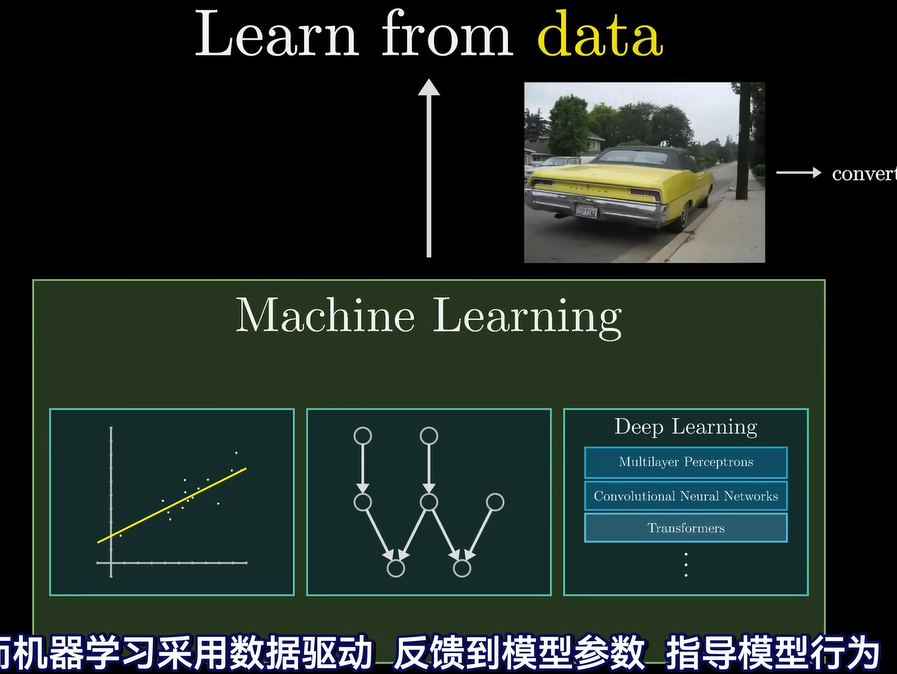

Transformer简述

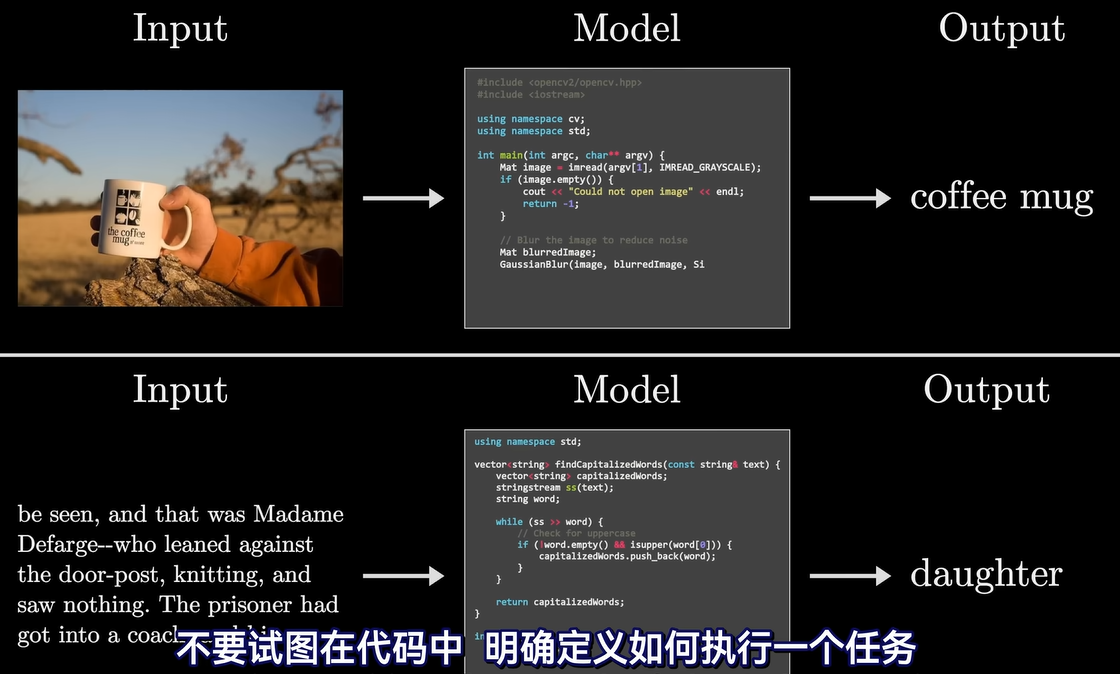

文生图就需要用到transformer黑箱

文生图就需要用到transformer黑箱

token

内部层次

中间主要是embedding matrix嵌入矩阵、attention注意力模块、multilayer perception多层感知机(MLP)

attention注意力模块内部是互相交流的、multilayer perception多层感知机(MLP)内部是并行不交流的

本质就是线性代数

实质通过矩阵运算

有不同的矩阵

有不同的矩阵

嵌入矩阵

如何推测的举例:1、男人之于女人≈国王之于王后

如何推测的举例:2、妈妈之于爸爸≈ 女人之于男人

3、希特勒+意大利-德国≈ 墨索里尼(从轴心国领导人/意大利两个角度找到)

4、寿司+德国-日本≈ 油煎香肠

点积是表达两个向量是否相近的方式,通过运算结果正负判断

![]()

context size就是一次处理向量的数量

所以当context size较少时,gpt会出现遗忘了之前说的

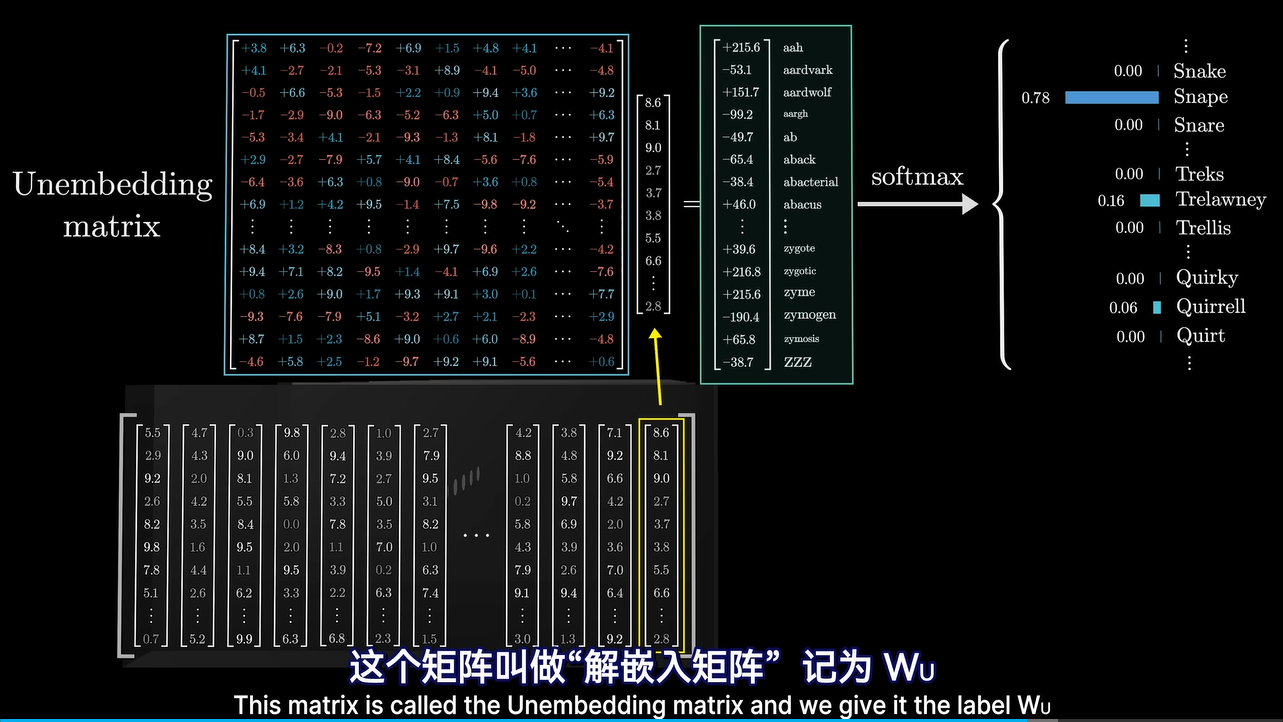

解嵌入矩阵

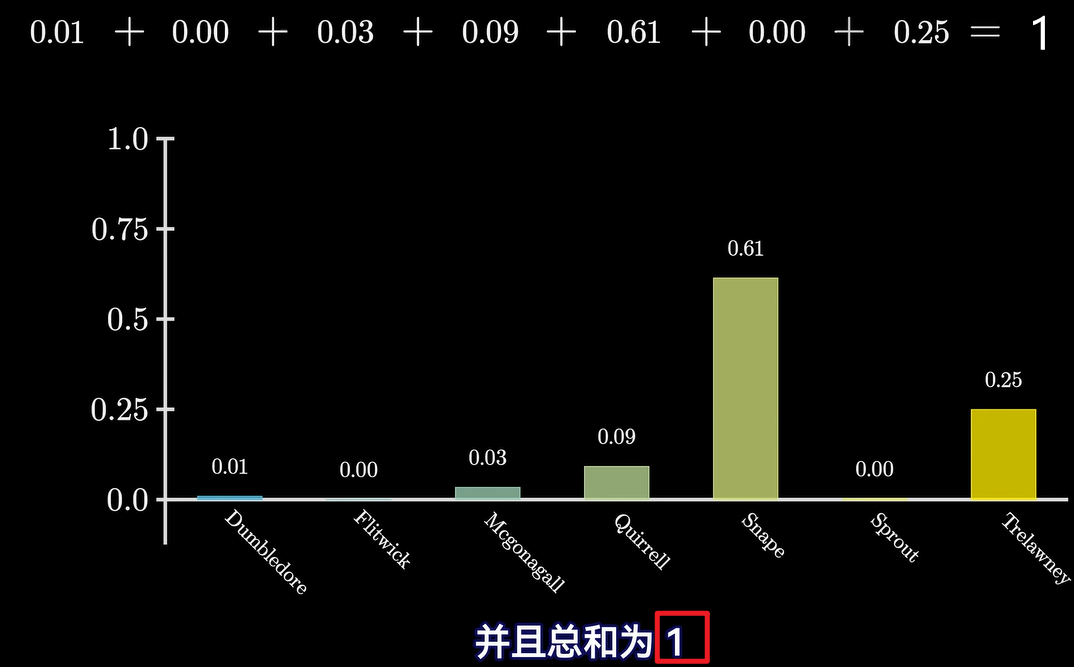

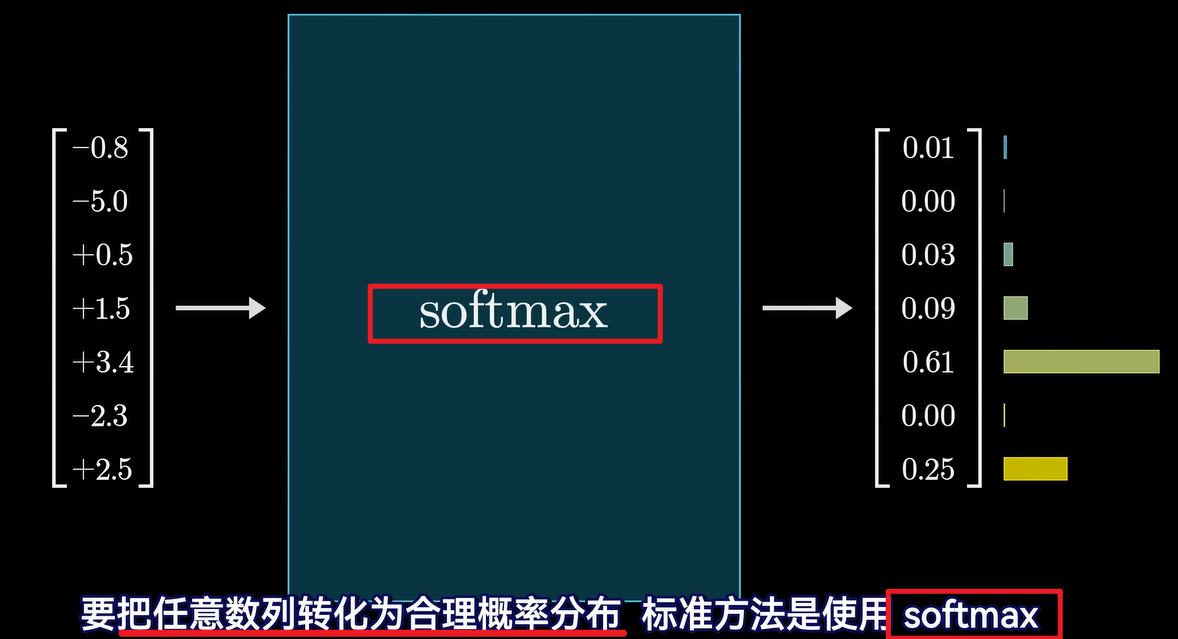

softmax

补充:另一个transformer介绍,不是很生动。所以只看了开头。