AI 学习入门之概述篇

前言

从ChatGPT到sora再到大模态大模型的爆发,AI 应用的形态从2022年末以来以不断丰富,随着deepseek 的横空出世,未来AI 也会朝着低成本、高性能的方向发展,2025年将成为AGI 元年,强人工智能时代已经到来。某种程度上,AI 已经在重塑我们的工作、生活方式,做为一名处理器设计工程师,从质疑AI →理解AI →学习AI →加入AI ,已经成为一种大势所趋。

近期也在恶补和AI 相关的知识,持续学习智能计算系统并进行分享将贯穿我的2025职场提升,这篇文章抛砖引玉,分享学到的一些知识,欢迎大家一起交流!

一、概述

(一)人工智能

1、分类

老生常谈,首先是人工智能的基本概念和分类。人工智能分为弱人工智能和强人工智能,弱人工智能是能够完成某种特定任务的人工智能,换个角度看,就是一种计算机科学的非平凡的应用。强人工智能或通用人工智能(Artificial General Intelligence, AGI),能表现正常人类所具有的各种智能行为。

人工智能的流派主要分为3类:

- 行为主义:基于控制论,构建感知-动作型控制系统

- 符号主义:基于符号逻辑的方法,用逻辑表示知识和求解问题

- 连接主义:基于大脑中神经元细胞连接的计算模型,用人工神经网络来拟合智能行为

符号主义最本质的问题是只考虑了理性认识的智能,具有一定的局限性,主要应用于强化学习;连接主义因为类比人工神经网络得到广泛应用。

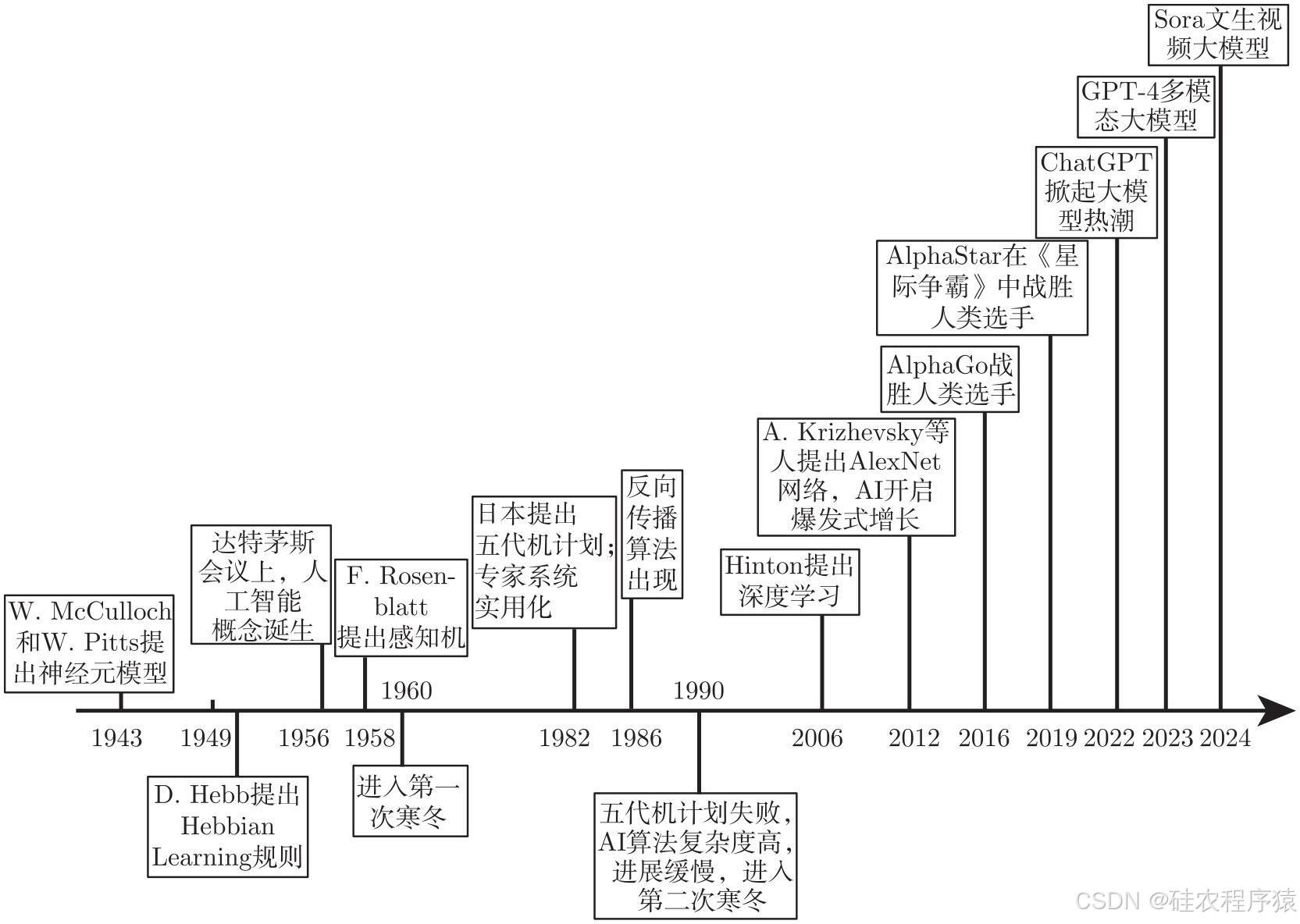

2、发展历程

人工智能的萌芽至少可以上溯到20世纪40年代,60多年的发展历史几起几落,经历了3次热潮,但也遇到了2次寒冬。

第一次热潮:1956年至20世纪60年代,达特茅斯会议驱动的第一次人工智能热潮是以符号逻辑为主要出发点的,也就是后来所谓的符号主义。还涌现出了几何定理证明者、国际象棋程序、跳棋程序、问答和规划系统等有一定影响力的成果。除了符号主义之外,连接主义在第一次人工智能热潮中也有所发展。该时期还提出了感知机模型。

第二次热潮:1975年至1991年,人工智能第二次热潮到来的标志性事件是1982年日本启动了雄心勃勃的五代机计划,反向传播学习算法的提出,使得神经网络重新成为研究的焦点,成为与符号主义并驾齐驱的连接主义方法。一方面,符号主义依然是旗手,但存在很多难以克服的困难,例如缺乏有足够表示能力同时又比较简练的逻辑,以及逻辑问题求解器的时间复杂度极高等;另一方面,连接主义方法(如神经网络)也没有找到真正落地的杀手级应用。

第三次热潮,2006年至今,深度学习神经网络成为主流,在语音识别、人脸识别、机器翻译等领域应用越来越广泛。GPT-4成为强人工智能的雏形。第三次热潮中的人工智能与达特茅斯会议时已经有显著的区别,连接主义成为压倒性的主流。

3、广泛应用

AI 技术广泛应用于计算机视觉CV、大语言模型NLP和图像处理、语音识别等领域,渗透到各行各业,包括医疗、量化交易、推荐算法、自动驾驶、游戏、安防和C 端应用等。

(二)智能计算系统

1、定义

做为一名芯片工程师,首先想解决的问题是大模型、算法、模型框架以及AI 芯片这几者之间的关系,这里就有了智能计算系统的概念。

人工智能算法或代码本身并不能构成一个完整的智能体,必须要在一个具体的物质载体上运行起来才能展现出智能。因此,智能计算系统就是智能的物质载体。现阶段的智能计算系统,硬件上通常是集成通用处理器和智能处理器的异构系统,软件上通常包括一套面向开发者的智能计算编程环境(包括编程框架和编程语言)。

人工智能技术分层如下图,既包括底层的硬件系统,也包括顶层的软件体系,目前在软件层面发展较好,但AI 芯片的发展远落后于国际先进水平,人工智能底层科技的缺失可能使得智能产业成为空中楼阁。

(1)异构智能计算系统

现今采用异构智能计算系统的主要原因:近十年来通用CPU 的计算能力增长近乎停滞,而智能计算能力的需求在不断以指数增长,二者形成了剪刀差。

异构系统在提高性能的同时,也带来了编程上的困难:

- 智能计算系统一般会集成一套编程环境,方便程序员快速便捷地开发高能效的智能应用程序

- 常用的深度学习编程框架包括TensorFlow 和MXNet等

- 深度学习编程语言包括CUDA 语言和BCL 语言等

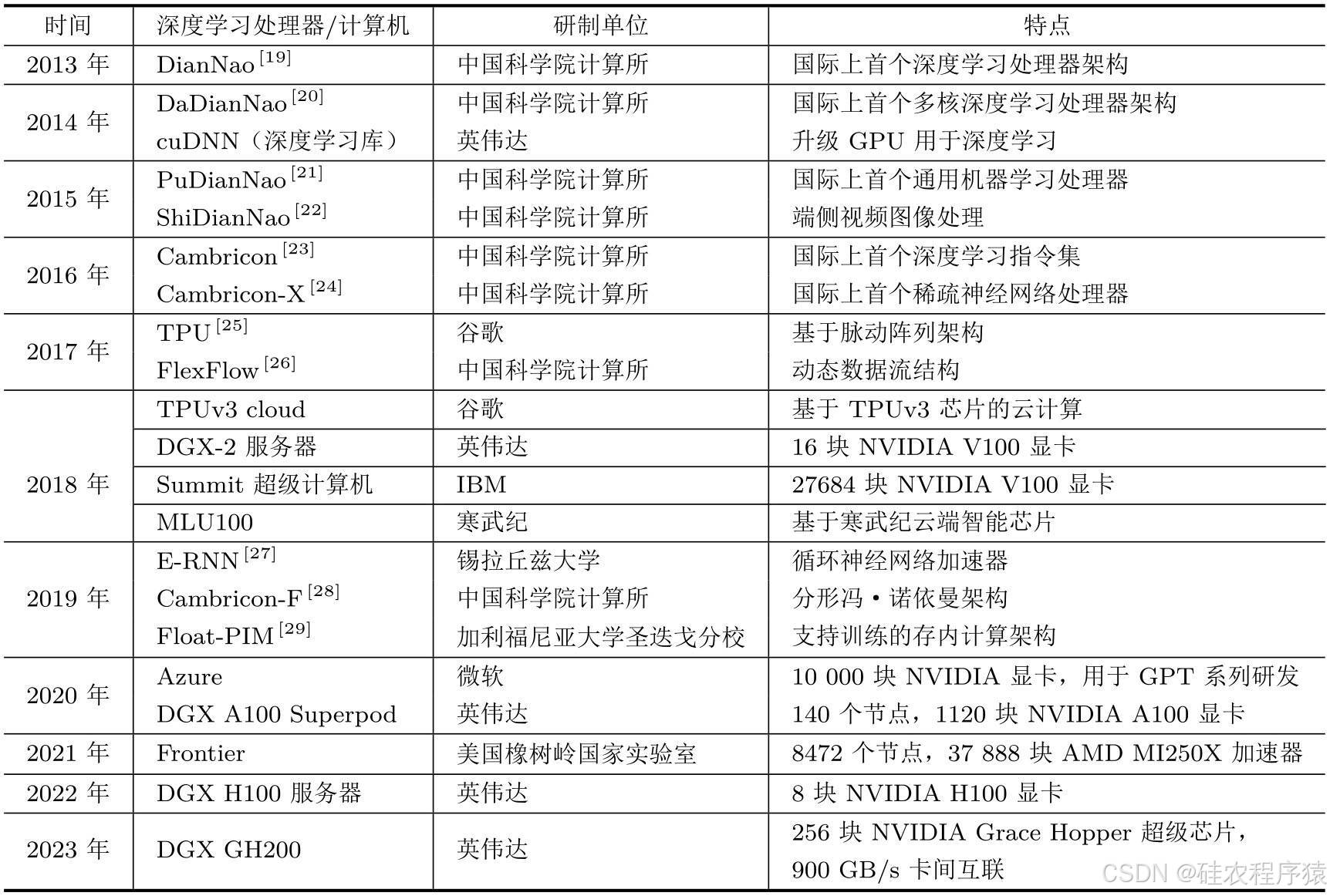

2、智能计算系统的发展

第一代智能计算系统:1980年代,面向符号主义智能处理的专用计算机(Prolog机,LISP机)

局限性:

①高级语言计算架构,OS的编程语言和硬件“统一”化,如LISP,只针对特定语言的优化

②由于摩尔定律发展,性能比不上CPU,价格昂贵,没有太多实际应用

第二代智能计算系统:2010年代,面向连接主义智能处理的专用计算机(深度学习计算机)

和第一代智能计算系统相比,第二代智能计算系统有两方面的优势:

①深度学习有大量实际的工业应用,已经形成了产业体系,因此相关研究能得到政府和企业的长期资助;

②摩尔定律在21 世纪发展放缓,通用CPU 性能增长停滞,专用智能计算系统的性能优势越来越大。

第三代智能计算系统:未来强人工智能/通用人工智能的载体

第三代智能计算系统具有近乎无限的计算能力,不再是智能算法的加速工具,将是通用人工智能(强人工智能)发育的沙盒虚拟世界。

具备全面感知能力和超大规模硬件的原始智人是怎样一步步获得智能的?

- 体系结构:面向海量并发认知智能计算线程和超大规模虚拟环境的计算机和芯片

- 算法:有限延迟的认知智能算法,能自主产生语言和文字,从本能之上建立起自己的知识图谱,打通感知到逻辑的鸿沟

- 编程框架,操作系统,网络等等都将为之巨变

(三)解决AI 任务

如何解决一个AI 任务是一个系统化的流程,这个处理过程主要包括5个步骤:输入→ 建模 → 实现 → 运行 → 输出

1、输入

就是原始的信息源和数据,已经存在的客观信息和数据

2、建模

建模的基石是神经网络基础和深度学习,神经网络类比于人脑神经元,包括输入层、隐层和输出层,当隐层个数大于1时就是多层神经网络(MLP)。下图为一个单隐藏层的神经网络

深度学习就是多层人工神经网络,深度学习最重要的作用是表征学习, 学习层级化的特征,“深度”这词指的就是很多层。深度学习是一把梯子,而不是火箭,原因在于泛化能力有限、缺乏推理能力、缺乏可解释性、鲁棒性欠佳

3、实现

实现主要依赖于编程框架和编程语言。将深度学习算法中的基本操作封装成一系列组件,帮助研究人员更简单的实现已有算法,或设计新的算法。这一系列深度学习组件,即构成一套深度学习框架。

常见的编程框架包括TensorFlow、PYtorch、caffe、Torch。以Pytorch为例,主要包括2个步骤:

1、构建数据流图,描述计算过程

2、执行数据流图,获得计算结果

异构编程语言是用基于C语言的扩展,简单易学,同时提供了丰富高效的编程接口,高效实现编程框架所需的算子,将神经网络的基本操作实现为能在寒武纪平台上运行的程序,以供编程框架调用。

4、运行

编程算法需要在处理器上完成执行和训练,主要涉及架构基础、架构设计和标准与评测。

架构基础依赖人工智能处理器,人工智能处理器主要是克服通用处理器的局限性,比如不可能扩展至人脑规模(百万亿突触)、性能和功耗问题。其发展简史包括:硬件化(计算和访存模式的适配)、算法优化(降低存储和计算量)和软硬件协同(面向硬件的算法优化)。

架构设计包括运算单元设计、存储层次设计、指令集设计、编程框架设计、多处理器架构设计,评测主要是根据测试基准(BbenchIP)完成对性能的评测。

5、输出

搭建运行环境,完成对代码的开发和编译从而实现对智能加速卡的运行,调试参考结果包括模型训练、性能剖析和系统监控。

二、关键概念

在深入学习AI知识之前,需要先弄清楚几个关键概念及它们之间的关系,如下图所示:

人工智能是最大的范畴、包括机器学习、计算机视觉和符号逻辑等分支,机器学习里面又包括很多子分支,比如人工神经网络、贝叶斯网络、决策树和线性回归等。目前最主流的机器学习方法是神经网络,而人工神经网络中最先进的技术是深度学习。

这篇文章仅对基本概念做简单介绍,后面的文章再详细展开。

关于机器学习有很多定义,目前统一的共性是:计算机通过不断地从经验或数据中学习来逐步提升智能处理能力,机器学习按照有无标签分为监督学习、无监督学习和强化学习。典型的机器学习过程如下图所示。

后续笔记会持续分享关于深度学习,神经网络的知识,欢迎交流探讨~