构建高可维护、易测试的异步任务系统:基于 Celery + Redis + Eventlet 的模块化架构实践

引言:为什么我们需要一个结构清晰的异步任务系统?

在现代软件开发中,异步任务已经成为提升响应性能、解耦业务逻辑、支持高并发的重要手段。尤其对于测试工程师而言,异步任务往往意味着:

- 任务执行不可控

- 状态追踪困难

- 异常处理复杂

- 自动化测试覆盖低

本文将带你从零开始,使用 Celery + Redis + Eventlet 构建一个结构清晰、易于维护和测试的异步任务系统。我们不仅关注功能实现,更强调代码组织、任务模块化、测试策略与可扩展性,确保你能够轻松驾驭复杂的异步场景。

一、项目结构设计与优化目标

✅ 设计目标:

- 模块化任务结构,便于维护和扩展;

- 支持自动化测试,状态可控;

- 易于调试与部署;

- 支持定时任务、协程池、任务重试等高级特性。

🧱 推荐包结构如下:

celery_test/

├── celery_task/ # Celery 核心任务包

│ ├── __init__.py # 包初始化

│ ├── celery.py # Celery 配置与实例初始化

│ ├── crawl_task.py # 爬虫类任务

│ ├── order_task.py # 订单类任务

│ └── user_task.py # 用户行为类任务

├── add_task.py # 触发异步任务

├── get_result.py # 查询任务结果

└── run_celery.sh # 启动 Worker 的快捷脚本(可选)

说明:这种结构清晰地划分了配置、任务、调用、监控四大部分,符合 Python 包管理规范,便于团队协作和后续扩展。

二、核心模块详解与最佳实践

1. celery_task/celery.py —— 统一配置中心

from celery import Celery

import os# 设置 Broker 和 Backend 地址

broker = 'redis://127.0.0.1:6379/1'

backend = 'redis://127.0.0.1:6379/2'# 初始化 Celery 实例

app = Celery('celery_task', # 应用名称,需与包名一致broker=broker,backend=backend,include=['celery_task.crawl_task','celery_task.order_task','celery_task.user_task']

)# 使用 eventlet 协程池(Windows 必须)

app.conf.worker_pool = 'eventlet'

app.conf.worker_concurrency = 4 # 并发数,可根据实际需求调整# 可选:设置软超时和重试机制

app.conf.update(task_default_queue='default',task_serializer='json',accept_content=['json'],result_serializer='json',timezone='Asia/Shanghai',enable_utc=True,

)

2. 任务模块 —— 按业务拆分,职责单一

示例:celery_task/crawl_task.py

import time

from .celery import app@app.task(bind=True, max_retries=3)

def crawl_(self):try:print('【爬虫任务】开始执行')time.sleep(3)print('【爬虫任务】执行结束')return '爬虫成功'except Exception as e:print(f'【爬虫任务】失败,准备重试... 错误:{e}')self.retry(exc=e, countdown=2) # 2秒后重试

测试价值:

- 支持任务失败自动重试;

- 日志输出明确,便于断言和验证;

- 可模拟异常,测试任务恢复能力。

3. 触发任务 —— add_task.py

from celery_task.crawl_task import crawl_if __name__ == '__main__':res = crawl_.delay() # 异步触发任务print(f"✅ 任务已提交,任务ID: {res.id}")

测试建议:

- 将此脚本作为接口测试中的异步操作入口;

- 可封装为工具函数供其他测试模块复用。

未启动worker时,运行add_task.py,则只会在broker中插入一条数据,不会运行。

启动worker之后,则会去broker中获取任务并执行。

运行完成后,broker中的数据会清除。

在backend中会新增一条数据。

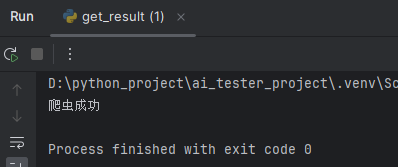

4. 获取任务结果 —— get_result.py

from celery_task.celery import app

from celery.result import AsyncResultif __name__ == '__main__':task_id = input("请输入任务ID: ")result = AsyncResult(id=task_id, app=app)if result.successful():print("✅ 任务成功:", result.get())elif result.failed():print("❌ 任务失败:", str(result.result))elif result.status == 'PENDING':print("⏳ 任务等待中...")elif result.status == 'RETRY':print("🔄 任务正在重试...")else:print(f"📌 当前任务状态: {result.status}")

测试价值:

- 支持状态判断和结果断言;

- 可用于接口测试中验证后台任务是否完成;

- 结合自动化测试框架(如 Pytest)进行断言验证。

三、启动 Celery Worker 与 Flower 监控

✅ 启动命令(在项目根目录运行):

celery -A celery_task worker -l info -P eventlet

✅ 启动定时任务调度器(Celery Beat):

先在 celery.py 中添加定时任务配置:

from celery.schedules import crontabapp.conf.beat_schedule = {'crawl-every-minute': {'task': 'celery_task.crawl_task.crawl_','schedule': crontab(minute='*/1'), # 每分钟执行一次},

}

然后启动 Beat:

celery -A celery_task beat -l info

✅ 安装并启动 Flower(任务监控):

pip install flower

celery -A celery_task flower

访问:http://localhost:5555 查看实时任务状态、Worker 负载、队列情况等。

测试价值:

- 实时监控任务执行状态;

- 快速定位任务失败原因;

- 支持性能分析与负载测试。

四、测试工程师的实战技巧与策略

✅ 测试用例编写示例(test_tasks.py)

import pytest

from celery_task.crawl_task import crawl_

from celery.result import AsyncResult

from celery_task.celery import app

import timedef test_crawl_task_success():res = crawl_.delay()time.sleep(4) # 等待任务完成assert res.status == "SUCCESS"assert res.get() == "爬虫成功"def test_crawl_task_retry():from unittest.mock import patchwith patch.object(crawl_, 'retry') as mock_retry:# 强制抛出异常以触发重试with pytest.raises(Exception):crawl_.apply(args=[True])assert mock_retry.called

测试要点总结:

- 断言任务状态;

- 模拟异常测试重试机制;

- 使用 Mock 工具隔离外部依赖;

- 集成到 CI/CD 系统中做持续验证。

五、常见问题与解决方案

| 问题 | 原因 | 解决方案 |

|---|---|---|

| 任务未注册 | include 路径错误 | 检查 celery.py 中的任务导入路径 |

| 无法获取结果 | AsyncResult 使用了错误的 app 实例 | 确保从同一 app 获取结果 |

| Windows 下任务不执行 | 缺少 eventlet | 添加 -P eventlet 参数 |

| 任务状态一直 PENDING | Redis 未启动 | 确保 Redis 正常运行 |

六、进阶建议与未来扩展方向

✅ 任务子包拆分(适用于大型项目):

celery_task/

├── __init__.py

├── celery.py

├── crawl/

│ ├── __init__.py

│ └── tasks.py

├── order/

│ ├── __init__.py

│ └── tasks.py

└── user/├── __init__.py└── tasks.py

更新 celery.py 中的 include:

include=['celery_task.crawl.tasks','celery_task.order.tasks','celery_task.user.tasks'

]

✅ 集成 Web 框架(如 FastAPI / Django)

通过 API 接口触发任务,并返回任务 ID,前端或测试脚本可通过 /result/<task_id> 查询状态。

七、总结:打造一个稳定、可测、可持续演进的异步系统

通过本文的模块化重构,你的异步任务系统将具备以下优势:

| 特性 | 描述 |

|---|---|

| ✅ 模块化清晰 | 任务按业务划分,易于维护 |

| ✅ 支持协程 | 使用 eventlet 提升 I/O 性能 |

| ✅ 易于测试 | 任务状态可控,支持断言与 Mock |

| ✅ 可视化监控 | Flower 实时查看任务状态 |

| ✅ 扩展性强 | 支持定时任务、分布式部署、子包拆分 |

八、行动号召:现在就开始搭建你的异步任务测试体系!

如果你希望:

- 更好地掌控异步流程;

- 提升自动化测试覆盖率;

- 在接口测试中验证后台任务;

- 构建高性能、稳定的测试基础设施;

那么,就从今天起,按照本文的指导,搭建属于你的 模块化、可测试、可扩展的异步任务系统!