服务器配置llama-factory问题解决

在配置运行llama-factory,环境问题后显示环境问题。这边给大家附上连接,我们的是liunx环境但是还是一样的。大家也记得先配置虚拟环境。

LLaMA-Factory部署以及微调大模型_llamafactory微调大模型-CSDN博客

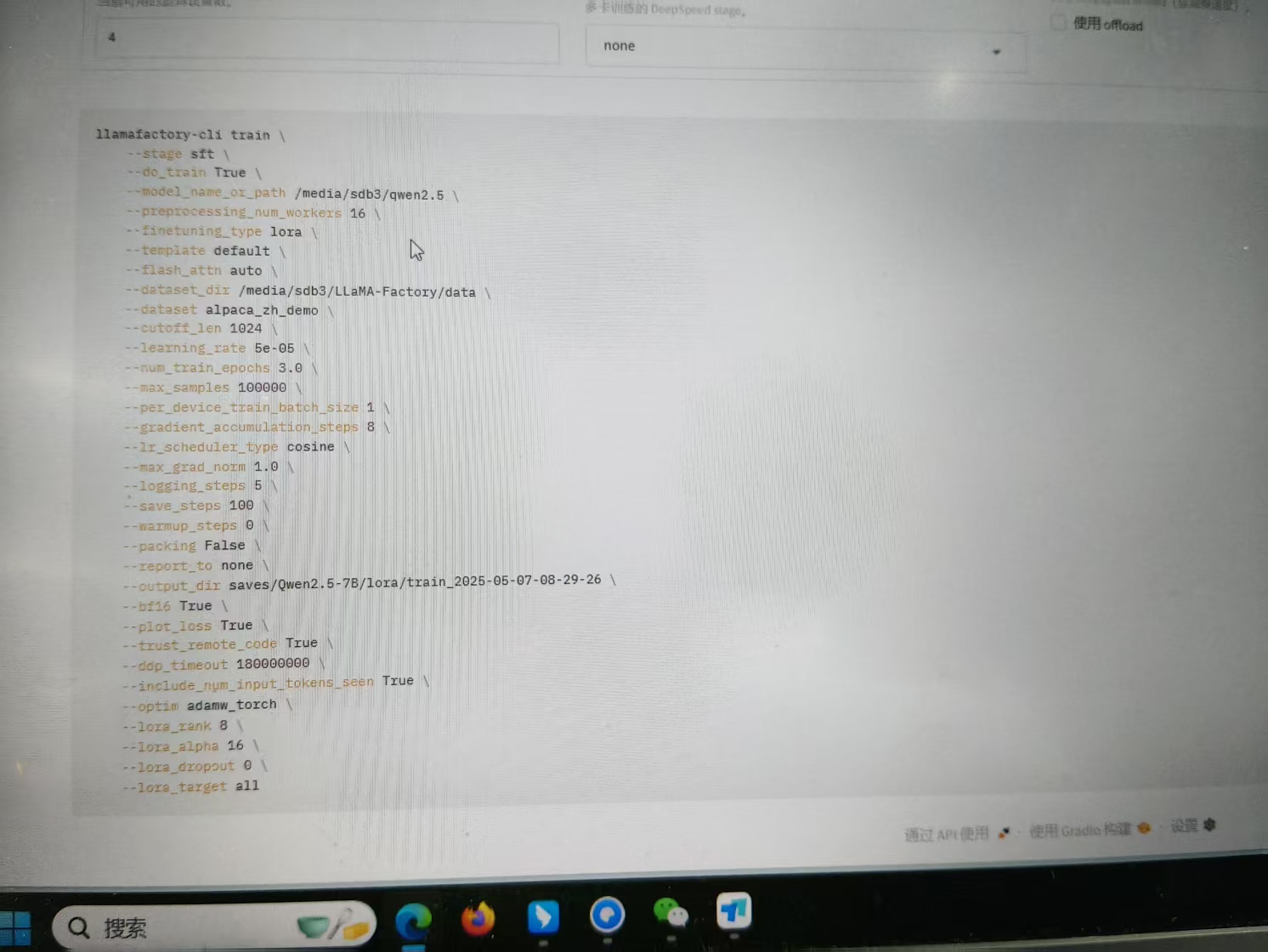

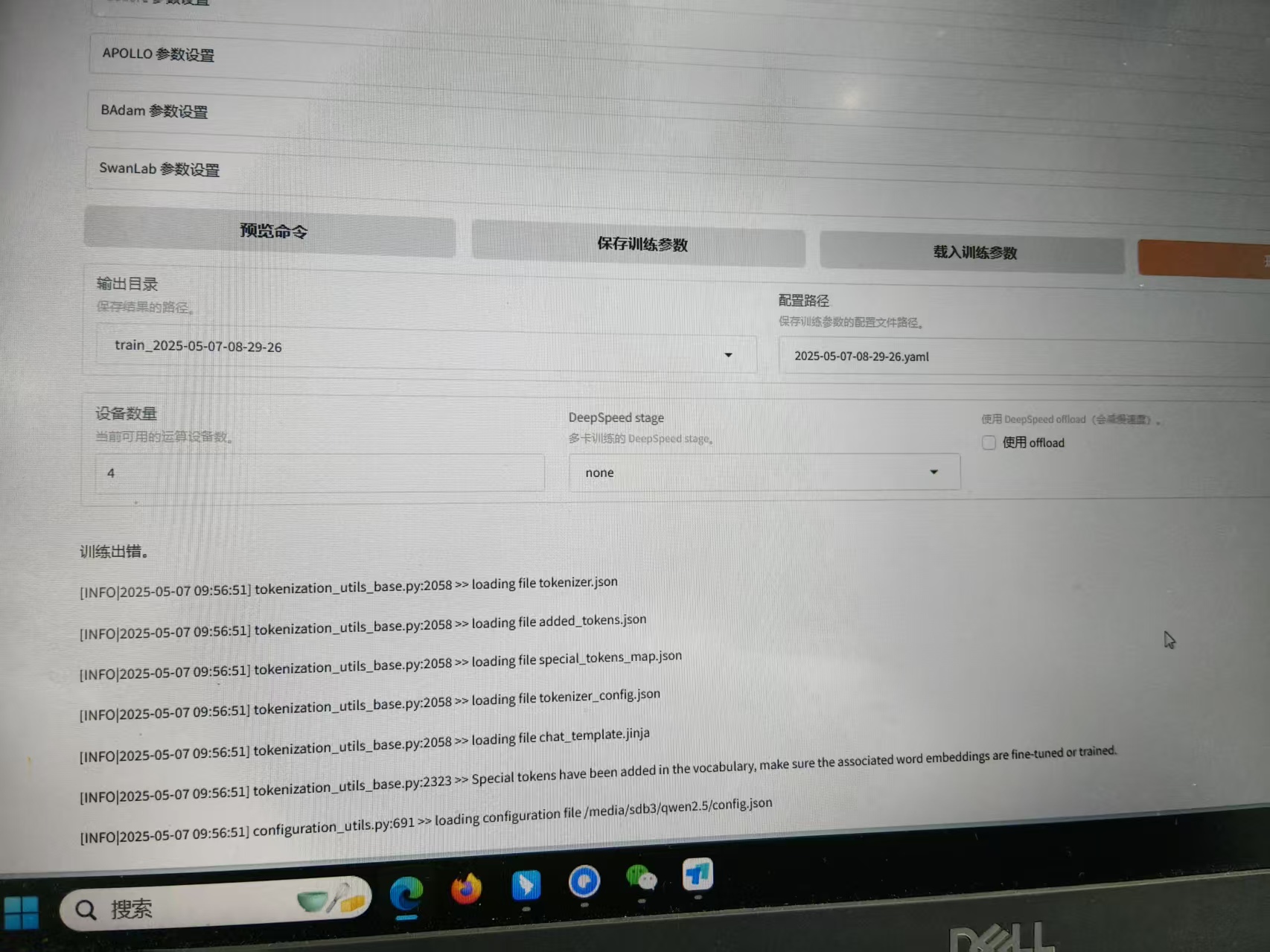

之后大家看看遇到的问题是不是我这样。

AI搜索的问题显示的是:

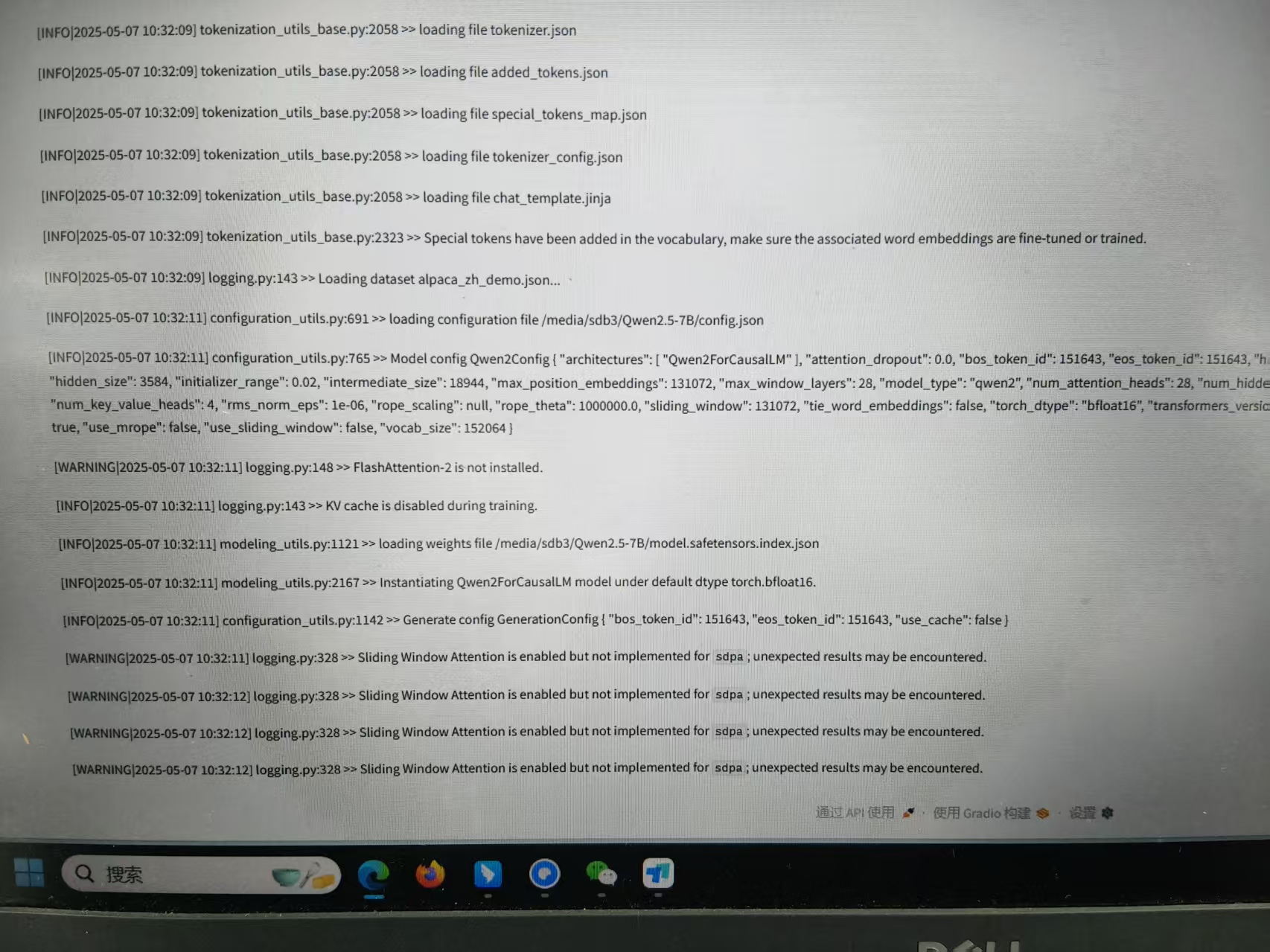

pip install flash-attn --no-build-isolation

这个不会安装cuda什么其他环境,那时候我更新了一下库,直接llama-factory瘫了。。

之后大家就可以美美调用了。

还有一个问题有时候显示缓存不足惹。。。。