【并行分布计算】Hadoop完全分布搭建

Hadoop完全分布搭建

1.为了使机器都处于同一个局域网中,先要修改机器的ip地址分配方式为固定ip,并为其固定分配一个ip地址。

[root@localhost ~]# vi /etc/sysconfig/network-scripts/ifcfg-ens33

问题:修改ip地址后,网络无法正常链接

解决方法:查看VMware上的DHCP设置中起始IP地址和结束IP地址范围,以及对应网关的IP地址,防止设置IP地址时选错IP地址范围。

修改后网络链接正常:

2.修改主机名,方便辨认机器

[root@localhost ~]# hostnamectl set-hostname hadoop01

修改主机名后需要重启虚拟机:

![]()

3. 配置网络映射 /etc/hosts

[root@hadoop01 ~]# vi /etc/hosts

4. 重启网络服务

[root@hadoop01 ~]# service network restart

![]()

5.安装ssh服务

(1)查看是否安装ssh

[root@hadoop01 ~]# rpm -qa | grep ssh

(2)启动ssh服务

[root@hadoop01 ~]# service sshd start

![]()

6.关闭防火墙

问题:

解决方法:centos7后是使用的基于iptable的systemctl stop firewalld

[root@hadoop01 ~]# yum install iptables-services

[root@hadoop01 ~]# systemctl stop firewalld

7. 开启Hadoop002,修改ip地址和修改主机名

vi /etc/sysconfig/network-scripts/ifcfg-ens33

systemctl restart network

[root@localhost ~]# hostnamectl set-hostname hadoop002

[root@localhost ~]# reboot

![]()

![]()

8. 开启Hadoop003,修改ip地址和主机名

vi /etc/sysconfig/network-scripts/ifcfg-ens33

systemctl restart network

[root@hadoop01 ~]# hostnamectl set-hostname hadoop003

[root@hadoop01 ~]# reboot

![]()

9. 配置hosts文件和ssh免密登录

(1)修改hosts配置文件(包括三台主机)

[root@hadoop01 ~]# vi /etc/hosts

(2)生成密钥文件

[root@hadoop01 ~]# ssh-keygen -t rsa

(3)将本机公钥文件复制到其它虚拟机上(3台主机都要执行)

(4)查看是否成功免密登录

10.hadoop集群配置

(1)在所有虚拟机根目录下新建文件夹export,export文件夹中新建data、servers和software文件

[root@hadoop01 ~]# mkdir -p /export/data

[root@hadoop01 ~]# mkdir -p /export/servers

[root@hadoop01 ~]# mkdir -p /export/software

(2)准备安装包

hadoop-2.7.6.tar.gz

jdk-8u161-linux-x64.tar.gz

(3)jdk安装(3台主机都安装)

[root@hadoop01 software]# tar -zxvf jdk-8u161-linux-x64.tar.gz -C /export/servers/

配置环境变量

vi /etc/profile

使配置文件生效

[root@hadoop01 servers]# source /etc/profile

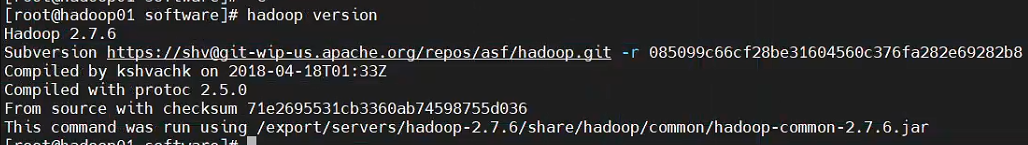

(4)hadoop安装(3台主机都安装)

[root@hadoop01 software]# tar -zxvf hadoop-2.7.6.tar.gz -C /export/servers/

配置文件

vi /etc/profile

[root@hadoop01 software]# source /etc/profile

[root@hadoop01 software]# hadoop version

(5)Hadoop集群配置

修改hadoop-env.sh文件

[root@hadoop01 hadoop]# vi hadoop-env.sh

修改core-site.xml文件

修改hdfs-site.xml文件

修改mapred-site.xml文件

[root@hadoop01 hadoop]# cp mapred-site.xml.template mapred-site.xml

[root@hadoop01 hadoop]# vi mapred-site.xml

修改yarn-site.xml文件

修改slaves文件

[root@hadoop01 hadoop]# vi slaves

将主节点中配置好的文件和hadoop目录copy给子节点

其中hadoop01为主节点,hadoop002和hadoop003为子节点

scp /etc/profile hadoop002:/etc/profile

scp /etc/profile hadoop003:/etc/profile

scp -r /export/ hadoop002:/

scp -r /export/ hadoop003:/

使子节点中的配置文件生效(hadoop02和hadoop03节点执行命令source /etc/profile)

![]()

![]()

在主节点格式化文件系统(successfully formatted 格式化成功)

hdfs namenode -format

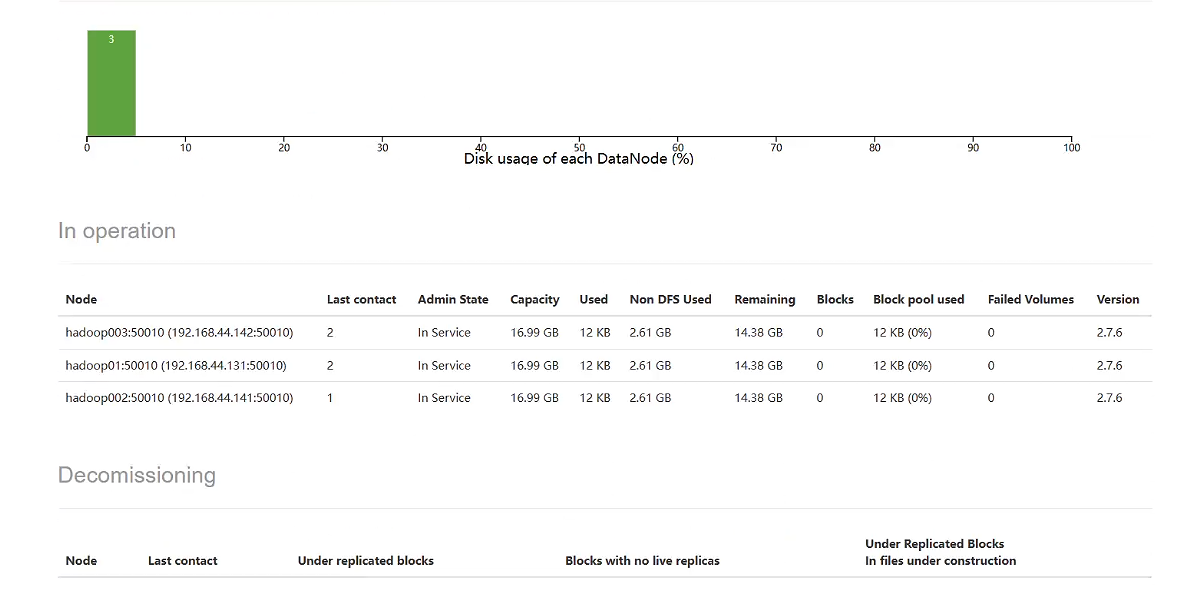

11.hadoop集群测试

(1)在主节点启动所有HDFS服务进程

[root@hadoop01 hadoop]# start-dfs.sh

[root@hadoop01 hadoop]# start-yarn.sh

(2)使用jps命令查看进程

在Windows系统下,访问http://hadoop01:50070,查看HDFS集群状态

在Windows系统下,访问http://hadoop01:8088,查看Yarn集群状态