【NLP 35、序列标注任务】

天,怎么还没变

念,不过两三年

—— 25.3.9

一、什么是序列标注任务

NLP中输入的每一句话都可以看作一个序列,其中的每一个字(单独的输入)都可以看作序列中的一个时间步

预测的结果是一个和输入等长的序列,对于序列中的每一个字(时间步)做分类,得到每个时间步的标签,预测出的标签与时间步等长

对于输入:X1X2X3X4…Xn

预测输出:Y1Y2Y3Y4…Yn

NLP中的应用场景: 分词,词性标注,句法分析,命名实体识别等

二、中文分词任务 —— 基于序列标注

对于每一个字,我们想判断它是不是一个词的边界

1.序列标注方式 — 四分类:

① B:词的左边界

② E:词的右边界

③ M:词的内部

④ S:单字

例:

优点:

规律明显,学习更加容易

2.序列标注方式 —— 二分类

对于每一个字,我们想判断它是不是一个词的边界:0 表示不是隔断句,1 表示是隔断

优点

二分类的学习比四分类更加简单,需要的计算资源更少

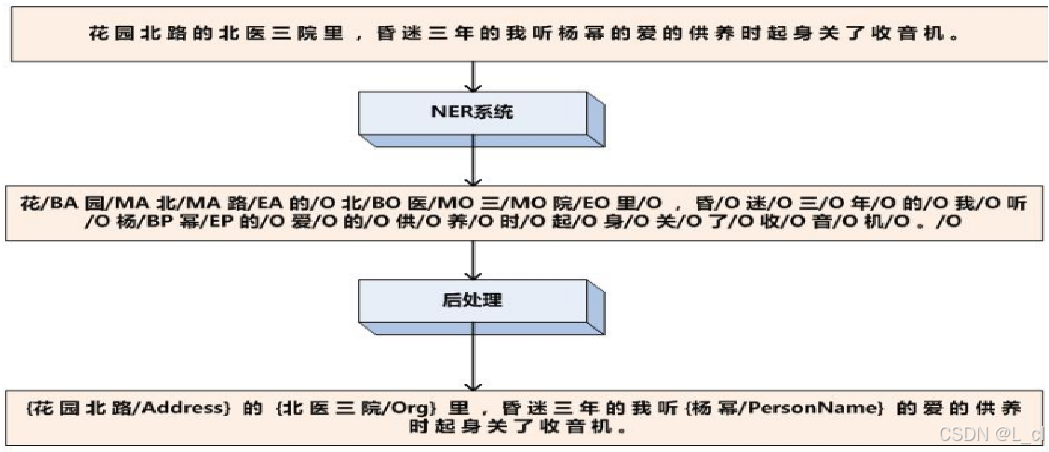

3.序列标注应用场景 —— 命名实体识别 NER

对于每个字做十分类,输入一段文本,输出一个与文本长度等长的序列,只要序列结果正确就可以找到各个正确实体的位置

BA:地址左边界 BO:机构左边界 BP:人名左边界 O:无关字(命名实体外的字)

MA:地址内部 MO:机构内部 MP:人名内部

EA:地址右边界 EO:机构右边界 EP:人名右边界

例:

需要人工标注正确的序列

三、中文分词 —— 基于深度学习 🚀

通过神经网络将每个 token 向量化,预测其分类标签

对于输入的每个字(token)向量化,得到每个字对应的向量,经过网络层后输出每个字预测的分类标签输出

1.模型初始化

代码运行流程

TorchModel (继承自nn.Module)

├── 1. 初始化方法 __init__()

│ ├── 1.1 嵌入层: nn.Embedding

│ │ ├── 参数: vocab_size=len(vocab)+1

│ │ └── 参数: input_dim=词向量维度

│ ├── 1.2 RNN层: nn.RNN

│ │ ├── input_size=嵌入层输出维度

│ │ ├── hidden_size=隐层维度

│ │ ├── num_layers=堆叠层数

│ │ ├── nonlinearity="relu" (激活函数)

│ │ └── dropout=0.1 (层间丢弃率)

│ ├── 1.3 分类层: nn.Linear

│ │ ├── in_features=隐层维度

│ │ └── out_features=2 (二分类输出)

│ └── 1.4 损失函数: nn.CrossEntropyLoss

│ └── ignore_index=-100 (忽略特定标签)

│

└── 2. 前向传播流程

├── 输入序列 → 嵌入层 → RNN层 → 分类层

└── 输出 → 损失计算(需配合标签)input_dim:词嵌入的向量维度(需与预训练词向量匹配)。

hidden_size:RNN 隐藏层神经元数量(影响模型容量)。

num_rnn_layers:RNN 堆叠层数(层数越多,模型越深)。

vocab:词汇表大小(决定 embedding 输出维度)。

nn.Embedding():将词索引(整数)映射为稠密向量(词嵌入),用于处理离散型文本数据。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

num_embeddings | int | None | 词汇表大小(即输入索引的最大值 + 1,例如 vocab_size=10000)。 |

embedding_dim | int | None | 嵌入向量的维度(如 128、256)。 |

padding_idx | int | -1 | 填充位置的索引(默认 -1,表示无填充)。用于忽略 [PAD] 标签。 |

scale_grad_by_freq | bool | False | 是否根据词频缩放梯度(减少高频词的梯度)。 |

device | str | None | 指定设备(如 "cuda" 或 "cpu")。 |

nn.RNN():实现循环神经网络(RNN)层,捕捉序列数据的时序依赖关系。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

input_size | int | None | 输入向量的维度(如词嵌入的输出维度)。 |

hidden_size | int | None | 隐藏层神经元的数量。 |

num_layers | int | 1 | RNN 的堆叠层数。 |

batch_first | bool | False | 输入数据形状是否为 (batch_size, sequence_length, input_size)。 |

bidirectional | bool | False | 是否为双向 RNN。 |

nonlinearity | str | "tanh" | 激活函数(如 "relu"、"sigmoid")。 |

dropout | float | 0.0 | Dropout 概率(防止过拟合)。 |

recurrent_dropout | float | 0.0 | RNN 层内部的 Dropout 概率。 |

bias | bool | True | 是否包含偏置项。 |

nn.Linear():全连接层,将输入线性映射到输出空间。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

in_features | int | None | 输入特征的数量。 |

out_features | int | None | 输出特征的数量。 |

bias | bool | True | 是否包含偏置项(默认为 True)。 |

nn.CrossEntropyLoss():计算交叉熵损失,常用于分类任务(如文本分类、NER)

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

ignore_index | int | -1 | 忽略标签的索引(如 [PAD] 标签设为 -1)。 |

weight | Tensor | None | 类别的权重(用于不平衡数据集)。 |

reduction | str | "mean" | 损失的缩减方式(如 "sum" 或 "mean")。 |

label_smoothing | float | 0.0 | 标签平滑系数(防止过拟合,如 0.1)。 |

def __init__(self, input_dim, hidden_size, num_rnn_layers, vocab):

super(TorchModel, self).__init__()

self.embedding = nn.Embedding(len(vocab) + 1, input_dim) #shape=(vocab_size, dim)

self.rnn_layer = nn.RNN(input_size=input_dim,

hidden_size=hidden_size,

batch_first=True,

bidirectional=False,

num_layers=num_rnn_layers,

nonlinearity="relu",

dropout=0.1)

self.classify = nn.Linear(hidden_size, 2)

self.loss_func = nn.CrossEntropyLoss(ignore_index=-100)2.前向传播

代码运行流程

forward 方法流程

├── 1. 输入处理

│ ├── 1.1 输入张量 x: (batch_size, sen_len)

│ └── 1.2 可选标签 y: (batch_size, sen_len)

│

├── 2. 嵌入层 (Embedding)

│ ├── 操作: self.embedding(x)

│ ├── 输出形状: (batch_size, sen_len, input_dim)

│ └── 作用: 将离散词索引映射为连续向量

│

├── 3. RNN层 (RNN Layer)

│ ├── 操作: self.rnn_layer(x)

│ ├── 输出形状: (batch_size, sen_len, hidden_size)

│ └── 作用: 提取时序特征,隐状态自动管理

│

├── 4. 分类层 (Classification)

│ ├── 操作: self.classify(x)

│ ├── 输出形状: (batch_size, sen_len, class_num=2)

│ └── 作用: 映射到二分类概率空间

│

├── 5. 分支逻辑 (根据标签存在性)

│ ├── 5.1 存在标签 y

│ │ ├── 操作: 计算交叉熵损失

│ │ ├── 维度变换: y_pred.view(-1, 2) → (batch_size*sen_len, 2)

│ │ ├── 标签展平: y.view(-1) → (batch_size*sen_len)

│ │ └── 返回: self.loss_func(预测值, 标签)

│ │

│ └── 5.2 无标签 y

│ └── 返回: 原始预测张量 y_pred

│

└── 6. 输出

├── 训练模式: 返回损失值(标量)

└── 推理模式: 返回预测概率张量input_dim:嵌入向量维度(需与 nn.Embedding 匹配)。

hidden_size:RNN 隐藏层大小。

class_num:分类任务类别数(如情感分析的正面/负面)。

loss_func.ignore_index: 忽略 [PAD] 标签的索引。

#当输入真实标签,返回loss值;无真实标签,返回预测值

def forward(self, x, y=None):

x = self.embedding(x) #output shape:(batch_size, sen_len, input_dim)

x, _ = self.rnn_layer(x) #output shape:(batch_size, sen_len, hidden_size)

y_pred = self.classify(x) #input shape:(batch_size, sen_len, class_num)

if y is not None:

#(batch_size * sen_len, class_num), (batch_size * sen_len, 1)

return self.loss_func(y_pred.view(-1, 2), y.view(-1))

else:

return y_pred

3. 构建数据

Ⅰ、构建词汇表

代码运行流程

build_vocab 函数流程

├── 1. 初始化空字典

│ └── 操作: `vocab = {}`

│

├── 2. 读取词表文件

│ ├── 操作: `with open(vocab_path, "r", encoding="utf8") as f`

│ ├── 逐行处理: `for index, line in enumerate(f)`

│ └── 字符映射:

│ ├── 字符提取: `char = line.strip()`

│ └── 索引分配: `vocab[char] = index + 1` (索引从1开始递增)

│

├── 3. 处理未知词(unk)

│ └── 操作: `vocab['unk'] = len(vocab) + 1`

│ ├── 作用: 为未登录词预留唯一标识符

│ └── 逻辑: 确保所有字符(包括unk)的索引不重复

│

└── 4. 返回词表

└── 操作: `return vocab`open():打开文件并返回文件对象,用于读写文件内容。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

file_name | str | 无 | 文件路径(需包含扩展名) |

mode | str | 'r' | 文件打开模式: - 'r': 只读- 'w': 只写(覆盖原文件)- 'a': 追加写入- 'b': 二进制模式- 'x': 创建新文件(若存在则报错) |

buffering | int | None | 缓冲区大小(仅二进制模式有效) |

encoding | str | None | 文件编码(仅文本模式有效,如 'utf-8') |

newline | str | '\n' | 行结束符(仅文本模式有效) |

closefd | bool | True | 是否在文件关闭时自动关闭文件描述符 |

dir_fd | int | -1 | 文件描述符(高级用法,通常忽略) |

flags | int | 0 | Linux 系统下的额外标志位 |

mode | str | 无 | (重复参数,实际使用中只需指定 mode) |

enumerate():遍历可迭代对象,同时返回元素的索引和值,简化循环计数逻辑。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

iterable | iterable | 无 | 需要遍历的可迭代对象(如列表、字符串、字典等)。 |

start | int | 0 | 索引的起始值(默认从 0 开始)。 |

strip():去除字符串两端的空白字符(如空格、换行符、制表符)或指定字符。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

chars | str | None | 指定要去除的字符集合(如 " \t\n\r")。默认去除空白字符。 |

#加载字表

def build_vocab(vocab_path):

vocab = {}

with open(vocab_path, "r", encoding="utf8") as f:

for index, line in enumerate(f):

char = line.strip()

vocab[char] = index + 1 #每个字对应一个序号

vocab['unk'] = len(vocab) + 1

return vocabⅡ、初始化数据集

代码运行流程

__init__ 方法流程

├── 1. 初始化对象

│ └── 操作: `super().__init__()`(隐式继承父类)

│

├── 2. 参数赋值

│ ├── 2.1 语料路径存储

│ │ └── 操作: `self.corpus_path = corpus_path`

│ │ └── 作用: 存储原始语料文件路径,如`corpus.txt`

│ │

│ ├── 2.2 词表加载

│ │ └── 操作: `self.vocab = vocab`

│ │ └── 作用: 保存字符到索引的映射,支持词向量转换

│ │

│ └── 2.3 序列长度限制

│ └── 操作: `self.max_length = max_length`

│ └── 作用: 控制输入序列最大长度,防止内存溢出

└── 3. 数据加载触发

└── 操作: `self.load()`

└── 作用: 调用自定义方法实现语料加载

└── 预期功能: 读取`corpus_path`文件内容

vocab:从 build_vocab 返回的词汇表

corpus_path:语料库文件路径

max_length:序列的最大长度

self.load():调用类方法,加载数据

def __init__(self, corpus_path, vocab, max_length):

self.vocab = vocab

self.corpus_path = corpus_path

self.max_length = max_length

self.load()Ⅲ、文本转序列

代码运行流程

sentence_to_sequence 函数流程

├── 1. 初始化序列

│ └── 操作: `sequence = []`

│ └── 作用: 创建空列表存储字符索引

│

├── 2. 遍历句子字符

│ ├── 循环逻辑: `for char in sentence`

│ └── 操作细节:

│ ├── 2.1 字符查询词表: `vocab.get(char, vocab['unk'])`

│ │ ├── 存在字符: 返回对应索引值(如 `"的" → 1024`)

│ │ └── 未登录字符: 返回 `unk` 索引(如 `"𓀀" → vocab['unk']=10001`)

│ └── 2.2 索引追加: 将结果添加至 `sequence` 列表

│

├── 3. 处理未知词(unk)

│ └── 逻辑: 当字符不在词表中时,使用预定义的 `unk` 兜底

│ └── 应用场景: 兼容生僻字、特殊符号或拼写错误

│

└── 4. 返回数字序列

└── 输出形式: `return sequence`

├── 示例输入: `sentence="自然语言处理", vocab={'自':1, '然':2, 'unk':0}`

└── 示例输出: `[1, 2, 0, 0, 0]`(假设后续字符未在词表中)遍历句子中的每个字符,查表得到索引,未知字符用

vocab['unk']替代。

字典.get():获取字典中指定键的值,若键不存在则返回默认值(避免 KeyError)

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

key | 任意类型 | 无 | 要获取的键。 |

default | 任意类型 | None | 键不存在时返回的值(可选)。 |

#文本转化为数字序列,为embedding做准备

def sentence_to_sequence(sentence, vocab):

sequence = [vocab.get(char, vocab['unk']) for char in sentence]

return sequenceⅣ、生成标签

代码运行流程

sequence_to_label 函数流程

├── 1. 输入处理

│ └── 操作: 接收句子 `sentence` 作为输入

│

├── 2. 分词处理

│ └── 操作: `words = jieba.lcut(sentence)`

│ ├── 作用: 使用 `jieba.lcut` 对句子进行精确分词,返回分词列表

│ └── 输出: `words` 列表,包含分词结果(如 `["我们", "是", "小青蛙"]`)

│

├── 3. 初始化标签序列

│ └── 操作: `label = [0] * len(sentence)`

│ ├── 作用: 创建与句子长度相同的全零列表,用于存储标注结果

│ └── 输出: `label` 列表(如 `[0, 0, 0, 0, 0, 0, 0]`)

│

├── 4. 遍历分词结果

│ ├── 操作: `for word in words`

│ └── 处理逻辑:

│ ├── 4.1 更新指针: `pointer += len(word)`

│ │ └── 作用: 记录当前分词在句子中的结束位置

│ └── 4.2 标注分词结束位置: `label[pointer - 1] = 1`

│ └── 作用: 在 `label` 列表中将分词结束位置标记为 1

│

└── 5. 返回标注结果

└── 操作: `return label`

├── 输出: 标注后的 `label` 列表

└── 示例: 输入 `sentence="我们是小青蛙"`,输出 `[0, 1, 0, 1, 0, 1, 1]`

jieba.lcut():对中文文本进行分词,返回词语列表(支持全模式和精确模式)。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

text | str | 无 | 需要分词的中文文本。 |

cut_all | bool | False | 是否启用全模式分词(True 切分更细)。 |

len():返回对象的长度或元素个数(字符串、列表、字典、元组等)。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

obj | 任意类型 | 无 | 需要计算长度的对象(如 list、str)。 |

#基于结巴生成分级结果的标注

def sequence_to_label(sentence):

words = jieba.lcut(sentence)

label = [0] * len(sentence)

pointer = 0

for word in words:

pointer += len(word)

label[pointer - 1] = 1

return labelⅤ、对数据进行填充 / 截断

代码运行流程

padding 方法流程

├── 1. 输入处理

│ ├── 1.1 输入序列: `sequence`(如 `[1, 2, 3, 4]`)

│ └── 1.2 输入标签: `label`(如 `[0, 1, 0, 1]`)

│

├── 2. 序列截断

│ └── 操作: `sequence = sequence[:self.max_length]`

│ ├── 作用: 将序列截断至最大长度 `self.max_length`

│ └── 示例: 若 `self.max_length=3`,则 `[1, 2, 3, 4]` → `[1, 2, 3]`

│

├── 3. 序列填充

│ └── 操作: `sequence += [0] * (self.max_length - len(sequence))`

│ ├── 作用: 用 `0` 填充序列至最大长度 `self.max_length`

│ └── 示例: 若 `self.max_length=5`,则 `[1, 2, 3]` → `[1, 2, 3, 0, 0]`

│

├── 4. 标签截断

│ └── 操作: `label = label[:self.max_length]`

│ ├── 作用: 将标签截断至最大长度 `self.max_length`

│ └── 示例: 若 `self.max_length=3`,则 `[0, 1, 0, 1]` → `[0, 1, 0]`

│

├── 5. 标签填充

│ └── 操作: `label += [-100] * (self.max_length - len(label))`

│ ├── 作用: 用 `-100` 填充标签至最大长度 `self.max_length`

│ └── 示例: 若 `self.max_length=5`,则 `[0, 1, 0]` → `[0, 1, 0, -100, -100]`

│

└── 6. 返回结果

└── 操作: `return sequence, label`

├── 输出: 填充后的序列和标签

└── 示例: 输入 `sequence=[1, 2, 3, 4]`, `label=[0, 1, 0, 1]`, `self.max_length=5`

├── 输出序列: `[1, 2, 3, 4, 0]`

└── 输出标签: `[0, 1, 0, 1, -100]`序列填充:截断至

max_length,不足部分用0填充。标签填充:截断至

max_length,不足部分用-100填充(表示无效标签)。

len():返回对象的长度或元素个数(字符串、列表、字典、元组等)。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

obj | 任意类型 | 无 | 需要计算长度的对象(如 list、str)。 |

def padding(self, sequence, label):

sequence = sequence[:self.max_length]

sequence += [0] * (self.max_length - len(sequence))

label = label[:self.max_length]

label += [-100] * (self.max_length - len(label))

return sequence, labelⅥ、加载数据

代码运行流程

load 方法流程

├── 1. 初始化数据列表

│ └── 操作: `self.data = []`

│ └── 作用: 创建一个空列表,用于存储处理后的数据

│

├── 2. 打开语料文件

│ └── 操作: `with open(self.corpus_path, encoding="utf8") as f`

│ ├── 作用: 以 UTF-8 编码打开语料文件

│ └── 文件句柄: `f`

│

├── 3. 逐行读取文件

│ ├── 操作: `for line in f`

│ └── 处理逻辑:

│ ├── 3.1 将句子转换为数字序列

│ │ └── 操作: `sequence = sentence_to_sequence(line, self.vocab)`

│ │ ├── 作用: 使用 `sentence_to_sequence` 函数将句子中的字符映射为数字序列

│ │ └── 输出: `sequence` 列表(如 `[1, 2, 3, 4]`)

│ │

│ ├── 3.2 生成标签序列

│ │ └── 操作: `label = sequence_to_label(line)`

│ │ ├── 作用: 使用 `sequence_to_label` 函数生成句子的标签序列

│ │ └── 输出: `label` 列表(如 `[0, 1, 0, 1]`)

│ │

│ ├── 3.3 填充序列和标签

│ │ └── 操作: `sequence, label = self.padding(sequence, label)`

│ │ ├── 作用: 使用 `padding` 方法将序列和标签填充至固定长度

│ │ └── 输出: 填充后的 `sequence` 和 `label` 列表(如 `[1, 2, 3, 0, 0]` 和 `[0, 1, 0, -100, -100]`)

│ │

│ ├── 3.4 转换为张量

│ │ ├── 操作: `sequence = torch.LongTensor(sequence)`

│ │ │ └── 作用: 将 `sequence` 列表转换为 PyTorch 的 `LongTensor`

│ │ └── 操作: `label = torch.LongTensor(label)`

│ │ └── 作用: 将 `label` 列表转换为 PyTorch 的 `LongTensor`

│ │

│ └── 3.5 添加到数据列表

│ └── 操作: `self.data.append([sequence, label])`

│ ├── 作用: 将处理后的序列和标签对添加到 `self.data` 列表中

│ └── 示例: `self.data = [[tensor([1, 2, 3, 0, 0]), tensor([0, 1, 0, -100, -100])], ...]`

│

├── 4. 数据量限制

│ └── 操作: `if len(self.data) > 10000: break`

│ ├── 作用: 如果 `self.data` 中的数据量超过 10000 条,则停止读取

│ └── 示例: 当 `len(self.data) == 10001` 时,退出循环

│

└── 5. 返回结果

└── 作用: `self.data` 列表中存储了所有处理后的数据,供后续使用open():打开文件并返回文件对象,用于读写文件内容。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

file_name | str | 无 | 文件路径(需包含扩展名) |

mode | str | 'r' | 文件打开模式: - 'r': 只读- 'w': 只写(覆盖原文件)- 'a': 追加写入- 'b': 二进制模式- 'x': 创建新文件(若存在则报错) |

buffering | int | None | 缓冲区大小(仅二进制模式有效) |

encoding | str | None | 文件编码(仅文本模式有效,如 'utf-8') |

newline | str | '\n' | 行结束符(仅文本模式有效) |

closefd | bool | True | 是否在文件关闭时自动关闭文件描述符 |

dir_fd | int | -1 | 文件描述符(高级用法,通常忽略) |

flags | int | 0 | Linux 系统下的额外标志位 |

mode | str | 无 | (重复参数,实际使用中只需指定 mode) |

torch.LongTensor():创建一个长整型张量,常用于 PyTorch 模型的输入或标签。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

data | list/tuple | 无 | 初始化数据(如 [1, 2, 3]) |

dtype | torch.dtype | torch.int64 | 数据类型(如 torch.long) |

device | str | None | 指定设备(如 "cuda:0") |

列表.append():向列表末尾添加单个元素

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

item | 任意类型 | 无 | 需要添加的元素。 |

def load(self):

self.data = []

with open(self.corpus_path, encoding="utf8") as f:

for line in f:

sequence = sentence_to_sequence(line, self.vocab)

label = sequence_to_label(line)

sequence, label = self.padding(sequence, label)

sequence = torch.LongTensor(sequence)

label = torch.LongTensor(label)

self.data.append([sequence, label])

if len(self.data) > 10000:

breakⅦ、构建数据加载器

代码运行流程

build_dataset 函数流程

├── 1. 输入参数

│ ├── 1.1 `corpus_path`: 语料文件路径

│ ├── 1.2 `vocab`: 词汇表,用于字符到索引的映射

│ ├── 1.3 `max_length`: 序列的最大长度

│ └── 1.4 `batch_size`: 每个批次的样本数量

│

├── 2. 创建自定义数据集

│ └── 操作: `dataset = Dataset(corpus_path, vocab, max_length)`

│ ├── 作用: 初始化自定义数据集对象

│ ├── 实现细节:

│ │ ├── 2.1 `__init__`: 初始化语料路径、词汇表和最大长度

│ │ ├── 2.2 `__len__`: 返回数据集的样本数量

│ │ └── 2.3 `__getitem__`: 根据索引返回处理后的序列和标签

│ └── 输出: `dataset` 对象

│

├── 3. 创建数据加载器

│ └── 操作: `data_loader = DataLoader(dataset, shuffle=True, batch_size=batch_size)`

│ ├── 作用: 将数据集包装为可迭代的数据加载器

│ ├── 参数说明:

│ │ ├── `shuffle=True`: 打乱数据顺序

│ │ └── `batch_size=batch_size`: 设置每个批次的样本数量

│ └── 输出: `data_loader` 对象

│

└── 4. 返回数据加载器

└── 操作: `return data_loader`

├── 作用: 返回可用于训练或推理的数据加载器

└── 示例: 输入 `corpus_path="data.txt"`, `vocab={"a":1, "b":2}`, `max_length=10`, `batch_size=32`

├── 输出: 一个 `DataLoader` 对象,支持按批次加载数据

└── 使用: `for batch in data_loader: ...`DataLoader():高效加载数据集,支持分批次、打乱顺序、多线程加载。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

dataset | Dataset | 无 | 自定义数据集对象。 |

batch_size | int | 1 | 每个批次的样本数量。 |

shuffle | bool | False | 是否在每个 epoch 开始时打乱数据。 |

num_workers | int | 0 | 使用多线程加载数据的工人数量。 |

#建立数据集

def build_dataset(corpus_path, vocab, max_length, batch_size):

dataset = Dataset(corpus_path, vocab, max_length) #diy __len__ __getitem__

data_loader = DataLoader(dataset, shuffle=True, batch_size=batch_size) #torch

return data_loader

4.模型训练 ⭐

代码运行流程

main 函数流程

├── 1. 初始化参数

│ ├── 1.1 `epoch_num = 10`:训练轮数

│ ├── 1.2 `batch_size = 20`:每次训练样本个数

│ ├── 1.3 `char_dim = 50`:每个字的维度

│ ├── 1.4 `hidden_size = 100`:隐含层维度

│ ├── 1.5 `num_rnn_layers = 3`:RNN 层数

│ ├── 1.6 `max_length = 20`:样本最大长度

│ ├── 1.7 `learning_rate = 1e-3`:学习率

│ ├── 1.8 `vocab_path = "chars.txt"`:字表文件路径

│ └── 1.9 `corpus_path = "corpus.txt"`:语料文件路径

│

├── 2. 建立字表

│ └── 操作: `vocab = build_vocab(vocab_path)`

│ ├── 作用: 从字表文件中构建词汇表

│ └── 输出: `vocab` 字典,包含字符到索引的映射

│

├── 3. 建立数据集

│ └── 操作: `data_loader = build_dataset(corpus_path, vocab, max_length, batch_size)`

│ ├── 作用: 从语料文件中构建数据集,并返回数据加载器

│ └── 输出: `data_loader` 对象,支持按批次加载数据

│

├── 4. 建立模型

│ └── 操作: `model = TorchModel(char_dim, hidden_size, num_rnn_layers, vocab)`

│ ├── 作用: 初始化模型,定义网络结构

│ └── 输出: `model` 对象,包含模型参数和计算逻辑

│

├── 5. 建立优化器

│ └── 操作: `optim = torch.optim.Adam(model.parameters(), lr=learning_rate)`

│ ├── 作用: 使用 Adam 优化器优化模型参数

│ └── 输出: `optim` 对象,包含优化逻辑

│

├── 6. 训练模型

│ ├── 6.1 训练轮数循环: `for epoch in range(epoch_num)`

│ └── 6.2 每轮训练逻辑:

│ ├── 6.2.1 设置模型为训练模式: `model.train()`

│ ├── 6.2.2 初始化损失列表: `watch_loss = []`

│ ├── 6.2.3 遍历数据加载器: `for x, y in data_loader`

│ │ ├── 6.2.3.1 梯度归零: `optim.zero_grad()`

│ │ ├── 6.2.3.2 计算损失: `loss = model(x, y)`

│ │ ├── 6.2.3.3 反向传播: `loss.backward()`

│ │ └── 6.2.3.4 更新权重: `optim.step()`

│ ├── 6.2.4 记录损失: `watch_loss.append(loss.item())`

│ └── 6.2.5 打印平均损失: `print("第%d轮平均loss:%f" % (epoch + 1, np.mean(watch_loss)))`

│

├── 7. 保存模型

│ └── 操作: `torch.save(model.state_dict(), "model.pth")`

│ ├── 作用: 将模型参数保存到文件

│ └── 输出: 模型文件 `model.pth`

│

├── 8. 保存词表

│ └── 操作:

│ ├── 8.1 打开文件: `writer = open("vocab.json", "w", encoding="utf8")`

│ ├── 8.2 写入词表: `writer.write(json.dumps(vocab, ensure_ascii=False, indent=2))`

│ └── 8.3 关闭文件: `writer.close()`

│ └── 输出: 词表文件 `vocab.json`

│

└── 9. 返回

└── 操作: `return`

└── 作用: 结束函数执行① 参数配置

epoch_num:训练轮数

batch_size:每轮训练的样本个数

char_dim:每个字的维度

hidden_size:隐含层(中间层)维度

num_rnn_layer:循环神经网络rnn层数

max_length:样本的最大长度

learning_rate:学习率

vocab_path:字 / 词表文件路径

corpus_path:语料文件路径

epoch_num = 10 #训练轮数

batch_size = 20 #每次训练样本个数

char_dim = 50 #每个字的维度

hidden_size = 100 #隐含层维度

num_rnn_layers = 3 #rnn层数

max_length = 20 #样本最大长度

learning_rate = 1e-3 #学习率

vocab_path = "chars.txt" #字表文件路径

corpus_path = "corpus.txt" #语料文件路径② 构建词汇表

vocab:调用build_vocab函数建立字表

vocab = build_vocab(vocab_path) #建立字表③ 构建数据集和数据加载器

data_loader:调用build_dataset数据加载器函数建立数据集

data_loader = build_dataset(corpus_path, vocab, max_length, batch_size) #建立数据集④ 初始化模型

model:调用TorchModel类建立模型

char_dim:每个字的维度 hidden_size:隐含层维度 num_rnn_layers:RNN网络层数

vocab:建立的字表

model = TorchModel(char_dim, hidden_size, num_rnn_layers, vocab) #建立模型⑤ 初始化优化器

optim:调用torch库函数建立优化器

torch.optim.Adam():创建 Adam 优化器,用于深度学习模型的参数优化。结合动量梯度下降和自适应学习率,提升训练稳定性。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

params | iterable | None | 需要优化的参数(如 model.parameters()) |

lr | float | 1e-3 | 学习率(如 0.001) |

betas | tuple | (0.9, 0.99) | 动量系数(β₁, β₂) |

eps | float | 1e-8 | 梯度裁剪的极小值(防止除零错误) |

weight_decay | float | 0 | 权重衰减系数(正则化) |

model.parameters():返回模型中所有可训练参数的迭代器,用于优化器绑定。

optim = torch.optim.Adam(model.parameters(), lr=learning_rate) #建立优化器⑥ 模型训练主流程

model.train():将模型切换为训练模式(启用 Dropout、BatchNorm 等训练专用层)。

optim.zero_grad():将优化器的梯度归零,为反向传播准备。

loss.backward():计算损失值对模型参数的梯度,沿计算图反向传播。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

retain_graph | bool | False | 是否保留计算图(需梯度多次更新时设为 True)。 |

create_graph | bool | False | 是否为梯度创建计算图(用于高阶导数)。 |

optim.step():根据梯度更新模型参数。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

closure | callable | None | 可选闭包函数,用于动态计算梯度。 |

列表.append():向列表末尾添加单个元素。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

item | 任意类型 | 无 | 需要添加的元素。 |

loss.item():将标量损失值转换为 Python 标量(如 float),用于计算平均值或记录日志。

np.mean():计算数组或可迭代对象的平均值。

#训练开始

for epoch in range(epoch_num):

model.train()

watch_loss = []

for x, y in data_loader:

optim.zero_grad() #梯度归零

loss = model(x, y) #计算loss

loss.backward() #计算梯度

optim.step() #更新权重

watch_loss.append(loss.item())

print("=========\n第%d轮平均loss:%f" % (epoch + 1, np.mean(watch_loss)))⑦ 模型保存

torch.save():保存模型参数到磁盘,支持自定义保存路径和文件名。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

obj | any | None | 需要保存的对象(如 model.state_dict())。 |

f | file_like | None | 文件句柄(若未提供,需指定 save_path 和 filename)。 |

save_path | str | None | 保存目录路径。 |

filename | str | None | 保存文件名(默认为 model.pth)。 |

tuple_to_numpy | bool | False | 是否将元组转换为 NumPy 数组。 |

open():打开文件并返回文件对象,用于读写操作。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

file_name | str | 无 | 文件路径(需包含扩展名)。 |

mode | str | 'r' | 文件打开模式(如 'w'、'a')。 |

buffering | int | None | 缓冲区大小(仅二进制模式有效)。 |

encoding | str | None | 文件编码(如 'utf-8')。 |

newline | str | '\n' | 行结束符。 |

write():向文件写入指定内容

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

content | str | None | 需要写入的字符串内容。 |

json.dumps(): 将 Python 对象序列化为格式化的 JSON 字符串,支持自定义编码规则、缩进、字符集等,常用于数据持久化或 API 交互。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

obj | any | None | 需要序列化的 Python 对象(如字典、列表、类实例等)。 |

indent | int/str | None | 缩进空格数(如 4)或缩进字符串(如 " "),美化 JSON 输出。 |

ensure_ascii | bool | True | 是否强制将非 ASCII 字符转义为 Unicode 码点(如 \\u4e2d)。设为 False 保留原始字符。 |

sort_keys | bool | False | 是否对字典的键进行排序。 |

default | callable | None | 自定义序列化函数,处理不可序列化对象(如 datetime)。 |

separators | tuple | (', ') | 分隔符元组(如 (',', ': ')),控制项间格式。 |

skipkeys | bool | False | 是否跳过字典中值为 None 的键。 |

cls | type | None | 自定义 JSON 编码器类(如 json.JSONEncoder 的子类)。 |

close():关闭文件对象,释放系统资源。

#保存模型

torch.save(model.state_dict(), "model.pth")

#保存词表

writer = open("vocab.json", "w", encoding="utf8")

writer.write(json.dumps(vocab, ensure_ascii=False, indent=2))

writer.close()5.调用模型预测

代码运行流程

predict 函数流程

├── 1. 初始化参数

│ ├── 1.1 `char_dim = 50`:每个字的维度

│ ├── 1.2 `hidden_size = 100`:隐含层维度

│ ├── 1.3 `num_rnn_layers = 3`:RNN 层数

│ ├── 1.4 `model_path`:模型权重文件路径

│ ├── 1.5 `vocab_path`:字表文件路径

│ └── 1.6 `input_strings`:待预测的字符串列表

│

├── 2. 建立字表

│ └── 操作: `vocab = build_vocab(vocab_path)`

│ ├── 作用: 从字表文件中构建词汇表

│ └── 输出: `vocab` 字典,包含字符到索引的映射

│

├── 3. 建立模型

│ └── 操作: `model = TorchModel(char_dim, hidden_size, num_rnn_layers, vocab)`

│ ├── 作用: 初始化模型,定义网络结构

│ └── 输出: `model` 对象,包含模型参数和计算逻辑

│

├── 4. 加载模型权重

│ └── 操作: `model.load_state_dict(torch.load(model_path))`

│ ├── 作用: 加载训练好的模型权重

│ └── 输出: 更新后的 `model` 对象,包含训练好的参数

│

├── 5. 设置模型为评估模式

│ └── 操作: `model.eval()`

│ ├── 作用: 关闭 dropout 和 batch normalization 等训练模式

│ └── 输出: 模型进入评估模式

│

├── 6. 逐条预测

│ ├── 6.1 遍历输入字符串列表: `for input_string in input_strings`

│ └── 6.2 每条字符串的处理逻辑:

│ ├── 6.2.1 将字符串转换为数字序列: `x = sentence_to_sequence(input_string, vocab)`

│ │ ├── 作用: 使用 `sentence_to_sequence` 函数将字符串映射为数字序列

│ │ └── 输出: `x` 列表,包含字符对应的索引(如 `[1, 2, 3, 4]`)

│ │

│ ├── 6.2.2 打印数字序列: `print(x)`

│ │ └── 作用: 输出数字序列,便于调试和观察

│ │

│ ├── 6.2.3 模型预测: `with torch.no_grad(): result = model.forward(torch.LongTensor([x]))[0]`

│ │ ├── 作用: 使用模型进行前向传播,生成预测结果

│ │ └── 输出: `result` 张量,包含模型输出的概率分布

│ │

│ ├── 6.2.4 获取预测标签: `result = torch.argmax(result, dim=-1)`

│ │ ├── 作用: 对概率分布取 argmax,生成预测的 01 序列

│ │ └── 输出: `result` 张量,包含预测的标签(如 `[0, 1, 0, 1]`)

│ │

│ ├── 6.2.5 打印预测标签: `print(result)`

│ │ └── 作用: 输出预测的 01 序列,便于调试和观察

│ │

│ └── 6.2.6 切分并打印文本: `for index, p in enumerate(result): ...`

│ ├── 作用: 根据预测的 01 序列切分文本,并在预测为 1 的地方添加空格

│ └── 输出: 切分后的文本(如 `"我 是 小青蛙"`)

│

└── 7. 返回

└── 操作: 结束函数执行① 参数配置

char_dim:每个字的维度

hidden_size:隐含层(中间层)维度

num_rnn_layer:循环神经网络rnn层数

② 构建词汇表

vocab:调用build_vocab函数建立字表

vocab = build_vocab(vocab_path) #建立字表④ 初始化模型

model:调用TorchModel类建立模型

char_dim:每个字的维度 hidden_size:隐含层维度 num_rnn_layers:RNN网络层数

vocab:建立的字表

model = TorchModel(char_dim, hidden_size, num_rnn_layers, vocab) #建立模型⑤ 加载模型权重

model.load_state_dict():加载预训练模型的权重到当前模型中,用于模型恢复或迁移学习。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

state_dict | dict | None | 包含模型参数的字典(如 torch.load("model.pth") 的输出)。 |

strict | bool | False | 是否严格匹配参数名称和形状(True 会报错不匹配项)。 |

torch.load():从磁盘加载保存的 PyTorch 模型、张量或优化器状态。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

file_path | str | None | 文件保存路径(如 "model.pth")。 |

map_location | callable | None | 自定义张量存储位置(如 lambda storage, loc: storage.load(loc))。 |

pickle_module | module | pickle | 自定义序列化模块(如 dill)。 |

model.load_state_dict(torch.load(model_path)) #加载训练好的模型权重

⑥ 设置模型为预测模式

model.eval():将模型切换为评估模式,关闭训练专用层(如 Dropout、BatchNorm)。

⑦ 预测主流程

序列转换:将输入字符串转换为模型可识别的索引序列。

#逐条预测

x = sentence_to_sequence(input_string, vocab)模型推理:加载预训练模型,输出每个时间步的类别概率。

torch.no_grad():在推理或评估时禁用梯度计算,节省内存和计算资源。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

disable_gradient | bool | True | 是否禁用梯度计算(仅影响 autograd 操作)。 |

torch.LongTensor():将数据转换为 PyTorch 的长整型张量。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

data | array_like | None | 输入数据(如列表、NumPy 数组)。 |

dtype | torch.dtype | torch.long | 数据类型(默认 torch.long)。 |

device | str | None | 指定设备(如 "cuda")。 |

torch.argmax():返回张量中最大值的索引。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

dim | int | None | 沿指定维度搜索最大值(如 dim=-1 表示最后一维)。 |

keepdim | bool | False | 是否保留原维度(True 返回形状相同的索引张量)。 |

out | Tensor | None | 输出结果存储的位置。 |

with torch.no_grad():

result = model.forward(torch.LongTensor([x]))[0]

result = torch.argmax(result, dim=-1) #预测出的01序列结果切分:根据预测标签为 1 的位置,对原始字符串进行实体分割。

格式化输出:在实体边界插入空格,打印分割结果。

enumerate():遍历可迭代对象,同时返回元素的索引和值。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

iterable | iterable | None | 需要遍历的可迭代对象(如列表、生成器)。 |

start | int | 0 | 索引的起始值(如 start=1)。 |

#在预测为1的地方切分,将切分后文本打印出来

for index, p in enumerate(result):

if p == 1:

print(input_string[index], end=" ")

else:

print(input_string[index], end="")完整代码

#coding:utf8

import torch

import torch.nn as nn

import jieba

import numpy as np

import random

import json

from torch.utils.data import DataLoader

"""

基于pytorch的网络编写一个分词模型

我们使用jieba分词的结果作为训练数据

看看是否可以得到一个效果接近的神经网络模型

"""

class TorchModel(nn.Module):

def __init__(self, input_dim, hidden_size, num_rnn_layers, vocab):

super(TorchModel, self).__init__()

self.embedding = nn.Embedding(len(vocab) + 1, input_dim) #shape=(vocab_size, dim)

self.rnn_layer = nn.RNN(input_size=input_dim,

hidden_size=hidden_size,

batch_first=True,

bidirectional=False,

num_layers=num_rnn_layers,

nonlinearity="relu",

dropout=0.1)

self.classify = nn.Linear(hidden_size, 2)

self.loss_func = nn.CrossEntropyLoss(ignore_index=-100)

#当输入真实标签,返回loss值;无真实标签,返回预测值

def forward(self, x, y=None):

x = self.embedding(x) #output shape:(batch_size, sen_len, input_dim)

x, _ = self.rnn_layer(x) #output shape:(batch_size, sen_len, hidden_size)

y_pred = self.classify(x) #input shape:(batch_size, sen_len, class_num)

if y is not None:

#(batch_size * sen_len, class_num), (batch_size * sen_len, 1)

return self.loss_func(y_pred.view(-1, 2), y.view(-1))

else:

return y_pred

class Dataset:

def __init__(self, corpus_path, vocab, max_length):

self.vocab = vocab

self.corpus_path = corpus_path

self.max_length = max_length

self.load()

def load(self):

self.data = []

with open(self.corpus_path, encoding="utf8") as f:

for line in f:

sequence = sentence_to_sequence(line, self.vocab)

label = sequence_to_label(line)

sequence, label = self.padding(sequence, label)

sequence = torch.LongTensor(sequence)

label = torch.LongTensor(label)

self.data.append([sequence, label])

if len(self.data) > 10000:

break

def padding(self, sequence, label):

sequence = sequence[:self.max_length]

sequence += [0] * (self.max_length - len(sequence))

label = label[:self.max_length]

label += [-100] * (self.max_length - len(label))

return sequence, label

def __len__(self):

return len(self.data)

def __getitem__(self, item):

return self.data[item]

#文本转化为数字序列,为embedding做准备

def sentence_to_sequence(sentence, vocab):

sequence = [vocab.get(char, vocab['unk']) for char in sentence]

return sequence

#基于结巴生成分级结果的标注

def sequence_to_label(sentence):

words = jieba.lcut(sentence)

label = [0] * len(sentence)

pointer = 0

for word in words:

pointer += len(word)

label[pointer - 1] = 1

return label

#加载字表

def build_vocab(vocab_path):

vocab = {}

with open(vocab_path, "r", encoding="utf8") as f:

for index, line in enumerate(f):

char = line.strip()

vocab[char] = index + 1 #每个字对应一个序号

vocab['unk'] = len(vocab) + 1

return vocab

#建立数据集

def build_dataset(corpus_path, vocab, max_length, batch_size):

dataset = Dataset(corpus_path, vocab, max_length) #diy __len__ __getitem__

data_loader = DataLoader(dataset, shuffle=True, batch_size=batch_size) #torch

return data_loader

def main():

epoch_num = 10 #训练轮数

batch_size = 20 #每次训练样本个数

char_dim = 50 #每个字的维度

hidden_size = 100 #隐含层维度

num_rnn_layers = 3 #rnn层数

max_length = 20 #样本最大长度

learning_rate = 1e-3 #学习率

vocab_path = "chars.txt" #字表文件路径

corpus_path = "corpus.txt" #语料文件路径

vocab = build_vocab(vocab_path) #建立字表

data_loader = build_dataset(corpus_path, vocab, max_length, batch_size) #建立数据集

model = TorchModel(char_dim, hidden_size, num_rnn_layers, vocab) #建立模型

optim = torch.optim.Adam(model.parameters(), lr=learning_rate) #建立优化器

#训练开始

for epoch in range(epoch_num):

model.train()

watch_loss = []

for x, y in data_loader:

optim.zero_grad() #梯度归零

loss = model(x, y) #计算loss

loss.backward() #计算梯度

optim.step() #更新权重

watch_loss.append(loss.item())

print("=========\n第%d轮平均loss:%f" % (epoch + 1, np.mean(watch_loss)))

#保存模型

torch.save(model.state_dict(), "model.pth")

#保存词表

writer = open("vocab.json", "w", encoding="utf8")

writer.write(json.dumps(vocab, ensure_ascii=False, indent=2))

writer.close()

return

#最终预测

def predict(model_path, vocab_path, input_strings):

#配置保持和训练时一致

char_dim = 50 # 每个字的维度

hidden_size = 100 # 隐含层维度

num_rnn_layers = 3 # rnn层数

vocab = build_vocab(vocab_path) #建立字表

model = TorchModel(char_dim, hidden_size, num_rnn_layers, vocab) #建立模型

model.load_state_dict(torch.load(model_path)) #加载训练好的模型权重

model.eval()

for input_string in input_strings:

#逐条预测

x = sentence_to_sequence(input_string, vocab)

print(x)

with torch.no_grad():

result = model.forward(torch.LongTensor([x]))[0]

result = torch.argmax(result, dim=-1) #预测出的01序列

print(result)

#在预测为1的地方切分,将切分后文本打印出来

for index, p in enumerate(result):

if p == 1:

print(input_string[index], end=" ")

else:

print(input_string[index], end="")

print()

if __name__ == "__main__":

main()

# print(jieba.lcut("今天天气不错我们去春游吧"))

# print(sequence_to_label("今天天气不错我们去春游吧"))

# print(sentence_to_sequence("今天天气不错我们去春游吧"))

# input_strings = ["同时国内有望出台新汽车刺激方案",

# "沪胶后市有望延续强势",

# "经过两个交易日的强势调整后",

# "昨日上海天然橡胶期货价格再度大幅上扬"]

# predict("model.pth", "chars.txt", input_strings)

四、CRF —— 条件随机场

CRF是为了解决,当预测某一个字为一种实体的左边界时,则其右边不可能是其余实体的内部或右边界,我们运用另一个矩阵控制序列前后转移的概率(相关性)

CRF的本质是在神经网络中加入一个CRF - 转移矩阵

1.CRF - 转移矩阵

CRF - 转移矩阵:标签数量 × 标签数量,本质上学习的是字和字之间两两标签转移的概率

START 和 END 可以看作两个特殊的符号,标记句子的开始和句子的结束

2.发射矩阵

发射矩阵:对于一句话中的每一个字进行四分类预测,判断其作为词的左右边界、词的内部、单字的概率。

3.结合发射矩阵和转移矩阵

CRF - 转移矩阵可以分别学习到某个类别的字转移到其他类别字的概率,然后与 发射矩阵学习到的输入向量过神经网络预测到的两字间的概率值相加,总和进行比较,对输入序列进行预测

CRF - 条件随机场输出的转移矩阵 可以与 向量经过神经网络后得出的发射矩阵结合使用,输出一个更优的预测结果

转移矩阵可以影响发射矩阵的结果,相当于在神经网络结构中加入一层神经网络

作用:规避一些不合理的序列输出

4.CRF —— Loss定义

① 输入序列 X,输出序列为 y的路径分数:A 为转移矩阵(代表前一个字向后一个字转移的概率),P 为发射矩阵(过神经网络的每个字对应的概率值),s(X, y) 代表任意一条路径的正确概率得分

s(X, y) = log(A * P) = logA + logP(这里的路径分数可以看作结合两矩阵,再做 log 运算后的)

② 输入序列X,预测输出序列为y的概率:对上式做softmax,对 步骤 ① 得到的所有路径分数做归一化

③ 对上式取log,目标为最大化该值(方便计算,与 p(y | X) 成正比):

依然希望这个 log (p(y | X)) 路径分数是最大的

④ 对上式取相反数做loss,目标为最小化该值:

其他路径的总概率得分之和的 log 值 - 正确路径的总概率得分

CRF会明显拖慢训练速度,以效率的角度考虑可以不使用CRF

序列标注任务需要位置对应

而如果使用Bert模型,则做序列标注任务时,label标签在前后都需要加一个占位符,将Bert模型的CLS和SCP标识符包括

文本分类任务与序列标注任务模型结构的主要区别:pooling 归一化层

5.CRF —— 源码解读

博主文章:【NLP 36、CRF条件随机场 —— 源码解读】-CSDN博客

五、解码方式

1.篱笆墙解码【动态规划问题】

篱笆墙问题最简单的解法 —— 暴力求解,计算所有路径和所有节点的概率值,找到最好的路径

计算次数:D ^ n (D为每一层的节点数,n为计算层数)

2.篱笆墙解码优化方式 ① Beam Search解码

首先定义一个 Beam Size,代表保留路径的最大数目;剪枝操作,将每一段的路径分别算出,然后计算每一小段路径的概率,将概率由高到低进行pa保留 Beam SIze 数目,这样每次剪枝,保留Beam Size数目路径,最终计算次数为:n * Beam Size * D,D为每一层的节点个数,n为路径的长度(计算层数 / 时间步的数目)

特例:Greedy Search 贪婪解码

将Beam Search设置为1,相当于每一步只保留结果最好的数,然后在下一层进行判断

3.篱笆墙解码优化方式 ② 维特比解码

对每一层的各个节点,分别计算对下一层的所有节点的概率值,然后每个结点保留概率值最高的一条路径,然后再对下一层的每个节点进行计算,最终计算次数为:n * D * D,D为每一层的节点个数,n为路径的长度(计算层数 / 时间步的数目)

4.效率对比

假设共有 n 组(列)节点,每一组节点平均数量为 D

穷举路径计算复杂度为:D ^ n

维特比解码复杂度为:n * D ^ 2

Beam Search解码复杂度为:n * D * B,B为BeamSize ,可以允许 B 超过 D

维特比解码 和 Beam Search解码复杂度主要比较 D 和 B 的大小关系 D为每一层的结点个数,等同于词表大小,n为路径的长度(计算层数 / 时间步的数目)

在序列标注任务上,用维特比编码的形式会多一点, 主要因为序列标注任务上,每一层结点数 D 不会过大

在生成式任务上,用Beam Search编码的形式多一点,因为生成式任务的节点数量 D 等同于词表大小

若序列标注任务中使用了CRF,则一般与维特比编码一起使用

若不使用CRF - 条件随机场,则不会出现篱笆墙解码问题

5.应用场景

Ⅰ、信息抽取与知识图谱构建

① 结构化数据生成:

从非结构化文本(如新闻、论文)中提取人名、地名、机构名等实体,生成结构化数据。例如,在新闻“苹果公司2024年发布新款手机”中提取“苹果公司”(机构名)和“2024年”(时间)

在生物医学领域,从科研文献中提取基因、蛋白质、疾病等实体,支持药物研发和医学研究

② 知识图谱构建:

通过实体间的关联(如“姚明→中国篮协”),构建实体关系网络,支持语义搜索和智能问答。例如,将企业收购事件中的“主体-行为-对象”三元组结构化存储

Ⅱ、智能交互与内容理解

① 问答对话系统

识别用户问题中的关键实体(如“北京今天天气”中的“北京”和“今天”),精准匹配知识库中的答案

在客服场景中,通过识别用户咨询中的产品名称、故障类型等实体,自动路由到对应服务模块

② 机器翻译

保留专有名词的语义一致性。例如,将“Apple Inc.”正确翻译为“苹果公司”而非字面翻译,避免歧义

Ⅲ、行业垂直应用

① 金融与法律分析

在财报中提取公司名、财务指标(如“净利润增长20%”),辅助投资决策

法律文书中识别案件相关人、时间、地点,加速案件检索与证据链构建

② 医疗健康

从电子病历中提取疾病名称(如“糖尿病”)、药物剂量,支持临床诊断和个性化治疗

③ 社交媒体与舆情监控

分析微博、评论中的品牌名、产品名,统计热点事件传播路径。例如,追踪“某品牌新品发布”的提及量和情感倾向

Ⅳ、内容生成与优化

① 自动摘要与推荐系统

从长文本中提取核心实体(如新闻中的关键人物和事件),生成简洁摘要

根据用户历史行为中的实体偏好(如“科幻电影”),优化推荐内容

② 广告与营销

识别用户搜索词中的产品类目(如“运动鞋”),定向推送相关广告

Ⅴ、科研与安全领域

① 情报分析

从公开报告中提取军事设施、技术术语等敏感实体,支持风险预警

② 学术研究

在论文中标注化学物质、实验方法,构建学科知识库

6.评价指标

序列标注准确率 ≠ 实体挖掘准确率

实体需要完整命中才能算正确

对于标注序列要进行解码

准确率:

精确率:![]()

召回率:![]()

F1score:F1 Score 是精确率(Precision)和召回率(Recall)的调和平均数,它是信息检索、机器学习和统计分类中常用的一种评估指标,旨在综合考虑精确率和召回率,用于衡量分类模型的性能。

Macro - F1(宏观):对每个类别分别计算 F1 Score,然后取平均值。对于多分类问题,如果有 N个类别,先计算每个类别的精确率Precision和召回率Recall,并得到每个类别的 F1Score ,然后计算它们的平均值,公式:

Micro - F1(微观):将所有类别的样本合并计算准确率和召回率,之后计算F1;将所有类别的真阳性(True Positives)、假阳性(False Positives)和假阴性(False Negatives)分别累加,然后根据这些累加值计算出一个总体的精确率和召回率,再计算 F1Score

公式:

区别在于是否考虑类别样本数量的均衡

Macro - F1 和 Micro - F1 选择策略

① 样本均衡且类别重要性相同:优先使用Macro-F1

② 样本不均衡但需关注全局:选择Micro-F1,或结合Weighted-F1(按样本量加权)

③ 多维度评估:同时计算Macro和Micro指标,全面分析模型性能

实例说明

-

案例1(Macro-F1):

在癌症病理图像分类中,10个类别(如肺癌、乳腺癌)的样本量差异大,但每个类别的误诊代价相同。此时Macro-F1能平等反映模型对各类的识别能力 -

案例2(Micro-F1):

在电商评论情感分析中,90%的评论为“好评”,10%为“差评”。若业务更关注整体准确率,Micro-F1更适合;若需确保差评召回率,则需补充Macro-F1

| 维度 | Macro-F1 | Micro-F1 |

|---|---|---|

| 核心思想 | 类别平等,关注每个类的独立表现 | 样本平等,关注整体预测效果 |

| 适用数据 | 样本均衡或类别重要性均等 | 样本不均衡或需综合评估整体性能 |

| 敏感对象 | 对少数类敏感 | 对多数类敏感 |

| 典型场景 | 医学多疾病分类、多情感分析 | 搜索引擎排序、大规模推荐系统 |

六、基于规则的命名实体识别

① 常使用正则表达式来匹配特定句式、词表

② 原则上,规则能处理的好的情况下,尽量不用模型

③ 使用规则的方式同样可以计算准确率和召回率

④ 规则的顺序有时会影响结果,调试时需注意

⑤ 规则的编写,一般会使用正则表达式来编写

七、正则表达式⭐

正则表达式(regular expression):描述了一种字符串匹配的模式(pattern),可以用来检查一个串是否含有某种子串、将匹配的子串替换或者从某个串中取出符合某个条件的子串等。

pattern:ab 检查pattern是否在字符串中出现

string 1: babb re.search(pattern, string) True

string 2: bbba re.search(pattern, string) None

string 3: baaa re.search(pattern, string) None

string 4: abb re.search(pattern, string) True

检查pattern是否在字符串开头出现

string 1: babb re.match(pattern, string) None

string 2: bbba re.match(pattern, string) None

string 3: baaa re.match(pattern, string) None

string 4: abb re.match(pattern, string) True

1.元字符

匹配任意数字或字母

2.特殊符号

3.修饰符

4.贪婪模式

贪婪模式是正则表达式的一种匹配方式,在这种模式下,正则表达式会尽可能多地匹配字符。它会尝试匹配满足模式的最长字符串

示例:

贪婪模式:

import re

string = "aabab"

pattern = "a.*b"

result = re.search(pattern, string)

print(result.group()) # 输出:aabab非贪婪模式:

import re

string = "aabab"

pattern = "a.*?b"

result = re.search(pattern, string)

print(result.group()) # 输出:aab常见的贪婪量词及其非贪婪形式

-

*(贪婪):匹配零次或多次,尽可能多地匹配。- 非贪婪形式:

*?

- 非贪婪形式:

-

+(贪婪):匹配一次或多次,尽可能多地匹配。- 非贪婪形式:

+?

- 非贪婪形式:

-

?(贪婪):匹配零次或一次,尽可能多地匹配。- 非贪婪形式:

??

- 非贪婪形式:

-

{m,n}(贪婪):匹配m到n次,尽可能多地匹配。- 非贪婪形式:

{m,n}?

- 非贪婪形式:

5.常见pattern写法

6.主要函数

re.search(pattern, string):在 string 中搜索第一个匹配 pattern 的子串,如果找到则返回一个 Match 对象,否则返回 None

re.match(pattern, string):从 string 的开始位置尝试匹配 pattern,如果匹配成功返回一个 Match 对象,否则返回 None

re.findall(pattern, string):在 string 中查找所有匹配 pattern 的子串,以列表形式返回

re.sub(pattern, repl, string):在 string 中搜索匹配 pattern 的子串,并用 repl 替换它们,返回替换后的新字符串

re.split(pattern, string):按照 pattern 将 string 分割成多个子串,返回一个列表

re.fulmatch():用于检查整个字符串是否完全匹配给定的正则表达式。如果整个字符串与正则表达式匹配成功,则返回一个匹配对象(Match);否则返回 None。

7.代码示例

import re

import random

import time

"""

介绍正则表达式的常用操作

"""

# re.match(pattern, string) 验证字符串起始位置是否与pattern匹配

print(re.match('北医[一二三]院', '北医三院怎么走')) # 在起始位置匹配

print(re.match('www', 'www.runoob.com')) # 不在起始位置匹配

# # re.search(pattern, string) 验证字符串中是否与有片段与pattern匹配

print(re.search('www', 'www.runoob.com')) # 在起始位置匹配

print(re.search('run', 'www.runoob.com')) # 不在起始位置匹配

print("————————————————————————————————————————————")

#pattern中加括号,可以实现多个pattern的抽取

line = "Cats are smarter than dogs"

matchObj = re.match(r'(.*) are (.*?) .*', line)

if matchObj:

print("matchObj.group() : ", matchObj.group())

print("matchObj.group(1) : ", matchObj.group(1))

print("matchObj.group(2) : ", matchObj.group(2))

else:

print("No match!!")

##########################################

print("————————————————————————————————————————————")

# re.sub(pattern, repl, string, count=0) 利用正则替换文本

# 将string中匹配到pattern的部分,替换为repl

phone = "2004-959-559#这是一个国外电话号码"

# 删除字符串中的 # 后注释

num = re.sub('#.*$', "", phone)

print("电话号码是: ", num)

# 删除非数字(-)的字符串 \D 代表非数字 \d 代表数字 脱敏

num = re.sub('\d', "*", phone)

print("电话号码是 : ", num)

print("————————————————————————————————————————————")

# repl 参数可以是一个函数,要注意传入的参数不是值本身,是match对象

# 将匹配的数字乘以 2

def double(matched):

return str(int(matched.group()) * 2)

string = 'A23G4HFD567'

print(re.sub('\d', double, string))

# count参数决定替换几次,默认是全部替换

string = "00000"

print(re.sub("0", "1", string, count=2))

############################

print("————————————————————————————————————————————")

# re.findall(string[, pos[, endpos]])

# 在字符串中找到正则表达式所匹配的所有子串,并返回一个列表,如果没有找到匹配的,则返回空列表

pattern = re.compile('\d+') # 查找数字

result1 = pattern.findall('runoob 123 google 456')

result2 = pattern.findall('run88oob123google456', 0, 10)

print(result1)

print(result2)

print(re.findall("北京|上海|广东", "我从北京去上海"))

################################

print("————————————————————————————————————————————")

# re.split(pattern, string[, maxsplit=0]) 照能够匹配的子串将字符串分割后返回列表

string = "1、不评价别人; 2、不给别人建议; 3、没有共同利益,不必追求共识"

print(re.split("\d、", string))

print(re.split(";|、", string))

##############################

print("————————————————————————————————————————————")

# 匹配汉字 汉字unicode编码范围[\u4e00-\u9fa5]

print(re.findall("[\u4e00-\u9fa5]", "ad噶是的12范德萨发432文"))

print("————————————————————————————————————————————")

##############################

# 如果需要匹配,在正则表达式中有特殊含义的符号,需做转义

print(re.search("(图)", "贾玲成中国影史票房最高女导演(图)").group())

print(re.search("\(图\)", "贾玲成中国影史票房最高女导演(图)").group())

print(re.sub("(图)", "", "贾玲成中国影史票房最高女导演(图)"))

print(re.sub("\(图\)", "", "贾玲成中国影史票房最高女导演(图)"))

print("————————————————————————————————————————————")

###############################

pattern = "\d12\w"

re_pattern = re.compile(pattern)

print(re.search(pattern, "432312d"))

print("————————————————————————————————————————————")

# # 效率

import time

import random

chars = list("abcdefghijklmnopqrstuvwxyz")

#随机生成长度为n的字母组成的字符串

string = "".join([random.choice(chars) for i in range(100)])

pattern = "".join([random.choice(chars) for i in range(4)])

re_pattern = re.compile(pattern)

start_time = time.time()

for i in range(50000):

# pattern = "".join([random.choice(chars) for i in range(3)])

# re.search(pattern, string)

re.search(re_pattern, string)

print("正则查找耗时:", time.time() - start_time)

start_time = time.time()

for i in range(50000):

# pattern = "".join([random.choice(chars) for i in range(3)])

pattern in string

print("python in查找耗时:", time.time() - start_time)

8.正则表达式常用练习

Ⅰ、基础匹配练习

① 手机号验证

匹配大陆手机号

r‘ ’ 是原始字符串的表示方式,能够避免对反斜杠的转义。

正则表达式的具体构成:

^ 表示字符串的开始。

1 表示手机号码必须以数字 1 开头。

[3-9] 表示第二位只能是 3 到 9 之间的数字,这符合中国手机号的格式。

\d{9} 表示接下来的 9 位可以是任意数字(0-9),\d 是数字的通用表示,{9} 表示匹配 9 次。

$ 表示字符串的结束。

re.match(pattern, string):从 string 的开始位置尝试匹配 pattern,如果匹配成功返回一个 Match 对象,否则返回 None

import re

# 1.手机号验证

def isPhoneNum(phone):

pattern = r'^1[3-9]\d{9}$'

'''

r'' 是原始字符串的表示方式,能够避免对反斜杠的转义。

^ 表示字符串的开始。

1 表示手机号码必须以数字 1 开头。

[3-9] 表示第二位只能是 3 到 9 之间的数字,这符合中国手机号的格式。

\d{9} 表示接下来的 9 位可以是任意数字(0-9),\d 是数字的通用表示,{9} 表示匹配 9 次。

$ 表示字符串的结束。

'''

return bool(re.match(pattern, phone))

print(isPhoneNum("15500600904"))

print(isPhoneNum("1234567890123456"))

print(isPhoneNum("1234568"))

② 邮箱地址提取

匹配符合以下格式的电子邮件地址:

- 用户名部分:由字母、数字、点号

.或短横线-组成,至少一个字符。- 域名部分:由字母、数字、点号

.或短横线-组成,至少一个字符。- 顶级域名:由字母、数字或下划线组成,至少一个字符。

[\w\.-]+

\w:匹配字母、数字或下划线(等价于[a-zA-Z0-9_])。\.:匹配点号.(需要转义,因为.在正则中是特殊字符)。-:匹配短横线-。[]:字符集,表示匹配其中任意一个字符。+:表示前面的字符集至少出现一次。

这部分匹配电子邮件地址的用户名部分,例如user.name或user-name。

@

- 匹配电子邮件地址中的

@符号,分隔用户名和域名。

[\w\.-]+

- 与第一部分类似,匹配域名部分,例如

example或sub.domain。

\.\w+

\.:匹配点号.。\w+:匹配至少一个字母、数字或下划线,表示顶级域名,例如.com或.org。

re.findall(pattern, string):在 string 中查找所有匹配 pattern 的子串,以列表形式返回

# 2.邮箱地址提取

def getEmail(text):

pattern = r'[\w\.-]+@[\w\.-]+\.\w+'

'''

[\w\.-]+ 表示匹配一个或多个字符,这些字符可以是字母、数字、下划线(\w),也可以是点(.)或连字符(-)。这是匹配邮箱的用户名部分,即 @ 符号前面的部分。

@ 表示匹配字符 @,这是邮箱地址中固定的符号。

[\w\.-]+ 表示匹配一个或多个字符,这些字符可以是字母、数字、下划线(\w),也可以是点(.)或连字符(-)。这是匹配域名部分。

\.\w+ 表示匹配一个点(.)后跟一个或多个字母、数字或下划线(\w)。这是匹配顶级域名部分,如 .com、.cn 等。

'''

return bool(re.findall(pattern, text))

print(getEmail(" "))

print(getEmail("hello world"))

print(getEmail("www.baidu.@qq.com"))③ 中文姓名匹配

^ 表示字符串的开始。

[\u4e00-\u9fa5] 表示匹配一个中文字符,其中 \u4e00 表示中文字符的起始范围,\u9fa5 表示中文字符的结束范围。

{2,5} 表示匹配 2 到 5 个连续的中文字符。

$ 表示字符串的结束。

re.fulmatch():用于检查整个字符串是否完全匹配给定的正则表达式。如果整个字符串与正则表达式匹配成功,则返回一个匹配对象(Match);否则返回 None。

# 3.中文姓名匹配

def isChineseName(name):

pattern = r'^[\u4e00-\u9fa5]{2,4}$'

'''

^ 表示字符串的开始。

[\u4e00-\u9fa5] 表示匹配一个中文字符,其中 \u4e00 表示中文字符的起始范围,\u9fa5 表示中文字符的结束范围。

{2,5} 表示匹配 2 到 5 个连续的中文字符。

$ 表示字符串的结束。

'''

return bool(re.fullmatch(pattern, name))

print(isChineseName("张三"))

print(isChineseName("张三丰"))

print(isChineseName("张"))

Ⅱ、综合练习 —— 身份证号验证与信息提取

^ 表示字符串的开始,确保所有的匹配从字符串的开始位置开始。

(\d{6}) 是一个捕获组,用于匹配身份证号码的地址码部分,即开头的6位数字。

(\d{4}) 是一个捕获组,用于匹配身份证号码的出生年份部分,即接下来的4位数字。

(\d{2}) 是一个捕获组,用于匹配身份证号码的出生月份部分,再接下来的2位数字。

(\d{2}) 是一个捕获组,用于匹配身份证号码的出生日期部分,再接下来的2位数字。

\d{2} 用于匹配顺序码部分,即接下来的2位数字。

(\d) 是一个捕获组,用于匹配性别码部分,单数表示男性,双数表示女性。

(?:\d|X|x) 是一个非捕获组,用于匹配校验码部分,它既可以是数字0-9,也可以是大写的X或者小写的x。

$ 表示字符串的结束,确保所有的匹配到字符串的末尾位置结束。

# 身份证号验证和信息提取

def parse_id_card(id_card):

pattern = r'^(\d{6})(\d{4})(\d{2})(\d{2})\d{2}(\d)(?:\d|X|x)$'

'''

^ 表示字符串的开始,确保所有的匹配从字符串的开始位置开始。

(\d{6}) 是一个捕获组,用于匹配身份证号码的地址码部分,即开头的6位数字。

(\d{4}) 是一个捕获组,用于匹配身份证号码的出生年份部分,即接下来的4位数字。

(\d{2}) 是一个捕获组,用于匹配身份证号码的出生月份部分,再接下来的2位数字。

(\d{2}) 是一个捕获组,用于匹配身份证号码的出生日期部分,再接下来的2位数字。

\d{2} 用于匹配顺序码部分,即接下来的2位数字。

(\d) 是一个捕获组,用于匹配性别码部分,单数表示男性,双数表示女性。

(?:\d|X|x) 是一个非捕获组,用于匹配校验码部分,它既可以是数字0-9,也可以是大写的X或者小写的x。

$ 表示字符串的结束,确保所有的匹配到字符串的末尾位置结束。

'''

match = re.match(pattern, id_card)

if match:

birthday = f"{match.group(2)}-{match.group(3)}-{match.group(4)}"

sex = "男" if int(match.group(5)) % 2 == 1 else "女"

return {"address": match.group(1), "birthday": birthday, "sex": sex}

print(parse_id_card("11010119900101001X"))![]()

9.正则表达式实用技巧总结

Ⅰ、基础语法核心

① 元字符优先级

. 匹配任意非换行字符,\d 等价于 [0-9],\w 包含字母、数字和下划线

使用 [] 定义字符集,如 [a-z] 匹配小写字母,[^c] 表示排除字符c量

② 词控制次数

*(0次或多次),+(至少1次),?(0或1次),{n,m}(n到m次)

Ⅱ、高频场景公式

① 手机号:^1[3-9]\d{9}$(严格匹配11位中国大陆手机号)

② 邮箱:[\w.-]+@[\w.-]+\.\w+(支持带点/短横线的用户名和域名)

③ 密码强度:

基础:^[a-zA-Z]\w{5,17}$(字母开头,6-18位字母数字下划线)

增强:(?=.*\d)(?=.*[a-z])(?=.*[A-Z])(必须包含大小写字母和数字)

Ⅲ、避坑小技巧

① 转义字符:特殊字符如 " . " 、 " * "需要使用 \ 转义,但在[]内无需转义符号

② 性能优化:避免嵌套量词,如(a+)+,优先使用具体字符集替代宽泛的

八、文本加标点任务 🚀

经过语音识别,或机器翻译,可能会得到没有标点符号的文本。此时进行自动文本打标有助于增强文本可读性

是一种粗粒度的分词

对传入文本中的每个字多分类,划定每个字应该属于的类别(类别:不加标点、加各类标点符号)

1.配置文件 config.py

model_path:保存训练好的模型权重文件路径。

schema_path:标签定义文件路径,定义实体类型与整数ID的映射关系。

train_data_path:训练数据文件路径,通常为分词后的序列标注格式。

valid_data_path:验证数据文件路径,用于模型性能评估。

vocab_path:词汇表文件路径,将字符映射到整数索引。

max_length:输入序列的最大长度,超过部分截断,不足部分填充。

hidden_size:隐藏层维度,决定模型记忆能力。

epoch:训练轮数,即数据集遍历次数。

batch_size:每次梯度更新使用的样本数量。

optimizer:选择优化算法

learning_rate:优化器的学习率,控制参数更新幅度。

use_crf:是否使用条件随机场(CRF)进行序列标注解码。

class_num:标签类别总数

# -*- coding: utf-8 -*-

"""

配置参数信息

"""

Config = {

"model_path": "model_output",

"schema_path": "data/schema.json",

"train_data_path": "data/train_corpus.txt",

"valid_data_path": "data/valid_corpus.txt",

"vocab_path":"chars.txt",

"max_length": 50,

"hidden_size": 128,

"epoch": 10,

"batch_size": 128,

"optimizer": "adam",

"learning_rate": 1e-3,

"use_crf": False,

"class_num": None

}2.模型文件 model.py

Ⅰ、模型初始化

代码运行流程

__init__ 方法流程

├── 1. 调用父类初始化

│ └── 操作: `super(TorchModel, self).__init__()`

│ └── 作用: 调用父类的初始化方法,确保继承的属性和方法正确初始化

│

├── 2. 从配置中获取参数

│ ├── 2.1 获取隐藏层大小: `hidden_size = config["hidden_size"]`

│ ├── 2.2 获取词汇表大小: `vocab_size = config["vocab_size"] + 1`

│ └── 2.3 获取类别数量: `class_num = config["class_num"]`

│

├── 3. 初始化嵌入层

│ └── 操作: `self.embedding = nn.Embedding(vocab_size, hidden_size, padding_idx=0)`

│ ├── 作用: 将离散的词汇索引映射到连续的稠密向量空间

│ ├── 参数说明:

│ │ ├── `vocab_size`: 词汇表大小

│ │ ├── `hidden_size`: 嵌入向量的维度

│ │ └── `padding_idx=0`: 指定索引 0 用于填充,不更新其梯度

│ └── 输出: `self.embedding` 对象

│

├── 4. 初始化 LSTM 层

│ └── 操作: `self.layer = nn.LSTM(hidden_size, hidden_size, batch_first=True, bidirectional=True, num_layers=1)`

│ ├── 作用: 定义 LSTM 层,用于处理序列数据

│ ├── 参数说明:

│ │ ├── `hidden_size`: 隐藏层大小

│ │ ├── `batch_first=True`: 输入和输出的第一维度为批次大小

│ │ ├── `bidirectional=True`: 使用双向 LSTM

│ │ └── `num_layers=1`: LSTM 层数为 1

│ └── 输出: `self.layer` 对象

│

├── 5. 初始化分类层

│ └── 操作: `self.classify = nn.Linear(hidden_size * 2, class_num)`

│ ├── 作用: 将 LSTM 的输出映射到类别数量

│ ├── 参数说明:

│ │ ├── `hidden_size * 2`: 输入维度(双向 LSTM 的输出维度为隐藏层大小的两倍)

│ │ └── `class_num`: 输出维度(类别数量)

│ └── 输出: `self.classify` 对象

│

├── 6. 初始化 CRF 层

│ └── 操作: `self.crf_layer = CRF(class_num, batch_first=True)`

│ ├── 作用: 定义 CRF 层,用于序列标注任务

│ ├── 参数说明:

│ │ ├── `class_num`: 类别数量

│ │ └── `batch_first=True`: 输入和输出的第一维度为批次大小

│ └── 输出: `self.crf_layer` 对象

│

├── 7. 设置是否使用 CRF

│ └── 操作: `self.use_crf = config["use_crf"]`

│ └── 作用: 从配置中获取是否使用 CRF 的标志

│

└── 8. 初始化损失函数

└── 操作: `self.loss = torch.nn.CrossEntropyLoss(ignore_index=-1)`

├── 作用: 定义交叉熵损失函数,忽略索引为 -1 的标签

└── 输出: `self.loss` 对象hidden_size:RNN/LSTM/GRU隐藏层维度,决定模型记忆能力。

vocab_size:词汇表大小

class_num:标签类别总数

use_crf:是否使用条件随机场(CRF)进行序列标注解码。

nn.Embedding():将离散的词索引映射为稠密的向量表示(词嵌入),常用于 NLP 任务的输入层。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

num_embeddings | int | None | 词汇表大小(输入维度,如 vocab_size)。 |

embedding_dim | int | None | 嵌入向量的维度(输出维度,如 char_dim=50)。 |

max_length | int | None | 序列的最大长度(用于动态 padding)。 |

padding_idx | int | None | 填充标记的索引(如 [PAD]=0,默认 None 不启用)。 |

sparse | bool | False | 是否使用稀疏矩阵存储(仅当 num_embeddings 很大时有用)。 |

_weight | Tensor | None | 预训练的嵌入权重(可选)。 |

nn.LSTM():实现长短期记忆网络(LSTM),处理序列数据并捕捉长期依赖。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

input_size | int | None | 单个时间步的输入特征维度(如词嵌入维度 char_dim=50)。 |

hidden_size | int | None | LSTM 单元的隐藏层维度。 |

num_layers | int | 1 | LSTM 层的数量。 |

batch_first | bool | False | 是否将 (batch_size, seq_len, features) 作为输入格式(默认为 (seq_len, batch_size, features))。 |

dropout | float | 0.0 | 在 LSTM 层后添加 dropout(防止过拟合)。 |

bidirectional | bool | False | 是否启用双向 LSTM(输出为两倍隐藏层维度)。 |

cell_class | Type[nn.RNNCell] | None | 自定义 RNN 单元类(默认为 nn.LSTMCell)。 |

initializer | Callable | None | 权重初始化方法。 |

nn.Linear():全连接层,将输入线性映射到输出。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

in_features | int | None | 输入特征数。 |

out_features | int | None | 输出特征数。 |

bias | bool | True | 是否启用偏置项。 |

device | str/int | None | 指定权重存储设备(如 "cuda")。 |

CRF():条件随机场(Conditional Random Field),用于序列标注任务,通过维特比算法解码最优标签序列。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

input_size | int | None | 单个时间步的输入特征维度(如 LSTM 输出维度)。 |

hidden_size | int | None | CRF 隐藏层维度。 |

num_tags | int | None | 标签类别总数。 |

transition_matrix | Tensor | None | 标签转移矩阵(num_tags x num_tags,默认随机初始化)。 |

mask | bool | False | 是否启用输入掩码(处理变长序列)。 |

torch.nn.CrossEntropyLoss():计算交叉熵损失,常用于分类任务。输入为 logits(未归一化的概率),无需手动 softmax。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

input_size | int | None | 输入特征数(即 logits 的维度)。 |

num_classes | int | None | 类别总数。 |

ignore_index | int | -100 | 忽略的标签索引(如 [PAD]=0)。 |

weight | Tensor | None | 类别权重(用于不平衡数据)。 |

reduction | str | "mean" | 损失计算的缩减方式(如 "sum" 或 "mean")。 |

label_smoothing | float | 0.0 | 标签平滑系数(防止过拟合)。 |

def __init__(self, config):

super(TorchModel, self).__init__()

hidden_size = config["hidden_size"]

vocab_size = config["vocab_size"] + 1

class_num = config["class_num"]

self.embedding = nn.Embedding(vocab_size, hidden_size, padding_idx=0)

self.layer = nn.LSTM(hidden_size, hidden_size, batch_first=True, bidirectional=True, num_layers=1)

self.classify = nn.Linear(hidden_size * 2, class_num)

self.crf_layer = CRF(class_num, batch_first=True)

self.use_crf = config["use_crf"]

self.loss = torch.nn.CrossEntropyLoss(ignore_index=-1) #loss采用交叉熵损失Ⅱ、前向传播

代码运行流程

forward 方法流程

├── 1. 输入参数

│ ├── 1.1 `x`: 输入数据,形状为 `(batch_size, sen_len)`

│ └── 1.2 `target`: 真实标签(可选),形状为 `(batch_size, sen_len)`

│

├── 2. 嵌入层处理

│ └── 操作: `x = self.embedding(x)`

│ ├── 作用: 将输入的离散索引映射为稠密向量

│ └── 输出: `x` 张量,形状为 `(batch_size, sen_len, hidden_size)`

│

├── 3. LSTM 层处理

│ └── 操作: `x, _ = self.layer(x)`

│ ├── 作用: 使用 LSTM 层处理序列数据,捕捉上下文信息

│ └── 输出: `x` 张量,形状为 `(batch_size, sen_len, hidden_size * 2)`(双向 LSTM)

│

├── 4. 分类层处理

│ └── 操作: `predict = self.classify(x)`

│ ├── 作用: 将 LSTM 的输出映射到类别数量

│ └── 输出: `predict` 张量,形状为 `(batch_size, sen_len, class_num)`

│

├── 5. 判断是否有真实标签

│ ├── 5.1 如果有真实标签 (`target is not None`):

│ │ ├── 5.1.1 判断是否使用 CRF:

│ │ │ ├── 5.1.1.1 如果使用 CRF (`self.use_crf`):

│ │ │ │ ├── 操作: `mask = target.gt(-1)`

│ │ │ │ │ └── 作用: 生成掩码,标记有效标签(非 -1)

│ │ │ │ └── 操作: `return self.crf_layer(predict, target, mask, reduction="mean")`

│ │ │ │ └── 作用: 使用 CRF 层计算损失

│ │ │ └── 5.1.1.2 如果不使用 CRF:

│ │ │ └── 操作: `return self.loss(predict.view(-1, predict.shape[-1]), target.view(-1))`

│ │ │ └── 作用: 使用交叉熵损失计算损失

│ │ └── 5.1.2 返回损失值

│ └── 5.2 如果没有真实标签:

│ ├── 5.2.1 判断是否使用 CRF:

│ │ ├── 5.2.1.1 如果使用 CRF (`self.use_crf`):

│ │ │ └── 操作: `return self.crf_layer.viterbi_decode(predict)`

│ │ │ └── 作用: 使用 CRF 层进行 Viterbi 解码,返回预测标签序列

│ │ └── 5.2.1.2 如果不使用 CRF:

│ │ └── 操作: `return predict`

│ │ └── 作用: 直接返回分类层的预测结果

│ └── 5.2.2 返回预测值

│

└── 6. 返回结果

├── 如果有真实标签: 返回损失值

└── 如果没有真实标签: 返回预测值x:输入数据,形状为 (batch_size, sen_len),其中 batch_size 是批次大小,sen_len 是序列长度

target:真实标签,形状与 x 相同。如果为 None,表示没有提供真实标签,仅返回预测值。

predict:模型的预测输出,形状为 (batch_size, sen_len, num_classes),其中 num_classes 是类别数。

mask: 掩码张量,用于标识有效标签的位置。target.gt(-1) 表示 target 中大于 -1 的位置为有效标签

use_crf:标记是否使用crf条件随机场

.shape:用于描述张量的维度结构,即张量在每个维度上的大小。它是一个由整数组成的元组(tuple),每个整数表示对应维度的大小。

view():改变张量的形状(类似 reshape),返回新视图(不复制数据)。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

| new_shape | tuple | None | 新的形状(如 (batch_size, sen_len))。支持 -1 自动推断维度。 |

| dtype | torch.dtype | None | 数据类型(如 torch.float32)。默认与原张量一致。 |

gt():逐元素比较,返回布尔张量(True 表示左操作数大于右操作数)。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

| other | Tensor | None | 右操作数(张量或标量)。例如 x.gt(0)。 |

#当输入真实标签,返回loss值;无真实标签,返回预测值

def forward(self, x, target=None):

x = self.embedding(x) #input shape:(batch_size, sen_len)

x, _ = self.layer(x) #input shape:(batch_size, sen_len, input_dim)

predict = self.classify(x)

if target is not None:

if self.use_crf:

mask = target.gt(-1)

return self.crf_layer(predict, target, mask, reduction="mean")

else:

return self.loss(predict.view(-1, predict.shape[-1]), target.view(-1))

else:

if self.use_crf:

return self.crf_layer.viterbi_decode(predict)

else:

return predictⅢ、选择优化器

代码运行流程

choose_optimizer 函数流程

├── 1. 输入参数

│ ├── 1.1 `config`: 配置字典,包含优化器类型和学习率

│ └── 1.2 `model`: 模型对象,包含需要优化的参数

│

├── 2. 从配置中获取优化器类型

│ └── 操作: `optimizer = config["optimizer"]`

│ └── 作用: 获取配置中指定的优化器类型(如 "adam" 或 "sgd")

│

├── 3. 从配置中获取学习率

│ └── 操作: `learning_rate = config["learning_rate"]`

│ └── 作用: 获取配置中指定的学习率

│

├── 4. 判断优化器类型

│ ├── 4.1 如果优化器是 "adam":

│ │ └── 操作: `return Adam(model.parameters(), lr=learning_rate)`

│ │ ├── 作用: 使用 Adam 优化器初始化并返回

│ │ └── 输出: Adam 优化器对象

│ └── 4.2 如果优化器是 "sgd":

│ └── 操作: `return SGD(model.parameters(), lr=learning_rate)`

│ ├── 作用: 使用 SGD 优化器初始化并返回

│ └── 输出: SGD 优化器对象

│

└── 5. 返回优化器对象

└── 作用: 返回根据配置选择的优化器对象config:配置字典,包含优化器的名称和学习率等超参数

model:待训练的模型,其参数将由优化器更新

optimizer:优化器的名称,例如 "adam" 或 "sgd",用于选择具体的优化算法

learning_rate:学习率,控制每次参数更新的步长大小

lr: 优化器的学习率参数,控制参数更新的步长

Adam():自适应矩估计优化器(Adaptive Moment Estimation),结合动量和 RMSProp 的优点。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

| lr | float | 1e-3 | 学习率。 |

| betas | tuple | (0.9, 0.999) | 动量系数(β₁, β₂)。 |

| eps | float | 1e-8 | 防止除零误差。 |

| weight_decay | float | 0 | 权重衰减率。 |

| amsgrad | bool | False | 是否启用 AMSGrad 优化。 |

| foreach | bool | False | 是否为每个参数单独计算梯度。 |

SGD():随机梯度下降优化器(Stochastic Gradient Descent)

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

| lr | float | 1e-3 | 学习率。 |

| momentum | float | 0 | 动量系数(如 momentum=0.9)。 |

| weight_decay | float | 0 | 权重衰减率。 |

| dampening | float | 0 | 动力衰减系数(用于 SGD with Momentum)。 |

| nesterov | bool | False | 是否启用 Nesterov 动量。 |

| foreach | bool | False | 是否为每个参数单独计算梯度。 |

parameters():返回模型所有可训练参数的迭代器,常用于参数初始化或梯度清零。

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

| filter | callable | None | 过滤条件函数(如 lambda p: p.requires_grad)。默认返回所有参数。 |

def choose_optimizer(config, model):

optimizer = config["optimizer"]

learning_rate = config["learning_rate"]

if optimizer == "adam":

return Adam(model.parameters(), lr=learning_rate)

elif optimizer == "sgd":

return SGD(model.parameters(), lr=learning_rate)Ⅳ、建立网络模型结构 & 完整代码

# -*- coding: utf-8 -*-

import torch

import torch.nn as nn

from torch.optim import Adam, SGD

from torchcrf import CRF

"""

建立网络模型结构

"""

class TorchModel(nn.Module):

def __init__(self, config):

super(TorchModel, self).__init__()

hidden_size = config["hidden_size"]

vocab_size = config["vocab_size"] + 1

class_num = config["class_num"]

self.embedding = nn.Embedding(vocab_size, hidden_size, padding_idx=0)

self.layer = nn.LSTM(hidden_size, hidden_size, batch_first=True, bidirectional=True, num_layers=1)

self.classify = nn.Linear(hidden_size * 2, class_num)

self.crf_layer = CRF(class_num, batch_first=True)

self.use_crf = config["use_crf"]

self.loss = torch.nn.CrossEntropyLoss(ignore_index=-1) #loss采用交叉熵损失

#当输入真实标签,返回loss值;无真实标签,返回预测值

def forward(self, x, target=None):

x = self.embedding(x) #input shape:(batch_size, sen_len)

x, _ = self.layer(x) #input shape:(batch_size, sen_len, input_dim)

predict = self.classify(x)

if target is not None:

if self.use_crf:

mask = target.gt(-1)

return self.crf_layer(predict, target, mask, reduction="mean")

else:

return self.loss(predict.view(-1, predict.shape[-1]), target.view(-1))

else:

if self.use_crf:

return self.crf_layer.viterbi_decode(predict)

else:

return predict

def choose_optimizer(config, model):

optimizer = config["optimizer"]

learning_rate = config["learning_rate"]

if optimizer == "adam":

return Adam(model.parameters(), lr=learning_rate)

elif optimizer == "sgd":

return SGD(model.parameters(), lr=learning_rate)

if __name__ == "__main__":

from config import Config

model = TorchModel(Config)3.数据加载 loader.py

代码运行流程

DataGenerator.__init__(self, data_path, config)

├── 初始化 self.config = config

├── 初始化 self.path = data_path

├── 加载词汇表:self.vocab = load_vocab(config["vocab_path"])

├── 更新配置:self.config["vocab_size"] = len(self.vocab)

├── 初始化 self.sentences = []

├── 加载 schema:self.schema = self.load_schema(config["schema_path"])

├── 更新配置:self.config["class_num"] = len(self.schema)

├── 初始化 self.max_length = config["max_length"]

└── 调用 self.load() 方法

DataGenerator.load(self)

├── 初始化 self.data = []

├── 打开文件:with open(self.path, encoding="utf8") as f

│ ├── 逐行读取文件:for line in f

│ │ ├── 判断行长度是否超过最大长度:if len(line) > self.max_length

│ │ │ ├── 分段处理行:for i in range(len(line) // self.max_length)

│ │ │ │ ├── 处理句子:input_id, label = self.process_sentence(line[i * self.max_length:(i+1) * self.max_length])

│ │ │ │ └── 将结果存入 self.data:self.data.append([torch.LongTensor(input_id), torch.LongTensor(label)])

│ │ │ └── 处理剩余部分:input_id, label = self.process_sentence(line)

│ │ │ └── 将结果存入 self.data:self.data.append([torch.LongTensor(input_id), torch.LongTensor(label)])

│ │ └── 处理整行:input_id, label = self.process_sentence(line)

│ │ └── 将结果存入 self.data:self.data.append([torch.LongTensor(input_id), torch.LongTensor(label)])

└── 返回

DataGenerator.process_sentence(self, line)

├── 初始化 sentence_without_sign = []

├── 初始化 label = []

├── 遍历句子中的每个字符:for index, char in enumerate(line[:-1])

│ ├── 跳过标点字符:if char in self.schema

│ │ └── continue

│ ├── 将字符加入 sentence_without_sign:sentence_without_sign.append(char)

│ ├── 获取下一个字符:next_char = line[index + 1]

│ ├── 判断下一个字符是否为标点:if next_char in self.schema

│ │ └── 将标点对应的标签加入 label:label.append(self.schema[next_char])

│ └── 否则加入默认标签:label.append(0)

├── 断言 sentence_without_sign 和 label 长度一致:assert len(sentence_without_sign) == len(label)

├── 编码句子:encode_sentence = self.encode_sentence(sentence_without_sign)

├── 补齐标签:label = self.padding(label, -1)

├── 断言 encode_sentence 和 label 长度一致:assert len(encode_sentence) == len(label)

├── 将句子加入 self.sentences:self.sentences.append("".join(sentence_without_sign))

└── 返回 encode_sentence, label

DataGenerator.encode_sentence(self, text, padding=True)

├── 初始化 input_id = []

├── 判断词汇表类型:if self.config["vocab_path"] == "words.txt"

│ └── 使用 jieba 分词并编码:for word in jieba.cut(text)

│ └── input_id.append(self.vocab.get(word, self.vocab["[UNK]"]))

├── 否则按字符编码:for char in text

│ └── input_id.append(self.vocab.get(char, self.vocab["[UNK]"]))

├── 判断是否需要补齐:if padding

│ └── 补齐 input_id:input_id = self.padding(input_id)

└── 返回 input_id

DataGenerator.padding(self, input_id, pad_token=0)

├── 截断 input_id:input_id = input_id[:self.config["max_length"]]

├── 补齐 input_id:input_id += [pad_token] * (self.config["max_length"] - len(input_id))

└── 返回 input_id

DataGenerator.__len__(self)

└── 返回 self.data 的长度:return len(self.data)

DataGenerator.__getitem__(self, index)

└── 返回 self.data 中的指定项:return self.data[index]

DataGenerator.load_schema(self, path)

├── 打开文件:with open(path, encoding="utf8") as f

└── 返回 JSON 数据:return json.load(f)

load_vocab(vocab_path)

├── 初始化 token_dict = {}

├── 打开文件:with open(vocab_path, encoding="utf8") as f

│ ├── 逐行读取文件:for index, line in enumerate(f)

│ │ ├── 去除空白字符:token = line.strip()

│ │ └── 将 token 和索引存入 token_dict:token_dict[token] = index + 1

└── 返回 token_dict

load_data(data_path, config, shuffle=True)

├── 初始化 DataGenerator:dg = DataGenerator(data_path, config)

├── 初始化 DataLoader:dl = DataLoader(dg, batch_size=config["batch_size"], shuffle=shuffle)

└── 返回 DataLoader:return dl

if __name__ == "__main__":

├── 导入 Config:from config import Config

└── 初始化 DataGenerator:dg = DataGenerator("/NLP/Day9_序列标注问题/demo1_ner/ner_data/train", Config)

Ⅰ、类初始化与配置加载

代码运行流程

__init__ 方法流程

├── 1. 输入参数

│ ├── 1.1 `data_path`: 原始数据文件路径

│ └── 1.2 `config`: 全局配置参数(如模型超参、路径信息等)

│

├── 2. 初始化实例变量

│ ├── 2.1 `self.config = config`

│ │ └── 作用: 将传入的配置字典赋值给实例变量 `self.config`

│ ├── 2.2 `self.path = data_path`

│ │ └── 作用: 将传入的数据路径赋值给实例变量 `self.path`

│ ├── 2.3 `self.vocab = load_vocab(config["vocab_path"])`

│ │ └── 作用: 加载词汇表,并将结果赋值给实例变量 `self.vocab`

│ ├── 2.4 `self.config["vocab_size"] = len(self.vocab)`

│ │ └── 作用: 计算词汇表大小,并更新 `self.config` 中的 `vocab_size`

│ ├── 2.5 `self.sentences = []`

│ │ └── 作用: 初始化一个空列表,用于存储处理后的句子

│ ├── 2.6 `self.schema = self.load_schema(config["schema_path"])`

│ │ └── 作用: 加载模式(schema),并将结果赋值给实例变量 `self.schema`

│ ├── 2.7 `self.config["class_num"] = len(self.schema)`

│ │ └── 作用: 计算模式中的类别数量,并更新 `self.config` 中的 `class_num`

│ └── 2.8 `self.max_length = config["max_length"]`

│ └── 作用: 将配置中的最大长度赋值给实例变量 `self.max_length`

│

├── 3. 调用 `load` 方法

│ └── 操作: `self.load()`

│ └── 作用: 调用 `load` 方法加载数据

│

└── 4. 初始化完成

└── 作用: 类实例化完成,实例变量已初始化并准备好使用config:存储全局配置参数(如模型超参、路径信息等)

data_path:记录原始数据文件路径,用于后续数据读取

vocab_size:词汇表大小,决定模型嵌入层的输入维度

# -*- coding: utf-8 -*-

import json

import re

import os

import torch

import random

import jieba

import numpy as np

from torch.utils.data import Dataset, DataLoader

"""

数据加载

"""

class DataGenerator:

def __init__(self, data_path, config):

self.config = config

self.path = data_path

self.vocab = load_vocab(config["vocab_path"])

self.config["vocab_size"] = len(self.vocab)

self.sentences = []

self.schema = self.load_schema(config["schema_path"])

self.config["class_num"] = len(self.schema)

self.max_length = config["max_length"]

self.load()Ⅱ、加载字表 / 词表

代码运行流程

load_vocab 函数流程

├── 1. 初始化空字典

│ └── 操作: `token_dict = {}`

│ └── 作用: 创建一个空字典,用于存储词汇及其对应的索引

│

├── 2. 打开词汇表文件

│ └── 操作: `with open(vocab_path, encoding="utf8") as f:`

│ └── 作用: 以 UTF-8 编码打开词汇表文件,确保文件读取后自动关闭

│

├── 3. 逐行读取文件

│ └── 操作: `for index, line in enumerate(f):`

│ └── 作用: 遍历文件的每一行,`index` 为行号(从 0 开始),`line` 为当前行的内容

│

├── 4. 处理每一行

│ ├── 4.1 去除行首尾空白字符

│ │ └── 操作: `token = line.strip()`

│ │ └── 作用: 去除行首尾的空白字符(如换行符、空格等),得到词汇

│ │

│ └── 4.2 将词汇及其索引存入字典

│ └── 操作: `token_dict[token] = index + 1`

│ ├── 作用: 将词汇及其对应的索引存入字典,索引从 1 开始(0 留给 padding 位置)

│ └── 输出: 更新后的 `token_dict` 字典

│

└── 5. 返回词汇字典

└── 操作: `return token_dict`

└── 作用: 返回包含词汇及其索引的字典vocab_path:词汇表文件的路径

token_dict:存储词汇项到索引的映射关系的字典

f:文件对象,打开的词汇表文件句柄(通过with语句自动管理资源)

index:索引,行号计数器

line:当前读取的文件行内容

token:去除首尾空白后的词汇项文本

open():Python 内置函数,用于打开文件并返回文件对象,支持文本模式和二进制模式操作

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

filename | str | 文件路径(含绝对/相对路径) | - |

mode | str | 文件打开模式(如 'r'、'w'、'a'、'b' 等) | 'r' |

encoding | str | 文件编码格式(文本模式必需,二进制模式忽略) | None |

errors | str | 编码错误处理方式(如 'ignore'、'replace') | None |

newline | str | 控制换行符转换行为(如 None、'\n') | None |

closefd | bool | 是否在关闭文件对象时关闭文件描述符 | True |

enumerate():将可迭代对象与索引组合,返回包含索引和元素的枚举对象,常用于循环中同时获取元素及其位置

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

iterable | 可迭代对象 | 要遍历的列表、元组、字符串等 | - |

start | int | 索引起始值(默认从 0 开始) | 0 |

strip():字符串方法,用于去除字符串首尾指定字符(默认为空白字符如空格、换行符)

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

chars | str | 需要去除的字符集合(如 '#'),若省略则默认去除空白字符 | None |

#加载字表或词表

def load_vocab(vocab_path):

token_dict = {}

with open(vocab_path, encoding="utf8") as f:

for index, line in enumerate(f):

token = line.strip()

token_dict[token] = index + 1 #0留给padding位置,所以从1开始

return token_dictⅢ、输入文本预处理

① 补齐或截断

代码运行流程

padding 方法流程

├── 1. 输入参数

│ ├── 1.1 `input_id`: 输入的序列,通常是一个列表或张量

│ └── 1.2 `pad_token`: 用于填充的标记,默认为 0

│

├── 2. 截断序列

│ └── 操作: `input_id = input_id[:self.config["max_length"]]`

│ ├── 作用: 将输入序列截断为配置中指定的最大长度 `max_length`

│ └── 输出: 截断后的序列

│

├── 3. 计算填充长度

│ └── 操作: `self.config["max_length"] - len(input_id)`

│ ├── 作用: 计算需要填充的长度

│ └── 输出: 填充长度(整数)

│

├── 4. 填充序列

│ └── 操作: `input_id += [pad_token] * (self.config["max_length"] - len(input_id))`

│ ├── 作用: 在序列末尾添加 `pad_token`,直到序列长度达到 `max_length`

│ └── 输出: 填充后的序列

│

└── 5. 返回结果

└── 操作: `return input_id`

└── 作用: 返回补齐或截断后的序列input_id:输入的原始token ID

pad_token:填充时使用的token ID(默认0,通常对应词汇表中的<PAD>标记)

self.config:字典,模型配置参数

self.config["max_length"]:序列允许的最大长度,用于控制一个batch内的序列统一性

len(): Python 内置函数,用于返回对象(如字符串、列表、元组、字典等)的长度或元素个数,是处理序列类型的核心工具

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

object | object | 需要计算长度的对象,支持字符串、列表、元组、字典、集合等序列或集合类型 | - |

#补齐或截断输入的序列,使其可以在一个batch内运算

def padding(self, input_id, pad_token=0):

input_id = input_id[:self.config["max_length"]]

input_id += [pad_token] * (self.config["max_length"] - len(input_id))

return input_id② 文本转编码

代码运行流程

encode_sentence 方法流程

├── 1. 输入参数

│ ├── 1.1 `text`: 输入的文本字符串

│ └── 1.2 `padding`: 是否对输入序列进行填充,默认为 True

│

├── 2. 初始化空列表

│ └── 操作: `input_id = []`

│ └── 作用: 创建一个空列表,用于存储编码后的序列

│

├── 3. 判断词汇表类型

│ ├── 3.1 如果词汇表路径为 "words.txt":

│ │ ├── 操作: `for word in jieba.cut(text):`

│ │ │ └── 作用: 使用 jieba 分词对文本进行分词

│ │ ├── 操作: `input_id.append(self.vocab.get(word, self.vocab["[UNK]"]))`

│ │ │ └── 作用: 将每个分词映射为词汇表中的索引,若未找到则使用 "[UNK]" 的索引

│ │ └── 输出: 分词后的编码序列

│ └── 3.2 否则:

│ ├── 操作: `for char in text:`

│ │ └── 作用: 对文本逐字符处理

│ ├── 操作: `input_id.append(self.vocab.get(char, self.vocab["[UNK]"]))`

│ │ └── 作用: 将每个字符映射为词汇表中的索引,若未找到则使用 "[UNK]" 的索引

│ └── 输出: 字符级的编码序列

│

├── 4. 判断是否填充

│ └── 操作: `if padding:`

│ ├── 作用: 如果 `padding` 为 True,则对编码序列进行填充

│ ├── 操作: `input_id = self.padding(input_id)`

│ │ └── 作用: 调用 `padding` 方法对序列进行补齐或截断

│ └── 输出: 填充后的编码序列

│

└── 5. 返回结果

└── 操作: `return input_id`

└── 作用: 返回编码后的序列(可能经过填充)text:输入的文本,需要被编码为模型可处理的格式

padding: 是否对输入进行填充(padding),默认为 True。填充通常用于使输入长度一致。

input_id:存储编码后的token ID序列

self.config:字典,模型配置参数

jieba.cut():结巴分词库的核心分词函数,支持三种分词模式(精确模式/全模式/搜索引擎模式),用于将中文文本切分成词语序列

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

sentence | str | 需要分词的中文字符串 | - |

cut_all | bool | 是否采用全模式分词(True为全模式,False为精确模式,默认False) | False |

HMM | bool | 是否启用隐马尔可夫模型处理未登录词(True启用,默认True) | True |

列表.append():用于在列表末尾添加一个元素,属于原地修改操作,无返回值

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

obj | object | 需要添加到列表末尾的元素(支持任意类型,包括列表/元组/字符串等) | - |

字典.get():安全获取字典中指定键的值,键不存在时返回默认值(默认为None),避免KeyError异常

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

key | hashable | 需要查询的键 | - |

default | optional | 键不存在时返回的默认值(可选参数,不提供则返回None) | None |

def encode_sentence(self, text, padding=True):

input_id = []

if self.config["vocab_path"] == "words.txt":

for word in jieba.cut(text):

input_id.append(self.vocab.get(word, self.vocab["[UNK]"]))

else:

for char in text:

input_id.append(self.vocab.get(char, self.vocab["[UNK]"]))

if padding:

input_id = self.padding(input_id)

return input_idⅣ、类内魔术方法

① len()方法重写

实现对象长度获取功能,当调用内置函数 len(obj) 时自动触发

def __len__(self):

return len(self.data)② getitem()方法重写

支持通过索引访问对象元素,使对象可被切片或逐项遍历

def __getitem__(self, index):

return self.data[index]③ load_schema()方法

从指定路径加载 JSON 文件并返回解析后的数据

open(): Python 内置函数,用于打开文件并返回文件对象,支持文本模式('r'、'w'、'a' 等)和二进制模式('rb'、'wb' 等)

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

file | str | 文件路径(支持相对/绝对路径) | - |

mode | str | 打开模式(如 'r' 只读、'w' 覆盖写入、'a' 追加) | 'r' |

encoding | str | 文件编码(如 'utf-8'),文本模式时必填 | None |

buffering | int | 缓冲策略(0 无缓冲、1 行缓冲、>1 缓冲区大小) | None |

json.load():用于将 JSON 格式的文件内容解析为 Python 对象(如字典、列表)

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

fp | 文件对象 | 支持 read() 方法的文件对象(如通过 open() 返回的文件对象) | - |

cls | type | 自定义解码类(可选) | None |

object_hook | function | 自定义转换函数(可选) |

def load_schema(self, path):

with open(path, encoding="utf8") as f:

return json.load(f)Ⅴ、预处理与标签生成

代码运行流程

process_sentence 方法流程

├── 1. 输入参数

│ └── 1.1 `line`: 输入的文本行

│

├── 2. 初始化空列表

│ ├── 2.1 `sentence_without_sign = []`

│ │ └── 作用: 用于存储去除标点后的字符序列

│ └── 2.2 `label = []`

│ └── 作用: 用于存储每个字符对应的标签

│

├── 3. 遍历字符序列

│ └── 操作: `for index, char in enumerate(line[:-1]):`

│ ├── 3.1 检查当前字符是否为标点

│ │ └── 操作: `if char in self.schema:`

│ │ └── 作用: 如果当前字符是标点,则跳过处理

│ ├── 3.2 将非标点字符加入 `sentence_without_sign`

│ │ └── 操作: `sentence_without_sign.append(char)`

│ ├── 3.3 检查下一个字符是否为标点

│ │ ├── 操作: `next_char = line[index + 1]`

│ │ └── 操作: `if next_char in self.schema:`

│ │ ├── 作用: 如果下一个字符是标点,则将其对应的标签加入 `label`

│ │ └── 操作: `label.append(self.schema[next_char])`

│ │ └── 否则:

│ │ └── 操作: `label.append(0)`

│ │ └── 作用: 如果下一个字符不是标点,则标签为 0

│ └── 输出: 更新后的 `sentence_without_sign` 和 `label`

│

├── 4. 检查长度一致性

│ └── 操作: `assert len(sentence_without_sign) == len(label)`

│ └── 作用: 确保 `sentence_without_sign` 和 `label` 长度一致

│

├── 5. 编码字符序列

│ └── 操作: `encode_sentence = self.encode_sentence(sentence_without_sign)`

│ └── 作用: 调用 `encode_sentence` 方法将字符序列编码为数值序列

│

├── 6. 填充标签序列

│ └── 操作: `label = self.padding(label, -1)`

│ └── 作用: 调用 `padding` 方法对标签序列进行填充,填充值为 -1

│

├── 7. 检查长度一致性

│ └── 操作: `assert len(encode_sentence) == len(label)`

│ └── 作用: 确保编码后的序列和标签序列长度一致

│

├── 8. 存储处理后的句子

│ └── 操作: `self.sentences.append("".join(sentence_without_sign))`

│ └── 作用: 将去除标点后的句子加入 `self.sentences` 列表

│

└── 9. 返回结果

└── 操作: `return encode_sentence, label`

└── 作用: 返回编码后的序列和标签序列sentence_without_sign:字符串列表,存储过滤后不含标点的纯文本字符序列

self.schema:字典,存储文本到索引的映射关系

self.sentences:字符串列表,存储所有处理后的句子

encode_sentence:文本编码后的数值序列

lable:整数列表,存储每个字符对应的标签(预测下一个字符是否是标点)

line:输入的原始文本字符串

index:当前字符在文本中的位置索引

char:当前处理的字符

enumerate():将可迭代对象(如列表、字符串)转换为索引-值元组序列,常用于for循环中同时获取元素及其位置

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

iterable | 可迭代对象 | 需要枚举的列表、字符串等对象 | - |

start | int | 索引起始值,默认为0 | 0 |

列表.append():在列表末尾添加一个元素,属于原地修改操作,无返回值

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

obj | object | 需要添加到列表末尾的元素(支持任意类型,包括列表/元组/字符串等) | - |

assert:在调试阶段检查条件是否为真,若为假则抛出AssertionError异常并终止程序

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

expression | bool | 需判断的表达式,若为False则触发异常 | - |

message | str | 可选参数,自定义错误提示信息 | None |

join():将可迭代对象(如列表、元组)中的元素按指定分隔符合并为字符

| 参数名称 | 类型 | 作用描述 | 默认值 |

|---|---|---|---|

iterable | 可迭代对象 | 需连接的元素序列(元素需为字符串类型) | - |

sep | str | 分隔符字符串,默认为空字符串"" | "" |

def process_sentence(self, line):

sentence_without_sign = []

label = []

for index, char in enumerate(line[:-1]):

if char in self.schema: #准备加的标点,在训练数据中不应该存在

continue

sentence_without_sign.append(char)

next_char = line[index + 1]

if next_char in self.schema: #下一个字符是标点,计入对应label

label.append(self.schema[next_char])

else:

label.append(0)

assert len(sentence_without_sign) == len(label)

encode_sentence = self.encode_sentence(sentence_without_sign)

label = self.padding(label, -1)

assert len(encode_sentence) == len(label)

self.sentences.append("".join(sentence_without_sign))

return encode_sentence, labelⅥ、数据加载和封装

① 数据加载

代码运行流程

load 方法流程

├── 1. 初始化空列表

│ └── 操作: `self.data = []`

│ └── 作用: 创建一个空列表,用于存储处理后的数据

│

├── 2. 打开文件

│ └── 操作: `with open(self.path, encoding="utf8") as f:`

│ └── 作用: 以 UTF-8 编码打开文件,确保文件读取后自动关闭

│

├── 3. 逐行读取文件

│ └── 操作: `for line in f:`

│ └── 作用: 遍历文件的每一行

│

├── 4. 判断行长度

│ ├── 4.1 如果行长度超过 `max_length`:

│ │ ├── 操作: `for i in range(len(line) // self.max_length):`

│ │ │ └── 作用: 将行分割为多个子序列,每个子序列长度为 `max_length`

│ │ ├── 操作: `input_id, label = self.process_sentence(line[i * self.max_length:(i+1) * self.max_length])`

│ │ │ └── 作用: 对每个子序列调用 `process_sentence` 方法进行处理

│ │ └── 操作: `self.data.append([torch.LongTensor(input_id), torch.LongTensor(label)])`

│ │ └── 作用: 将处理后的子序列及其标签转换为 `LongTensor` 并加入 `self.data`