双层BEV启发式具身导航路径规划新范式!Dual-BEV Nav:非结构化户外环境中的机器人导航

- 作者:Jianfeng Zhang 1 ^{1} 1, Hanlin Dong 1 ^{1} 1, Jian Yang 2 ^{2} 2, Jiahui Liu 3 ^{3} 3, Shibo Huang 1 ^{1} 1, Ke Li 2 ^{2} 2, Xuan Tang 1 ^{1} 1, Xian Wei 1 ^{1} 1, Xiong You 2 ^{2} 2

- 单位: 1 ^{1} 1华东师范大学软件工程学院, 2 ^{2} 2信息工程大学地理空间信息学院, 3 ^{3} 3福建师范大学计算机与网络安全学院

- 论文标题:Dual-BEV Nav: Dual-layer BEV-based Heuristic Path Planning for Robotic Navigation in Unstructured Outdoor Environments

- 论文链接:https://arxiv.org/pdf/2501.18351

主要贡献

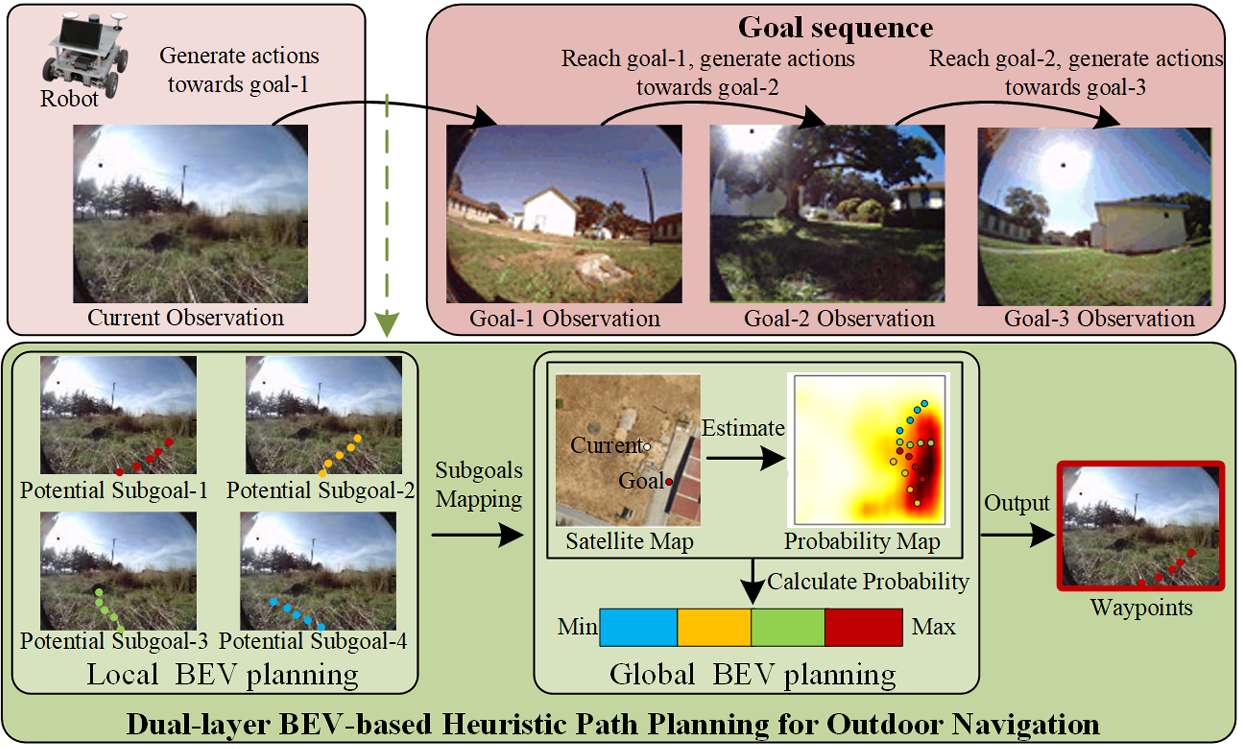

- 双层BEV启发式路径规划(Dual-BEV Nav):结合了局部和全局的BEV表示,用于在无结构户外环境中进行机器人导航。通过将局部和全局的可行驶性识别结合起来,实现了长距离导航。

- 局部BEV规划模型(LBPM):基于BEV的端到端导航模型,能够显著增强机器人在复杂环境中识别可行驶性的能力,而不需要进行可驾驶区域的显式分割,提高了路径规划的精度和适应性。

- 全局BEV规划模型(GBPM):通过概率图提供全局提示的全局BEV模型,有效减少了机器人对精确先验地图的依赖。通过从俯视图中学习可行驶性,提供了全局的可行驶性信息。

- 通过在公共数据集和现实世界场景中进行实验,与基线方法相比,Dual-BEV Nav在时间距离预测准确性上提高了高达18.7%,并且在现实世界部署中成功实现了65米长的户外导航。

研究背景

研究问题

- 路径规划能力依赖于机器人对全局和局部地面区域的可通行性识别。

- 论文主要解决的问题是机器人在非结构化户外环境中进行路径规划时的挑战,特别是在低质量位置和地图信息的情况下。

研究难点

该问题的研究难点包括:

- 室外开放环境的复杂性使得机器人难以识别缺乏清晰定义结构的地面区域的可通行性;

- 现有方法很少分析在非结构化户外场景中局部和全局可通行性识别的集成。

相关工作

地图的先验知识

地图的先验知识对于机器人的全局路径规划至关重要。根据应用环境的特点,使用先验地图的方法可以分为两类:

- 结构化环境:

- 在这些环境中,如街道、高速公路、校园、工业园区和港口,方法利用明显的结构特征构建精确的先验地图。

- 这些精确的先验地图为优化全局路径提供了坚实的基础。

- 然而,过度依赖先验地图使得在实际部署中难以调和实时传感器数据和先验地图之间的差异。

- 非结构化环境:

- 在这些环境中,构建精确的先验地图较为困难,因此路径规划高度依赖于实时感知。

- 先验地图的知识作为启发式指导,提供了更大的灵活性和适应性。

- 然而,先验地图的限制使得实现高效的全局规划具有挑战性。

路径规划的可行驶性识别

机器人通过识别可行驶性来进行路径规划。在机器人的局部/全局路径规划框架中:

- 局部可行驶性识别:

- 基于机器人的实时感知数据进行计算。

- 传统的基于前视视图的方法容易受到尺度失真的影响,而BEV(Bird’s Eye View)提供了距离信息,确保了感知的尺度不变性。

- 因此,基于BEV的环境感知在自动驾驶和户外机器人中得到了广泛应用,特别是在3D目标检测和语义分割任务中。

- 全局可行驶性识别:

- 依赖于先验地图的知识,如用于A*算法的2D网格地图和Dijkstra算法、3D点云以及拓扑地图。

- 最近的研究集中在从俯视图中识别可行驶性,包括基于颜色和形状的分割方法和基于模型的分割方法。

- 然而,依赖颜色和形状的分割方法由于地理区域间的巨大变异性而容易失败,并且通常需要大量的劳动和时间成本。

双层BEV启发式路径规划

局部BEV规划模型

局部BEV感知编码器

- 输入:包括上下文观察( o t − P : t − 1 o_{t-P:t-1} ot−P:t−1)和当前观察( o t o_t ot)。

- BEV视图变换:通过BEV视图变换方法增强机器人识别可行驶性和适应无结构环境的能力。

- 特征提取:使用LSS方法提取BEV特征,通过EfficientNet从前置摄像头提取图像特征,并预测每个像素的离散深度分布。深度估计后,将2D像素特征(

F

e

a

i

2

D

Fea_{i}^{2D}

Feai2D)提升到3D特征(

F

e

a

i

3

D

Fea_{i}^{3D}

Feai3D):

F e a i 3 D = D i estimate ⋅ F e a i 2 D Fea_{i}^{3D} = D_{i}^{\text{estimate}} \cdot Fea_{i}^{2D} Feai3D=Diestimate⋅Feai2D - BEV投影:将3D特征点云投影到2D BEV平面上,并使用BEV池化操作整合每个BEV网格上的所有特征。

任务驱动的目标解码器

- 输入:对于导航任务,输入包括环境上下文表示( o t − P o_{t-P} ot−P)、当前观察( o t o_t ot)和目标观察( o w o_w ow)。

- BEV视图变换模块:提高潜在特征的准确性。

- 目标函数:采用VIB方法训练目标函数,以建立输出之间的强相关性,并最小化KL散度,确保潜在特征的一致性:

L V I B ( θ , ϕ ) = E τ [ − E p ϕ [ log q θ ( { d } t : t + H ∣ z t w , o t − P : t ) + λ log q θ ( { a , x } t : t + H ∣ z t w , o t − P : t ) ] + β KL ( p ϕ ( z t w ∣ o w , o t − P : t ) ∣ ∣ r ( z t w ) ) ] \mathcal{L}_{VIB}(\theta, \phi) = E_{\tau} \left[ -E_{p_{\phi}} \left[ \log q_{\theta} \left( \{d\}_{t:t+H} | z_{t}^{w}, o_{t-P:t} \right) + \lambda \log q_{\theta} \left( \{a, x\}_{t:t+H} | z_{t}^{w}, o_{t-P:t} \right) \right] + \beta \text{KL} \left( p_{\phi} \left( z_{t}^{w} | o_{w}, o_{t-P:t} \right) || r \left( z_{t}^{w} \right) \right) \right] LVIB(θ,ϕ)=Eτ[−Epϕ[logqθ({d}t:t+H∣ztw,ot−P:t)+λlogqθ({a,x}t:t+H∣ztw,ot−P:t)]+βKL(pϕ(ztw∣ow,ot−P:t)∣∣r(ztw))]

其中, τ , p ϕ , q θ , z t w , d , a , x , H , λ , β \tau, p_{\phi}, q_{\theta}, z_{t}^{w}, d, a, x, H, \lambda, \beta τ,pϕ,qθ,ztw,d,a,x,H,λ,β 分别代表小批量数据、编码器、解码器、潜在特征、时间距离、路径点、GPS偏移、预测步长、平衡参数和KL散度调整参数。

全局BEV规划模型(GBPM)

从俯视图中学习可行驶性

- GBPM利用机器人自主探索生成的轨迹数据来学习俯视图中的可行驶性。

- 历史路径作为前景,未覆盖的区域作为背景。GBPM不使用简单的二值分割,而是直接使用概率预测来构建地图。

概率图构建

- 通过U-Net模型实现可行驶性分割。U-Net是一种用于图像分割的卷积神经网络,适用于从俯视图中提取可行驶性信息。

- 为了避免前景和背景之间的像素不平衡问题,GBPM使用二值焦点损失(Binary Focal Loss)进行训练。焦点损失的公式如下:

Focal Loss

=

−

α

⋅

(

1

−

p

t

)

γ

⋅

log

(

p

t

)

\text{Focal Loss} = -\alpha \cdot (1 - p_{t})^{\gamma} \cdot \log(p_{t})

Focal Loss=−α⋅(1−pt)γ⋅log(pt)

其中, p t p_{t} pt 是通过sigmoid函数获得的可行驶性预测概率, α \alpha α 是一个因子, γ \gamma γ 调整对分类良好的样本和难分类样本的重视程度。

概率图的应用

- GBPM将俯视图编码为一个概率图,其中每个像素表示机器人导航到该位置的提示值。

- 这个概率图是一个连续的概率分布,值随着接近不可通行区域逐渐增加,使机器人能够提前规划避障。

局部和全局集成

- 路径生成和评分:LBPM生成多个潜在的可行路径,提供时间距离、GPS偏移和路径点信息。GBPM将俯视图编码为全局概率图,并将这些路径投影到该图上。

- 路径评分公式:使用以下公式评估路径的成本,并选择最优路径:

KaTeX parse error: Expected 'EOF', got '_' at position 67: … \text{temporal_̲distance}

其中, k k k 是预设参数,用于调整GBPM和LBPM之间的重要性。

实验与结果分析

实验设置

-

公共数据集上的模拟:

- 使用RECON数据集进行模型训练和测试。RECON数据集包含来自9个不同真实场景的超过5,000条轨迹,包括车载摄像头图像、GPS坐标和其他维度特征。

- 使用Google Maps API获取俯视图像。

- 数据集分为训练集和测试集,每个模型在训练集上进行训练,并在测试集上评估其性能。

-

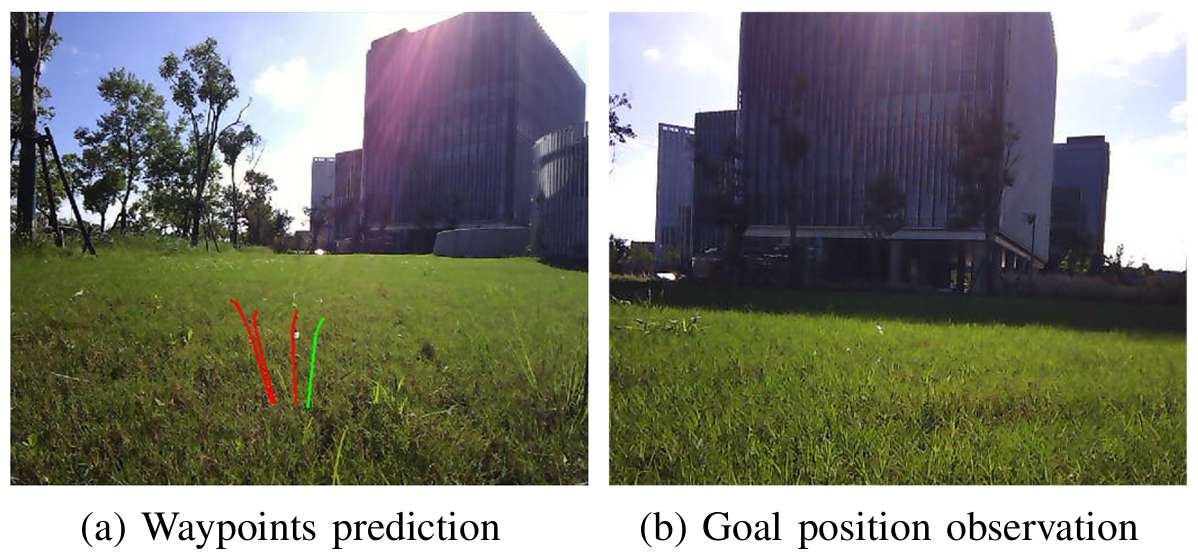

现实世界部署:

- 在学校环境中进行实验,该环境包括大量草地、林地和建筑物。

- 选择一个树荫下的轨迹作为导航实验的预期轨迹,并在同一场景中选择几个目标点进行信号-目标探索实验。

结果和分析

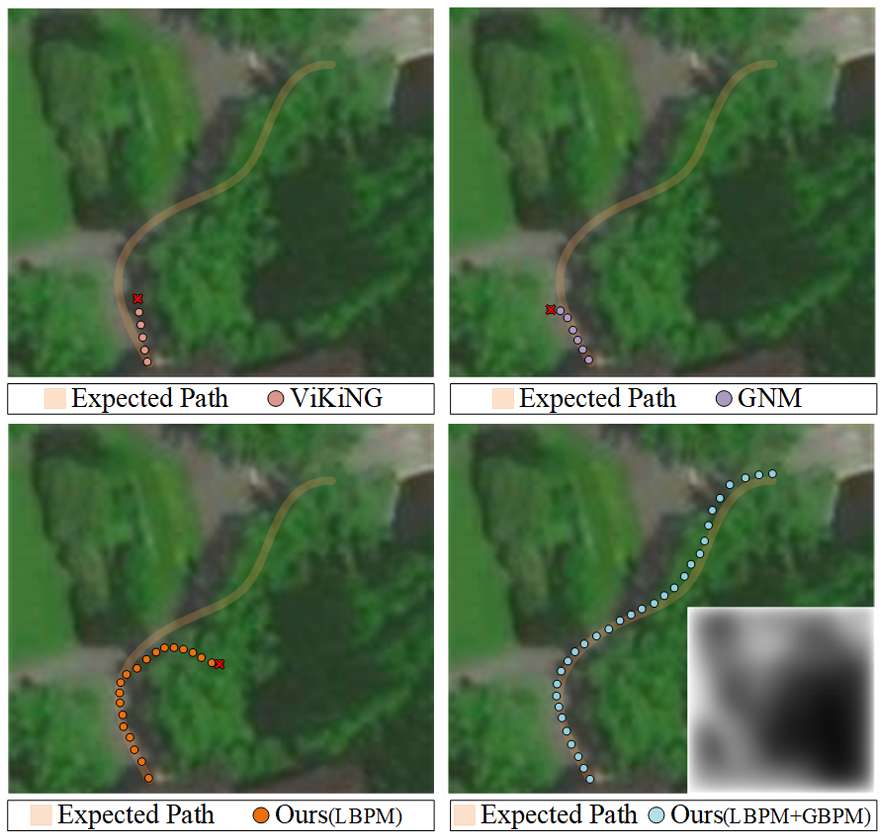

公共数据集上的模拟

- 时间距离预测:时间距离表示从当前位置到达子目标所需的时间步数,反映了到达子目标的难度。通过比较不同方法在时间距离预测上的表现来验证所提方法的改进。

- 远/近目标分类准确率:评估目标图像的时间距离分类准确率,具体来说,时间距离在0到10之间的目标被标记为“近”,在10到20之间的被标记为“远”。

- 时间距离预测准确率:在不同误差阈值下评估预测的准确性。结果显示,使用上下文信息的方法(本文方法和GNM)在时间距离预测上优于仅基于当前观察的方法(ViKiNG)。

现实世界部署实验

- 导航任务:

- 在导航任务中,尽管测试环境与训练数据集在建筑风格和地表植被上有显著差异,所提方法表现出显著的鲁棒性,并在所有方法中表现最佳。

- 在65米长的路径上成功完成导航任务,展示了在多急转弯路径上的优异性能。

- 与其他基线方法相比,ViKiNG和GNM在识别可行驶性方面能力较低,导致路径偏离预期。而LBPM在没有全局提示的情况下可以实现一定距离的导航,但在路径偏离和碰撞方面存在不足。LBPM和GBPM的结合成功地完成了导航任务。

-

单目标探索任务:

- 设置不同距离的目标,目标分为三个级别:Easy(距当前位置小于10米)、Medium(10-20米)和Hard(大于20米)。

- 在没有全局提示的情况下,LBPM在Hard和Medium级别上优于基线方法。加入全局提示后,LBPM+GBPM在中等难度级别上实现了100%的任务完成率,在Hard级别上达到了80%的成功率,平均位移为31米。

总结

- 论文提出了一种结合局部和全局BEV规划的方法,从overhead地图中提取的全局BEV提示和实时局部BEV表示。

- 增强了机器人在复杂户外环境中识别可通行性的能力,提高了路径规划的距离。

- 未来的工作将计划结合无人机获取实时俯视视图,以进一步提升系统的鲁棒性和实时性能。