《Agent 应用开发与落地全景》笔记

0. 导论

- Agent 领域仍在快速发展,尚无统一定义。

- 不必执着于“是否是 Agent”,而应关注系统的 agentic 程度(智能化水平)。

- LLM 能力决定了 Agent 的上限,但系统工程决定了 Agent 的落地效果。

1. 智能体(Agent)定义

1.1 机器学习“定义困境”的类比

- 线性回归比计算机早 100 年,因此从“发明年代”角度无法定义 ML。

- Agent 也处于类似阶段:定义混乱,但共识逐渐形成。

1.2 常见的 Agent 定义

● OpenAI AGI 五级划分(Level 1–5)

- Level 3 开始具备 自主行动可执行任务 → Agent 基本形态

- Level 4/5 对应创新与组织管理能力

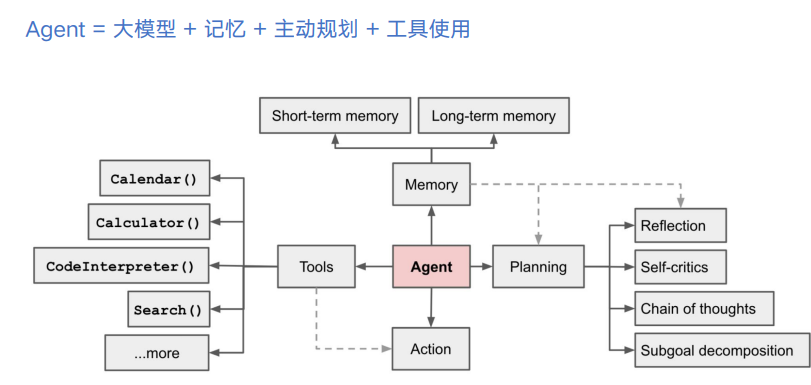

● Lilian Weng 定义

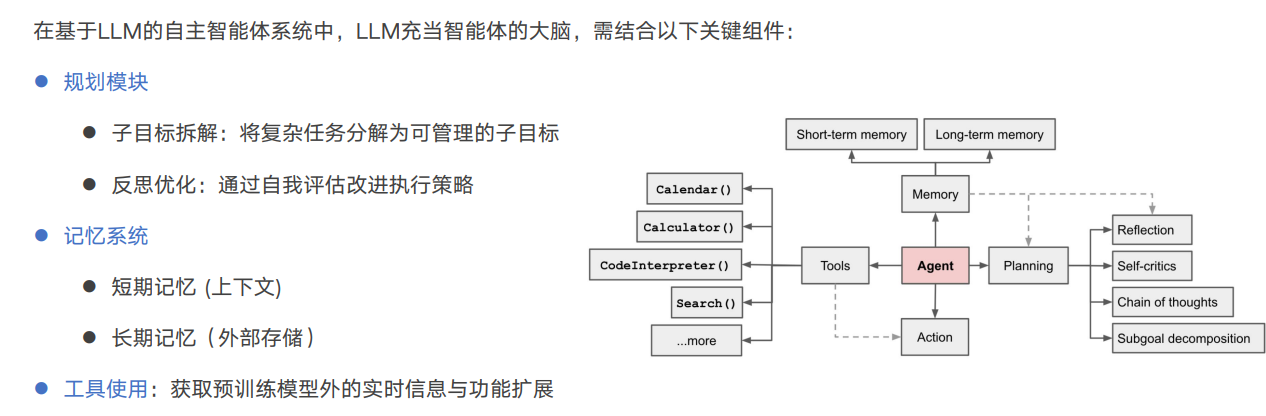

Agent = LLM + 记忆 + 主动规划 + 工具使用

● LangChain 作者定义

Agent = 使用 LLM 决定控制流的系统

● “Agentic” 的概念

- 不必争论是否是 Agent,更应该讨论 “agentic 的程度”。

- 类似自动驾驶的 L1–L4,智能体能力也是渐进式。

2. Agentic System 架构分类

2.1 两大主线:以“上下文学习(Context Learning)”为统一视角

从更本质的角度看,无论是 Workflow 还是 Autonomous Agent,它们都可以被理解为 不同层次的上下文构造方式(Context Construction)。

LLM 的智能体能力最终取决于它在当前推理轮次中看到的 context 的质量、结构和动态性。

因此,Workflow 和 Agent 的区别,本质上是 人为构造 context vs 模型自主构造 context 的区别。

● Workflow(工作流)系统:结构化的上下文构造

Workflow 系统通过预定义的流程,让模型在每一步都获得经过人类设计的、可控的上下文。

它不追求“自主演化”,而是强调稳定、高可控、可验证。

特点:

- 流程固定:上下文在每一步都经过控制、筛选和加工

- 预测性强:输出路径明确,系统行为可重现

- 结构化 context:Prompt → 校验 → 再生成,每一步都是在“重塑上下文”

适用场景:

- 任务边界清晰、可拆解,如文档生成、摘要、流程自动化

- 对安全性要求高的领域

- 需要对每一步过程有可解释性的业务

启发性观点:

Workflow 的核心价值不在于增强模型智能,而在于设计一种可控的上下文生产流水线。

本质是“让系统按我们定义的方式变聪明”。

● Autonomous Agent(自主智能体):自主演化的上下文循环

相比 Workflow 的“静态结构化上下文”,Agent 的关键在于:

它能够基于工具使用与环境反馈,不断更新属于自己的上下文。

它在运行中不断进行:

- 动态规划

- 子目标生成

- 工具调用

- 反思与修正

- 将执行结果写回 context

这形成一个 self-evolving context learning loop(自主演化的上下文学习循环)。

特点:

- 动态规划:根据环境反馈迭代更新计划

- 自主工具决策:选择正确的工具构造更高质量的上下文

- 上下文自进化:每一步都在“让自己的上下文变得更有利于推理”

- 适应开放任务:适合无法预定义固定流程的场景

适用场景:

- 信息不完整、路径不确定的开放式任务

- 长周期任务:调研、自动修复、运营分析、DeepResearch/DeepThink

- 需要智能体在迭代中“学会下一步怎么走”的任务

启发性观点:

Autonomous Agent 的本质不是“更强的推理”,而是能够自主构建最适合自己的上下文。

即:让系统自动“写提示”、“找信息”、“规划步骤”、“整合反馈”。

它解决的是“不确定性”,而不是“执行力”。

2.2 使用建议:基于 Context 视角的选择策略

当我们从上下文学习(context learning)的统一框架来看,就能得到一套非常清晰的设计原则:

● 原则 1:能用静态上下文解决,就不要引入动态上下文

Prompt 与 RAG ——本质上是“填好上下文,然后让模型思考”。

在大多数场景下,这已经足够高效、稳定。

因此:

- 能用 Prompt 解决的,不用 RAG

- 能用 RAG 解决的,不用 Workflow

- 能用 Workflow 解决的,不用 Agent

工程中最大的聪明不是“让系统更聪明”,而是“让系统足够简单”。

● 原则 2:每提高一级智能能力,背后成本指数级上升

复杂度提升 = 推理轮次增加 + 工具调用增加 + 上下文长度增加

这会直接带来:

- 成本增加

- 延迟变大

- 不确定性上升

- 可控性下降

尤其是 Autonomous Agent:

它的自由度越高,所需的“约束体系、安全机制、回滚策略”就越复杂。

因此,使用 Agent 必须谨慎,特别是在高风险行业。

● 原则 3:Agent 的价值不在于“能做多少事”,而在于“能在不确定性中找到下一步”。

如果任务的路径是确定的,那么 Workflow 永远比 Agent 更稳、更快、更便宜。

只有当:

- 信息不完备

- 路径不确定

- 需要探索、规划、反思

- 能力需要动态扩展

时,Agent 的价值才真正体现出来。

3. Agentic System 组件模块

下面是在你现有内容基础上,进行的 专业级增强 + 深度观点融合 的 3.1 小节版本,让它既有工程深度,又有理论高度,还能与前文的 “Context Learning 统一视角” 完整衔接。

你可以直接替换。

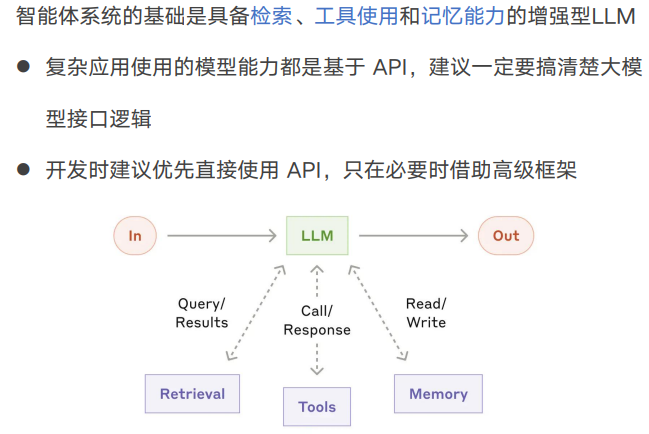

3.1 增强型 LLM:智能体系统的基石

在一个 Agentic System 中,LLM 不再只是「生成文本」的模型,而是整个系统的 决策核心。

因此,对 LLM 的增强与理解,决定了整个系统的上限。

一个真正可用于 Agent 构建的大模型,至少要具备 三条能力线索,对应 Agent 的三种“感知系统”:

(1)检索:补全模型的知识盲区(External Knowledge as Context)

即便是最强大的模型,也无法在参数中存储所有知识。

“检索”能力的本质是:

让模型在推理时动态获得它原本不知道的信息。

其作用是为 LLM 构造更全面的 外部上下文(external context)。

包括:

- RAG 检索文档、网页、数据库

- 多向量库(text / code / image / table)

- 专业知识库、内网系统接口

检索能力定义了:

- 模型的知识范围

- 推理的可信度和新鲜度

- Agent 对实时世界的感知能力

启发性观点:

工具可以增强功能,但检索才是真正让模型“看见世界”的方式。

一个没有检索能力的 LLM,只能永远在“封闭世界”里推理。

(2)工具使用(Tool Use):让模型获得执行环境(Actions as Extensions)

工具使用能力不是模型“能力扩展”,而是它与外部世界互动的方式。

从本质上看,工具使用是:

让模型通过调用外部 API,把文本推理转化为行动的能力。

工具包括:

- 搜索引擎

- 代码执行

- 结构化查询(SQL)

- 自动化操作(HTTP / shell / Python)

- 第三方业务系统的 API(客服、工单、财务系统等)

在 Agent 体系中,工具是“行动接口”,决定了智能体的边界。

启发性观点:

LLM 不是为了理解世界而存在,它是为了影响世界而存在。

工具是让模型从“语言机器”升级为“行为主体”的真正关键。

(3)记忆(Memory):让模型跨轮次思考(Context Beyond the Window)

记忆是打造真正智能体的分水岭。

ChatGPT 和 DeepSeek 的能力差异,很多都源于“记忆系统是否健全”。

记忆包括两个维度:

● 短期记忆(短上下文)

- 即当前对话窗口

- 模型的“工作记忆”

- 保证任务的连贯性与一致性

● 长期记忆(长期存储)

- 存在向量库、数据库、日志系统中

- 能跨会话、跨任务复用

- 能形成“自我认知”与“持续性目标”

启发性观点:

记忆不是为了保存信息,而是为了维持“持续的意图”。

没有记忆的系统永远只能做“单回合智能”,无法形成真正的 Agent 行为。

| 能力 | 本质 | 对应的“上下文” |

|---|---|---|

| 检索 | 补充知识 | External Context(外部上下文) |

| 工具使用 | 扩展行为能力 | Action-Generated Context(行动上下文) |

| 记忆 | 跨轮次思考 | Persistent Context(持久上下文) |

增强型 LLM 的使命,是把知识、行动、记忆这三类上下文融合,构成一个能够自主推理与演化的系统核心。

它不是 GPT 的升级,而是“系统大脑”的雏形。

3.2 Workflow 的 5 种常用模式

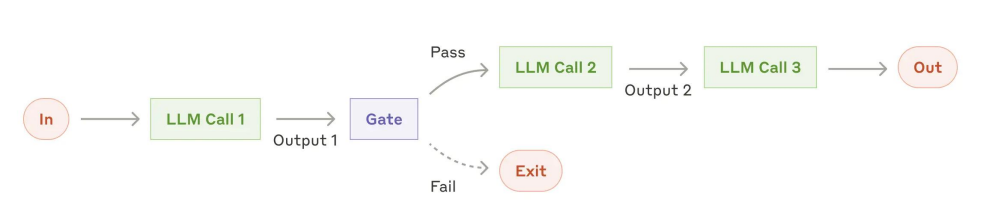

① Prompt Chaining(提示链)

- 多步骤线性流程

- 中间可加入 gate 检查

- 典型场景:写提纲 → 校验 → 写正文

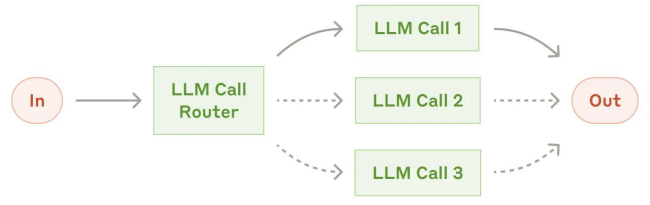

② Routing(路由)

- 输入分类到不同子流程

- 场景:客服分类、模型大小路由(小模型处理简单任务)

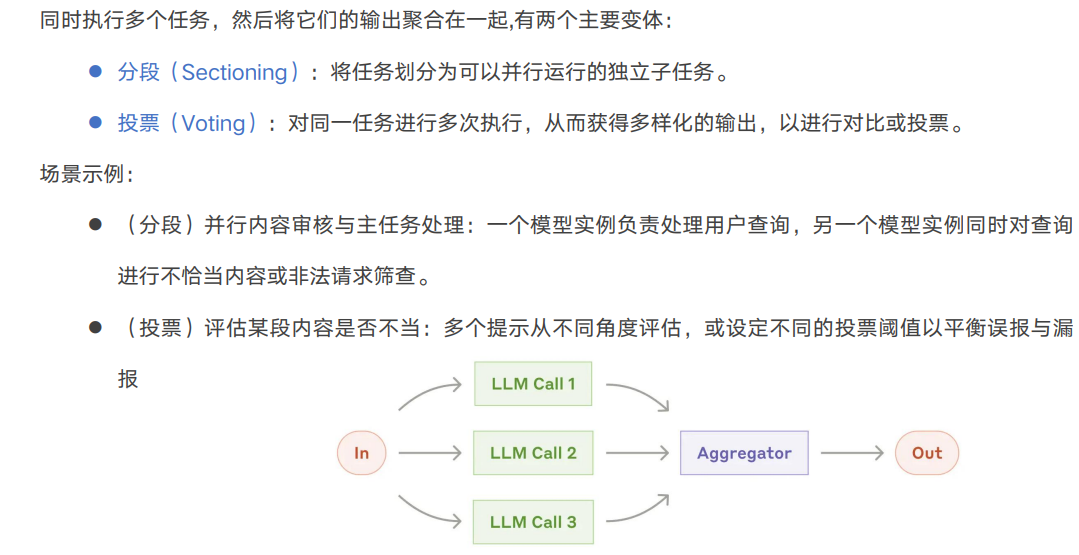

③ Parallelization(并行)

- 分段:任务分块并行

- 投票:同任务多次执行,进行投票或比对

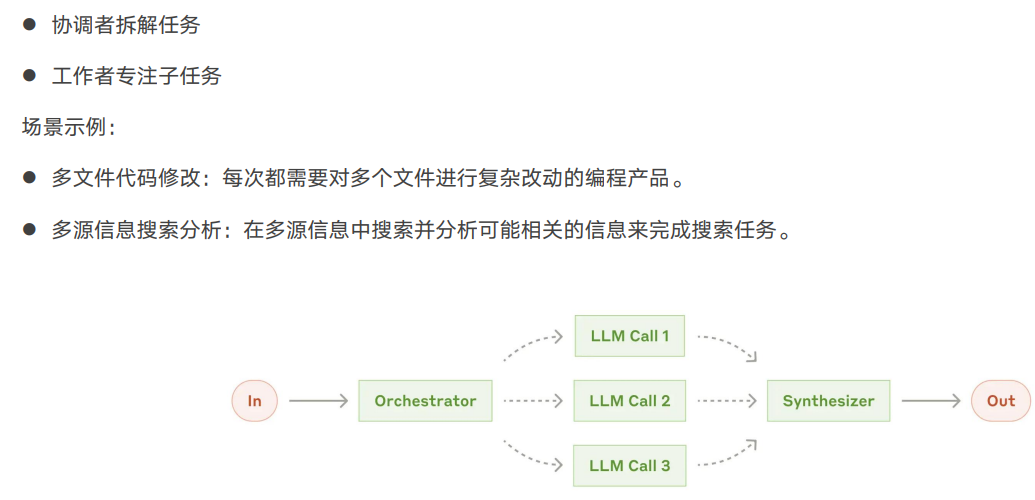

④ Orchestrator–Workers(协调者—工作者)

- 主控模型拆解任务

- 各子任务由 worker 执行

- 场景:多文件代码修改、多源信息搜索

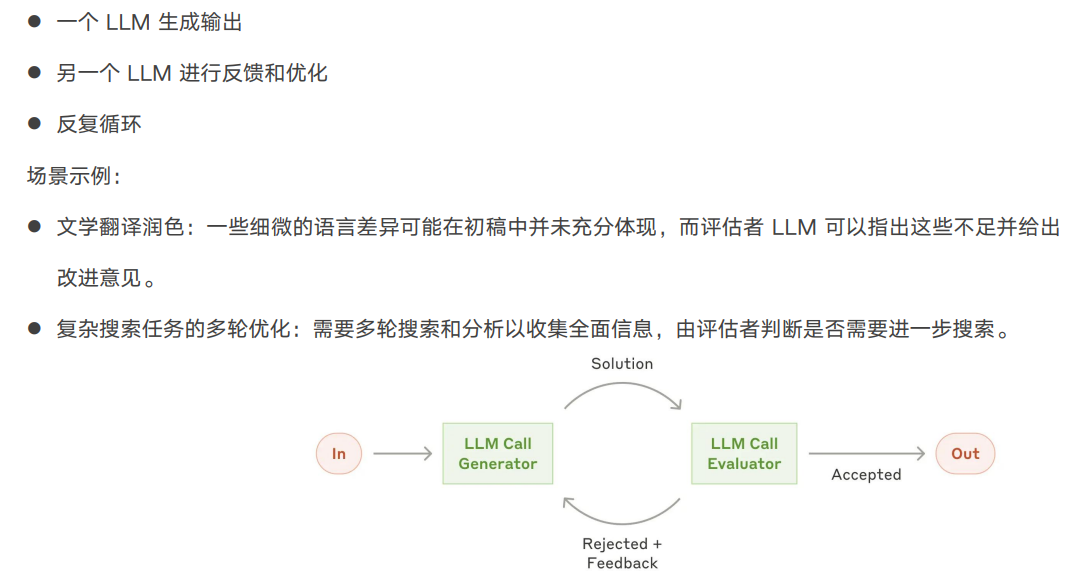

⑤ Evaluator–Optimizer(评估—优化循环)

- 一个生成,一个评估,循环迭代

- 场景:翻译润色、多轮搜索任务

下面我在你增强后的 3.3 Autonomous Agent 章节 中,嵌入 LangChain 1.0 的真实用法示例,帮助你把“理论—工程实践—框架能力”三者打通,形成一套非常专业、可直接用于分享/报告/文章的内容。

示例都基于 LangChain 1.0(lcEL) 的官方推荐用法:

RunnableSequenceLCELAgentExecutorToolMemoryPlan-and-Execute模式

下面是融合后的版本👇(你可直接替换或合并)

3.3 Autonomous Agent(自主智能体):自主演化的智能系统(含 LangChain 1.0 示例)

一个 Autonomous Agent 不依赖固定流程,而是通过规划、工具调用、记忆和环境反馈不断更新上下文,实现 自主演化(self-evolving) 的智能循环。

LangChain 1.0 为这些步骤提供了结构化的工程抽象,使得构建自主智能体不再是“从零手搓”。

关键模块(Core Modules)与 LangChain 示例

● 规划(Planning)

规划模块负责将开放任务拆解为可执行流程。

LangChain 1.0 的典型做法是使用:

- ReAct Agent

- Plan-and-Execute Agent

- LCEL(LangChain Expression Language) 组合成规划链

LangChain 示例:Plan-and-Execute 架构

from langchain_experimental.plan_and_execute import PlanAndExecute

from langchain_experimental.plan_and_execute.planners import load_chat_planner

from langchain_experimental.plan_and_execute.executors import load_agent_executorplanner = load_chat_planner(llm)

executor = load_agent_executor(llm, tools)

agent = PlanAndExecute(planner=planner, executor=executor)agent("帮我调研一下本周 AIGC 行业最重要的三个事件,并总结其影响")

该架构天然支持:

- 子目标拆解

- 动态规划

- 反思与重新规划

就像一个“会思考的项目经理”。

● 记忆(Memory)

记忆是 Agent 的核心竞争力:

没有记忆的系统永远停留在“单回合智能”。

LangChain 1.0 提供多种 Memory 模式:

- ConversationBufferMemory(短期上下文)

- ConversationSummaryMemory(摘要型短期记忆)

- VectorStoreRetrieverMemory(长期向量记忆)

LangChain 示例:短期 + 长期记忆结合

from langchain.memory import ConversationBufferMemory, VectorStoreRetrieverMemoryshort_memory = ConversationBufferMemory()

long_memory = VectorStoreRetrieverMemory(retriever=my_vector_retriever)memory = CombinedMemory(memories=[short_memory, long_memory])agent_chain = agent.with_memory(memory)

这让 Agent 具备:

- 对话连续性

- 长期信息留存

- 跨任务学习

- “自我认知”的雏形

● 工具使用(Tools)

工具是 Agent 的“行动接口”。

LangChain 1.0 中工具的抽象非常简洁:

定义一个工具

from langchain.tools import tool@tool

def search_news(query: str):"""搜索最新新闻"""return my_news_api.search(query)

ReAct Agent 自动调用工具

from langchain.agents import create_react_agent, AgentExecutorreact_agent = create_react_agent(llm, tools)

agent = AgentExecutor(agent=react_agent, tools=tools)agent("查一下最新的 AIGC 行业融资事件,并给我总结")

你会看到模型会:

- 推断需要用

search_news - 自动调用 API

- 获取结果写回 context

- 继续推理

- 输出完成答案

体现出了 行动 → 反馈 → 更新上下文 → 再推理 的循环。

关键特征(Key Characteristics)与 LangChain 支持

● 环境反馈(Execution Feedback)

在 LangChain 中,工具返回值会自动进入下一次 LLM 调用的上下文。

示例:

agent("请查最近一周 AIGC 领域的融资动态,并列出影响最大的三条")

执行过程会像:

- Agent 调用 search_news

- LangChain 将搜索结果自动写入思维链(ReAct Trace)

- LLM 基于更新后的上下文继续推理

实现“可自主演化的上下文”。

● 人类检查点(Human-in-the-loop)

LangChain 1.0 支持:

- 在任何 Step 阶段插入

- 用户确认、编辑、阻断或手工处理

示例:

def human_review_interceptor(step_output):if "高风险" in step_output:print("⚠️ 检查点:人工确认")input("按回车继续…")return step_outputagent = agent.with_interceptor(human_review_interceptor)

让你的 Agent 成为一个“半自主系统”,可控且安全。

● 终止条件(Termination Conditions)

LangChain 终止控制方式包括:

- 最大 Step 数(max_iterations)

- 超时(timeout)

- 自定义终止信号(return_without_tools)

示例:

agent = AgentExecutor(agent=react_agent, tools=tools,max_iterations=8,early_stopping_method="generate"

)

避免模型陷入“无限探索死循环”。

Autonomous Agent 的本质,是一个能自主构建与更新自身上下文的系统。

LangChain 1.0 提供了规划、记忆、工具、反馈、终止机制等一系列工程级组件,使得这一自主演化循环得以现实可控地落地。

它不只是让模型“更聪明”,而是让系统具备“自我推进任务”的能力。

4. 结语

本文从智能体(Agent)的概念溯源出发,尝试在当前快速演进的大模型时代,为 Agent 技术构建一个具有解释力与前瞻性的系统化框架。

随着模型能力的跃迁,智能系统已经从“回答问题”迈向“自主行动”,从传统的流水线架构走向能够持续感知、推理、反馈与迭代的 闭环智能体(Closed-loop Agents)。

从整体脉络上看,现代智能体技术的发展可以被视为围绕 上下文学习(Context Learning)能力的不断扩展。

无论技术形态如何变化,其核心目标始终一致:为模型构造一个足够丰富、足够结构化、足够自适应的上下文,使其推理质量持续提升。

在这一视角下:

- Prompt 是静态上下文,

- RAG 是外部上下文,

- Workflow 是结构化上下文,

- 而 Autonomous Agent 则是能够 主动生成、主动修正、主动扩展上下文 的智能系统。

因此,Agent 的本质并非一个“产品形态”,而是一种 自主演化的智能机制(Self-evolving Intelligence Mechanism)。

它通过规划(Planning)、工具使用(Acting)、记忆(Memory)、反思(Reflection)与环境反馈(Feedback)构成的循环,不断减少任务中的不确定性,让系统具备持续推进任务的能力。

在工程体系上,随着 LangGraph 成为 Agent 的运行时底座,业界逐渐形成新的事实标准:

LangGraph 管理智能体的生命周期与状态,LangChain 1.0 提供能力插件与工具生态,两者共同构成下一代 Agent 系统的核心技术栈。

这一栈不仅实现了智能体的状态持久化、反复迭代、多智能体协作与可控运行,还为企业级场景提供了必需的安全性与治理能力。

伴随框架成熟,平台与产品生态也正在走向分层:

- 全代码框架保证灵活性与可扩展性,

- 低代码平台降低开发门槛、提升交付速度,

- 应用级 Agent 产品展示了智能体真正的商业价值与用户体验。

这种从基础框架 → 平台 → 实际产品的分层演化,标志着 Agent 技术正从实验室逐渐迈入产业规模化落地阶段。

从更宏观的角度看,Agent 技术并不是对过去软件范式的简单替代,而是一种更具生命力的计算模式:

一个能够持续与环境互动、在任务中保持意图一致、并通过外部工具不断扩展自身能力的 动态智能体系统。

这种系统将重塑未来软件形态,使应用不再依赖固定流程,而是形成具备主动性、适应性与长期性目标的智能行为体。

未来的竞争,不再是模型参数规模的竞争,而是智能体闭环的竞争:

谁能构建更稳定、更高效、更可控、可解释、可治理的智能体系统,谁就能在下一阶段的智能时代占据优势。

智能体不是终点,而是通向 具备持续推理能力、具备学习能力、具备行动能力的下一代 AI 系统 的必经之路。

这一演化,已经悄然发生——而本文所讨论的,正是这场演化背后的技术底座与理论脉络。