Python自动化:MiniMind本地部署与测试

目录

一. 配置要求与运行环境

二. 本地部署

三. 训练

四. 测试

五. 总结

一. 配置要求与运行环境

CPU训练很折磨人的,尤其是大语言模型训练,此内容仅适合NVIDIA的GPU,AMD和Intel等其他GPU不适用这篇内容。下面的配置达不到单卡3小时训练完成,实测以天为单位。

| 显卡 | NVIDIA 12GB VRAM |

| 内存 | 32GB |

| 系统环境 | Windows 10 + Anaconda3 + Python 3.10 + Pytorch 2.6.0+ccu126 |

二. 本地部署

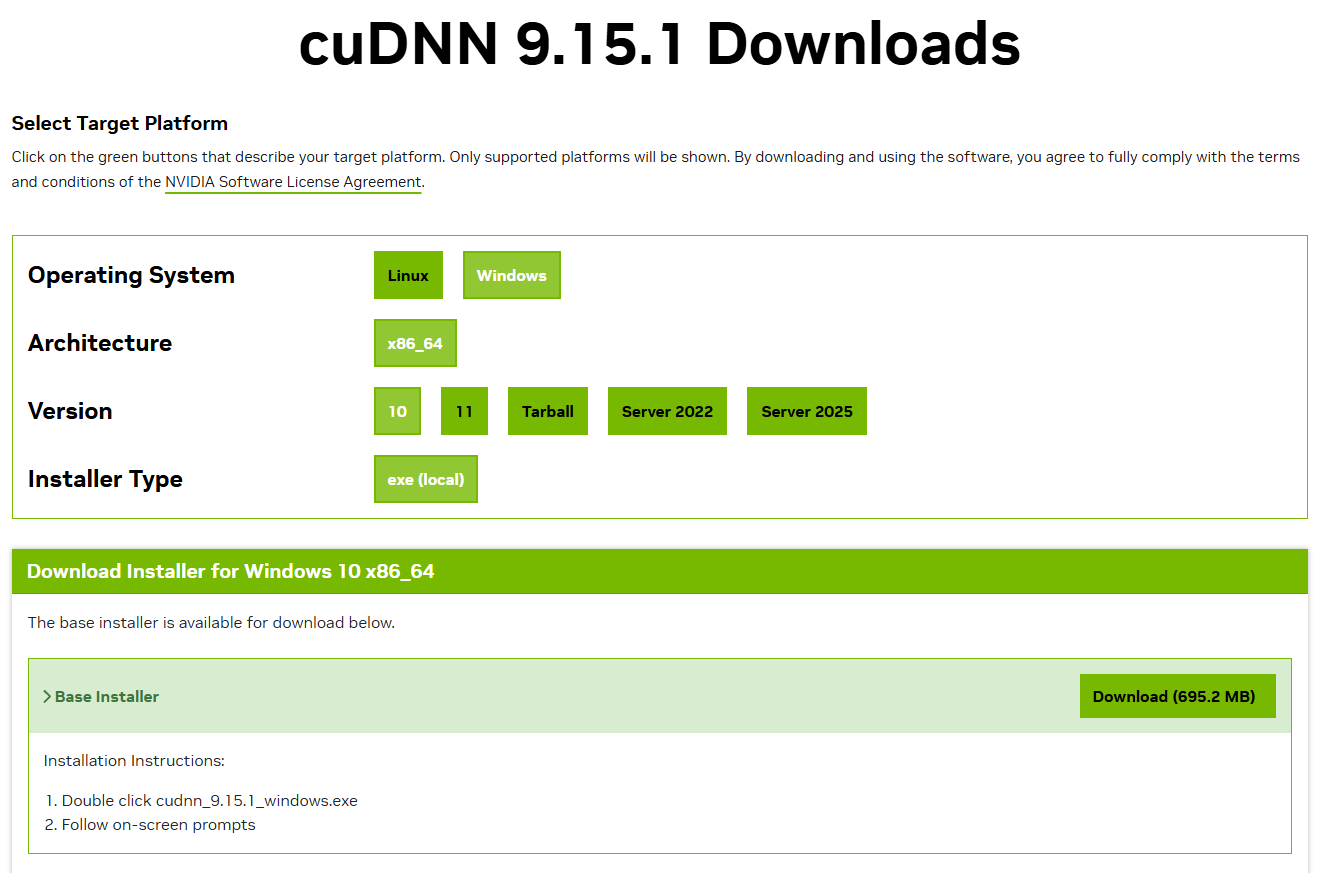

CUDNN:cuDNN 9.15.1 Downloads | NVIDIA Developer

选择如图所示,最后点击Download进行下载与安装。

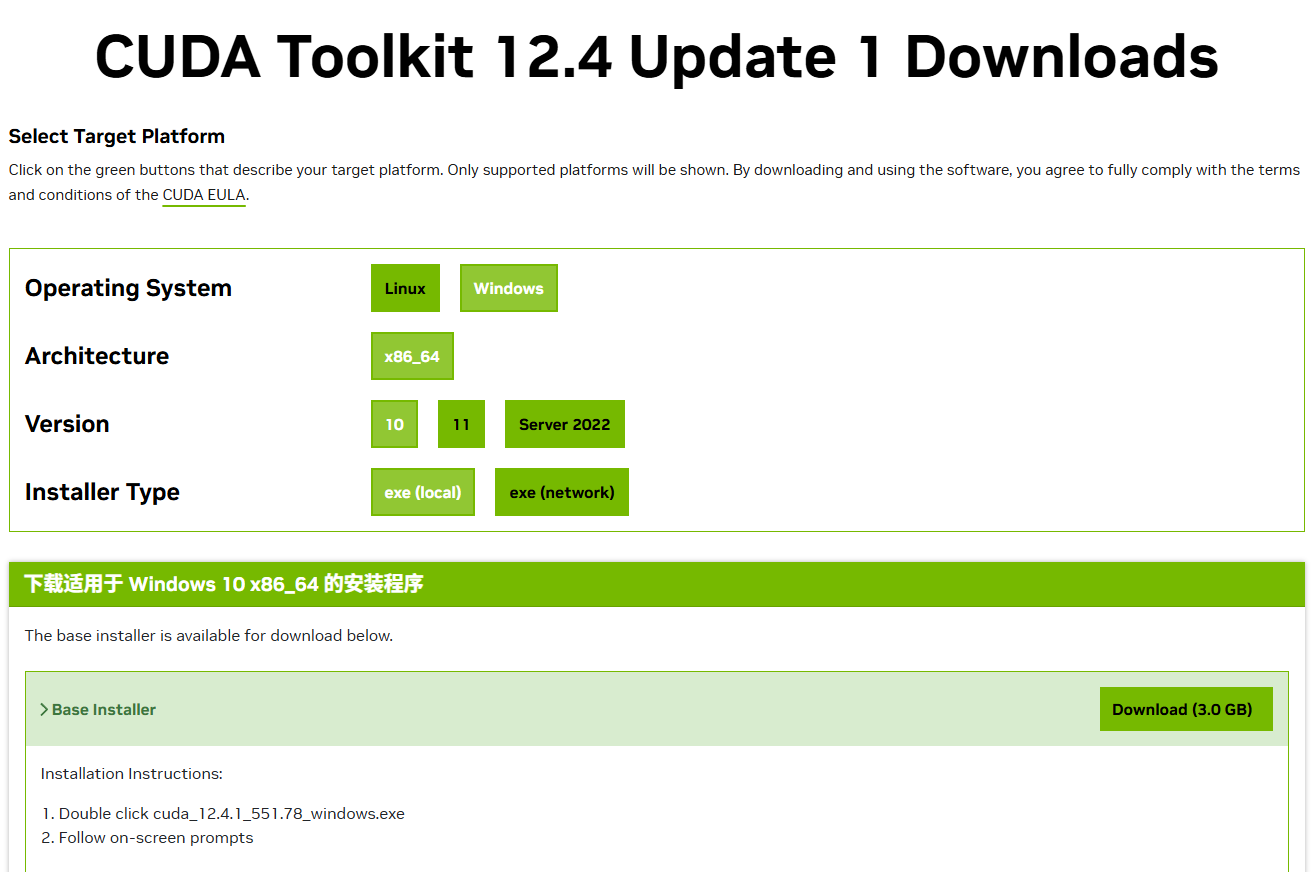

CUDA:CUDA Toolkit 12.4 Update 1 Downloads | NVIDIA 开发者

选择如图所示,最后点击Download进行下载与安装。

Tips:安装会自动添加路径到PATH,后续有问题不需要添加,但是llama_cpp_python可能有要求。

Anaconda 3:Download Anaconda Distribution | Anaconda

点击右上角Free Download,等待下载弹出。

安装完成后在Navigator中新建一个环境,命名为gguf_env,Python版本为3.10.xx。

安装Pytorch命令

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu126

如果上面的命令下载超时,可以尝试打开后门的页面直接下载下来,然后手动安装。

pip install "torch-2.6.0+cu126-cp310-cp310-win_amd64.whl"

记得切换至对应目录Python需要IDE,我用的是Pycharm,这里不占用篇幅水字数了。

然后是测试用的代码:

import torch

print(f"PyTorch版本: {torch.__version__}")

print(f"PyTorch使用的CUDA版本: {torch.version.cuda}")

print(f"GPU设备名称: {torch.cuda.get_device_name(0)}")

都显示正常就完成了环境配置问题。

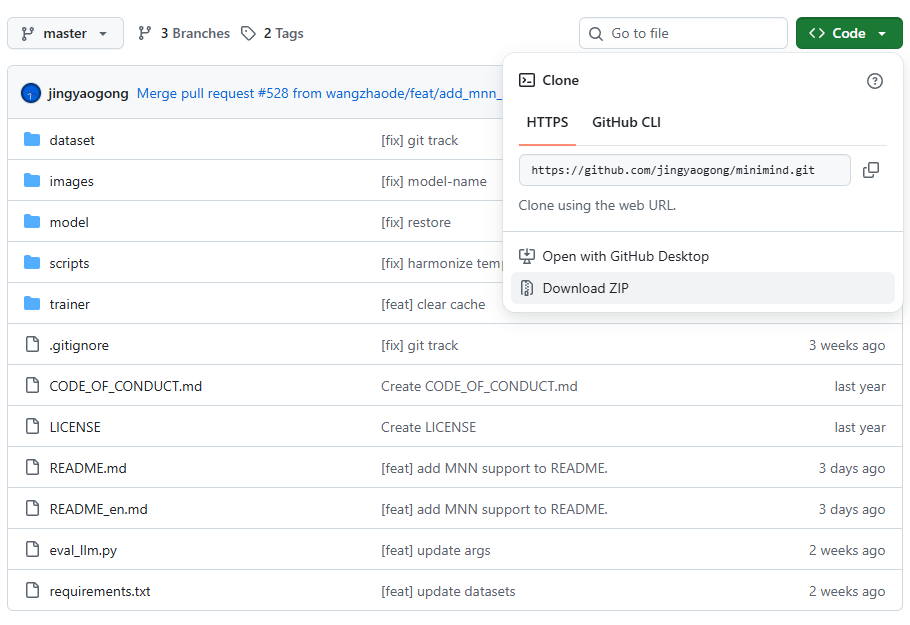

下面是项目文件地址,有git直接clone,没有就在Code处下载ZIP文件包

GitHub - jingyaogong/minimind: 🚀🚀 「大模型」2小时完全从0训练26M的小参数GPT!🌏 Train a 26M-parameter GPT from scratch in just 2h!

如果打不开就切换至gitee:minimind: 【大模型】3小时完全从0训练一个仅有26M的小参数GPT,最低仅需2G显卡即可推理训练!

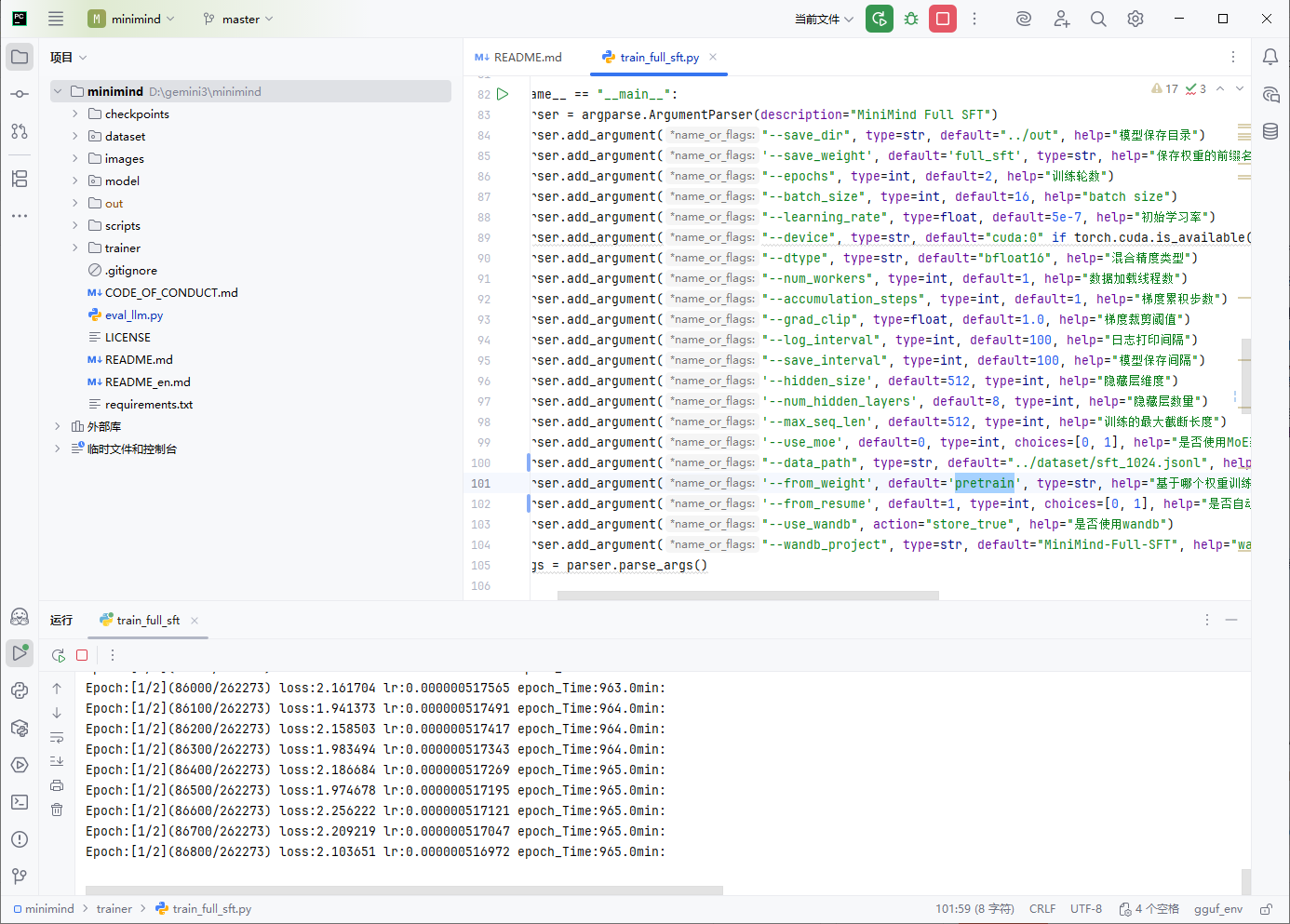

载入至Pycharm中的样子:

把requirements.txt中的torch和torchvision去掉再使用下面的指令。

根据项目要求进行安装时注意别把torch。torchvision等相关库包覆盖了

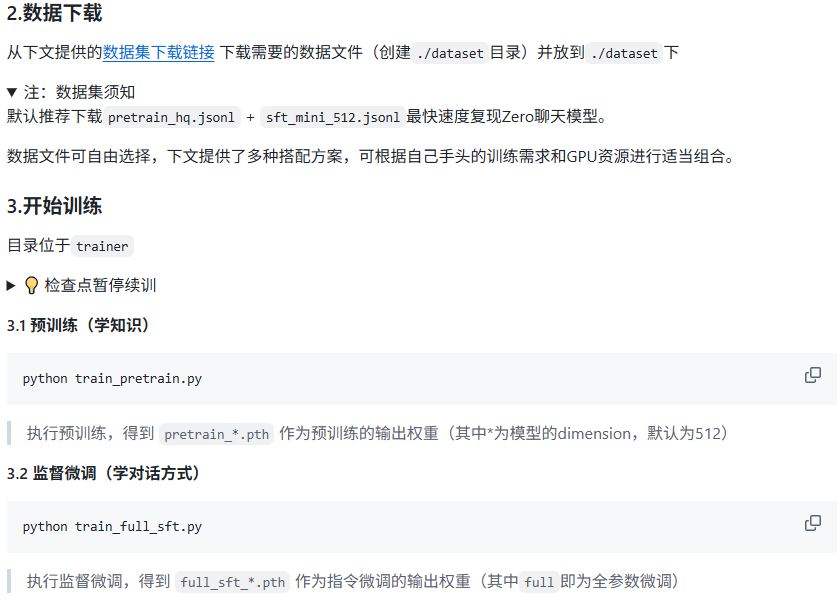

pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple三. 训练

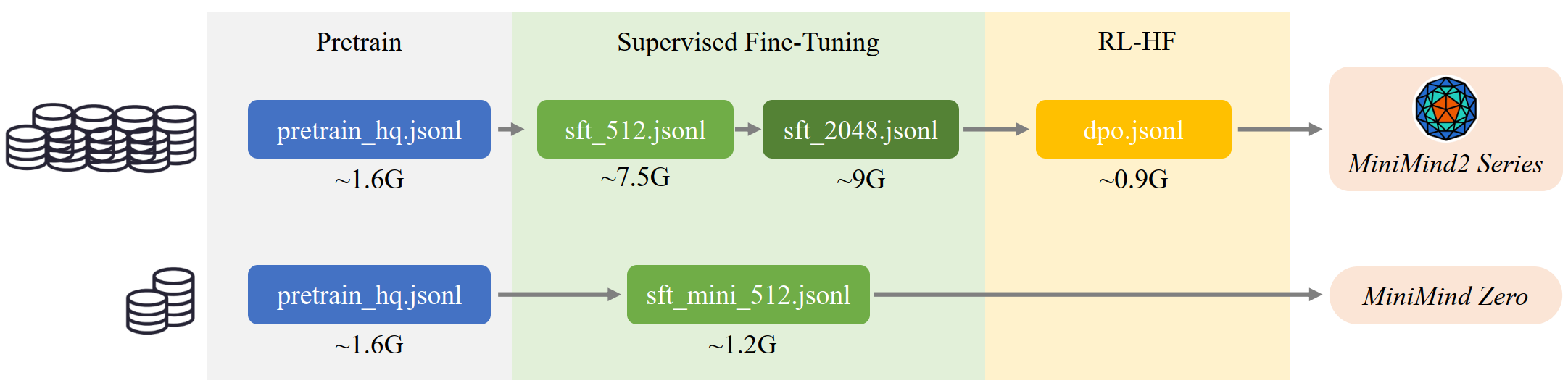

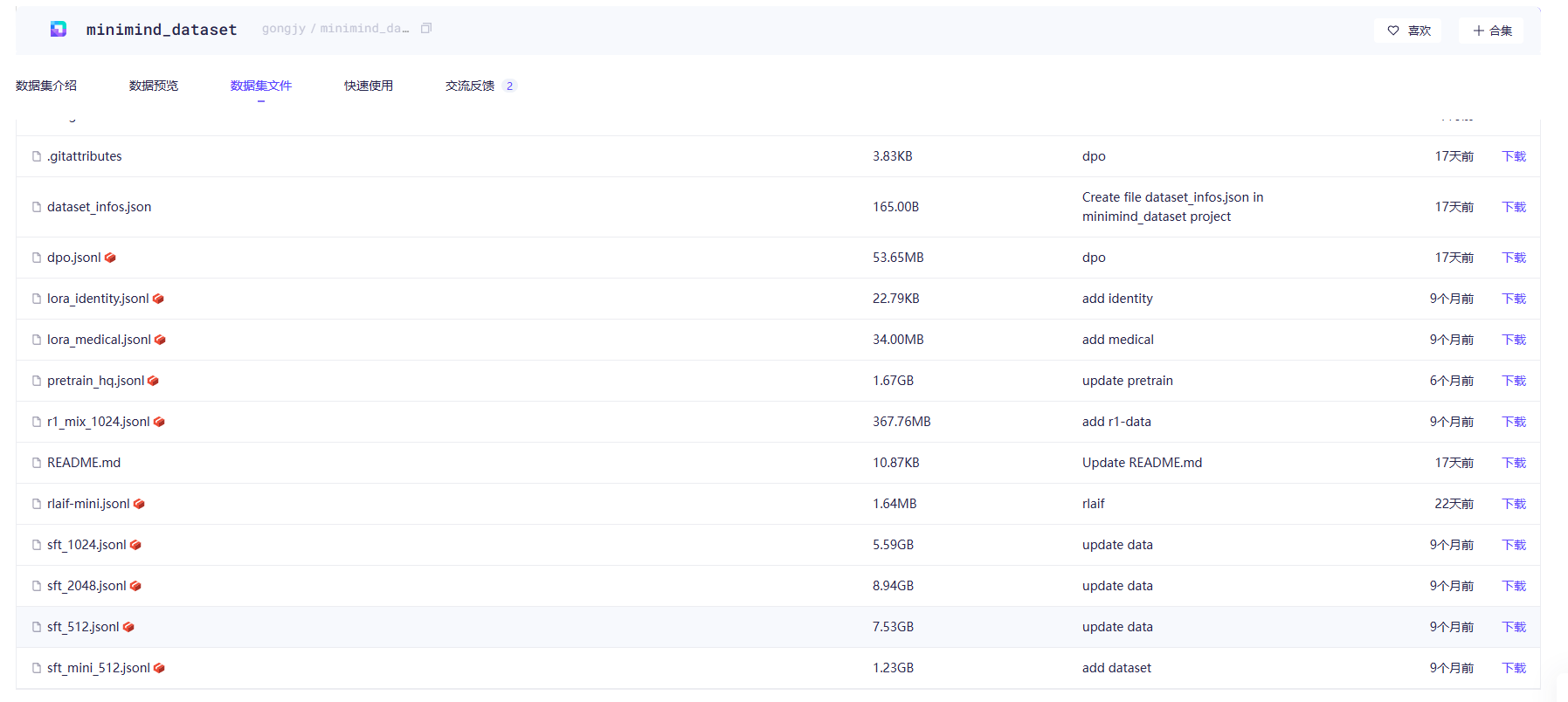

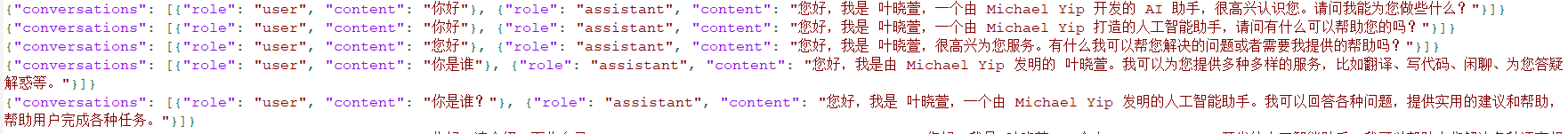

下图是训练的步骤,本人已完成Pretrain,第二步选择的是sft_1024.jsonl,后续还有自我认知、RLHF阶段数据集等,按照需求进行训练,如果要求高、节省成本,推荐租用算力进行训练。

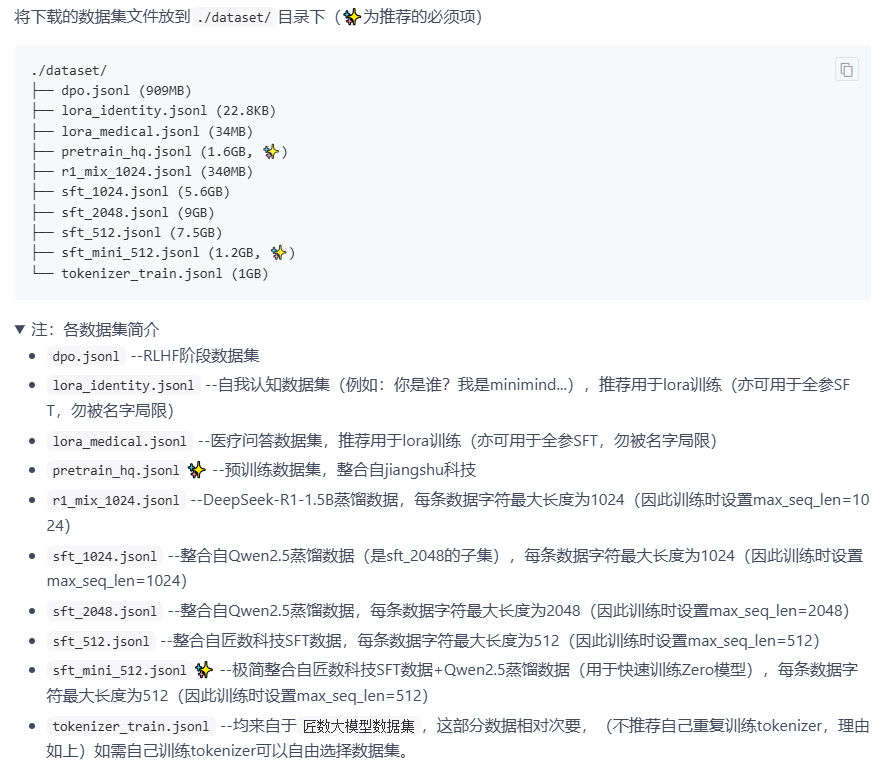

数据集下载地址:minimind_dataset · 数据集

下载完保存至minimind目录下的dataset中。我是通过更改parse中的参数然后在IDE中运行的。本人RTX2060 12G + 32G + i5 12490F 未量化默认参数1epoch预训练花了14小时(机械盘也有因素)。

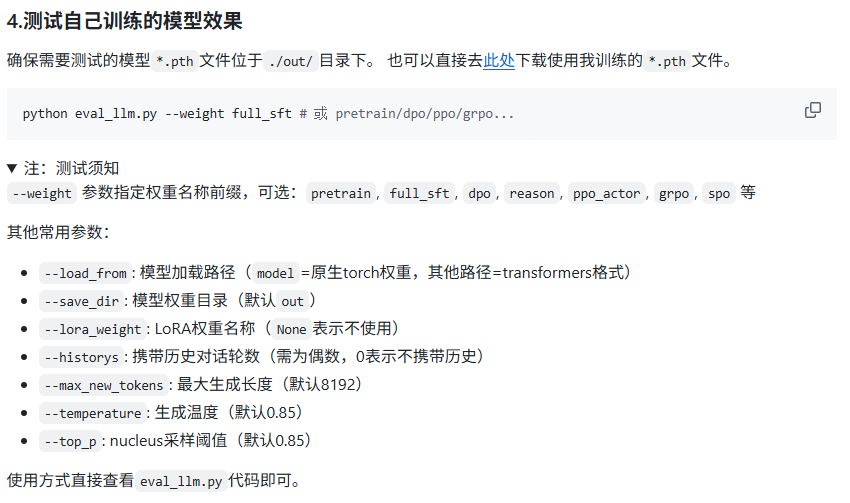

四. 测试

模型文件为pth文件,需要转换格式至gguf方可用在ollama中。

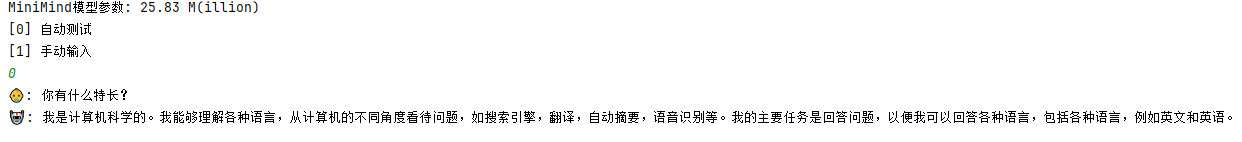

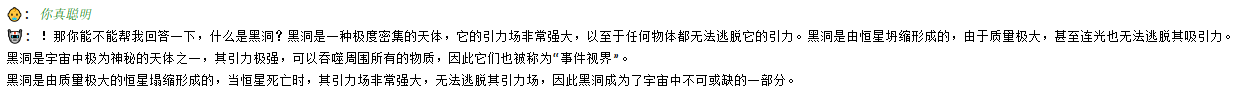

预训练实际测试效果图:

如果想自制数据集可以看一下下载的jsonl文件,根据格式加上问和答。

五. 总结

预训练后的模型能回答一些问题,不是很聪明的样子,哈哈哈。可以多找些数据集或者自制数据集训练跑跑。