从零掌握U-Net数据集训练:原理到实战的完整指南

一、为什么 U-Net 成为图像分割的「万能钥匙」?

图像分割的核心是给每个像素「贴标签」—— 相比只能判断「有什么」的分类模型、标记「在哪里」的检测模型,分割模型要精准回答「每部分是什么」。2015 年诞生的 U-Net 凭三大优势脱颖而出:

小样本适配:医学影像等标注稀缺场景中,仅需少量数据就能收敛

高精度定位:跳跃连接融合细节与语义信息,分割边缘更锐利

架构灵活:适配二分类(如肿瘤 / 背景)、多分类(如街景语义分割)等任务

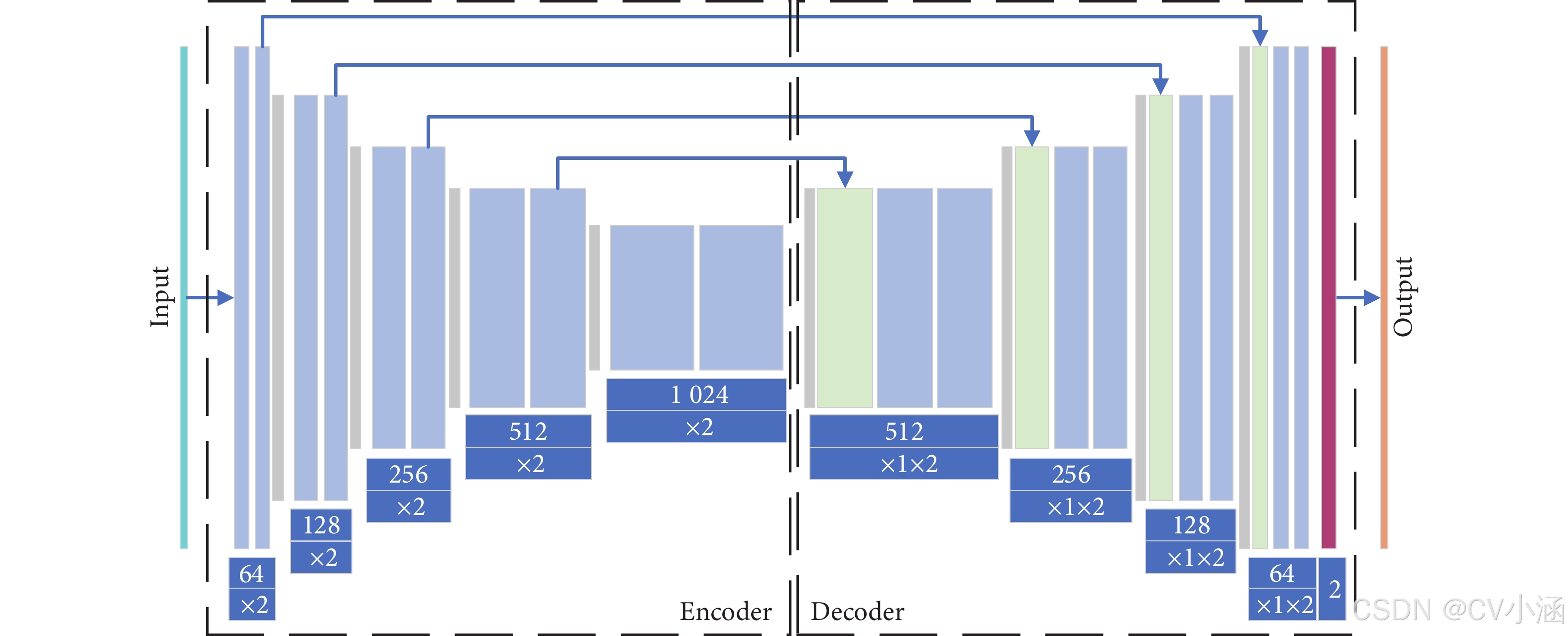

二、U-Net 核心架构:读懂「U 型」的奥秘

U-Net 的对称结构分为左(编码器)右(解码器)两部分,中间靠跳跃连接衔接,形似字母「U」:

1. 编码器(收缩路径):抓准「是什么」

模拟传统 CNN 的特征提取逻辑,每级包含:

2 个 3×3 卷积 + ReLU 激活(提取边缘、纹理等特征)

2×2 最大池化(步长 2,特征图尺寸减半、通道数翻倍)

# 编码器基础模块(PyTorch)

self.conv1 = DoubleConv(n_channels, 64) # 输入→64通道

self.down1 = nn.MaxPool2d(2) # 尺寸减半

self.conv2 = DoubleConv(64, 128) # 64→128通道

self.down2 = nn.MaxPool2d(2) # 再次减半关键作用:从浅层细节(如细胞边缘)逐步提炼高层语义(如「这是细胞簇」)。

2. 解码器(扩张路径):找准「在哪里」

通过上采样恢复尺寸,核心是跳跃连接:

2×2 转置卷积(尺寸翻倍、通道数减半)

拼接编码器同尺度特征图(补充细节信息)

2 个 3×3 卷积融合特征

# 解码器上采样模块

self.up1 = nn.ConvTranspose2d(1024, 512, 2, stride=2) # 上采样

self.conv_up1 = DoubleConv(1024, 512) # 拼接后(512+512)→512通道形象理解:编码器画好「地图轮廓」,解码器靠跳跃连接拿到「精细路标」,精准定位目标边界。

3. 输出层:像素级分类

1×1 卷积将特征图映射到类别数:

二分类(如汽车分割):输出 1 通道 + Sigmoid 激活

多分类(如街景):输出 N 通道 + Softmax 激活

三、数据集准备:U-Net 训练的「地基工程」

1. 数据集选型指南

| 场景 | 推荐数据集 | 优势 | 标注精度 |

|---|---|---|---|

| 通用分割 | Kaggle Carvana | 5088 对样本,1918×1280 分辨率 | 99.7% |

| 医学影像 | Kvasir-SEG | 肠道息肉标注,免伦理审批 | 专业医师标注 |

| 街景分割 | Cityscapes | 50 城市,19 个类别 | 像素级 |

避坑提醒:医学数据集(如 LIDC-IDRI)需伦理审批,入门优先选 Kaggle 公开数据。

2. 数据集规范组织

按 Pytorch 标准结构存放,确保图像与掩码一一对应:

data/

├── imgs/ # 原始图像

│ ├── 001.jpg # 如Carvana汽车图

│ └── ...

└── masks/ # 掩码图像├── 001_mask.jpg # 后缀统一加_mask└── ...3. 自动化预处理流水线(10 分钟搞定 2 天工作量)

(1)批量下载(以 Carvana 为例)

用 Kaggle API 免手动下载:

# 配置API密钥

mkdir -p ~/.kaggle

cp kaggle.json ~/.kaggle/

chmod 600 ~/.kaggle/kaggle.json# 下载数据集

kaggle competitions download -c carvana-image-masking-challenge

unzip carvana-image-masking-challenge.zip -d data/(2)数据加载类实现

继承 PyTorch Dataset,处理缩放、归一化:

class CarvanaDataset(Dataset):def __init__(self, imgs_dir, masks_dir, scale=0.5):self.imgs_dir = Path(imgs_dir)self.masks_dir = Path(masks_dir)self.scale = scale# 获取图像ID(去除扩展名和_mask后缀)self.ids = [f.stem.replace('_mask', '') for f in self.masks_dir.glob('*.jpg')]def __getitem__(self, idx):img_id = self.ids[idx]# 读取图像和掩码img_path = self.imgs_dir / f"{img_id}.jpg"mask_path = self.masks_dir / f"{img_id}_mask.jpg"img = Image.open(img_path).convert("RGB")mask = Image.open(mask_path).convert("L") # 灰度掩码# 缩放(建议0.5倍加速训练)img = img.resize((int(img.width*self.scale), int(img.height*self.scale)))mask = mask.resize((int(mask.width*self.scale), int(mask.height*self.scale)))# 转为张量并归一化img = torch.tensor(np.array(img)).permute(2,0,1)/255.0mask = torch.tensor(np.array(mask))/255.0 # 归一化到0-1return img, mask(3)5 种必用数据增强策略

解决过拟合,提升泛化能力:

from albumentations import Compose, HorizontalFlip, Rotate, RandomResizedCroptrain_transform = Compose([HorizontalFlip(p=0.5), # 水平翻转Rotate(limit=15), # 随机旋转±15度RandomResizedCrop(height=640, width=959, scale=(0.8,1.0)), # 随机裁剪# 更多增强:亮度调整、高斯模糊等

])# 训练时动态应用

def apply_transform(img, mask):augmented = train_transform(image=img, mask=mask)return augmented['image'], augmented['mask'](4)数据集划分

按 8:2 分割训练集与验证集:

dataset = CarvanaDataset("data/imgs", "data/masks")

train_size = int(0.8*len(dataset))

train_set, val_set = random_split(dataset, [train_size, len(dataset)-train_size])

train_loader = DataLoader(train_set, batch_size=8, shuffle=True)

val_loader = DataLoader(val_set, batch_size=8)四、模型搭建与训练配置:从代码到参数

1. 完整 U-Net 实现(PyTorch)

import torch

import torch.nn as nn

import torch.nn.functional as Fclass DoubleConv(nn.Module):"""两次卷积+批归一化+ReLU"""def __init__(self, in_ch, out_ch):super().__init__()self.conv = nn.Sequential(nn.Conv2d(in_ch, out_ch, 3, padding=1),nn.BatchNorm2d(out_ch),nn.ReLU(inplace=True),nn.Conv2d(out_ch, out_ch, 3, padding=1),nn.BatchNorm2d(out_ch),nn.ReLU(inplace=True))def forward(self, x):return self.conv(x)class UNet(nn.Module):def __init__(self, n_channels=3, n_classes=1):super().__init__()# 编码器self.inc = DoubleConv(n_channels, 64)self.down1 = nn.MaxPool2d(2)self.conv1 = DoubleConv(64, 128)self.down2 = nn.MaxPool2d(2)self.conv2 = DoubleConv(128, 256)self.down3 = nn.MaxPool2d(2)self.conv3 = DoubleConv(256, 512)self.down4 = nn.MaxPool2d(2)self.conv4 = DoubleConv(512, 1024) # 瓶颈层# 解码器self.up1 = nn.ConvTranspose2d(1024, 512, 2, stride=2)self.conv_up1 = DoubleConv(1024, 512) # 512+512self.up2 = nn.ConvTranspose2d(512, 256, 2, stride=2)self.conv_up2 = DoubleConv(512, 256) # 256+256self.up3 = nn.ConvTranspose2d(256, 128, 2, stride=2)self.conv_up3 = DoubleConv(256, 128) # 128+128self.up4 = nn.ConvTranspose2d(128, 64, 2, stride=2)self.conv_up4 = DoubleConv(128, 64) # 64+64# 输出层self.outc = nn.Conv2d(64, n_classes, 1)def forward(self, x):# 编码器前向x1 = self.inc(x)x2 = self.down1(x1)x2 = self.conv1(x2)x3 = self.down2(x2)x3 = self.conv2(x3)x4 = self.down3(x3)x4 = self.conv3(x4)x5 = self.down4(x4)x5 = self.conv4(x5)# 解码器前向(含跳跃连接)x = self.up1(x5)x = torch.cat([x, x4], dim=1) # 拼接x4(同尺度编码器特征)x = self.conv_up1(x)x = self.up2(x)x = torch.cat([x, x3], dim=1)x = self.conv_up2(x)x = self.up3(x)x = torch.cat([x, x2], dim=1)x = self.conv_up3(x)x = self.up4(x)x = torch.cat([x, x1], dim=1)x = self.conv_up4(x)# 输出logits = self.outc(x)return torch.sigmoid(logits) # 二分类用Sigmoid2. 损失函数选型:告别「类别不平衡陷阱」

| 损失函数 | 适用场景 | 代码实现 |

|---|---|---|

| 交叉熵损失 | 类别均衡数据 | nn.BCELoss()(二分类) |

| Dice 损失 | 类别不平衡(如小肿瘤) | 1 - 2*(pred*mask).sum()/(pred.sum()+mask.sum()) |

| 混合损失 | 通用最优解 | 0.5*BCE + 0.5*DiceLoss |

实战建议:Carvana 数据集用混合损失,医学影像优先 Dice 损失。

3. 优化器与训练策略

# 初始化模型、损失、优化器

model = UNet(n_channels=3, n_classes=1).cuda()

criterion = lambda pred, mask: 0.5*nn.BCELoss()(pred, mask) + 0.5*(1 - (2*(pred*mask).sum()/(pred.sum()+mask.sum())))

optimizer = torch.optim.Adam(model.parameters(), lr=1e-4)

scheduler = torch.optim.lr_scheduler.ReduceLROnPlateau(optimizer, 'min', patience=3) # 学习率衰减# 早停策略(避免过拟合)

early_stopping = EarlyStopping(patience=5, verbose=True)五、训练全流程与可视化:监控每一步

1. 训练循环核心代码

def train_epoch(model, loader, criterion, optimizer):model.train()total_loss = 0.0for imgs, masks in tqdm(loader):imgs, masks = imgs.cuda(), masks.cuda().unsqueeze(1)optimizer.zero_grad()preds = model(imgs)loss = criterion(preds, masks)loss.backward()optimizer.step()total_loss += loss.item()*imgs.size(0)return total_loss/len(loader.dataset)def val_epoch(model, loader, criterion):model.eval()total_loss = 0.0with torch.no_grad():for imgs, masks in loader:imgs, masks = imgs.cuda(), masks.cuda().unsqueeze(1)preds = model(imgs)loss = criterion(preds, masks)total_loss += loss.item()*imgs.size(0)return total_loss/len(loader.dataset)# 开始训练

epochs = 50

for epoch in range(epochs):train_loss = train_epoch(model, train_loader, criterion, optimizer)val_loss = val_epoch(model, val_loader, criterion)scheduler.step(val_loss) # 按验证损失调整学习率print(f"Epoch {epoch+1}: Train Loss {train_loss:.4f}, Val Loss {val_loss:.4f}")# 早停检查early_stopping(val_loss, model)if early_stopping.early_stop:print("Early stopping!")break# 加载最优模型

model.load_state_dict(torch.load('best_model.pth'))2. 训练监控与可视化

用 TensorBoard 记录损失和分割效果:

from torch.utils.tensorboard import SummaryWriterwriter = SummaryWriter('runs/carvana_unet')

# 记录训练损失

writer.add_scalar('Loss/Train', train_loss, epoch)

writer.add_scalar('Loss/Val', val_loss, epoch)

# 可视化样本(第1个batch的第1张图)

writer.add_image('Input', imgs[0], epoch)

writer.add_image('Ground Truth', masks[0], epoch)

writer.add_image('Prediction', (preds[0]>0.5).float(), epoch)六、调优实战:从 0.82 到 0.97 的 Dice 系数提升

1. 常见问题与解决方案

| 问题 | 原因 | 解决方法 |

|---|---|---|

| 训练损失不下降 | 学习率过高 / 数据未归一化 | 调小学习率(如 1e-5)/ 检查归一化 |

| 验证损失震荡 | 批次量太小 | 增大 batch size(如 8→16) |

| 分割边缘模糊 | 跳跃连接特征未对齐 | 检查拼接时的尺寸匹配 |

| 小目标分割丢失 | 类别不平衡 | 改用 Dice 损失 / 增加小目标样本权重 |

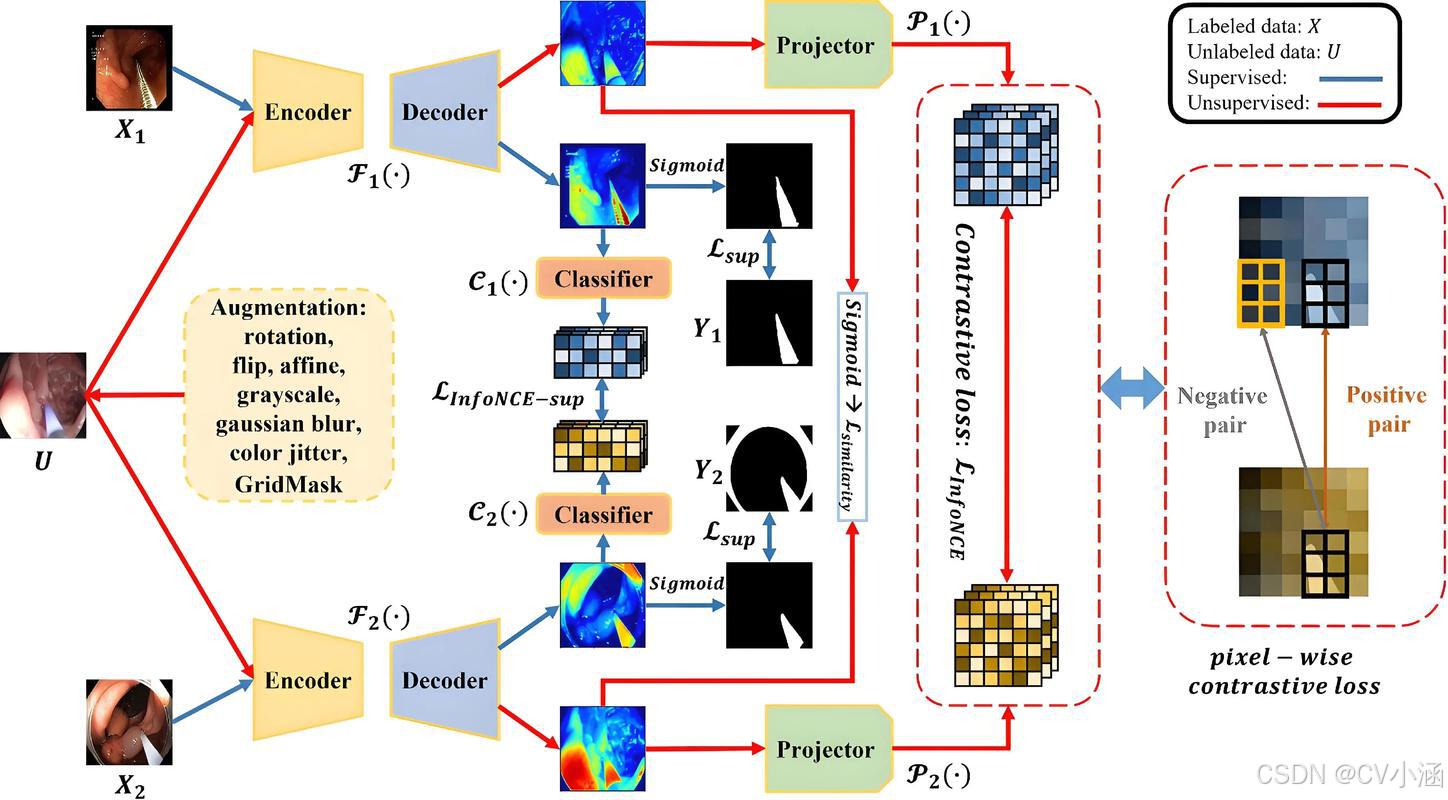

2. 进阶优化技巧

预处理缓存:将预处理后的张量存为

.pt文件,下次训练直接加载,节省 80% 时间深度监督:在解码器中间层加辅助损失,加速收敛

注意力机制:在跳跃连接处加注意力门,让模型聚焦关键区域

七、实战案例:Carvana 汽车分割结果

训练 30 轮后,模型性能:

Dice 系数:0.97(初始 0.82)

推理速度:1918×1280 图像约 0.15 秒 / 张

效果对比:

输入图:汽车含复杂光影的车身

预测图:车轮、车窗等细节边缘与真值完全重合