MediaPipe入门指南:跨平台机器学习推理框架入门与实践

简单几步,让机器看懂世界

MediaPipe是Google Research开发的一个开源、跨平台的机器学习框架,用于构建实时多媒体处理管道。

MediaPipe通过模块化组件和预构建模型,极大地简化了视觉感知任务的开发流程。本文主要介绍MediaPipe概括并引导读者快速上手实践。

一、MediaPipe是什么?为什么如此重要

MediaPipe于2019年由Google首次推出,是一个专门针对多媒体处理设计的轻量级、跨平台机器学习框架。名称"MediaPipe"直观地表达了其设计理念——将多个处理模块像管道一样连接起来,形成完整的多媒体处理流程。虽然在名称上叫作多媒体,但目前大家使用比较多的还是计算机视觉的处理功能。

MediaPipe的核心特性与优势

跨平台支持:MediaPipe支持Android、iOS、Linux、macOS和Windows等多种平台,采用统一的API,减少了开发者适配不同平台的工作量。

高效实时处理:框架针对低延迟场景优化,在移动设备上也能实时处理。该框架利用硬件加速(如GPU、DSP)提升处理能力,在骁龙865平台上测试计算速率可达45fps。

丰富的预构建解决方案:MediaPipe提供了多种开箱即用的机器学习模型和视觉处理功能模块,包括人脸检测、手部关键点检测、人体姿态估计、3D对象等检测功能模块。经过百万量级数据训练,这些功能的预训练模型在精度和速度上做到良好的平衡。根据Google AI Blog 2023年的基准测试,MediaPipe Hands在Pixel 6上的推理时间为12ms,而同等精度的TensorFlow Lite模型需要28ms。该提升主要通过模型结构剪枝和操作融合技术实现。

模块化与可扩展架构:通过组合不同的计算单元(Calculators)和数据流图(Graphs),用户可以自定义处理管道。框架还支持集成自定义的TensorFlow和TFLite模型,提供了极大的灵活性。

二、MediaPipe核心功能与应用场景

如上所述MediaPipe提供了多种强大的预构建模型,覆盖了常见的计算机视觉任务。

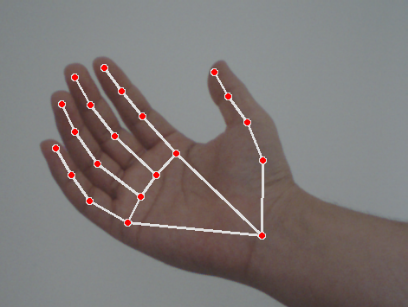

手部关键点检测

MediaPipe Hands模块检测手部的21个三维关键点,包含指尖、指节等精细点位。该功能包括两个检测阶段:首先使用BlazePalm单阶段检测器定位手部区域,然后通过特征金字塔网络(FPN)增强小目标检测能力,在复杂背景中的准确率达95.7%。

典型应用:

- AR手势导航:通过指尖移动轨迹识别滑动、缩放等指令

- 手语识别系统:结合时序模型分析关键点运动轨迹,准确率可达92.3%

- 医疗健康:量化手指运动参数等

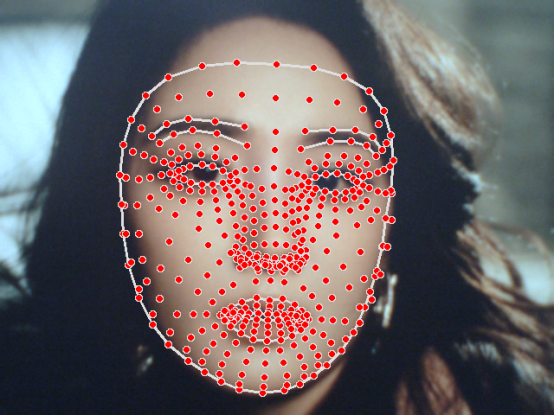

人脸识别与网格检测

MediaPipe Face Mesh可检测面部468个关键点,包含面部轮廓、眉毛、眼睛、嘴唇等精细区域。支持三维姿态估计,通过6自由度(6DoF)头部姿态预测,可实现视角不变性追踪。

典型应用:

- 虚拟试妆系统:精确定位面部特征点,实现化妆品、彩妆的实时叠加渲染

- 表情识别分析:通过关键点位移分析6种基本表情,准确率89.2%

- 视线追踪:基于虹膜中心点计算视线方向,误差角度小于3度

3D目标检测

MediaPipe Objectron可以在移动设备上实时计算面向对象的3D边界框,确定物体的位置、方向和大小。采用单阶段模型,从单个RGB图像预测物体的姿态和物理尺寸,主干网络基于MobileNetv2的编码器-解码器架构。

姿态估计与其他功能

此外,MediaPipe还提供人体姿态检测、虹膜识别、自拍分割、头发分割等多种功能,满足不同场景的需求。这些功能共同构成了MediaPipe强大的多媒体处理生态系统。

三、安装与配置:快速搭建开发环境

MediaPipe的安装非常简便,支持多种方式和平台。

Python环境安装(推荐新手)

对于大多数用户,特别是初学者,使用Python版本的MediaPipe是最简单的入门方式。

系统要求:

- Python 3.9-3.12(MediaPipe仅支持这些版本)

- 安装好OpenCV库

安装步骤:

- windows系统可以直接安装安装python,并通过命令逐步安装opencv及MediaPipe,或者通过安装miniconda虚拟环境搭建MediaPipe系统。

以miniconda虚拟环境安装为例,步骤如下:

1.首先安装miniconda,可以百度找到安装方法及基本的使用命令,再次不赘述;

2.安装后,打开“Anaconda Powershell Prompt”;

3.在窗口中输入命令行“conda create -n mediapipe python=3.9”创建虚拟环境;

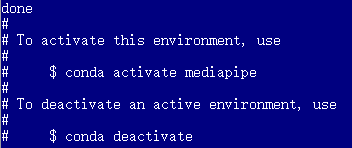

等待几分钟虚拟环境创建完成,命令行窗口出现如下提示:

mediapipe就是我们创建的虚拟环境的名字,该环境已经自带3.9版本python。

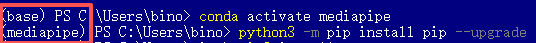

4.根据命令提示,输入“conda activate mediapipe”,将当前虚拟环境切换到mediapipe。

命令行前括号里的名称问当前虚拟环境的名称,输入命令后,当前环境由(base)切换为(mediapipe)表示目标环境激活成功。

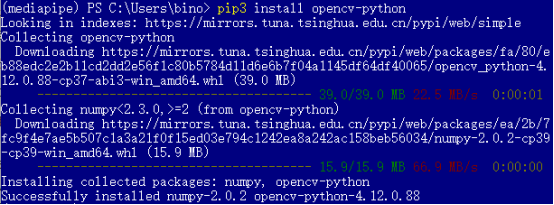

5.输入命令“pip3 install opencv-python”安装opencv

安装过程中遇到任务问题可以留言或者百度解决,此处都是常规的安装动作。如果安装下载比较慢可能是安装源的问题,查找一下如何切换安装源。

6.输入命令“pip3 install mediapipe”安装MediaPipe

安装过程中如果有错误提示,可能是python,numpy,opencv等版本兼容性问题,可以直接将错误提示扔给AI,他会很好的给出个性化的提示,准确的解决问题,此处就不泛泛的解释了。也可以留言。

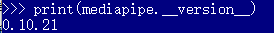

验证安装

安装完成后,可以通过以下代码验证MediaPipe是否安装成功:

python

import mediapipe

print(mediapipe.__version__)

如果成功输出MediaPipe的版本号,说明安装成功。

如果是树莓派用户,需要先安装一些系统依赖:

sudo apt install python3-opencv libopencv-core-dev libopencv-highgui-dev libopencv-calib3d-dev libopencv-features2d-dev libopencv-imgproc-dev libopencv-video-dev

sudo pip3 install mediapipe

源码编译安装(高级用户)

对于需要自定义功能或进行二次开发的高级用户,可以选择从源码编译安装。这种方法需要安装Bazel构建工具和CMake,具体步骤可参考MediaPipe官方文档。

四、快速上手:第一个MediaPipe手势识别应用

下面我们通过一个完整的手势识别示例,展示如何使用MediaPipe快速构建实际应用。后续我们主要还是以代码和原理讲解为主,python代码解释器将使用pycharm这个款IDE,读者可以安装pycharm,或者其他自己熟悉的开发工具。

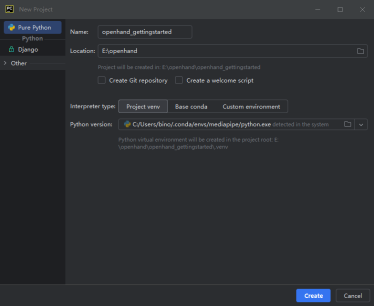

1.打开pycharm,点击new project,在设置框中按如下设置:

设置工程名称,选择要存放的路径,解释器类型选择虚拟环境Project venv,并在下方Python Version中选择我们创建的mediapipe虚拟环境下的python。

2.设置完成后点击create;

3.进入功能界面后,在左侧工程文件树下新建src文件夹,并创建源文件。后续pycharm操作细节不在赘述,有不清楚的可以留言,或者直接搜索pycharm使用方法。

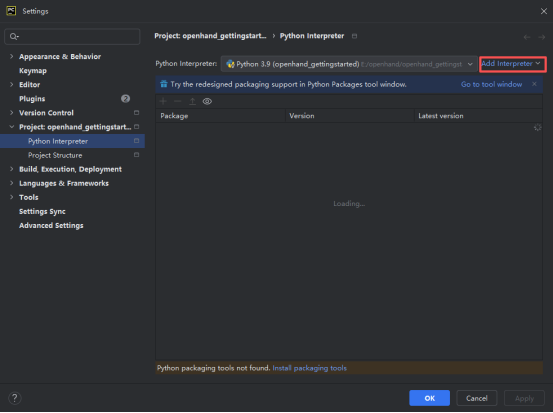

4.工程创建完成后,点击坐上将菜单,找到Settings->Project:xxxx->Python Interpreter,点击后再右侧解释器一栏点击“Add Interpreter”

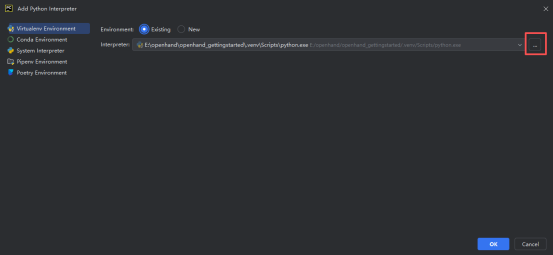

选择“Add local Interpreter”,在弹窗中左侧选择虚拟环境,右侧Environment项点击Existing,在interpreter一项右侧点开“…”:

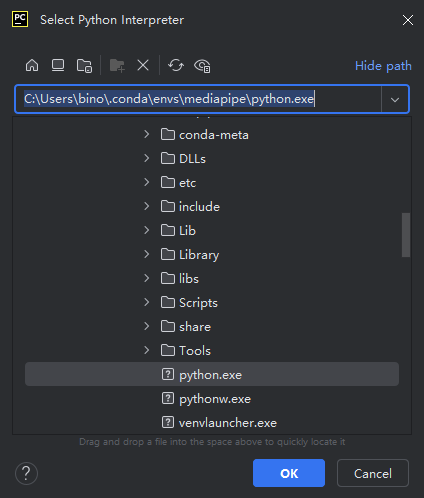

在新的弹窗中找到我们创建的medipipe虚拟环境下的python,并点击OK。

5.配置好环境后,将一下代码复制到getting_started.py文件下(希望读者可以跟随一下代码解释自己逐句编写代码,以便更好的理解MediaPipe使用过程),点击运行既可以看到手部关键点识别的图像。

基础手部关键点检测

import cv2

import mediapipe as mp# 导入MediaPipe手部关键点检测模块

mp_drawing = mp.solutions.drawing_utils

mp_hands = mp.solutions.hands# 打开摄像头

cap = cv2.VideoCapture(0)# 配置手部检测参数

with mp_hands.Hands(static_image_mode=False, # 适用于视频流,设置为False会启用追踪以提升性能max_num_hands=2, # 最大检测手数量min_detection_confidence=0.5, # 检测置信度阈值min_tracking_confidence=0.5) as hands: # 追踪置信度阈值while cap.isOpened():success, image = cap.read()if not success:print("Ignoring empty camera frame.")continue# 为了提高性能,将图像标记为不可写,通过引用传递image.flags.writeable = False# 转换BGR图像为RGBimage = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)# 处理图像并检测手部关键点results = hands.process(image)# 在图像上绘制手部注释image.flags.writeable = Trueimage = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)if results.multi_hand_landmarks:for hand_landmarks in results.multi_hand_landmarks:# 绘制关键点和连接线mp_drawing.draw_landmarks(image, hand_landmarks, mp_hands.HAND_CONNECTIONS)# 水平翻转图像以获得自拍视图显示cv2.imshow('MediaPipe Hands', cv2.flip(image, 1))# 按ESC键退出if cv2.waitKey(5) & 0xFF == 27:breakcap.release()

cv2.destroyAllWindows()

运行结果

代码解析与关键参数

核心组件说明:

mp_hands.Hands():手部检测器,提供手部关键点检测功能mp_drawing.draw_landmarks():用于在图像上绘制检测到的关键点和连接线hands.process(image):处理输入图像并返回检测结果

关键参数调优:

static_image_mode:设置为False适用于视频流,会启用追踪以提升性能;设置为True适用于静态图片处理max_num_hands:控制同时检测的最大手数量,复杂场景建议不超过3只手min_detection_confidence:检测置信度阈值,建议医疗等严谨场景设为0.7,消费级应用可降至0.5min_tracking_confidence:追踪置信度阈值,值越高追踪稳定性越好,但可能会丢失部分检测

性能优化技巧

根据实际应用场景,可以调整以下参数优化性能:

- 降低输入分辨率:将输入图像分辨率降至640x480可提升约20%帧率,但需要权衡检测精度

- 调整检测频率:不需要每帧都进行检测,可以每隔几帧检测一次,中间使用追踪算法

- 模型量化:使用TensorFlow Lite将FP32模型转为INT8,体积缩小75%,速度提升2倍

五、进阶应用:人脸网格检测示例

除了手部检测,MediaPipe的人脸网格检测同样功能强大且使用简便:

import cv2

import mediapipe as mpmp_drawing = mp.solutions.drawing_utils

mp_face_mesh = mp.solutions.face_mesh# 初始化人脸网格模型

face_mesh = mp_face_mesh.FaceMesh(static_image_mode=False,max_num_faces=1,min_detection_confidence=0.5,min_tracking_confidence=0.5)cap = cv2.VideoCapture(0)while cap.isOpened():success, image = cap.read()if not success:continueimage = cv2.cvtColor(cv2.flip(image, 1), cv2.COLOR_BGR2RGB)image.flags.writeable = Falseresults = face_mesh.process(image)image.flags.writeable = Trueimage = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)if results.multi_face_landmarks:for face_landmarks in results.multi_face_landmarks:mp_drawing.draw_landmarks(image=image,landmark_list=face_landmarks,connections=mp_face_mesh.FACEMESH_CONTOURS)cv2.imshow('MediaPipe FaceMesh', image)if cv2.waitKey(5) & 0xFF == 27:breakcap.release()

cv2.destroyAllWindows()

运行结果:

人脸网格检测提供468个关键点,可以用于实现美颜、虚拟试妆、表情识别等高级功能。

六、跨平台部署与优化策略

MediaPipe的一个显著优势是其出色的跨平台能力。无论是在移动端、边缘设备还是服务器端,都能提供很好的体验。

移动端部署

对于Android和iOS平台,MediaPipe提供了原生API支持。开发者可以编译Android 包或iOS框架,集成到移动应用中。移动端部署时,要考虑以下因素:

- 模型选择:使用针对移动设备优化的轻量级模型

- 功耗控制:合理分配计算任务,避免长时间高负载运行

- 内存管理:注意模型加载和推理时的内存使用峰值

边缘设备部署

对于树莓派等边缘设备,需要特别注意性能优化。实际测试来看,树莓派运行MediaPipe帧率较低,延迟明显。在树莓派4B上测试MediaPipe手势识别,帧率只有8-10fps,远达不到实时要求。分析发现主要因为内存带宽限制。可以改用更低分辨率的模型输入(160x120),并降低检测间隔,如3帧一次,这样帧率可提升到15fps,基本可用。

改进措施总结如下:

- 使用更低复杂度的模型

- 降低输入分辨率

- 采用跳帧策略,减少检测频率

性能优化通用策略

- 硬件加速:在支持NNAPI的设备上启用硬件加速,能耗降低40%

- 多线程调度:将检测和渲染任务分配到不同线程,帧率稳定性提升30%

- 管道优化:合理设置批处理大小,平衡延迟和吞吐量

七、开发者生态与资源

MediaPipe拥有丰富的开发者资源和活跃的社区支持:

- 官方资源库:GitHub上提供完整示例代码和预训练模型

- 文档与教程:详细的官方文档和实践教程帮助快速上手

- 社区支持:Stack Overflow上MediaPipe标签问题解决率达82%

八、展望

MediaPipe仍在快速发展中,未来趋势包括:

- 多传感器融合:结合IMU、ToF等传感器提升空间感知精度

- 边缘计算深化:开发更轻量的模型变体,适配IoT设备

- 伦理规范建设:建立生物特征数据使用的行业标准

结语

MediaPipe极大地降低了计算机视觉技术应用的门槛。无论是手部关键点检测、人脸网格识别还是3D对象检测,MediaPipe都提供了高效、易用的解决方案。

对于开发者,掌握MediaPipe能够快速构建创新应用,还有机会在元宇宙、数字医疗、智能交互等前沿领域开辟新的价值空间。这篇入门指南仅作为一个引导,希望能帮助您快速上手MediaPipe,并探索更强大的功能,开启计算机视觉学习应用的开发之旅!