[论文阅读] AI + 软件工程 | 3340个Python ML项目实证:PyQu工具+61种代码变更,精准提升软件质量!

3340个Python ML项目实证:PyQu工具+61种代码变更,精准提升软件质量!

论文信息

- 论文原标题:From Code Changes to Quality Gains: An Empirical Study in Python ML Systems with PyQu

- 主要作者及研究机构:

- Mohamed Almukhtar(美国密歇根大学弗林特分校)

- Marouane Kessentini(美国大峡谷州立大学)

- Anwar Ghammam(美国密歇根大学迪尔伯恩分校)

- Hua Ming(美国密歇根大学弗林特分校)

- 引文格式(GB/T 7714):Almukhtar M, Kessentini M, Ghammam A, et al. From Code Changes to Quality Gains: An Empirical Study in Python ML Systems with PyQu[C]//Proceedings of IEEE/ACM 48th International Conference on Software Engineering (ICSE’26). New York: ACM, 2026: 1-13. https://doi.org/10.1145/3744916.3773258.

一段话总结

面对Python机器学习系统(MLS)中代码变更与质量关联模糊、缺乏自动化评估工具的痛点,研究团队对3340个开源Python ML项目(含3.7百万次提交、2.7万亿行代码)开展大规模实证研究,研发出基于低级别软件指标+机器学习的质量评估工具PyQu(平均准确率、精确率、召回率达0.84,F1分数0.85),并识别出61种可直接提升质量的代码变更(归为13类,25种为新发现),同时构建1728个手动标注提交的基准数据集,为Python MLS的质量优化提供了工具、数据与实践指南。

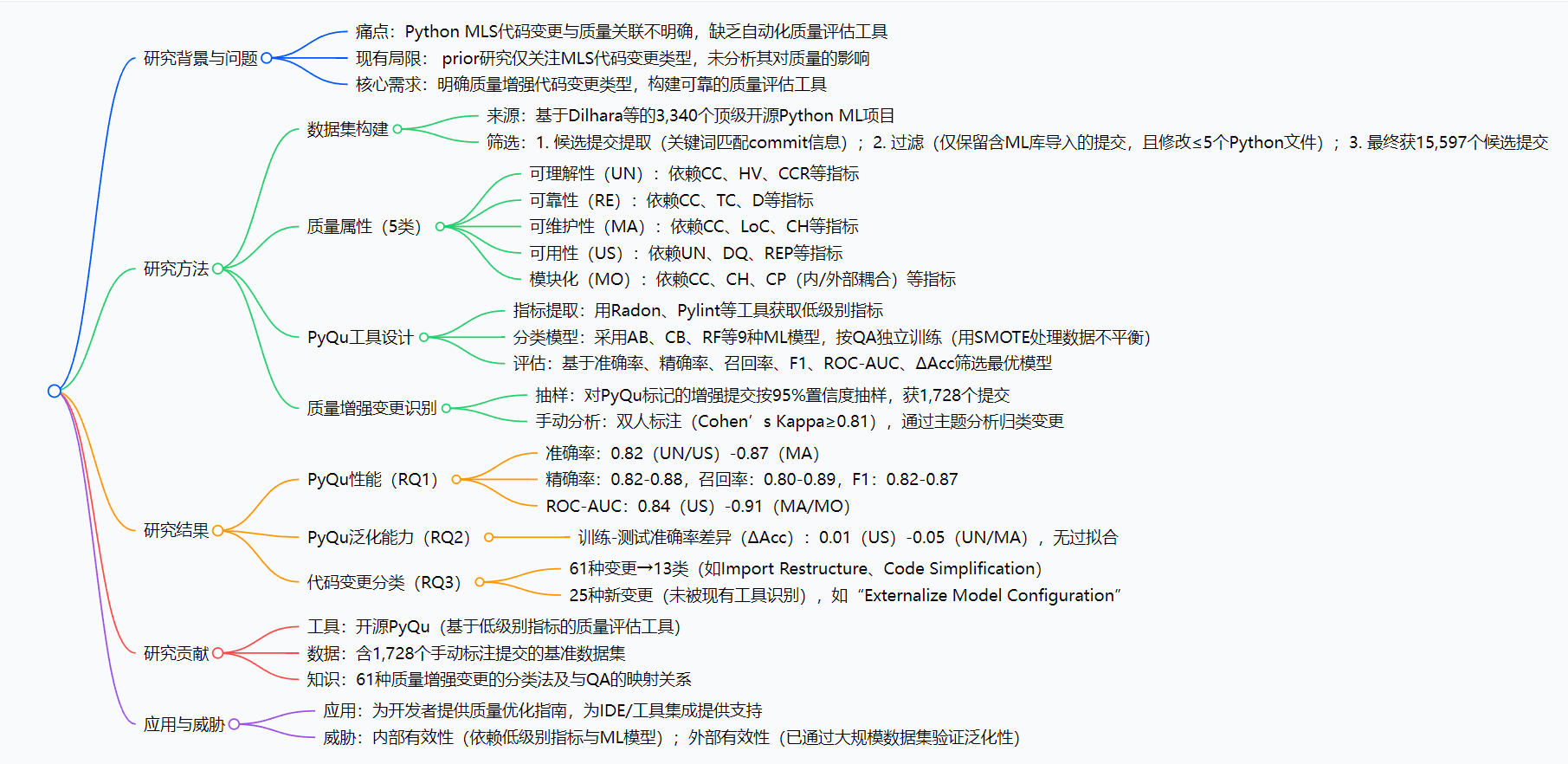

思维导图

研究背景

如今,Python已是机器学习领域的“主力语言”,从工业界的TensorFlow项目到开源社区的各类工具库,Python ML系统无处不在。但随着生成式AI代码生成技术的普及和系统规模的扩大,一个关键问题浮出水面:不是所有代码变更都能提升质量,可到底哪些变更能让软件更可靠、更易维护?

之前的研究要么只罗列ML系统里常见的代码变更类型,要么用“可维护代码”这种主观标签评判质量,既没说清变更和质量的具体关联,也没有能自动化评估的工具。比如有些开发者会把模型配置写在类构造函数里,修改时要翻遍代码;还有些用了过时的API,不仅影响性能还可能埋坑——这些变更到底怎么影响软件质量,没人能说透。

对于开发者来说,这就像“摸着石头过河”:改代码时不知道会不会帮倒忙;对于工具设计者,也缺一个靠谱的标准来做质量检测。所以,搞清楚“哪些代码变更能提升质量”“怎么快速识别这些变更”,就成了行业里急需解决的问题。

创新点

- 工具创新:PyQu的“客观评估”逻辑:摒弃传统工具的主观标签,通过循环复杂度、注释比例等低级别指标的变化量,结合机器学习模型判断代码变更是否提升质量,避免人为偏见。

- 规模创新:超大规模实证研究:覆盖3340个开源项目、3.7百万次提交、2.7万亿行代码,是目前Python MLS质量相关代码变更领域最全面的研究。

- 发现创新:25种未被识别的质量增强变更:现有工具最多只能识别31%的相关变更,而本研究发现的61种变更中,25种是全新的,填补了现有工具的空白。

- 资源创新:首个基准数据集:构建含1728个手动验证提交的数据集,每个提交都标注了对应的质量提升属性,为后续研究提供统一标准。

研究方法和思路

整个研究就像“侦探破案”,分四步层层推进,逻辑清晰易懂:

第一步:搭建“证据库”——数据集构建

- 从开源社区筛选3340个顶级Python ML项目,涵盖TensorFlow、PyTorch等主流框架相关项目;

- 用关键词(如“refactor”“code quality”)和正则匹配,提取开发者意图提升质量的提交;

- 双重过滤:只保留修改含ML库(如NumPy、Scikit-learn)导入文件的提交,且每次提交修改不超过5个Python文件,最终得到15597个候选提交。

第二步:明确“评判标准”——定义质量属性与指标

确定5类核心质量属性,每类都用具体的低级别指标量化(比如“可理解性”用循环复杂度、注释代码比来衡量),避免模糊判断。

第三步:打造“侦探工具”——PyQu实现与评估

- 用Radon、Pylint等工具提取提交前后的低级别指标,计算变化量(比如循环复杂度降低了多少);

- 测试9种机器学习模型(如随机森林、CatBoost),按5类质量属性分别训练,用SMOTE技术解决数据不平衡问题;

- 从准确率、精确率等6个维度筛选最优模型,确保工具性能稳定。

第四步:“锁定真凶”——质量增强变更识别

- 用PyQu标记15597个候选提交,按质量属性分成5组;

- 每组按95%置信度抽样,共得到1728个提交,由两位专家手动分析,识别其中的代码变更类型;

- 通过主题分析将变更归类,最终形成61种变更、13个类别的分类法,并验证变更与质量属性的映射关系。

主要成果和贡献

核心成果汇总表

| 研究问题(RQ) | 研究方法 | 核心结果 |

|---|---|---|

| RQ1:PyQu检测质量增强提交的效果如何? | 基于手动标注数据集,用6个指标评估 | 准确率0.82-0.87,精确率0.82-0.88,召回率0.80-0.89,F1分数0.82-0.87 |

| RQ2:PyQu的泛化能力如何? | 测试未见过的代码变更,计算训练-测试准确率差和ROC-AUC | 训练-测试准确率差≤0.05,ROC-AUC≥0.84,无过拟合 |

| RQ3:Python MLS中有哪些质量增强代码变更? | 手动分析抽样提交,主题分析归类 | 61种变更→13类,25种为新发现,覆盖全部5类质量属性 |

三大核心贡献

- 工具层面:开源PyQu工具(https://sites.google.com/view/mlcodequiality/home),开发者可直接用它评估代码变更的质量影响,IDE和工具厂商也能集成到开发环境中,实现实时质量检测。

- 实践层面:明确了61种变更与5类质量属性的映射关系,比如“将硬编码值改为常量”能提升可维护性,“添加类型注解”能提升可靠性,开发者可按图索骥优化代码。

- 研究层面:提供了1728个手动标注的基准数据集,为后续MLS质量评估研究提供了统一的“参考标准”,推动领域发展。

关键问题

问题1:PyQu工具相比现有Python代码变更检测工具(如PyRef、Python RefMiner),核心优势是什么?其性能表现如何量化?

答案:

- 核心优势:1. 聚焦“质量增强”目标:现有工具仅检测变更类型,PyQu通过低级别指标+ML模型,直接判断变更是否提升质量(而非仅识别变更);2. 覆盖更多变更:仅14.8%(PyRef)、31%(Python RefMiner)、8.2%(R-CPatMiner)的变更能被现有工具识别,而PyQu支持的61种变更中25种为新发现;3. 客观性:避免传统工具的主观标签(如“可维护代码”),基于指标变化量实现客观评估。

- 量化性能:PyQu在5类质量属性上的平均准确率、精确率、召回率达0.84,F1分数0.85;ROC-AUC≥0.84(最高0.91),训练-测试准确率差异≤0.05(无过拟合),泛化能力强。

问题2:研究识别的61种质量增强代码变更中,新发现的25种变更有哪些典型例子?这些新变更主要提升哪些质量属性(QA)?

答案:

- 典型新变更例子:1. “Externalize Model Configuration”(将模型配置从类构造函数移至独立文件,如Listing 1);2. “Add DNN Layer Name”(为DNN层添加描述性名称,提升可理解性);3. “Replace Deprecated API Usage”(用新API替代过时API,如PyTorch中用

loss.item()替代loss.data[0]);4. “Enhance Argument Parsing Description”(优化命令行参数描述,提升可用性)。 - 提升的QA:新变更主要覆盖全部5类QA,例如“Externalize Model Configuration”提升模块化与可维护性,“Add DNN Layer Name”提升可理解性与可用性,“Replace Deprecated API Usage”提升可靠性与可维护性。

问题3:研究的数据集构建过程如何确保其代表性与有效性?最终数据集的关键规模参数是什么?

答案:

- 确保代表性与有效性的措施:1. 来源代表性:基于Dilhara等(2021)整理的3,340个顶级开源Python ML项目,覆盖不同规模、贡献者数量与流行度(含TensorFlow等活跃项目);2. 筛选严格性:通过“关键词提取候选提交→ML相关过滤(仅保留含PyTorch/TensorFlow等库的提交)→文件数过滤(≤5个Python文件)”,减少无关变更,最终获15,597个候选提交;3. 标注可靠性:抽样500个提交双人手动标注(Cohen’s Kappa=0.87),用SMOTE处理数据不平衡,确保训练数据有效性;4. 验证抽样:对PyQu标记的增强提交按95%置信度抽样,获1,728个手动验证提交(跨QA重复率仅18.37%),确保结果可靠。

- 关键规模参数:原始项目数3,340个,原始提交数超3.7百万次,代码行数超2.7万亿行,候选提交数15,597个,手动验证提交数1,728个,最终分析的质量增强变更数61种(13类)。

总结

这篇研究精准击中了Python ML系统开发中的核心痛点——代码变更与质量的“模糊地带”。通过超大规模的实证分析,不仅研发出高性能的PyQu评估工具,还梳理出清晰的质量增强变更分类法,既给开发者提供了“怎么改”的实践指南,也为工具设计者和研究者搭建了基础平台。

对于行业来说,它让ML系统的质量优化从“凭经验”变成“有依据”;对于开发者来说,相当于多了一个“代码质量侦探”,能快速判断变更的价值。未来随着工具的普及和数据集的扩展,Python ML系统的可维护性、可靠性有望得到大幅提升。