ICLR 2025 Spotlight | 打破AI“黑箱”!最新IIS评分框架:揭示模型性能与可解释性的共生关系

点击原文,查看更多ICLR 2025论文精读

一、导读

过去的研究认为,模型的可解释性和分类性能之间存在矛盾,即提高可解释性往往会降低分类准确率。然而,这种观点是否适用于所有类型的预训练模型尚不明确。

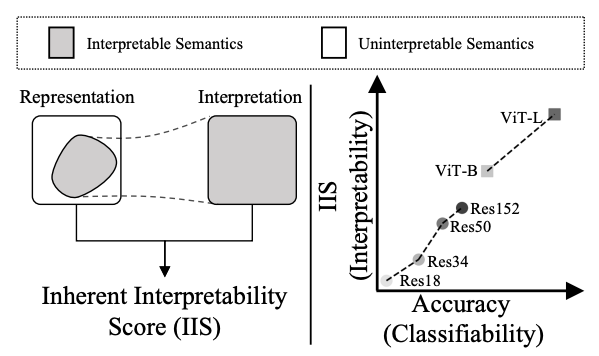

为了解决这一问题,本文提出了一种新的评估方法——固有可解释性评分(IIS),用于量化预训练模型表示的可解释性。

研究发现,可解释性和分类性能实际上是正相关的,即分类性能越高的模型,其表示中也包含更多可被解释的语义信息。基于这一发现,作者进一步提出了一种通过最大化可解释性来提升分类性能的方法,并在多个数据集上验证了其有效性。

二、论文基本信息

-

论文标题:Enhancing Pre-trained Representation Classifiability can Boost its Interpretability

-

作者与单位:Shufan Shen(中国科学院计算技术研究所)、Zhaobo Qi(哈尔滨工业大学(威海))、Junshu Sun、Qingming Huang、Qi Tian(华为)、Shuhui Wang(鹏城实验室)

-

发表信息:ICLR 2025

-

论文链接:https://arxiv.org/abs/2510.24105

-

代码地址:https://arxiv.org/abs/2510.24105

三、主要贡献与创新

-

提出固有可解释性评分(IIS),用于量化预训练表示的可解释性。

-

发现可解释性与分类性能之间存在正相关关系,打破了传统认知中的“矛盾论”。

-

提出通过最大化可解释性来进一步提升分类性能的方法。

-

实现了基于稀疏概念的预测,在保持高精度的同时提供可解释的预测结果。

四、研究方法与原理

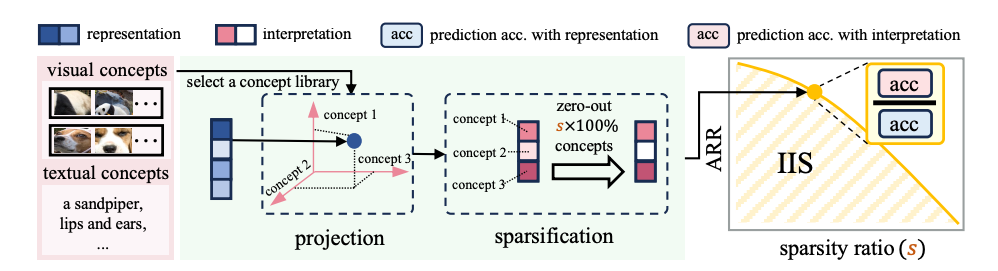

本文提出通过IIS评分来衡量预训练表示的可解释性,其核心思想是:表示中可被解释的语义越多,其在稀疏概念空间中的预测精度损失就越小。

概念库构建:

构建了四种类型的概念库(Prototype、Cluster、End2End、Text),用于将表示投影到概念空间。

对于视觉概念,使用图像块或片段,通过聚类或端到端学习得到概念向量 :

对于文本概念,使用CLIP模型学习概念向量 :

稀疏概念解释:

将表示 投影到概念空间:

使用稀疏化函数 保留最重要的概念:

IIS评分定义:

IIS定义为不同稀疏度 下的精度保持率(ARR) 曲线下面积:

其中 ARR 表示基于解释的预测精度与原始表示预测精度的比值。

五、实验设计与结果分析

实验设置:

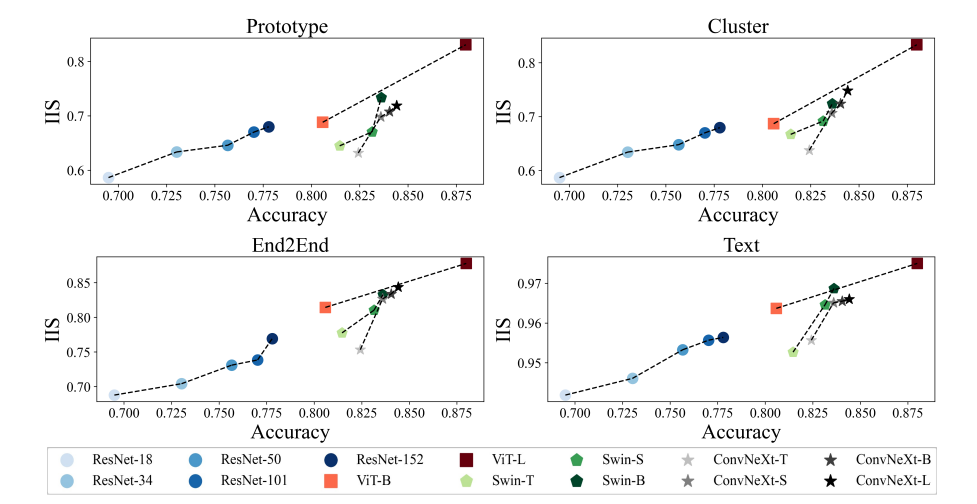

使用 ImageNet、CUB-200、CIFAR-10/100 等数据集,评估包括 ResNet、ViT、Swin、ConvNeXt 等预训练模型。概念库包括视觉和文本两种模态。

对比实验:

-

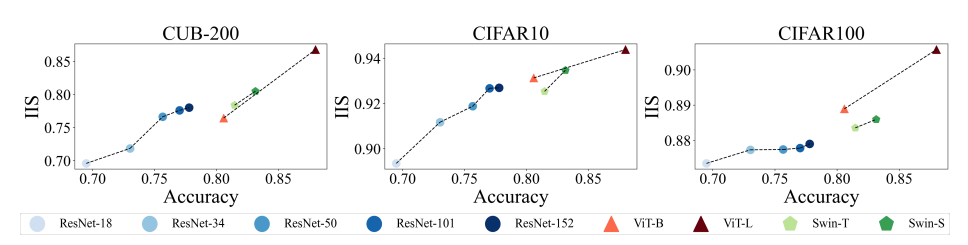

图3和图4 展示了不同模型在多个数据集上的IIS与分类精度的正相关关系。

-

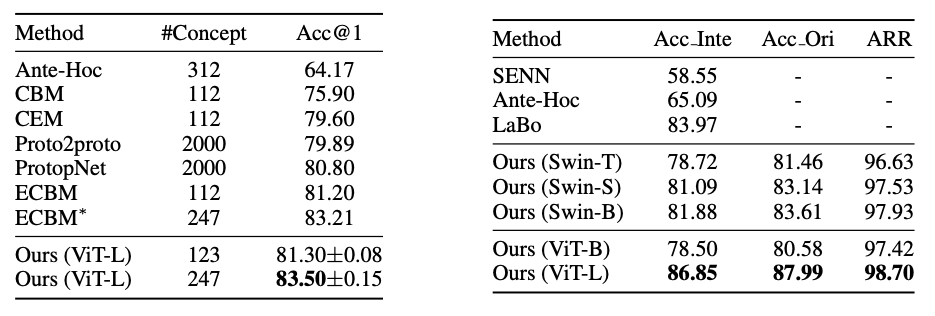

表4和表5 显示,基于解释的预测在CUB-200和ImageNet上达到或超过了现有可解释方法(如CBM、ECBM)的精度。

消融实验:

-

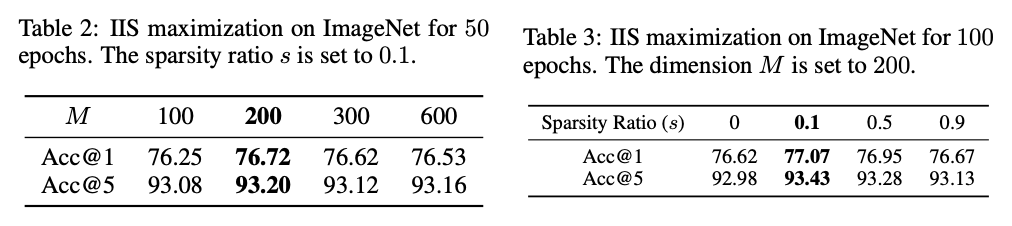

表2和表3 研究了概念空间维度 和稀疏度 对性能的影响,发现 、 时效果最佳。

-

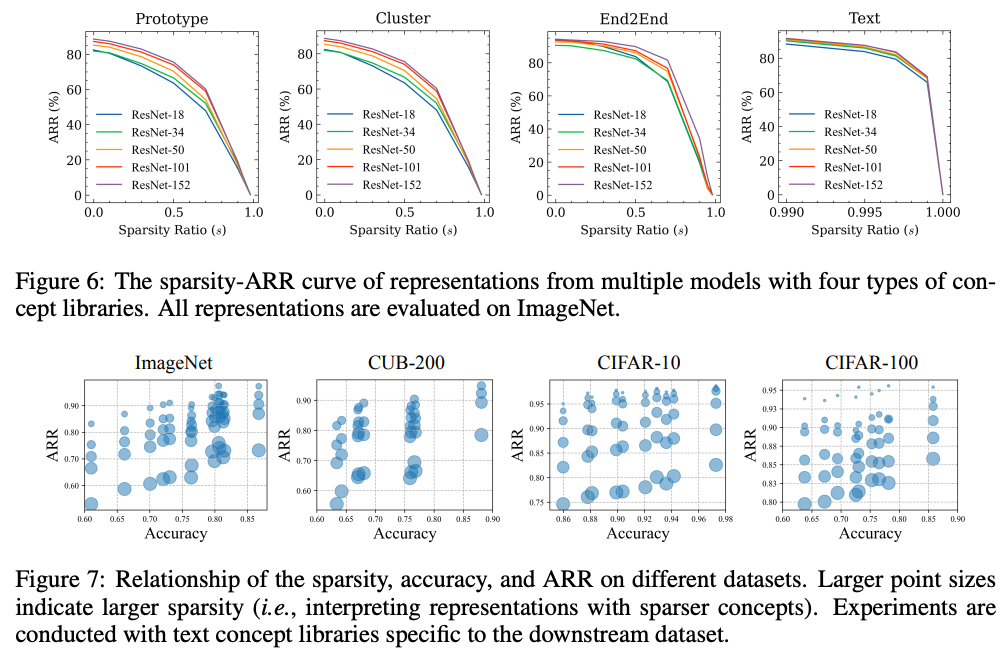

图6和图7 展示了不同稀疏度下ARR的变化,进一步验证了IIS作为可解释性指标的有效性。

-

可视化分析:

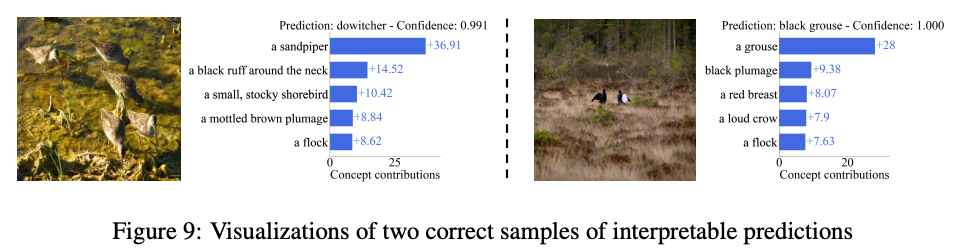

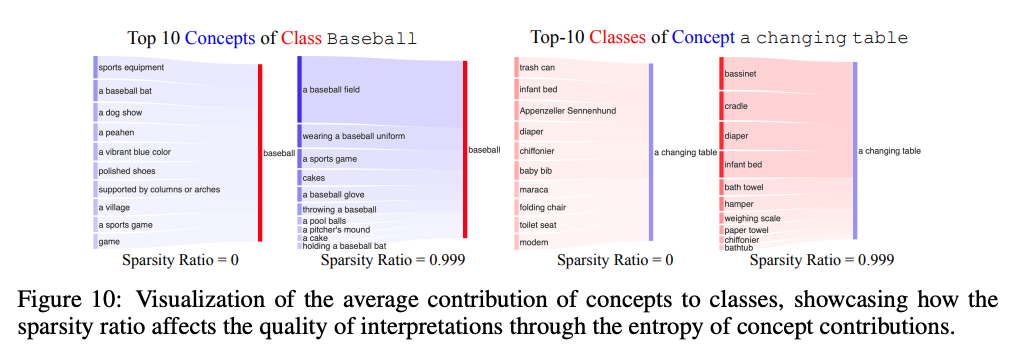

图9和图10 展示了模型预测所依赖的关键概念,并说明高稀疏度下概念与类别之间的关系更清晰。

六、论文结论与评价

总结:

本文通过提出IIS评分,首次系统性地揭示了预训练表示的可解释性与分类性能之间的正相关关系,并在此基础上提出了一种通过可解释性最大化来提升分类性能的方法。

评价:

该研究打破了传统认为“可解释性与性能不可兼得”的观念,为构建高性能且可解释的视觉模型提供了新思路。方法的优点在于通用性强,适用于多种预训练模型和任务;缺点在于IIS的计算依赖于概念库的构建,且尚未从理论上解释为何两者呈正相关。

未来可进一步探索IIS在更大规模模型(如视觉-语言基础模型)中的应用,并尝试从表示结构的角度解释其内在机制。

点击原文,查看更多ICLR 2025论文解析~